2024-04-19

解密 Meta Llama 3:目前最强的开源大语言模型

本文来自微信公众号:子非AI(ID:you_are_not_ai),作者:非子爱,原文标题:《解密 Meta Llama 3:目前最强的开源大语言模型》

核心要点:

-

我们隆重推出 Meta Llama 3,这是我们最新一代的开源大语言模型,代表了当前技术的最高水平。

-

Llama 3 模型即将登陆 AWS、Databricks、Google Cloud、Hugging Face、Kaggle、IBM WatsonX、Microsoft Azure、NVIDIA NIM 和 Snowflake 等平台,并得到 AMD、AWS、Dell、Intel、NVIDIA 和 Qualcomm 提供的硬件平台的支持。

-

我们致力于以负责任的方式开发 Llama 3,并提供各种资源来帮助用户负责任地使用它。这包括通过 Llama Guard 2、Code Shield 和 CyberSec Eval 2 引入新的信任和安全工具。

-

在接下来的几个月中,我们将推出新的功能,包括更长的上下文窗口、更多模型尺寸、性能增强,并分享 Llama 3 的研究论文。

-

Meta AI,基于 Llama 3 技术构建,是全球领先的 AI 助手之一,它可以提升您的智力水平,减轻您的负担,帮助您学习、高效完成任务、创造内容和建立联系,让您充分利用每一刻。您可以在这里体验 Meta AI。

今天,我们兴奋地宣布下一代 Llama 的前两个模型,Meta Llama 3,现已开放使用。此版本包含具有 8B 和 70B 参数的预训练和指令微调语言模型,可以支持各种用例。新一代 Llama 在广泛的行业基准测试中展现了最先进的性能,并提供了新的功能,例如改进的推理能力。我们相信,这些模型是同类开源模型中的佼佼者。为了践行我们长期以来的开放理念,我们将 Llama 3 交到社区手中。我们希望在整个技术栈中开启新一波 AI 创新浪潮——从应用程序到开发者工具,再到评估和推理优化等等。我们期待看到您使用它构建的精彩作品,并欢迎您提供反馈。

我们的 Llama 3 目标

通过 Llama 3,我们的目标是构建能够与当今最佳专有模型相媲美的最佳开源模型。我们希望响应开发人员的反馈,提高 Llama 3 的整体实用性,同时继续在负责任地使用和部署 LLM 方面发挥领导作用。我们秉承开源精神,尽早和频繁地发布模型,以便社区能够在这些模型仍在开发中时尽早获得访问权限。今天发布的基于文本的模型是 Llama 3 模型系列中的首批成员。我们在不久的将来的目标是使 Llama 3 支持多语言和多模态,拥有更长的上下文,并持续改进跨核心 LLM 能力(例如推理和编码)的整体性能。

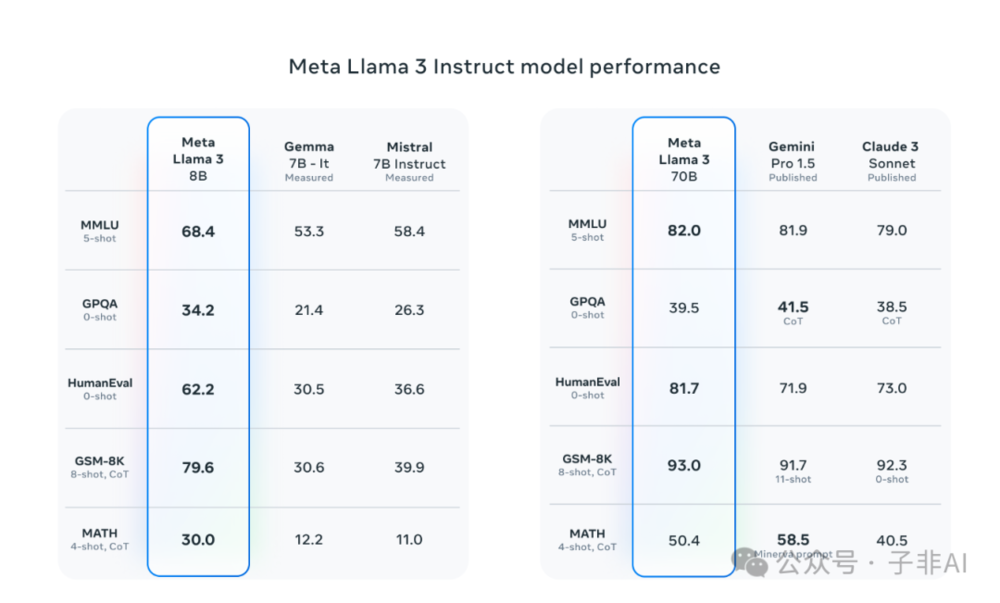

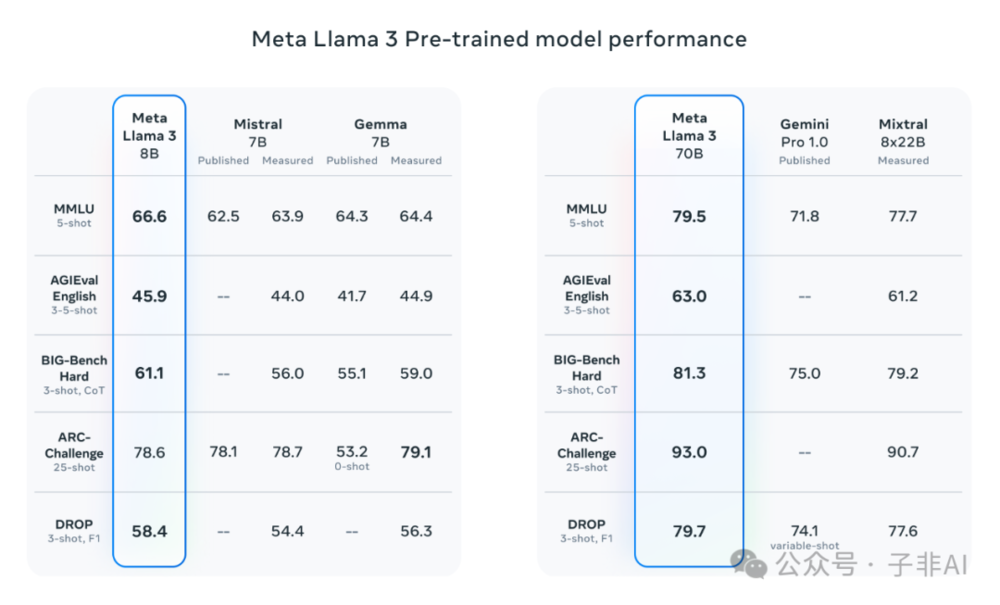

最先进的性能

我们新的 8B 和 70B 参数 Llama 3 模型是 Llama 2 的重大飞跃,并在这些规模上为 LLM 模型树立了新的标杆。得益于预训练和后训练的改进,我们的预训练和指令微调模型是当今 8B 和 70B 参数规模下最好的模型。我们后训练程序的改进大大降低了错误拒绝率,提高了模型对齐度,并增加了模型响应的多样性。我们还看到了推理、代码生成和指令遵循等功能的显著改进,使 Llama 3 更易于控制。

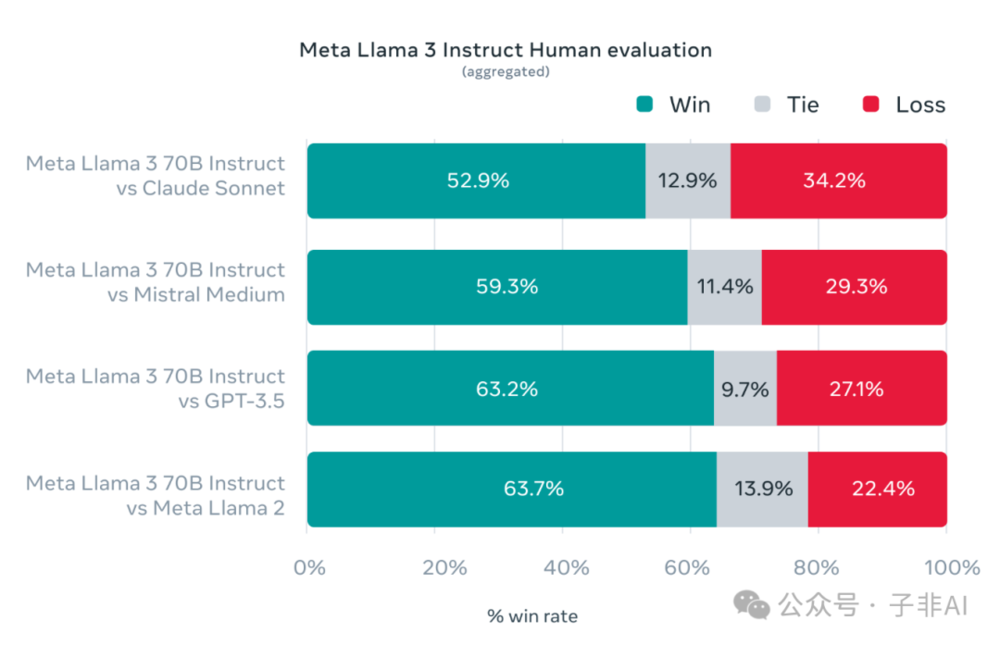

在 Llama 3 的开发过程中,我们不仅关注模型在标准基准测试中的性能,还致力于优化其在真实世界场景中的表现。为此,我们开发了一个新的高质量人工评估集。该评估集包含 1,800 个提示,涵盖 12 个关键用例:寻求建议、集思广益、分类、封闭式问答、编码、创意写作、信息提取、扮演角色/人物、开放式问答、推理、改写和总结。为了防止我们的模型在此评估集上发生意外过拟合,即使是我们自己的建模团队也无法访问它。下图显示了我们对这些类别和提示进行的人工评估的汇总结果,以及 Claude Sonnet、Mistral Medium 和 GPT-3.5 的对比结果。

基于此评估集的人工注释者偏好排名突显了我们的 70B 指令遵循模型在真实世界场景中与同等规模的竞争模型相比的强大性能。

我们的预训练模型还为这些规模的 LLM 模型树立了新的标杆。

为了开发出优秀的语言模型,我们认为创新、扩展和优化简单性至关重要。我们在整个 Llama 3 项目中秉持着这一设计理念,重点关注四个关键要素:模型架构、预训练数据、扩展预训练和指令微调。

模型架构

根据我们的设计理念,我们在 Llama 3 中选择了相对标准的仅解码器转换器架构。与 Llama 2 相比,我们做出了几项关键改进。Llama 3 使用一个具有 128K 个标记的词汇表的标记器,可以更有效地编码语言,从而显著提高模型性能。为了提高 Llama 3 模型的推理效率,我们在 8B 和 70B 尺寸中都采用了分组查询注意力 (GQA)。我们使用掩码对 8,192 个标记的序列训练模型,以确保自注意力不会跨越文档边界。

训练数据

为了训练最佳语言模型,策划一个大型、高质量的训练数据集至关重要。根据我们的设计原则,我们在预训练数据上投入了大量资源。Llama 3 是在超过 15T 个标记上进行预训练的,这些标记全部来自公开来源。我们的训练数据集比用于 Llama 2 的数据集大 7 倍,并且包含 4 倍多的代码。为了支持即将到来的多语言用例,超过 5% 的 Llama 3 预训练数据集由涵盖 30 多种语言的高质量非英语数据组成。但是,我们预计这些语言的性能不会达到与英语相同的水平。

为了确保 Llama 3 接受过最高质量数据的训练,我们开发了一系列数据过滤管道。这些管道包括使用启发式过滤器、NSFW 过滤器、语义重复数据删除方法和文本分类器来预测数据质量。我们发现前几代 Llama 在识别高质量数据方面出奇地出色,因此我们使用 Llama 2 生成文本质量分类器的训练数据,这些分类器为 Llama 3 提供支持。

我们还进行了大量实验,以评估在最终预训练数据集中混合来自不同来源数据的最佳方法。这些实验使我们能够选择一个数据组合,确保 Llama 3 在各种用例中都能表现良好,包括琐事问题、STEM、编码、历史知识等。

扩大预训练

为了有效利用 Llama 3 模型中的预训练数据,我们在扩大预训练方面付出了巨大努力。具体来说,我们为下游基准评估开发了一系列详细的缩放定律。这些缩放定律使我们能够选择最佳数据组合,并就如何最好地利用我们的训练计算做出明智的决策。重要的是,缩放定律使我们能够在我们实际训练模型之前预测我们最大的模型在关键任务上的性能(例如,在 HumanEval 基准测试中评估的代码生成——见上文)。这有助于我们确保最终模型在各种用例和功能中都具有强大的性能。

在 Llama 3 的开发过程中,我们对缩放行为进行了一些新的观察。例如,虽然 Chinchilla 最优的 8B 参数模型的训练计算量对应于约 200B 个标记,但我们发现即使在模型接受了两个数量级更多数据的训练后,模型性能仍会继续提高。在我们对它们进行多达 15T 个标记的训练后,我们的 8B 和 70B 参数模型都继续以对数线性方式改进。较大的模型可以通过较少的训练计算量来匹配这些较小模型的性能,但通常更喜欢较小的模型,因为它们在推理过程中效率更高。

为了训练我们最大的 Llama 3 模型,我们结合了三种类型的并行化:数据并行化、模型并行化和流水线并行化。当同时在 16K 个 GPU 上进行训练时,我们最有效的实现可实现每个 GPU 超过 400 TFLOPS 的计算利用率。我们在两个定制构建的 24K GPU 集群上进行了训练运行。为了最大限度地提高 GPU 正常运行时间,我们开发了一个先进的新训练堆栈,可自动执行错误检测、处理和维护。我们还极大地提高了硬件可靠性和静默数据损坏的检测机制,并且我们开发了新的可扩展存储系统,以减少检查点和回滚的开销。这些改进导致总有效培训时间超过 95%。总的来说,与 Llama 2 相比,这些改进将 Llama 3 训练的效率提高了约 3 倍。

指令微调

为了充分释放我们预训练模型在聊天用例中的潜力,我们也在指令调整方法上进行了创新。我们的后训练方法是监督微调 (SFT)、拒绝采样、近端策略优化 (PPO) 和直接策略优化 (DPO) 的组合。SFT 中使用的提示的质量以及 PPO 和 DPO 中使用的偏好排名对对齐模型的性能具有巨大影响。我们在模型质量方面的一些最大改进来自精心策划这些数据并对人类注释者提供的注释进行多轮质量保证。

通过 PPO 和 DPO 从偏好排名中学习也极大地提高了 Llama 3 在推理和编码任务上的性能。我们发现,如果您向模型询问一个它难以回答的推理问题,该模型有时会产生正确的推理跟踪:模型知道如何产生正确的答案,但它不知道如何选择它。关于偏好排名的培训使模型能够学习如何选择它。

使用 Llama 3 进行构建

我们的愿景是使开发人员能够自定义 Llama 3 以支持相关用例,并使其更容易采用最佳实践并改进开放生态系统。在此版本中,我们提供了新的信任和安全工具,包括使用 Llama Guard 2 和 Cybersec Eval 2 更新的组件,以及 Code Shield 的引入——这是一个推理时间防护栏,用于过滤 LLM 生成的非安全代码。

我们还与 torchtune 共同开发了 Llama 3,torchtune 是一个新的 PyTorch 原生库,用于轻松创作、微调和试验 LLM。torchtune 提供了完全用 PyTorch 编写的内存高效且可破解的训练方案。该库与 Hugging Face、Weights & Biases 和 EleutherAI 等流行平台集成,甚至支持 Executorch 以在各种移动和边缘设备上运行高效推理。从提示工程到将 Llama 3 与 LangChain 结合使用,我们提供了一份全面的入门指南,并指导您从下载 Llama 3 一直到在生成式 AI 应用程序中进行大规模部署。

系统级的责任方法

我们设计 Llama 3 模型是为了最大限度地提供帮助,同时确保行业领先的方法来负责任地部署它们。为了实现这一目标,我们采用了一种新的、系统级的方法来负责任地开发和部署 Llama。我们将 Llama 模型视为更广泛系统的一部分,该系统将开发人员置于驾驶座上。Llama 模型将作为开发人员根据其独特最终目标设计的系统的一个基础部分。

指令微调在确保我们模型的安全性方面也起着重要作用。我们的指令微调模型已经通过内部和外部努力进行了红队(测试)安全性。我们的红队方法利用人类专家和自动化方法生成对抗性提示,试图引起有问题的响应。例如,我们应用全面的测试来评估与化学、生物、网络安全和其他风险领域相关的滥用风险。所有这些努力都是迭代的,并用于为正在发布的模型提供安全微调信息。您可以在模型卡中阅读有关我们努力的更多信息。

LlamaGuard 模型旨在成为提示和响应安全的基础,并且可以根据应用程序需求轻松进行微调以创建新的分类法。作为起点,新的 Llama Guard 2 使用了最近宣布的 MLCommons 分类法,以支持在这个重要领域出现行业标准。此外,CyberSecEval 2 通过添加对 LLM 允许滥用其代码解释器、攻击性网络安全功能以及易受提示注入攻击的倾向的衡量标准来扩展其前身(在我们的技术论文中了解更多信息)。最后,我们推出了 Code Shield,它增加了对 LLM 生成的非安全代码进行推理时间过滤的支持。这提供了针对不安全代码建议、代码解释器滥用预防和安全命令执行的风险缓解。

随着生成式 AI 领域的发展速度,我们相信开放的方法是将生态系统聚集在一起并减轻这些潜在危害的重要途径。作为其中的一部分,我们正在更新我们的负责任使用指南 (RUG),该指南提供了使用 LLM 进行负责任开发的全面指南。正如我们在 RUG 中概述的那样,我们建议根据适合应用程序的内容指南检查和过滤所有输入和输出。此外,许多云服务提供商都提供内容审核 API 和其他负责任部署工具,我们鼓励开发人员也考虑使用这些选项。

大规模部署 Llama 3

Llama3 将很快在所有主要平台上提供,包括云提供商、模型 API 提供商等等。Llama 3 将无处不在。

我们的基准测试表明,与 Llama 2 相比,该标记器提供了改进的标记效率,产生的标记减少了 15%。此外,分组查询注意力 (GQA) 现在也已添加到 Llama 3 8B 中。结果,我们观察到,尽管该模型与 Llama 2 7B 相比多了 1B 个参数,但改进的标记器效率和 GQA 有助于保持与 Llama 2 7B 相当的推理效率。

有关如何利用所有这些功能的示例,请查看 Llama Recipes,其中包含我们所有可用于从微调到部署再到模型评估的所有开源代码。

Llama3 的下一步是什么?

Llama3 8B 和 70B 模型标志着我们计划为 Llama 3 发布内容的开始。还有很多事情要做。

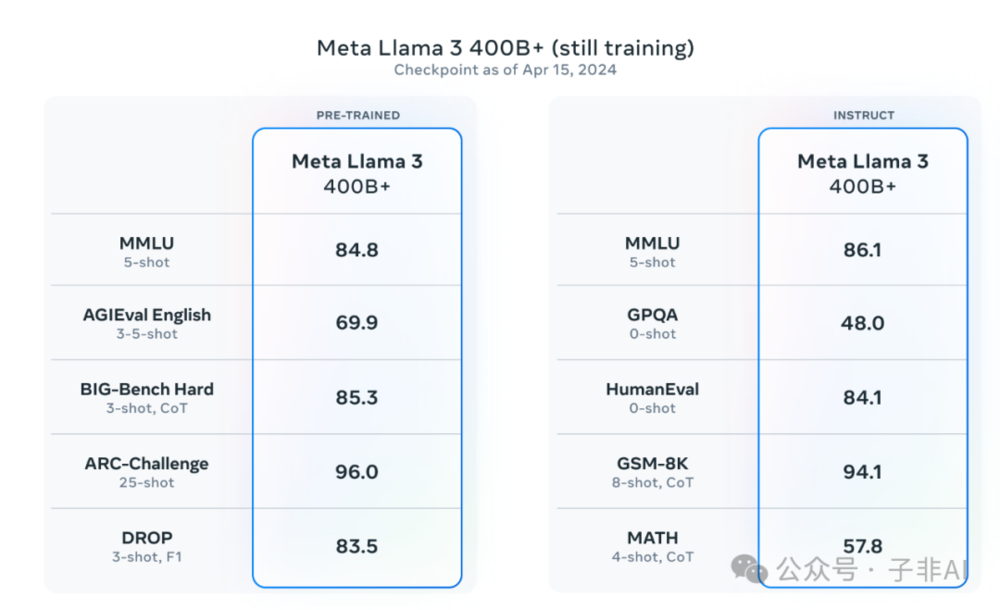

我们最大的模型超过 400B 个参数,虽然这些模型仍在训练中,但我们的团队对它们的趋势感到兴奋。在接下来的几个月中,我们将发布具有新功能的多个模型,包括多模态、能够以多种语言进行对话、更长的上下文窗口以及更强大的整体功能。一旦我们完成 Llama 3 的训练,我们还将发表一份详细的研究论文。

为了让您提前了解这些模型在继续训练时今天的状况,我们认为我们可以分享一些关于我们最大的 LLM 模型趋势的快照。请注意,此数据基于仍在训练的 Llama 3 的早期检查点,并且这些功能不受今天发布的模型支持。

我们致力于持续增长和发展一个开放的 AI 生态系统,以负责任地发布我们的模型。我们长期以来一直认为,开放会导致更好、更安全的产品、更快的创新和更健康的整体市场。这对 Meta 有好处,对社会也有好处。我们对 Llama 3 采取社区优先的方法,从今天开始,这些模型可在领先的云、托管和硬件平台上使用,并且还有更多模型即将推出。

立即试用 Meta Llama 3

我们已将最新的模型集成到 Meta AI 中,我们认为这是世界上领先的 AI 助手。它现在使用 Llama 3 技术构建,并且在我们应用程序中的更多国家/地区可用。

您可以在 Facebook、Instagram、WhatsApp、Messenger 和网络上使用 Meta AI 来完成工作、学习、创造和连接对您来说重要的东西。您可以在此处阅读有关 Meta AI 体验的更多信息。

访问 Llama 3 网站下载模型,并参考入门指南以获取所有可用平台的最新列表。

您还可以很快在我们的 Ray-Ban Meta 智能眼镜上测试多模态 Meta AI。

与往常一样,我们期待看到您使用 Meta Llama 3 构建的所有令人惊叹的产品和体验。

本文来自微信公众号:子非AI(ID:you_are_not_ai),作者:非子爱

子非AI

从思考到创造

从思考到创造