扫码打开虎嗅APP

No.45

2024-04-26

AI精选(45)-人工智能领域内的最新进展

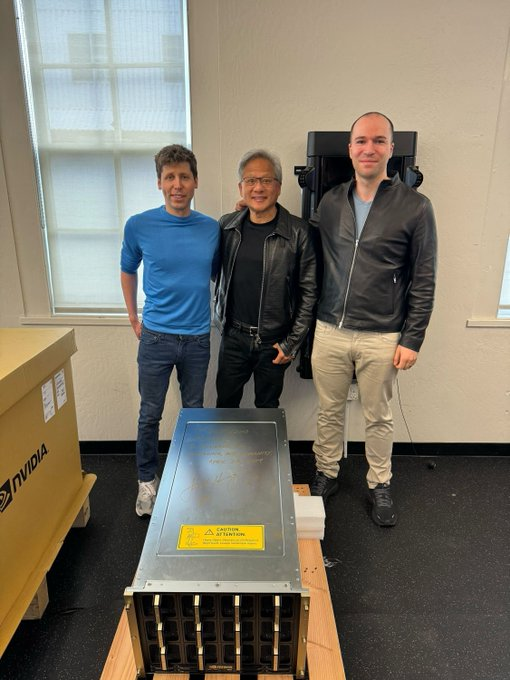

一、黄仁勋亲手将世界首台 NVIDIA DGX H200 交付给 OpenAI

Nvidia 最近将全球首款DGX H200 GPU交付给了OpenAI,这是迄今为止公司开发的最强大的GPU。DGX H200的功率效率提高了50%,在不同的大型语言模型(LLM)任务中,性能提升显著,例如Llama2 13B提升40%,GPT-3 175B提升60%,Llama2 70B提升超过90%。

DGX H200 GPU将帮助OpenAI加速其AI开发,尤其是在其面向产品的ChatGPT以及其他AI项目如Sora视频生成器和所谓的Q* AGI模型等方面。

这些项目需要大量的计算能力,而DGX H200作为目前最强大的GPU,能显著支持OpenAI的这些需求。

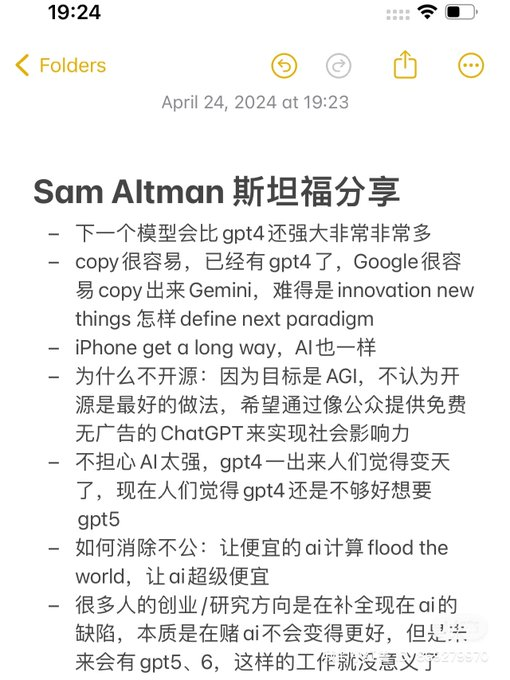

二、Sam Altman 4月24日斯坦福大学讨论要点整理

Sam Altman觉得仅关注当前AI局限性的初创企业和研究可能是徒劳的,因为 GPT-5 和 GPT-6 可能会使这些努力变得过时。” 他设想人工智能将通过融合电影和游戏的个性化、互动体验重新定义娱乐。

三、日本横須賀市使用AI技术克隆了自己的市长,来进行英语信息的发布,毫无疑问语言的鸿沟将越来越小

该克隆市能够以英语向公众传达市政新闻和更新,特别是在市长的定期记者会上宣布的内容。

这些信息将通过市的官方YouTube频道发布,确保信息能够及时且广泛地传达给全球观众。

横須賀市还计划将此技术应用于更广泛的领域,如灾害信息传播、旅游信息发布以及向全世界传递和平等信息。

日本横須賀市还是公务员使用ChatGPT最多的城市,几乎全部城市员工都在使用GPT进行办公。

完整视频:https://youtube.com/watch?v=0Z1wPZ9ngLw

四、Nvidia已收购了总部位于特拉维夫的AI工作负载管理初创公司Run:ai,交易价格为7亿美元

Run:ai成立于特拉维夫大学,由Omri Geller、Ronen Dar和Meir Feder共同创立,专注于开发可以将AI模型分割为多个部分,这些部分可在不同的硬件上并行运行。Run:ai的产品将继续在Nvidia的DGX Cloud AI平台下以同样的商业模式提供,此平台允许企业客户访问计算基础设施和软件,用于训练生成式等形式的AI模型。此外,Run:ai也将增强Nvidia的产品,特别是在多个数据中心部署生成式AI的能力。

至此,Run:ai已成为Nvidia继2019年购买Mellanox的6.9亿美元交易之后的最大一笔收购。在被收购前,Run:ai已从Insight Partners、Tiger Global、S Capital和TLV Partners等投资者那里筹集了1.18亿美元资金。

新闻来源:https://techcrunch.com/2024/04/24/nvidia-acquires-ai-workload-management-startup-runai/

五、Morph Studio,一种一体化 AI 视频工作流程

Morph Studio拥有自己的文本到视频的模型,并引入了一个AI电影制作平台。该工具采用故事板形式,用户可以通过输入不同场景的文本提示来创建和编辑镜头,并将它们组合成连贯的叙述。

Morph与Stability AI合作支持该创作过程,未来Morph计划引入多种生成视频模型供用户选择。用户可以在Morph的创作者社区共享其独特的生产工作流,其他人可以通过更改AI提示来复制和修改模板。

Morph最初专注于制作高清视频,在此加入候补名单: http://morphstudio.com

六、IDM-VTON:虚拟试衣技术

能够生成高度真实的虚拟试衣图像,细节更加精细。

IDM-VTON能够捕捉到服装的细节,如纹理、图案和缝线等,这些细节在试衣图像中被准确地再现。

即使是在户外或者背景复杂的照片中,这项技术也能准确地展示衣物试穿效果,保持高质量的图像输出。

在多个不同的人物上展示同一件服装时,IDM-VTON依然能保持了服装细节的一致性。

项目地址:https://idm-vton.github.io

在线体验:https://huggingface.co/spaces/yisol/IDM-VTON

七、OpenVoice V2版本发布

原生支持英语、西班牙语、法语、中文、日语和韩语 音频质量大幅提升

能轻松克隆任何声音,用多种语言说话,并可控制情感口音

OpenVoice能对声音风格的精细控制,包括情感、口音、节奏、停顿和语调,同时能够复制参考发言者的音色。

八、DeepFacelive: 可以在直播过程和视频通话时进行实时换脸的工具

DeepFaceLive 建立在 DeepFaceLab 的基础上,后者为当前领先的面部交换框架,能够产生接近电影质量的面部合成效果,提供高保真的视觉体验。

•视频通话应用:用户可以在视频通话中实时更换自己的面部,使用来自网络摄像头的实时视频或预录视频。

•直播应用:在直播时,主播可以更改自己的面部表情或整个面容,以吸引观众或增加互动性。

•面部动画器:DeepFaceLive应用中还包括一个面部动画模块,用户可以控制静态面部图片,通过视频或相机捕捉的自己的面部来操作这些图片。

GitHub:https://github.com/iperov/DeepFaceLive…

软件下载:https://deepfakevfx.com/downloads/deepfacelive/…

九、阿里可以让人像照片变成唱歌视频的项目 EMO 终于发布了,体验了一下非常强

一张简单的照片加上克隆的语音模型,字节就可以定制自己的数字人出镜。 Heygen 之类的产品都需要录制一段相当长的视频,并且算力成本也很高,这个直接是免费的。 明天开放公测,想要提前体验的同学可以在后面的推用我的内测邀请码。 而且不局限于写实的人像,3D 模型、 二次元漫画都可以生成视频,生成一张自己喜欢的二次元图片然后加上自己的克隆语音就可以当Vtuber了。

申请链接:https://wjx.top/vm/exOVbr1.aspx#

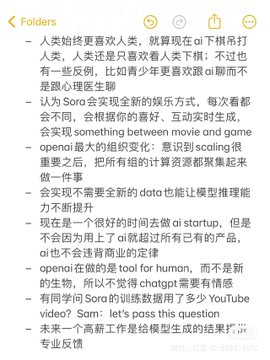

十、苹果也开始学 Meta 了,开源了AI, 而且更加的彻底

完全开源了 OpenELM 一系列模型,包括270M、450M、1.1B和3B四个规模的模型:

不仅包括模型权重和推理代码,还包括了在公开数据集上进行模型训练和评估的完整框架,涵盖训练日志、多个保存点和预训练设置。

还开源了CoreNet:深度神经网络训练库:

使研究人员和工程师能够开发和训练各种标准及创新的小型和大型模型,适用于多种任务,如基础模型(例如,CLIP和大语言模型(LLM))、物体分类、检测以及语义分割。

OpenELM采用按层分配参数的策略,有效提升了Transformer模型各层的参数配置效率,显著提高模型精度。例如,在大约十亿参数的预算下,OpenELM的准确率较OLMo提升了2.36%,且预训练所需的Token数量减少了一半。

CoreNet 项目地址:https://github.com/apple/corenet

OpenELM模型下载地址:https://huggingface.co/apple/OpenELM

论文:https://arxiv.org/abs/2404.14619

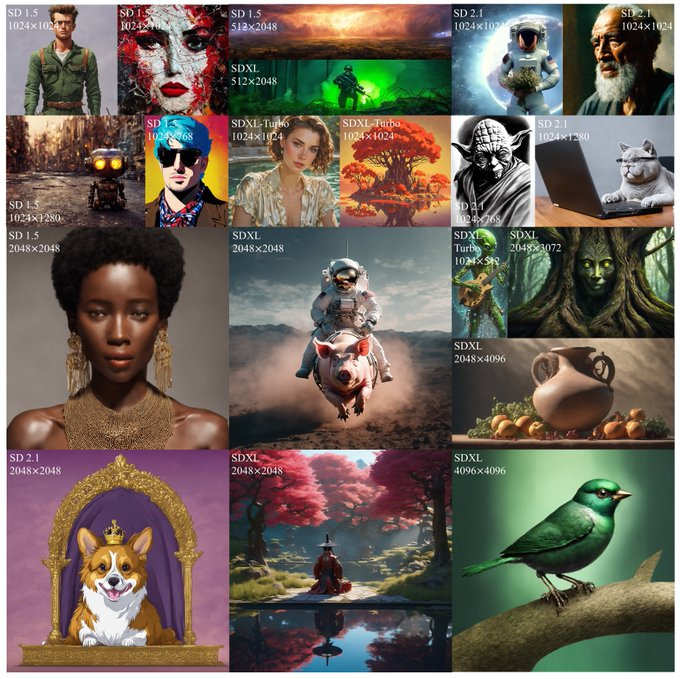

十一、HiDiffusion:大幅提升扩散模型的图像生成质速度提升6倍

该项目由字节跳动的研究团队开发,只需添加一行代码即可将,HiDiffusion 可以无缝地整合到现有的预训练扩散模型中。

它能够使得图像输出分辨率能够扩展到 4096×4096 像素,同时还能将图像生成速度提高 1.5 到 6 倍。

还能在高分辨率图像生成中将推理时间减少 40%-60%。

- 支持的模型: HiDiffusion 支持多种稳定扩散模型,包括 Stable Diffusion XL、Stable Diffusion XL Turbo、Stable Diffusion v2 和 Stable Diffusion v1。此外,它还支持基于这些模型的下游扩散模型,如 Ghibli-Diffusion 和 Playground 等。

- 支持的任务: HiDiffusion 支持多种任务,包括文本到图像的生成、ControlNet 控制网络任务和Inpainting 图像修复。

易于使用: 通过Huggface Diffusers库,使用 HiDiffusion 生成图像极为简单,只需添加一行代码即可

该内容为专享内容

购买AI深度研究员的简报专栏即可查看全部内容

从思考到创造

从思考到创造