扫码打开虎嗅APP

本文来自微信公众号:硅星人 (ID:guixingren123),作者:Juny,原文标题:《Meta新模型“分割一切”:抠图完成究极进化,计算机视觉迎来GPT-3时刻》,题图来自:《钢铁侠》

对于每一个看过漫威的人来说,钢铁侠的头盔无疑是大家都想拥有的一个装备。透过这个头盔,你可以一眼识别并标记出眼前所有的人和物品,并且看到这些事物独特的数据和特点。而现在,Meta正在把这一科幻设想推向现实。

当最近巨头们正在AIGC领域上激战之时,Meta默默地在人工智能的另一个重要分支搞起了大动作——计算机视觉。

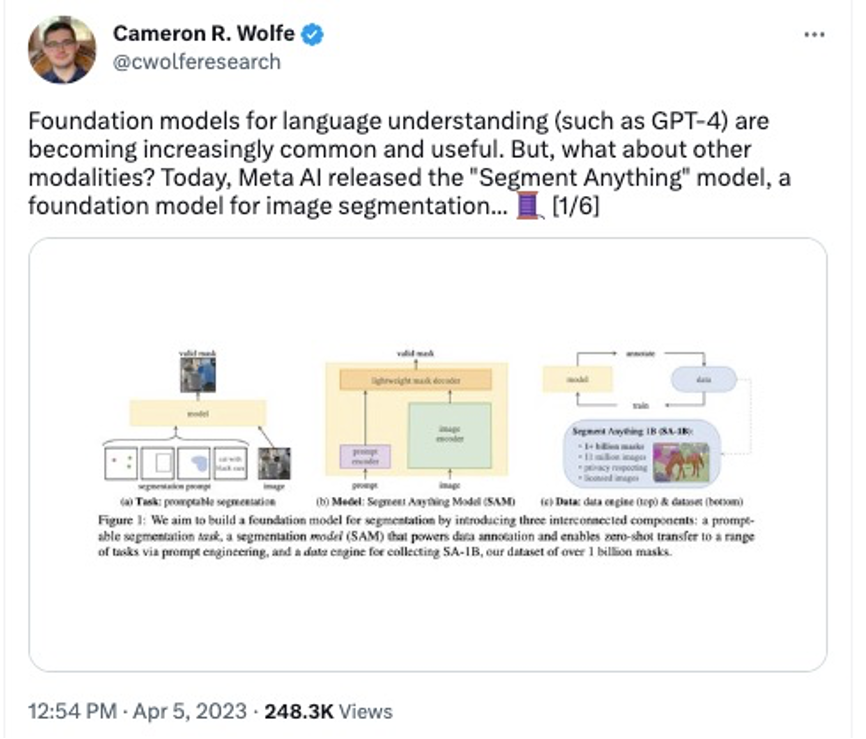

本周三,Meta研究部门发布了一篇名为其“Segment Anything(分割一切)”的论文,文中介绍了一个全新的Segment Anything Model(即SAM),可以用于识别图像和视频中的物体,甚至是人工智能从未被训练过的物品。

所谓的“分割”,用最通俗的话来说就是抠图。但Meta此次所展示的人工智能抠图能力,可能远比你想象的要更加强大,甚至在人工智能领域被认为是计算机视觉的“GPT-3时刻”。

图片、视频一键识别,哪里喜欢点哪里

虽然智能抠图这件事并不算是个新鲜事物,但如果你尝试过用P图软件来抠图换背景,就会发现想把照片抠得快、抠得准、抠得自然其实是一件费时又费力的事。

从技术的角度来说,数字图像的“抠图”一直就是计算机视觉领域的一项经典且复杂的任务,其中关键的难点在于识别的时间和精准度。而Meta此次发布的SAM可以说给出了近乎完美的解决方案。

对于任何一张照片,Meta都可以快速识别照片中的所有物体,并智能地将其分割成不同的形状和板块。你可以点击图中的任意物品进行单独处理。

图/Meta

此次SAM的一大突破还在于,即使是在训练过程中从未遇到过的物品和形状,人工智能也能将其准确识别并分割出来。

图/Meta

而除了简单的识别图片中的物品之外,此次SAM还支持用户使用各种交互性的方式来分离出想要的物体。

比如你可以通过将鼠标悬浮在该物体之上,就能自动定位出物体的轮廓。即使是颜色非常相近或者有连人眼都很难快速分辨出的倒影的图片之中,SAM都能非常准确找出轮廓边线。

图/Meta

再比如,你也可以直接通过输入文字查询,AI就可以帮你找到并标记出这个图片中你想找的这个文字对象。

图/Meta

不仅仅是静态图片,对于视频中的物体,SAM也能准确识别并且还能快速标记出物品的种类、名字、大小,并自动用ID给这些物品进行记录和分类。

Meta表示,未来这一技术会跟AR/AR头显进行广泛结合。这听上去是不是确实有点钢铁侠头盔的味道了?

图/Meta

看到这里是不是已经觉得很厉害了?别着急,Meta这次还有大招。

除了能把物品从图像中精准地分离出来,SAM还能支持对这个物品的编辑。也就是说,你可以把这个衣服从这个模特身上换下来,或许再换个颜色改个大小,放在另一模特身上。

图/Meta

你也可以把物体从静态图片中“抠”出来的椅子,进行3D渲染和编辑,让它从一个图片立刻动起来,接着你还可以改变形状或者进行更多的创意操作。

图/Meta

计算机视觉领域的 GPT-3 时刻,打开更大应用想象空间

Meta发布了SAM之后,立刻吸引了大量关注,甚至在很多人工智能业内人士的眼中,SAM的出现可以说是计算机视觉领域的GPT-3时刻。

英伟达人工智能科学家Jim Fan表示,此次SAM最大的一点突破是它已经基本能够理解“物品”的一般概念,即使对于未知对象、不熟悉的场景(例如水下和显微镜里的细胞)它都能比较准确地理解。

不仅是Jim有这样的观点,一些AI研究专家甚至也表示,SAM之于计算机视觉,就像是GPT之于大语言模型。

图/Twitter

而就在SAM昨天发布之后,很多人也在第一时间上手进行了实测。硅星人浏览了一圈,发现不仅基本满屏都是惊叹,一些网友还结合自身的工作领域打开了SAM更广的应用想象空间。

有人将包含了众多复杂元素的图片上传之后,SAM识别起来毫无压力,无论是近景还是远景,大量的复杂细微的元素都可以基本准确找出。

图/Twitter

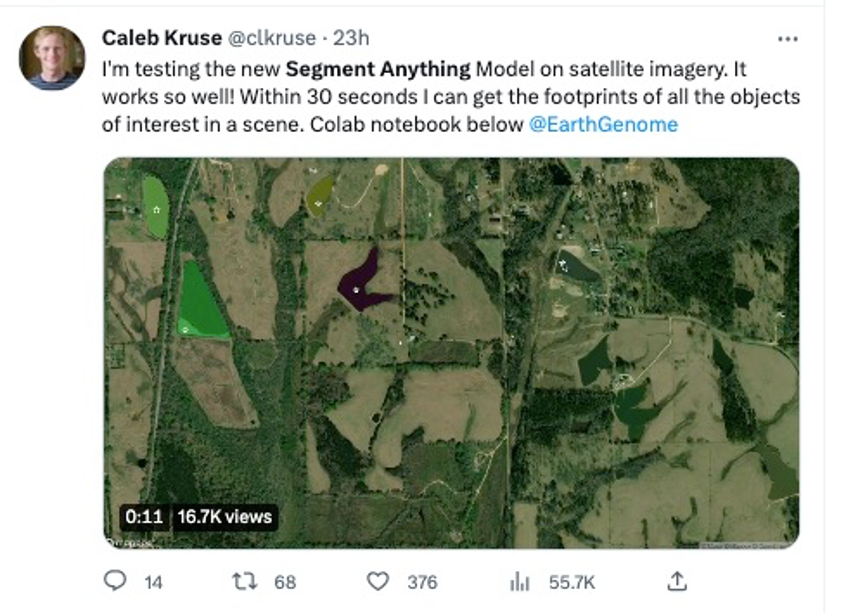

有自然科学研究者将SAM和卫星图像结合在了一起,表示SAM能够很好地识别和找到他标记的风貌类型。

图/Twitter

有神经外科影像学的专家将SAM用到了一个脊髓血管病的病例文件之中,认为SAM在帮助判断和分析病情上有很大帮助。

图/Twitter

有生物学家输入了一张显微镜下的组织图片,即使图中形状特征毫无规律,但凭借着Zero-shot技术,SAM也能够自动识别多细胞结构中的腺体、导管、动脉等。该生物学家认为SAM的产出结果已经非常接近完美,未来能够节省大量手动注释的时间。

图/Twitter

还有有骑行爱好者将地图和SAM结合起来,认为能够帮助自己未来更快更高效地给地图做标记。

图/Twitter

基于1100万张照片训练,模型和数据全部开源

总体来看,跟过去的一些计算机视觉模型相比,SAM 在几个方面有着显著的提升和不同:

首先,SAM开创性地跟Prompt结合了起来。它可以接受各种输入提示,例如点击、框选或指定想要分割的对象,这种输入并不是一次性指令,你可以不停地对图像下达不同的指令达到最终的编辑效果,这也意味着此前在自然语言处理的Prompt模式也开始被应用在了计算机视觉领域。

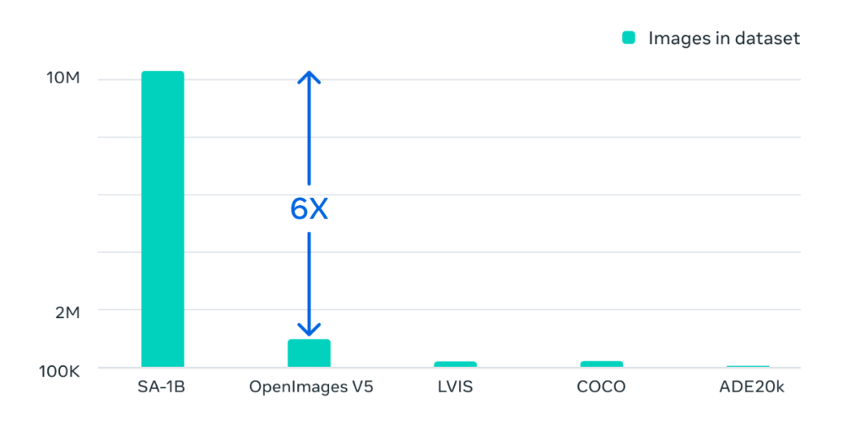

此外,SAM基于1100万张图像和11亿个掩码的海量数据集上进行训练,这是迄今为止最大的分割数据集。该数据集涵盖了广泛的对象和类别,例如动物、植物、车辆、家具、食物等,这些图像的分辨率达到了1500×2250,平均每张图像约有100个掩码。此次SAM采用了轻量级掩码解码器,可以在每次提示仅几毫秒内在网络浏览器中运行。

SAM在各种分割任务上具有很强的零样本性能。零样本意味着SAM可以在不对特定任务或领域进行任何额外训练或微调的情况下分割对象。例如,SAM可以在没有任何先验知识或监督的情况下分割人脸、手、头发、衣服和配饰。SAM还可以以不同的方式分割对象,例如红外图像或深度图等。

SAM的训练数据集是OpenImage V5的6倍

Meta表示,目前公司内部已经开始使用SAM相关技术,用于在Facbook、Instagram等社交平台上照片的标记、内容审核和内容推荐等。而之后,生成人工智能作为“创意辅助工具”也将被作为今年的重点优先事项被纳入到Meta更多的应用程序中。

此次,可能最让很多业内人士惊喜的地方在于,无论是SAM模型还是巨大的训练数据集都是开源的!也就是说,目前任何人都可以在非商用许可下载和使用SAM及数据。

Meta表示,此举是希望进一步加速整个行业对图像分割以及更通用图像与视频理解的研究。‘Meta也预计,随着SAM的演进和发展,该技术可能会成为未来AR/VR、内容创作、设计更多领域的强大的辅助工具。

作为一个新兴的研究模型,SAM现在的使用门槛其实并不高,即使你是一个完全不懂AI的普通用户,在segment-anything平台上也可以去亲身体验一下它神奇的抠图功能。感兴趣的小伙伴快去试试吧!

参考资料:https://research.facebook.com/publications/segment-anything/

本文来自微信公众号:硅星人 (ID:guixingren123),作者:Juny