扫码打开虎嗅APP

本文来自微信公众号:新智元 (ID:AI_era),作者:新智元,原文标题:《GPT-5停不停?Bengio痛心跳出呼吁,LeCun怒斥AI末日论者》,头图来自:视觉中国

呼吁暂停比GPT-4更强AI训练的公开信,把超强AI的种种争议,更加激烈地推到了公开的台面上。

这几日,后续激辩不断,几方立场愈发两极分化。

而公开信的签名人数,也从最初的1000出头,猛增到了近1.6万。

图/公开信签名人数截图

面对接踵而至的指责和质疑的声浪,OpenAI匆忙在凌晨发文回应:我们会坚决保障AI安全,绝不“偷工减料”!

2018图灵奖得主之一的Bengio,昨天专门在自己的博客上写了一篇长文,解释自己为什么签名赞成暂停超强AI研发。

而另一位图灵奖得主LeCun一再表示,这种暂停根本就没有必要,而且与AI末日论者辩论真的毫无意义。

在与众网友舌战多日后,他将于明天和吴恩达亲自出镜,向大众公开解释为什么他们不赞同暂停训练超强AI 6个月。

图/LeCun在社媒发布的信息

一、LeCun:与AI末日论者辩论毫无意义

今日,LeCun发推再次强调自己的立场:人类需要机器智能。

“历史一再表明,智能越多,社会和人类的福祉就会越多:我们会拥有更好的技能、读写能力、教育、创造力、文化、沟通和思想的自由交流。”

“人类和机器的智能是进步的动力。”

图/LeCun在社媒发布的信息

“机器智能是增强人类智能的一种方式,就像机械工具增强人类体能一样。”

图/LeCun在社媒发布的信息

在他看来,担心AI会灭绝人类,这种想法非常荒谬。

图/LeCun在社媒发布的信息

“人们对AI风险过度担忧的唯一原因,就是这个神话:当你打开一个超级智能系统的那一刻,人类就注定要灭亡。这是荒谬的愚蠢,基于对AI运作方式彻底的误解。”

而且,今天关于AI安全的讨论,跟1890年关于客机安全的讨论一样,全是推测性的。

“在我们拥有可靠达到人类智能水平的AI系统的基本设计和演示之前,关于它们的风险和安全机制的争论还为时过早。”

图/LeCun在社媒发布的信息

图/LeCun在社媒发布的信息

有网友在评论区中问他,Hinton的访谈你听了吗?

图/Hinton访谈视频截图

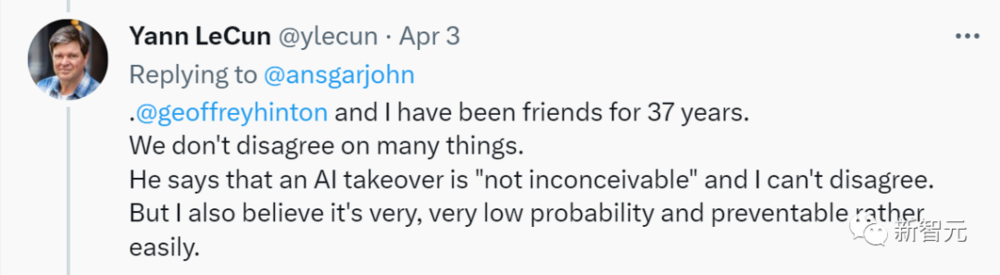

LeCun表示:我和Hinton都是37年的朋友了,我们在很多事情上都没有分歧。

他说,AI接管“并非不可想象”,他并不反对。但他相信,这种事情的概率极低,也很容易预防。

图/LeCun在社媒发布的信息

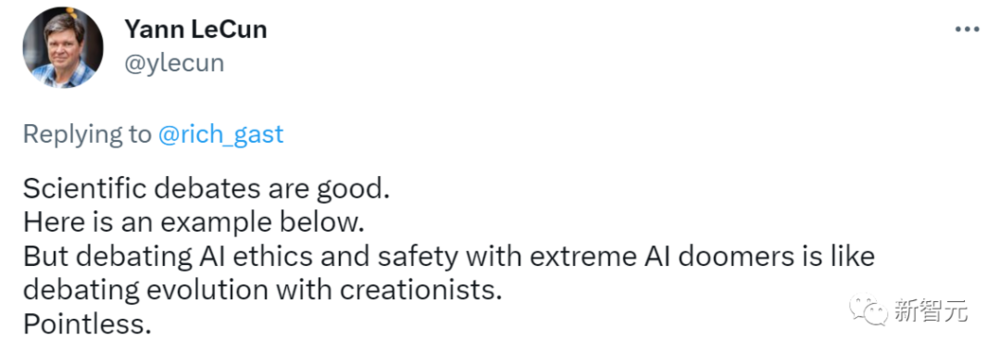

然后,LeCun给网友们分享了自己在几年前与Bengio、Russell、Zador等大佬辩论的帖子,告诉大家,这才叫有意义的辩论。

但是,与极端的AI末日论者辩论AI伦理和安全,就像与神创论者辩论进化论一样,毫无意义。

图/LeCun在社媒发布的信息

有网友感谢LeCun分享这场辩论,但是强调有些人就是不相信以利润为导向的公司会将人类和地球的安全置于利润之上,把他们称为AI末日预言者,是武断和不公平的。

图/网友回应

而LeCun转发了这样一篇论文。他评论道:“由于担心动荡,奥斯曼帝国限制了印刷书籍的传播。因此,它错过了启蒙运动,失去了在科学技术上的主导地位,并最终失去了经济和军事上的影响力。”

图/论文截图

在他看来,阻止AI替代我们的高技能工作岗位,也是如此。

图/LeCun在社媒发布的信息

二、Bengio:需要按下暂停键

另外,签署公开信的深度学习三巨头之一Yoshua Bengio在沉默几天后,首次解释了自己加入FLI呼吁的看法:

“一年前我可能不会签署这样一封信。正是因为人工智能发展出现了意想不到的加速,因此我们需要退一步。并且我对这些问题的看法已经改变了。”

图/社媒相关信息截图

就此,Bengio在自己的网站上发表了一篇长文,具体解释了签署公开信的原因——技术进步需要放缓,这样才能确保安全、保护集体的福祉。

图/Yoshua Bengio

Bengio认为我们已经越过了一个关键的门槛:机器现在可以和我们对话,甚至假装成人类。

而且,自从ChatGPT发布以来,大家发现不那么谨慎守规矩的玩家会有竞争优势,如果是这样的话,那么通过降低谨慎和道德监督的水平,就可以更容易出头。

面对更加激烈的商业竞争,OpenAI也可能会急于开发这些巨大的人工智能系统,把他们在过去十年的人工智能研究中养成的透明和开放科学的良好习惯抛在脑后。

Bengio表示,签署这封公开信可以提醒学界和工业界:我们必须花时间更好地了解这些系统,并在国家和国际层面制定必要的框架,来增加对公众的保护。

即使签署这封公开信造成的影响可能没有那么大,但是起码会掀起一场全社会的讨论。我们将不得不在未来几年做出集体选择,包括我们想用我们正在开发的强大工具做什么。

从中短期风险来看,可能是出于政治目的操纵公众舆论,特别是传播虚假信息,这很容易预测;而长期风险就是偏离程序员所设定的目标,对人类造成伤害,这种风险很难预测。

但是这封公开信并不是要叫停所有的AI研究,也并不是说GPT-4将成为自主的AI并威胁到人类。相反,危险的是怀有不良意图的人类或根本不知道其行为后果的人类,在未来几年内可能利用这些工具危及人类的未来。

图/Yoshua Bengio

现在,我们需要规范这些系统,提高人工智能系统的透明度和监督,保护社会。风险和不确定性已经如此严重,因此我们的治理机制也要加速发展。

社会需要时间来适应变化,法律需要时间来通过,监管框架需要时间来落实。Bengio认为迅速提高意识,把这个问题放在更多的场合去进行更多的公众辩论是很重要的。

不过,从根本上来说,Bengio对技术是乐观的,他认为技术将能够帮助我们克服人类面临的巨大挑战。然而,为了面对这些挑战,现在需要的是去思考如何调整我们的社会,甚至完全重塑它们。

“我们应该放弃吗?当然不是。减少对未来的损害,我们总是有办法做得更好,在正确的方向上的每一步,都会有所裨益。”

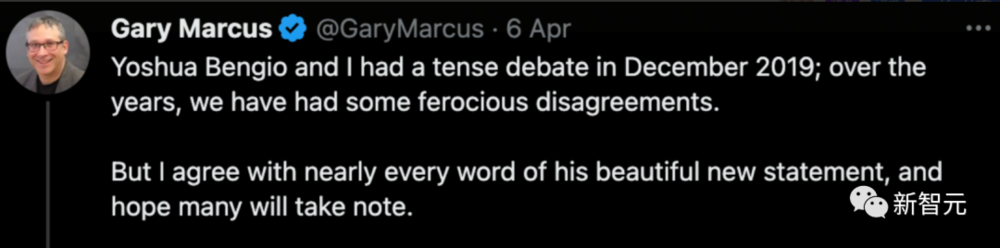

对此,纽约大学马库斯也表示了支持,尽管两人之前有些意见相左。

图/马库斯社媒截图

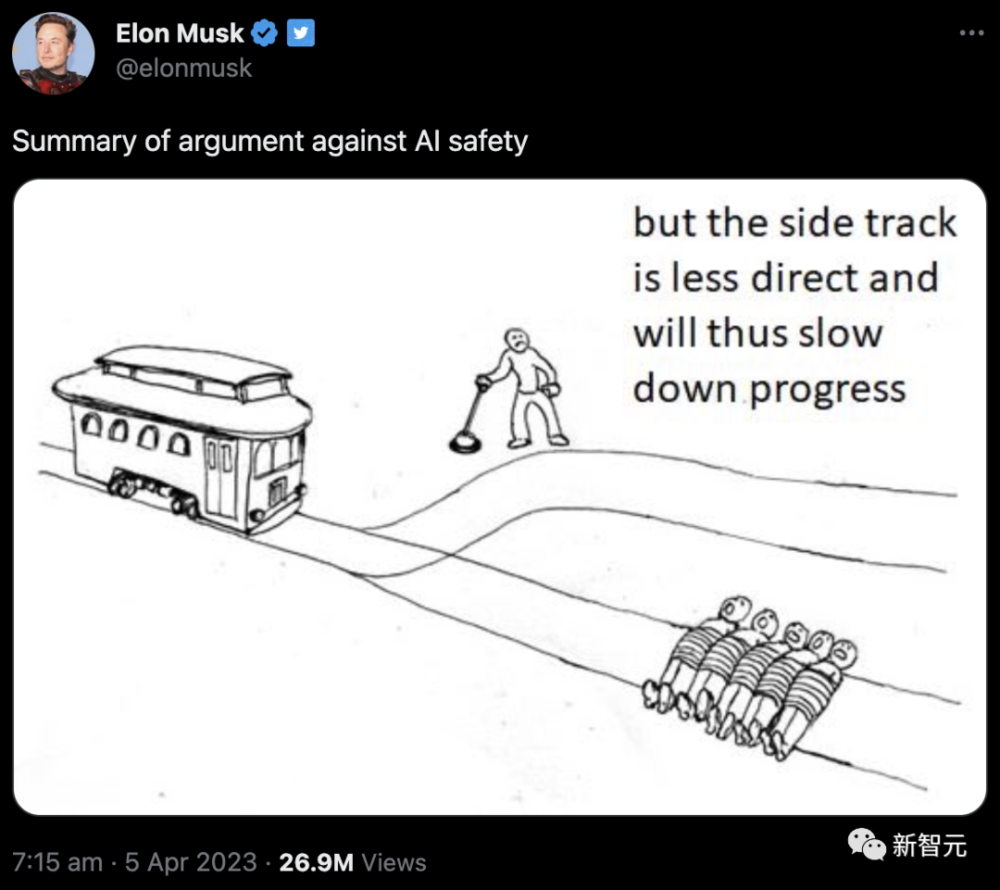

三、马斯克:这是个电车难题

另一边,作为公开信支持者的马斯克表示,你们这些反对暂停的人就属于下面这种人:

“另一条路太绕,会减慢AI的发展,不如还是直接碾过去吧。”

图/Musk社媒截图

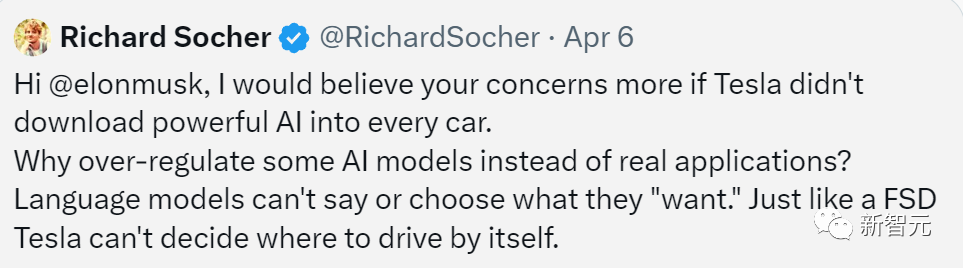

而有网友指出了“华点”——“如果你没有将强大的AI装到每一辆特斯拉中,我会更相信你的担忧。”

“为什么过度监管某些AI模型,而不是实际的应用程序呢?语言模型无法说出或选择它们‘想要’的内容,就像特斯拉的FSD系统不能自己决定开到哪里。”

图/网友评论

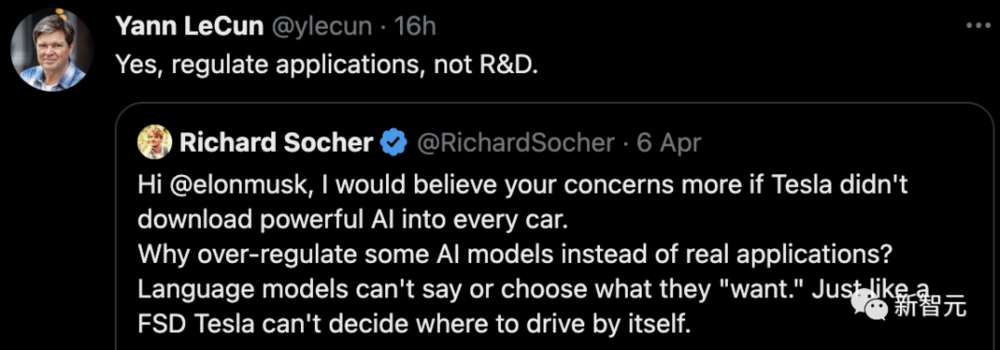

LeCun转发了该网友的推文,表示同意:“没错,应该去规范应用,而不是研发。”

图/LeCun社媒截图

四、OpenAI急忙澄清

眼看AI安全已经成为众矢之的,OpenAI急忙出面,表示自己也很重视AI安全。

图/OpenAI的澄清长文

在昨天发布的Our Approach to AI Safety的长文中,OpenAI主要探讨了安全地构建、部署和使用人工智能系统的方法。

OpenAI表示,强大的人工智能系统应该接受严格的安全评估。

GPT-4在发布之前,对其进行了严格的测试,内部员工耗时6个月去确保发布前让模型更加安全和一致。

并且,还让外部专家参与反馈,利用人类反馈强化学习(RLHF)等技术改善模型的行为。

另外,文中还列出了其他确保AI安全的方法:

从真实世界的使用中学习,以改进保障措施;保护儿童;尊重隐私;提高事实的准确性。

最后,OpenAI提出了应该“继续研究和参与”。这一点可以说是对近来呼吁暂停超强AI研发的正面回应。“我们认为,解决人工智能安全问题的实用方法是投入更多的时间和资源来研究有效的缓解措施和调整技术,并针对现实世界的滥用进行测试。”

图/OpenAI的澄清长文

暂停六个月,时间够吗?

根据一项调查,69%的美国成年人强烈支持或在一定程度上支持暂停开发六个月,但也有人认为这似乎只是徒劳。

图/票数分布

而关心AI会毁灭人类这个话题的人,和不关心的人,大约各占一半。

图/票数分布

参考资料:

https://yoshuabengio.org/2023/04/05/slowing-down-development-of-ai-systems-passing-the-turing-test/

https://twitter.com/GaryMarcus/status/1643754841221783553

本文来自微信公众号:新智元 (ID:AI_era),作者:新智元