扫码打开虎嗅APP

本文来自微信公众号:与非网eefocus(ID:ee-focus),作者:刘浩然,头图来自:视觉中国

马克思曾在《资本论》中阐述资本主义:“如果有10%的利润,资本就会保证到处被使用;有20%的利润,资本就能活跃起来;有50%的利润,资本就会铤而走险;为了100%的利润,资本就敢践踏一切人间法律。有300%以上的利润,资本就敢犯任何罪行,甚至去冒绞首的危险。”

以那个时代的经济环境来看,马克思认为资本家的获利上限大概就是3倍利润。不过如今经济全球化叠加地缘政治冲突的情况下,3倍利润似乎已难以形容一家企业发展的势头。

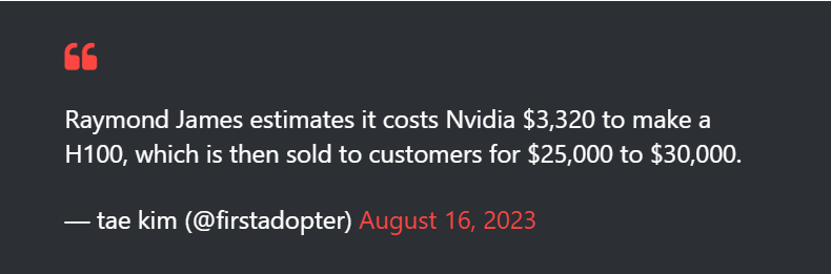

8月16日,《巴伦周刊》资深撰稿人Tae Kim最近在社交媒体上发布的帖子估计,英伟达每销售一块H100 GPU就能获得高达1000%的利润。投资银行公司Raymond James表示:“H100 GPU的起价为3320美元,该公司(英伟达)以25000至30000美元的价格出售这些GPU。尽管我们没有获得AI GPU的BoM表单,但我们当然相信这只是一个粗略的估计,NVIDIA可能会赚得更多。”

图源:profesional review

多个平台分析师认为,H100的售价远高于其实际价格,1000%的估算可能还没有考虑到通货膨胀的因素,实际数字可能还要高得多。

事实上,英伟达的GPU并不是第一次暴涨。过去几年,尤其是2016年~2021年之间,“加密货币”的兴起为GPU行业注入了源源不断的热钱。尽管2022年末“挖矿”退潮,英伟达曾一度面对销量危机,但紧随而来的AI又让英伟达快速恢复元气。

如今英伟达又一次站在风口之上,只不过这一次它的利润率似乎有些恐怖了。10倍利润的背后,是谁撑起了GPU价格?

一、谁在抢购H100?

在智能时代,数据、算力与算法被称为基础三要素,其中算力则是核心基础。当ChatGPT引领全球进入AI时代后,算力稀缺正逐渐成为制约AI发展的最大瓶颈。而算力,正是GPU等擅长并行计算芯片的最大特点。因此,对算力需求越大,则越需要H100等高算力芯片。

图源:国泰君安

1. 中美大厂

H100 GPU是英伟达继A100之后的又一款旗舰GPU,曾经A100已经被认为是AI服务器上的“核心主力”。据OpenAI资料显示,目前最知名的AI大模型ChatGPT,训练一次13亿参数的GPT-3 XL模型每天需要的全部算力约为27.5PFlop/s,而训练一次1746亿参数的GPT-3模型每天需要的算力约为3640 PFlop/s。即使是在对模型的日常运营上来看,OpenAI仍旧需要每日消耗4800PFlop/s的算力。

这还仅是OpenAI一家的算力需求,国泰君安证券统计,ChatGPT爆火之后,以谷歌、Meta、亚马逊为首的互联网大厂也在跟进。据谷歌资料显示,目前已经建成包含26000个H100的A3服务器,还部署了数十台TPU V4超级计算机,每台拥有4096个TPU芯片;亚马逊官方资料显示,它们即将推出的EC2超级集群可以扩展至20000个互联的H100;Meta资料显示,亚马逊云已经拥有2000个DGX A100服务器,配备了超过16000个A100 GPU,亚马逊专家表示未来他们还会采购3万片H100。

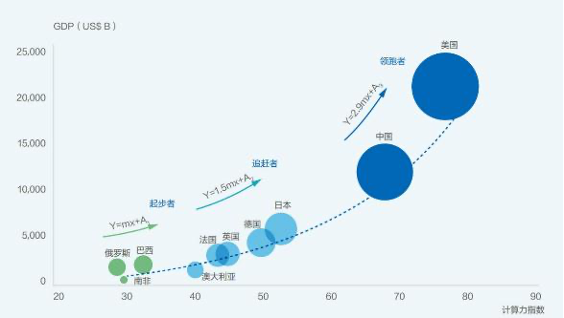

算力对经济的影响 图源:中国通信院,国泰君安

国内也涌现出诸如百度文心一言、讯飞星火大模型、360智脑等。在群雄逐鹿的大模型战争上,全球算力呈现极度紧缺态势,因此,AI服务器也成为英伟达GPU的最大应用领域。

2. 中东

如果将地区的算力用山峰山谷的形式呈现在世界地图上的话,我们将看到中美两国会升起全球最高的两座山峰。根据信通院算力白皮书信息显示,美国、中国、欧洲、日本在全球算力规模中的份额分别为34%、33%、14%与5%,其中全球基础算力,美国份额达37%,中国以26%份额排名第二。

美中欧日算力分布的局面,与当前世界上经济体量的分布大体相同。毕竟如今一张AI服务器专属GPU动辄数万美元,没点“家底”真的是玩不起的。不过说到经济实力,我们似乎忽略了世界上还有一群“钱多到流油”的国家——沙特与阿联酋为首的海湾石油大国。

别看如今算力地图上并无中东国家身影,但很明显,AI引领的第四次信息革命之下,没有一个国家想要落后。

据外媒《金融时报》消息显示,沙特阿拉伯最近以4万美元单价购入了至少3000块英伟达H100 GPU芯片。此外阿联酋也同样购买数千颗英伟达芯片,并将它们部署在阿布扎比马斯达尔市的国有技术创新研究所内,用于创建了名为“Falcon”的大型语言模型上。消息人士称阿联酋已经做出决定,它希望拥有和控制其计算能力和人才,拥有自己的平台,而不是依赖中国人或美国人。此外,沙特大学拥有至少200台满载A100的服务器,预计还将建成并投入使用一台超级计算机Shaheen III,这台超级计算机仍旧会采用英伟达的芯片。

简单总结一下,当ChatGPT凭借一个月的时间狂砍上亿用户数量来看,全球几大经济体已经开启“算力大战”,对高算力AI芯片的需求远超英伟达的供应能力。此外,AI浪潮下,除了中美等国,中东国家如阿联酋和沙特也积极参与这一抢购浪潮,意图借助英伟达H100GPU来推动本国AI技术的快速发展。

二、为什么是H100?

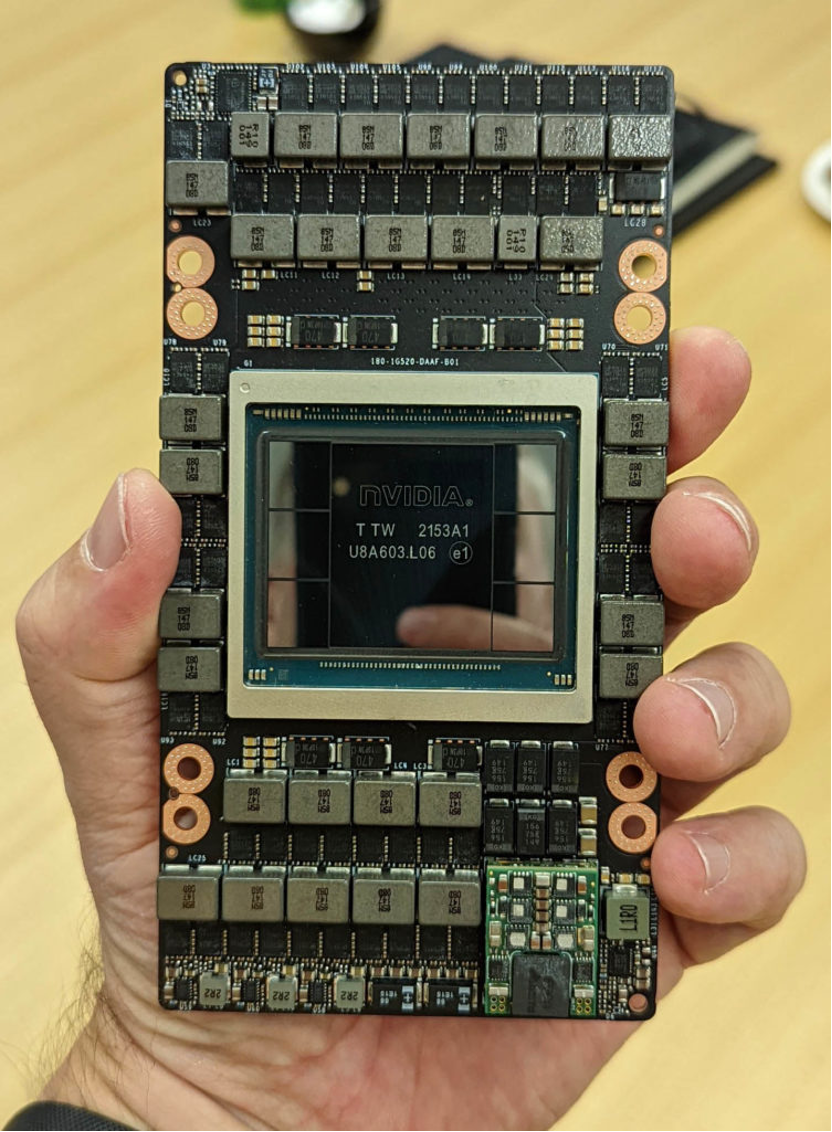

从当前的市场占比来看,英伟达已经以极其恐怖的占比在GPU领域获得了显著优势,在AI服务器领域已经近乎垄断。在今年3月结束的GTC大会上,英伟达创始人黄仁勋又身着一身皮衣现身发布会。会上他自豪地拿着H100 H100 NVLINK芯片,宣布要让英伟达成为AI中的台积电。AI的大趋势无人可挡,既然H100被炒得这么高,那换其他GPU不可以吗?

H100 是一款针对大模型专门优化过的芯片,使用台积电5nm定制版本制程(4N)打造,单块芯片包含800亿晶体管。H100同时也是全球首款PCI-E 5和HBM 3GPU,一块GPU的IO带宽就是40 Terabyte/s。

英伟达H100 GPU 图源:STH

对于ChatGPT等大模型的训练来说,算力决定了模型的训练速度,这与GPU的张量核心(NPU)数量有关,不过其他参数也深刻影响着大模型的训练效果。

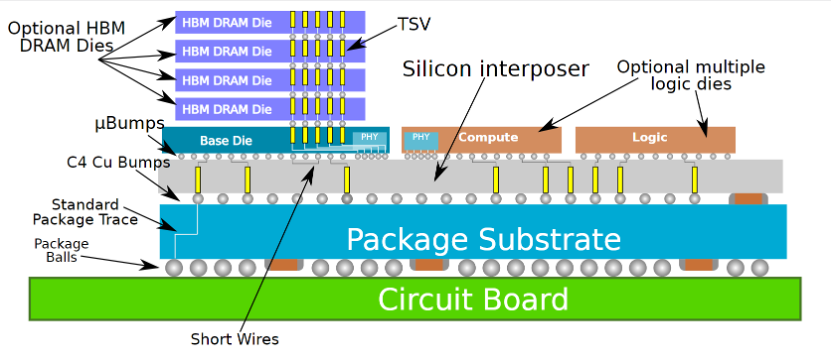

目前H100等专为AI训练设计并制造的显卡,均采用HBM内存作为GPU的配套存储。HBM相对传统显存来说,其颗粒利用3D封装的方式上下堆叠在一起,可以有效提升存储与计算芯片之间的信息交换速率,对于AI大模型这种需要高频读取的算法来说,影响更甚。因此,普通GPU,例如英伟达最知名的RTX系列GPU就难以胜任大模型AI的训练任务。

我们还能从A100到H100升级的参数上看出AI对于GPU的需求。相对于A100,H100有更低的缓存延迟和FP8计算能力。HBM可以提升缓存延迟,而提升FP8则是让H100真正成为一颗“专注”AI的芯片。

FP8指的是8bit的Float数据类型,内存占用为FP32的1/4,FP16的1/2。FP8被广泛用于AI训练之中,与FP16相比,FP8格式的训练吞吐量增加4倍,但损失精度不到0.1%。因此,应用提升FP8计算可以有效降低模型对内存的需求,提升训练速度并降低功耗,直接降低了训练成本。

不过可能有观众指出,既然H100更适合AI服务器,那英伟达的死对头AMD是否有“平替”呢?

海外独角兽的一份调查中显示,AMD GPU理论上是可行的,但企业在面对替换风险与GPU软件生态,仍认为选择英伟达的GPU更为保险。文章中认为,某私有云公司的高管表示,设备从购买到实际真正运转都需要一定时间,即便只是2个月左右的开发和调试时间都意味着比竞争对手更晚进入市场。

因此,拥有CUDA生态的英伟达可以率先占据开发者的使用习惯,形成生态“护城河”。此外,文中另一观点认为很多公司的AI大模型训练成本已经接近3亿美元,没有人会冒险去大规模依赖AMD或其他初创公司的芯片。

CoWoS技术 图源:wikichip

其实,记者了解到,目前生产H100等当前最先进GPU需要台积电的CoWoS封装。目前英伟达早已预订了绝大部分该类先进封装的产能,即使其他厂商想要与英伟达一争高下,也需要等台积电扩产才行。

三、1000%的利润被谁拿走?

尽管在全球抢购与其不可替代属性的加持下,H100的售价已经达到了“黑心”的程度,但1000%的利益仍旧高得可怕。究其原因,其实这1000%的利润率并没有完全进了英伟达一家腰包。H100从工厂到用户手中,其实经过了不止一道程序。而这一切的原因还要追溯到2022年美国的一则禁令。

2022年9月2日,英伟达对外宣布,已经获得美国政府批准,可以在明年3月前继续向美国客户出口的产品提供A100,可以在明年9月前继续履行A100和H100的订单。

换言之,就在10天之后的2023年9月1日,英伟达A100与H100全系列GPU将被禁止出口到中国。此外根据美国证券交易委员会通知,英伟达将需要获得许可才能向中国和俄罗斯出口任何基于最新架构的H100、A100或DGX/HGX等系统。

禁令发出后,尽管中国企业仍可以通过美政府批准后继续进口H100,事实上中国对于H100的采购早已停止,美国此举可能仅为了保护在华美资企业尾单不受损。不过H100的流通,可能不止局限于常规渠道。

此前曾有诸多报道指出,H100、A100正以一些非常规渠道从全世界流入中国境内。路透社曾采访过多家中国运营商,他们均表示还能轻松采购少量A100或H100芯片,并通过航空运输至境内客户手中,因为小批量采购可以更容易规避制裁与出境监管。据了解,这些供应商的进货渠道遍及全球,他们使用多种身份从官方渠道采购后再流转进入中国。据了解,通过这种方式“悄悄”进货的方式,购买价格要比通过常规途径进货贵两倍,A100的入手价格能达到2万美元左右。H100由于出品较晚,价格仍不稳定,但其售价绝对会高出天际。

因此,尽管目前市场上充斥着超高售价的H100与A100,但这1000%的利润大概不会被英伟达全部拿走。马斯克在推特调侃:“似乎每个人、每条狗都在购买GPU……获得GPU比获得毒品还难”。这也似乎从侧面证实了H100售卖的混乱。

不过至今任何一家媒体或都无法估算出具体能有多少H100或A100芯片通过这种方式流入中国。记者认为,尽管美国政府极力阻止美企的高精尖产品出口中国,但从英伟达战略规划中看出,目前中国蓬勃发展的AI市场已经成为英伟达难以放弃的优质市场。

黄仁勋曾对美国的相关禁令表示不满:“拜登政府对半导体技术实施的出口限制,使英伟达感到‘束手束脚’。英伟达无法在全球最大市场之一的中国开展业务。”为此,英伟达已经为中国市场推出“专供产品”H800与A800,它们能很好地规避美政府提出的不合理出口限制,尽管这两款GPU为100类型的阉割版本。

尽管在参数上,A800与H800难以与原版型号相提并论,但我们仍能看出英伟达对于中国市场的重视。换个角度看,如今H100与A100的种种“地下交易”,英伟达官方是不会出全力去限制的。

写在最后

AI浪潮中,中美纷纷抢购H100,以满足日益增长的AI算力需求,尤其是大模型建设,推动了H100的需求和价格上涨。但AI并不是中美两国的专利,海湾石油国家也积极参与AI领域竞争,试图在全新的信息革命中实现对中美的“弯道超车”。而H100作为针对服务器的GPU,性能和独特的生态系统使其难以替代,又恰逢美国对中国的芯片封锁,让更多的H100通过非常规渠道在全球流转。种种原因下,H100这颗 “得天独厚”的GPU,让厂商与整个销售链条上的掮客们收获了恐怖的1000%利润。

其实,说来说去,关键还是在于没人能够挑战英伟达的地位。如今AI时代到来,或许英伟达还将借着AI东风让本就高不可攀的生态壁垒更加难以挑战。但依旧是AI,这项技术仍旧赋予了其他厂商,甚至国家和地区实现“弯道超车”的能力。但就目前来说,英伟达短期在AI的地位无可替代。

本文来自微信公众号:与非网eefocus(ID:ee-focus),作者:刘浩然