扫码打开虎嗅APP

出品 | 虎嗅科技组

作者 | 齐健

编辑 | 廖影

头图 | 视觉中国

“AI芯片赛道会在年底再度爆发,芯片危机最快会在明年解决。”

早在半年前,就有很多AI和芯片业内人士对算力危机提出了乐观预期。业内普遍认为,以谷歌研发TPU芯片为例,各家重注投资AI大模型的公司一定都会投入AI芯片的赛道。

其最主要的原因就是,资本巨头们不会让英伟达长期独占市场。

诚如预期。最近两周,AI大模型的头部玩家相继放出了最新的芯片战略。先是亚马逊给OpenAI最强竞对Anthropic注资40亿美元,买断了他们在AI训练方面的“芯片选择权”;其后是微软AI芯片Athena被媒体曝出将在下月发布;最后则是这两天路透社的报道,称OpenAI正在评估潜在的芯片公司收购。

虽说OpenAI投资芯片研发在情理之中,但相对于其他重注AI大模型的巨头来说,OpenAI毕竟体量有限。如此迅速地杀入芯片研发赛道,会不会有些仓促?

事实上,OpenAI入局芯片也是逼不得已。一方面,芯片价格持续上涨,这也说明OpenAI正在被迫把自己辛苦研发AI赚到的钱,上供给英伟达。另一方面,GPU短缺的现状,也的确正在制约AI公司的发展。

OpenAI的CEO山姆奥特曼就曾在2023年中的一场闭门讨论中抱怨:GPU短缺的问题打乱了OpenAI的短期计划。

山姆奥特曼在这次会议中提到,OpenAI在GPT-4发布之初就计划把ChatGPT的上下文长度提升到32k token,但GPT-4上线很长一段时间,这一预期都没有实现,其根本原因就是OpenAI也面临着GPU短缺,以及算力太贵等问题。

不过,对于刚刚崛起的AI独角兽来说,研发AI芯片,除了是要反抗英伟达的“压榨”,投资芯片还隐含另一层原因,就是要努力花钱。

烫手的钞票

在大模型的资本狂欢中,AI公司账上的钱,越来越多。

OpenAI年初收获微软100亿美元注资;在亚马逊给Anthropic注资40亿美元之前,谷歌就已经给这家公司投资了数亿美元,在亚马逊之后,谷歌还有计划继续对该公司追加投资。国内AI大模型的明星公司智谱AI,近期也曝出了B-4轮融资的消息,目前估值或达10亿美金。

除了大量融资涌入,AI公司的技术升级也在给研发省下很多钱。

今年3月,OpenAI公布的API接入价格就出现了大幅下降,据OpenAI公布的数据,ChatGPT的推理运算成本,在3个月时间里下降了至少90%。

虽然半年过后的今天,OpenAI并没有公布推理和训练成本的下降最新情况。但可以预见的是,在不考虑算力芯片涨价的情况下,AI训练和推理的单位算力成本大概率是在持续下降的。

当然,在原有基础上AI公司肯定会扩大研发规模,但技术研发并不会无限扩张。如果算力成本能保持3个月“打一折”的下降速度,那么可以想见,OpenAI的很多研发预算,短期内都会闲置在账户里。

资金快进慢出,对于创业公司不是好事。

一方面会导致投资者对公司资金管理能力的疑虑,另一方面大量现金也有可能降低创业公司的投资回报率。

拿到巨额融资,本应是好事,但对于短期盈利预期并不明朗的AI公司来说,钱多了反而使这些公司的掌舵人开始发愁:这么多钱怎么花?

要全部投在模型训练上吗?这显然不合理。

首先所有技术的研发都是周期性的,不管一次融了多少钱,花钱都要按部就班地来。另外,现阶段AI大模型公司开销的大头主要是AI训练过程中产生的算力费用。但如果把钱全花在算力付费上,那这些钱就完全是研发开支。

但大模型研究其实有点像赌博,并不是说每次训练都能得到满意的结果。如果大模型研发效果好,那么巨大的算力开支还算说得过去。但如果反复训练,没有达到预期的效果,那这些为算力支付的费用就只能是试错成本。这也就使得AI公司在算力方面支付的钱,也变成了赌博,为算力付的钱,有多少是真的投资了未来,又有多少打了水漂呢?

然而,如果能在研发AI的同时,把这些钱花在算力芯片上,那就完全不一样了。

投资AI芯片,最直接的好处就是账面上好看,收购芯片研发公司,就可以把原本要烧在算力上的钱,沉淀成了资产。这不仅能增强自己的核心竞争力,还能给早期投资人和未来的投资人花钱的合理解释。一旦公司IPO,这些沉淀下来的资金,也可以帮助推高公司的估值。

芯片最适合AI公司烧钱

多数技术公司花钱的最好的办法都是买买买。但是买谁,也有讲究。

过去一段时间里,很多AI公司在“烧掉多余的钱”方面,都会选择收购业务相似的同行,或者是与自身业务强相关的上下游企业。国内很多财大气粗的AI公司,就已经收购了不少金融、制造等数字化转型服务公司,有的甚至还自己投资新建了不少相关公司。

不过,从过去二三十年,互联网、软件公司的发展来看,AI技术研发、数字化转型,这些偏重互联网、云和软件等业务的研发花销普遍不大,未必能达到把钱花好的目的。

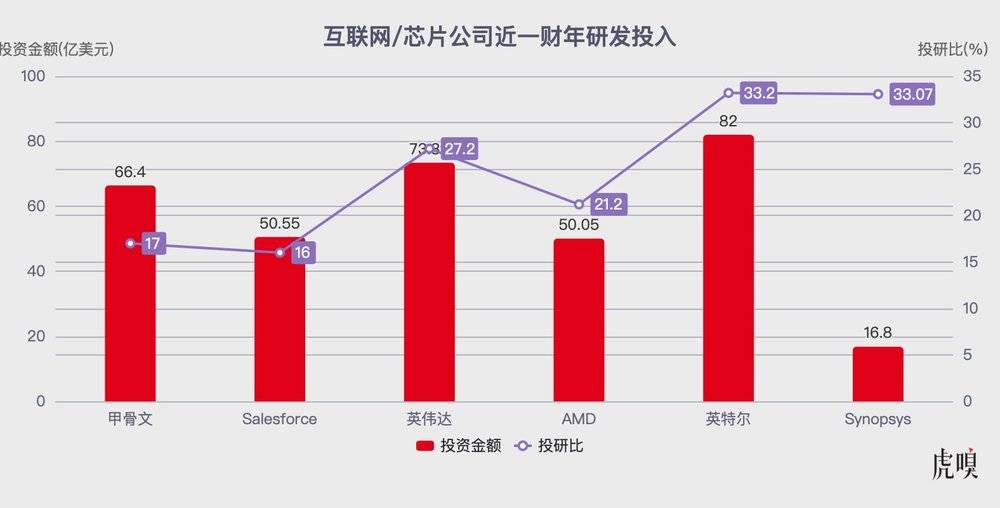

以美股头部公司为例。市值3012亿美元的甲骨文,2023财年的研发费用是66.4亿,占营收的17%。2018亿美元市值的Salesforce,2023财年的研发费用是50.55亿,投研比为16%。

相对来说,芯片研究要比软件贵得多。同类型的芯片公司,即使体量不大,研发费用也要高过这些软件公司。

最火的英伟达,2023财年研发成本73.39亿美元,占比27.2%,2022财年52.68亿美元,占比19.6%。虽然英伟达目前市值超万亿,但在2023财年中,英伟达股价的平均值还不到现在的一半。

其他的芯片公司,AMD的2022财年研发费用为50.05亿美元,占营收的21.2%;英特尔2023财年研发费用82亿美元,投研比33.2%;高通的2022财年研发费用81.94亿,投研比19%。

更有趣的是,给芯片行业做工具软件的EDA公司们的研发投入更大。主流EDA软件Synopsys上一财年的研发费用为16.8亿美元,投研比33.07%。过去几年中,这家公司的投研比也全部高于30%,有的年份甚至超过40%。

互联网/芯片公司近一财年研发投入

对于现阶段急需花钱的AI公司来说,AI芯片公司如此高的研发成本,算是很适合“烧钱”了。

AI公司能打破英伟达的壁垒吗?

AI公司做AI芯片,听起来很合理,但实际上并不容易。

目前市面上除了英伟达的GPU以外,还有很多公司在设计AI芯片。包括谷歌为TensorFlow设计的TPU (Tensor Processing Unit);华为正在研究的专为神经网络计算设计的NPU (Neural Processing Unit);以及传说被孙正义盯上的英国公司Graphcore开发的,专门用于AI任务的IPU。

这些芯片多数也都经历了很长时间的研发迭代,但商业表现和英伟达明显相去甚远。

其中,谷歌从2015年就开始研发TPU,并在内部推广使用。2018年,谷歌开放了TPU的第三方应用,作为其云基础设施的一部分。不过到目前为止,TPU仍没有大规模走入AI芯片市场。

事实上,即使TPU开放了商业化,目前主流的GPT模型要在TPU上运行,也会受到一定限制。因为GPT采用了与TensorFlow不同的PyTorch架构,虽然PyTorch中已经增加了对 TPU 的支持,但在运行过程中还需要一些额外的优化工作。

这也是困扰一众AI芯片的问题,多数AI芯片的硬件性能其实已与英伟达相差不远,但是底层软件和开发工具对应用的支持远不如英伟达。

不久前,科大讯飞总裁刘庆峰曾公开称赞华为的AI芯片性能,称其已经可以对标英伟达的高端显卡了。对此,很多业内人士其实并不感到奇怪,“显卡的裸金属性能要赶上英伟达,其实不难。”中科院自动化所主管刘昊告诉虎嗅,中科院自动化所的紫东太初大模型就一直与武汉智算中心合作,使用华为昇腾Ascend 910和910b训练AI大模型。

昇腾Ascend 910

刘昊认为,在性能方面华为的算力芯片确实与A100差不多,但在训练大模型的过程中却无法替代英伟达显卡。“虽然华为芯片的性能没有问题,但在实际的AI大模型训练中,它的工具链不够完善,裸金属的性能并不能完全发挥出来。”

英伟达的壁垒,并不是GPU硬件性能,而是基于CUDA的开发环境。虽然华为在这方面也在开发类似的CANN,但相对于已经推出超过15年的CUDA来说,差距还比较明显。

不过,这对于OpenAI、Anthropic这样的AI公司来说,正是可以发挥优势的部分。

AI公司可以在软件和硬件之间进行紧密的协同设计,确保芯片的设计完全满足算法的需求,从而提高效率和性能。同时,AI公司可以围绕其芯片产品建立完整的生态系统,包括软件库、工具、框架和支持服务,从而为客户提供一站式的解决方案。

除此之外,AI公司对机器学习和深度学习算法的理解更深入,这使得它们能够为特定的算法或任务定制和优化芯片。在实际应用中使用机器学习模型,它们可以根据实际的应用需求和场景,也可以对芯片设计进行反复迭代。

赚钱预期的分歧

过去9个月时间里,英伟达股价翻了3倍,市值突破一万亿美元。目前的市盈率TTM为102.03,静态市盈率为242.75。而Invesco半导体ETF的30家美国半导体公司平均市盈率为21倍,其他在AI上重投入的科技巨头们的市盈率都在20-40倍之间,英伟达的赚钱能力几乎强过他们10倍。

有消息称,2023年第二季度英伟达最先进的H100显卡出货量达800多吨,且持续供不应求。多位国内GPU服务器渠道商向虎嗅透露,一台百万多的GPU服务器,交货周期不同,价格上浮空间超过50%。

在今天,买GPU服务器的AI公司、云厂商,像极了国内奢饰品店门口排队买LV和GUCCI的人。在英伟达门口,攥着钱,排着队。好不容易交了钱,还要等货。如果再没有能打的竞争对手出现,英伟达的销售们没准也要开始让客户“配货”买GPU了。

不过,在这样赚钱的赛道里,资本对AI芯片的情绪其实比较复杂。毕竟AI芯片的赚钱周期太长了。大家都想像英伟达一样赚钱,但没几个人愿意经历芯片研发的漫长等待期。

由此,资本市场对AI芯片公司的态度也出现了分歧。在OpenAI要做芯片的传闻之前,国内AI芯片行业就有两则新闻值得关注。

首先是寒武纪近期发布公告称,国投基金减持完毕,基本清仓。而这已经不是寒武纪创投股东们首次出现清仓式减持。第二则是背靠腾讯的燧原科技宣布完成D轮融资20亿元。

作为AI芯片第一股,寒武纪遇到的最大问题,就是持续亏损,长期烧钱却落地缓慢。在AI芯片上直接烧钱的做法似乎不太适合中国公司,中国的AI公司和AI芯片公司,可能更适合Anthropic和亚马逊的合作模式。在AI芯片研发方面,多方协作,发挥自身特长。AI公司把AI推理、训练的应用需求用好,芯片公司把芯片设计技术用好,再配合大厂的技术、资金优势,从而加快产品的研发、迭代速度,从而在市场中占领一席之地。