扫码打开虎嗅APP

本文来自微信公众号:机器之能 (ID:almosthuman2017),作者:sia,题图来自:视觉中国

就在 OpenAI 陷入混乱的这几天,竞争对手们——无论是初创公司还是巨头——也没袖手旁观。除了用销售电话“轰炸”对方企业客户,自家基石模型或具体应用都有了重要进展。

直接竞争对手之一、也曾牵涉这起混乱的 Anthropic 刚刚为市场提供了一个新的替代方案——最新发布的 Claude 2.1 对公司旗舰大型语言模型做了三项重要更新。

其中,最引人瞩目的是 Claude 2.1 支持上下文窗口达 200K,Anthropic 表示这是一项复杂的壮举,也是行业首创。在此之前,OpenAI 在开发者日上公布的 GPT-4 上下文窗口为 128K。

200K 相当于大约 150,000 个单词,约 500 页的材料,这对于“整个代码库、财务报表(如 S-1 ),甚至是《伊利亚特》《奥德赛》等长篇文学作品来说已经足够了。”公司博客中写道。

Claude 聊天服务今年上线至今,已经有数百万用户使用它来翻译学术报告、起草商业文书或者分析复杂合约。许多用户在处理庞大文件时,希望能有更长的上下文窗口和更精确的输出,因此,Anthropic 决定进一步扩大窗口规模。

透过与大量内容或数据交谈,更新后的模型可以进行总结、执行问答、预测趋势、比较多个文档等。过去通常需要数小时人工才能完成的任务, 现在仅需几分钟,随着技术进步,预计延迟也将大幅降低。

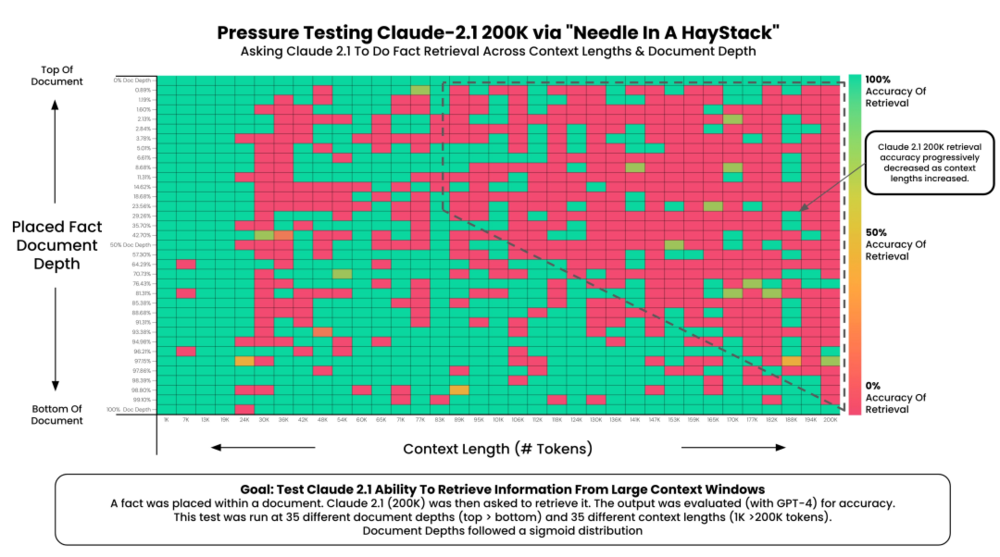

理论上,技术可以提供用户想要的任何上下文长度,但拥有更多信息并不一定意味着模型也能很好地处理它。网友 @Greg Kamradt 对 Claude 2.1 上下文记忆进行了压力测试,有一些重要发现:

网友 Greg Kamradt 对 Claude 2.1 的 200k Token 上下文记忆能力进行了压力测试,并获得了一些重要发现。

比如,非常靠近文档开始、结尾位置事实记忆的准确率几乎 100%,但难以记住和推理中间部分信息。靠近开头部分事实的记忆表现不如对尾部事实的记忆(类似 GPT-4)。

另外,上下文越少,准确性越高。输入超过 90K Token 的上下文长度,记忆能力会逐渐变差。不过,就大多数日常应用来说,32K、64K 上下文窗口长度已经足够。

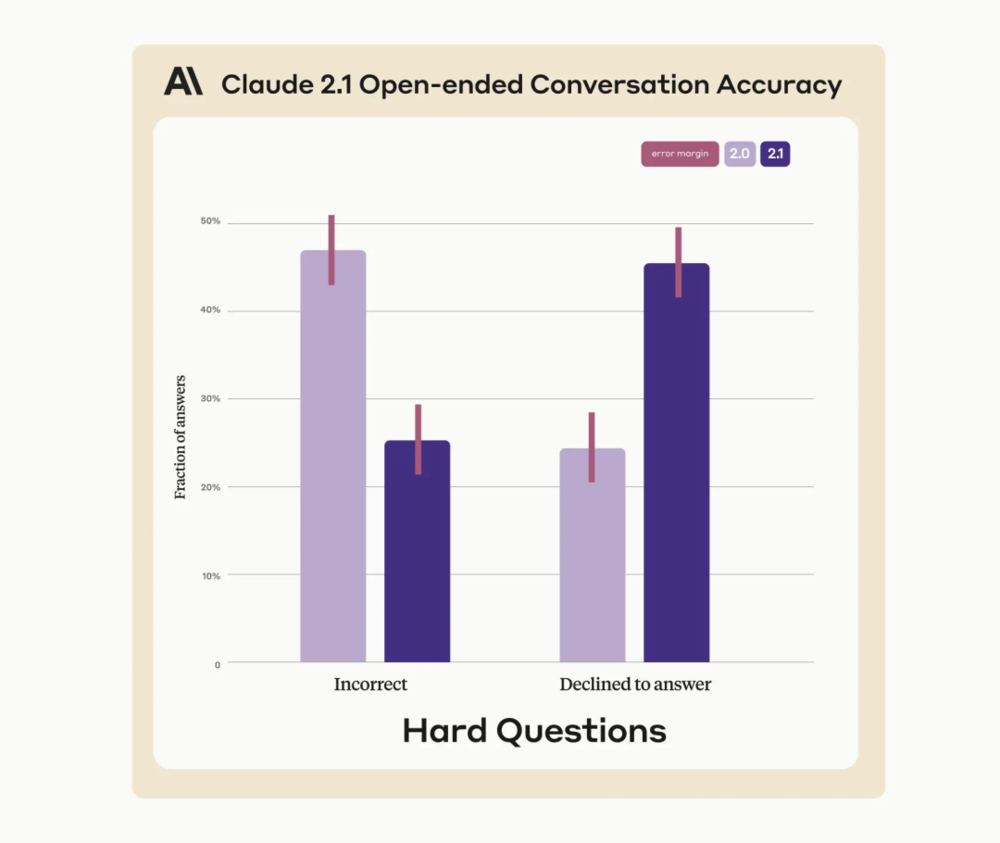

Claude 2.1 另一个令人印象深刻的更新就是改善了对内容的理解和摘要水平。公司称,“幻觉率降低 2 倍”——与 Claude 2.0 模型相比,虚假陈述减少了 2 倍。

他们利用一些已知的弱点问题来考验新模型,比如“大量复杂的、事实性的问题”。他们发现,该模型“明显更有可能提出异议,而不是提供错误信息。”

也就是说,更有可能做出表示不确定的回答,比如“我不确定玻利维亚第五大人口城市是什么”,而不是直接给到错误答案,例如“玻利维亚人口第五多的城市是蒙特罗。”

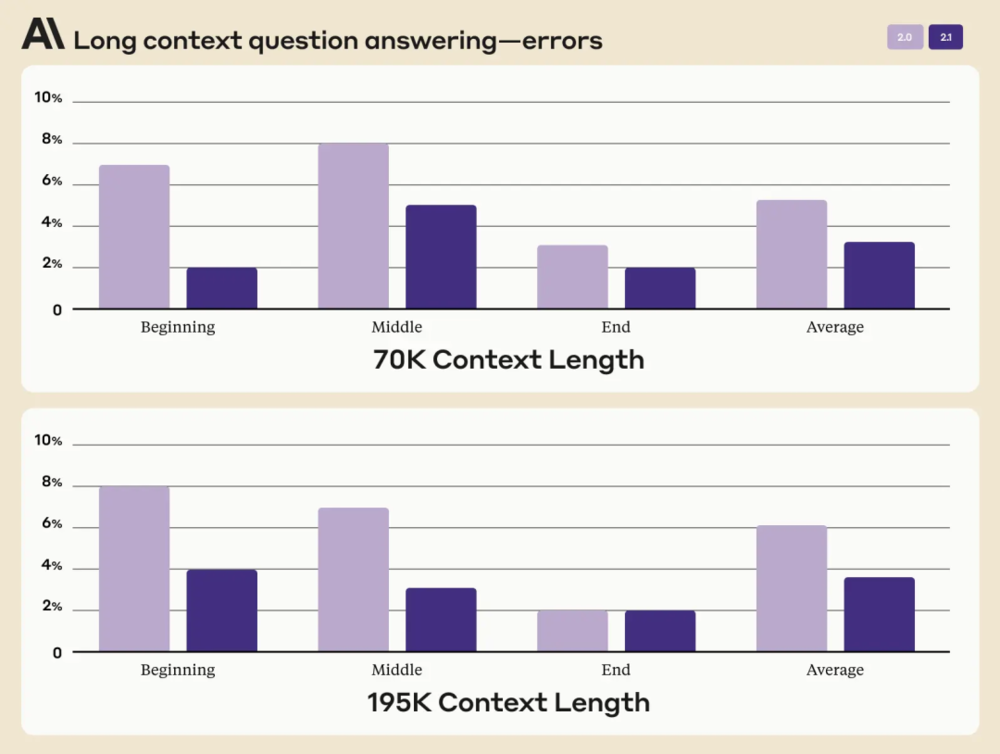

另外,该模型在理解和总结方面也做了重要改进,特别是法律文件、财报以及技术说明等需要高准确度内容的文档,错误答案比例减少了 30%,将支持性的特定声明文件进行错误推论的情况减少了 3-4 倍。

第三,Claude 2.1 通过整合特定的工具(类似 Agent)来弥补模型不足。用户可以自定义一组工具供 Claude 调用,根据任务自动执行操作。比如,如果发现解决某个问题需要使用计算工具或者调用某个 API,模型就会自动调用。

另外,新模型还提供了常见的系统提示,在用户输入提示之前,先设定模型的系统提示,比如告诉其扮演特定角色,以更加一致的方式来回答问题。

Anthropic 的模型可能并不总是与 OpenAI 的模型旗鼓相当,但这个行业发展很快,竞争也非常激烈,另一个例子就是对话式聊天机器人 Pi 背后的初创公司 Inflection AI 刚刚完成新的 AI 模型 Inflection-2 的训练。

Inflection-2 比 Inflection-1 的能力要强得多,主要体现在事实知识的显著改进、更好的风格控制以及推理能力的提升。

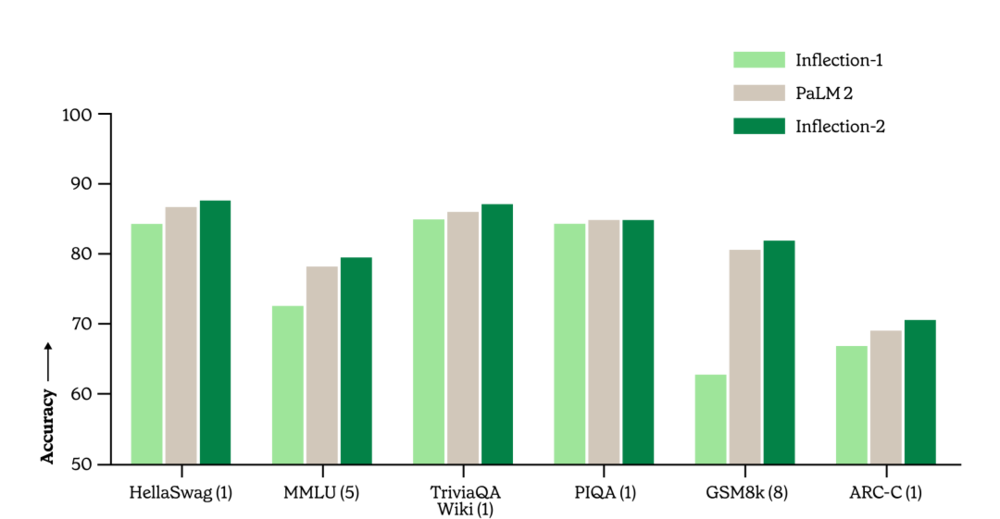

和竞品相比,Inflection-2 的表现优于 LLaMA 2 的最大 700 亿参数版本、Elon Musk 的 xAI 初创公司 Grok-1、谷歌的 PaLM 2 Large 和 Anthropic 的 Claude 2。

公司 CEO Mustafa Suleyman ( 也是 Google DeepMind 联合创始人兼前任负责人)声称, Inflection-2 的规模可以被认为是同类产品中最好的——“非常非常接近”GPT-4。从今天开始,Inflection 正在将其培训重点转移到下一个模型上,他预测,该模型将在六个月内达到其前身的 10 倍,再过六个月将达到 10 倍。

Inflection-1、Google PaLM 2-Large 和 Inflection-2 在一系列常用学术基准中的比较。

Suleyman 表示,更新后的模型将很快集成到 Inflection 5 月发布的聊天机器人 Pi 中。在此之前,还需要更多的“对齐”,调教 Pi 的语气和回答风格,还要降低模型幻觉。

Suleyman 本人此前曾直言不讳地谈论人工智能安全,在 7 月作为拜登政府召集的七家 AI 公司之一签署了 AI 风险管理的自愿承诺书。他还发誓,要 Pi 远离回答与选举有关的问题和为政治竞选活动制作材料。他最近出版了一本书,其中详细介绍了人工智能的风险,名为“即将到来的浪潮(The Coming Wave)”。

事实上,Suleyman 与 IIya Sutskever 有过交集,后者曾作为 DeepMind 的承包商和顾问为其工作。“我非常尊重他,不仅仅是在技术上,而且他非常有原则,非常真诚。我认为他和团队其他成员的意图是真诚的。”Suleyman 在接受福布斯采访时谈到了对这次 OpenAI 地震的一些看法。

除了两大创业公司基石模型的重要更新,巨头在应用层面也有新的动作。

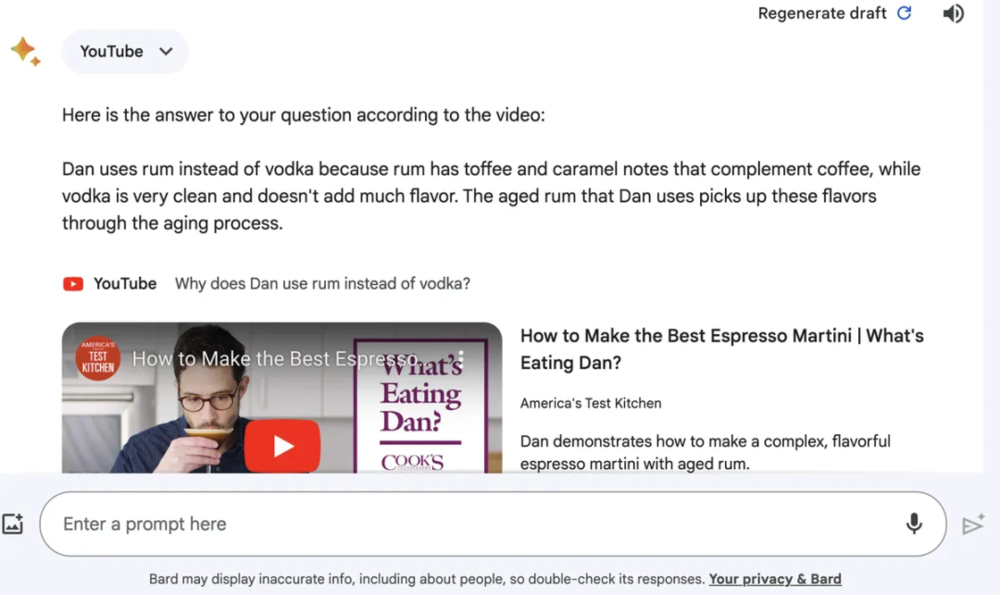

谷歌 Bard 正在为用户提供视频解读功能。

从昨天开始, 测试用户可以通过提问Bard,大致了解 YouTube 视频内容。

举个例子。有烹饪经验的人都知道熟记食物配方、每种配方的量和比例有多么头疼和复杂。6 寸戚风蛋糕到底要多少个鸡蛋?多少克糖?一杯浓缩咖啡马天尼要加多少本尼迪克特酒?

现在有了Bard 的帮助,用户只用输入一些提示,就会得到一份完整的浓缩咖啡马天尼成分清单以及操作步骤,省去来回拖曳视频寻找关键信息的麻烦。

Bard可以总结视频中的关键点,并准确回答浓缩咖啡马天尼的配方。

在总结这段视频时,Bard 涵盖了所有关键部分,比如配料和用量都是准确的,操作说明也是正确的,甚至准确提醒你第一步要用带有冰块的水冷却马提尼杯。

唯一不太准确的是,它告诉你应该摇晃饮料 30 秒——但视频绝对没有演示或建议你摇晃这么长时间。另外,想要获得完整配方,单靠 Bard 生成是不行的,需要你在提示中明确要求“步骤说明”时才会间接获得。

Google Bard 虽然在很多方面可能不如 ChatGPT,但它正在变得越来越有用。同时,另一个热度不亚于 OpenAI GPT-4 的竞争对手 Grok ,马斯克称,也将于下周向 X Premium+ 订阅者推出。

虽然马斯克关于产品交付时间框架的声明并不总是有效,但 X 应用程序的代码开发表明 Grok 集成已经在进行中。

本周,应用程序研究员 Nima Owji 分享了屏幕截图,显示了如何将 Grok 添加到 X 的网络应用程序中,并指出其 URL 为 twitter.com/i/grok。

一张截图展示了一个“Ask Grok”文本输入框,用于与聊天机器人对话。

另一张屏幕截图中,尚未成为 Premium+ 订阅者的用户将被邀请升级以获得对 Grok 的访问权限。

参考链接

https://www.anthropic.com/index/claude-2-1

https://inflection.ai/inflection-2

https://www.theverge.com/2023/11/22/23972636/bard-youtube-extension-update-search-video-content

本文来自微信公众号:机器之能 (ID:almosthuman2017),作者:sia