扫码打开虎嗅APP

本文来自微信公众号:极客公园(ID:geekpark),作者:美漪,题图来自:视觉中国

OpenAI 的权力之争才刚刚落幕,一场关键交易悄悄浮出了水面。

据外媒《连线》(Wired)报道,在 Sam Altman 担任 OpenAI 的首席执行官期间,OpenAI 与 Rain AI 签订了一份价值 5100 万美元的意向书,承诺会在 Rain AI 的芯片上市后购买芯片。

Rain AI 是一家 AI 芯片初创公司,旨在大幅降低 AI 算力的成本。通过研发一种模仿人脑的工作方式的 AI 芯片——NPU,从而为 OpenAI 和 Anthropic 等 AI 公司提供“低成本、高能效的硬件”。

该公司称,“相比传统的 GPU,NPU 将为 AI 开发者(如 OpenAI)提供潜在的 100 倍计算能力,并在训练方面提供 10000 倍的能效。”

鉴于,OpenAI 一直受困于算力短缺,也就不难理解,它会愿意花费大量资金,来确保自己的 AI 项目所需的芯片供应。

Rain AI 研发的芯片有什么特点呢?该公司又是如何显露头角的?这笔投资揭示了 Altman 和 OpenAI 在芯片领域怎样的布局?

“类脑”AI 芯片

Rain AI 的核心产品是基于神经拟态(Neuromorphic)技术的“类脑”AI 芯片——NPU。芯片旨在实现低耗、高效地处理信息,从而满足 AI 任务的苛刻计算需求。

它模仿了人脑的结构和功能,类似于大脑中的神经连接,建立在了人工突触相互连接的网络上。这种架构允许 NPU 以并行和分布式的方式处理信息,使其非常适合 AI 应用中的“计算密集型任务”。

而且,Rain AI 率先采用了数字内存计算(D-IMC)模式,进一步提升了 AI 处理、数据移动和数据存储的效率。

Rain AI 的 NPU 旨在以低功耗高效处理信息,满足 AI 任务的苛刻计算需求 | 图片来源:Rain AI 官网

此外,Rain 还为数字内存计算磁贴和软件栈,提供了知识产权(IP)许可机会,该 IP 是专门为要求超低延迟和高能效的设备上的 AI 工作负载而定制的,涵盖了长距离以太网(Long Reach Ethernet, LRE)的一系列计算用例,包括智能汽车、智能手表等。

针对自家产品,Rain 打出的 solgan 是“重新定义 AI 计算的极限”,并宣传“我们的 AI 加速器在速度、功耗、面积、精度和成本之间实现了创纪录的平衡”。

鉴于,Rain 所设计的“类脑”芯片(NPU)承诺具有高效和低耗的运行,这对于克服英伟达、AMD 等公司制造的重型芯片相关的“瓶颈”至关重要。

涵盖了 LRE 一系列计算用例 | 图片来源:Rain AI 官网

Rain AI 的创始者之一,Gordon Wilson 更是在 LinkedIn 上直言,“NPU 芯片将定义新的 AI 芯片市场,并大幅颠覆现有市场。”

不过,值得注意的是,尽管 Rain AI 号称自己相比于英伟达的 GPU 有更好的能效,但 Rain 的初始芯片,其实是基于谷歌、高通和其他科技公司支持的传统的 RISC-V 开源架构,旨在用于远离数据中心的所谓边缘设备,如手机、无人机、汽车和机器人等。

但是,当前的大多数边缘芯片设计,如智能手机采用的芯片,都专注于神经网络的推理阶段。而 Rain 的目标是提供一种芯片,既能用于模型和算法的训练,又能用于之后的推理运行。

目前,Rain AI 已经推出首个 AI 平台,可进行 AI 推理和训练,还宣称“类脑”芯片(NPU)将允许 AI 模型根据周围环境实时定制或微调。

对此,Sam Altman 还曾公开表示,“这种神经拟态方法能大幅降低 AI 开发成本,并有望为实现真正的 AGI 提供帮助。”

据悉,OpenAI 希望利用这些芯片来降低数据中心的成本,并将自己的模型部署在手机和手表等设备中,那么“类脑”芯片(NPU)无疑对 OpenAI 来说有着巨大的吸引力,

尽管如此,这些也都只是猜测。目前,OpenAI 将如何使用这些芯片还是不得而知。

与 OpenAI 联系紧密

Rain AI 成立于 2017 年,旨在为未来的 AI 构建“低成本”的计算平台。

Rain AI 有三位联合创始人,分别是 Jack Kendall、Gordon Wilson、Juan Claudio Nino,他们在佛罗里达大学结识,此外,还聘请了 OpenAI 的软件工程师 Scott Gray 担任公司顾问。

目前,Rain AI 约有 40 名员工,包括 AI 算法开发和传统芯片设计方面的专家。

Rain AI 的创始人团队|Rain AI

有趣的是,Rain AI 的总部也位于旧金山,与 OpenAI 相距不到一英里。

公司成立的次年,Rain AI 就在种子轮融资中,获得了 500 万美元的融资,投资者包括知名的创业孵化器 Y Combinator。

彼时,Altman 正在担任 Y Combinator 的 CEO,同时还以个人名义向 Rain AI 投资了 100 万美元。一年后,OpenAI 通过了这份价值 5100 万美元的芯片购买协约。

截至 2022 年 4 月,经历了由沙特阿拉伯附属基金 Prosperity7 Ventures 领投的价值 2500 万美元的一轮融资,Rain 的总融资额达到 3300 万美元,估值也达到了 9000 万美元。

今年年初,该公司向潜在投资者“夸炫”其进展,表示预计本月就可以推出“测试”芯片,这将意味着芯片设计已经完成,可以开始制造。

Rain AI 还表示最早于明年 10 月可向客户提供第一批芯片,甚至向投资者强调,自己已经与谷歌、甲骨文、Meta、微软和亚马逊等科技巨头进行了高级谈判,以销售系统给它们。但对此,微软拒绝置评,其他公司没有回应置评请求。

简而言之,Rain AI 仍处于开发阶段,目前尚不清楚何时才能投入商用。尽管该公司的“类脑”芯片(NPU)技术前景广阔,支持者也备受瞩目,但它仍面临着许多挑战。

OpenAI 的野心

不管 Altman 投资 Rain AI 这番举动有没有私心在里头,芯片短缺确实是 OpenAI 面临的一大难题。

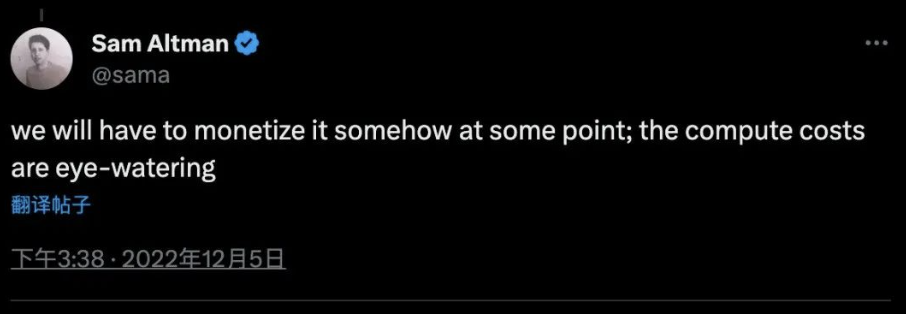

事实上,一年前,ChatGPT 刚刚发布不到一周,Altman 就感觉到计算成本“惨不忍睹”。之后,更是不止一次公开抱怨 AI 芯片的“残酷紧缺”和“令人瞠目”的成本。

今年 5 月份,Altman 更是无奈承认,“OpenAI 正在经历严重的算力短缺,许多短期计划都推迟了。”

众所周知,OpenAI 利用其主要投资者微软的强大云服务,但由于硬件限制,经常关闭 ChatGPT 的某些功能。

对此,Altman 表示,“AI 的进展速度可能取决于新的芯片设计和供应链。”毕竟在当下,算力就是一切。

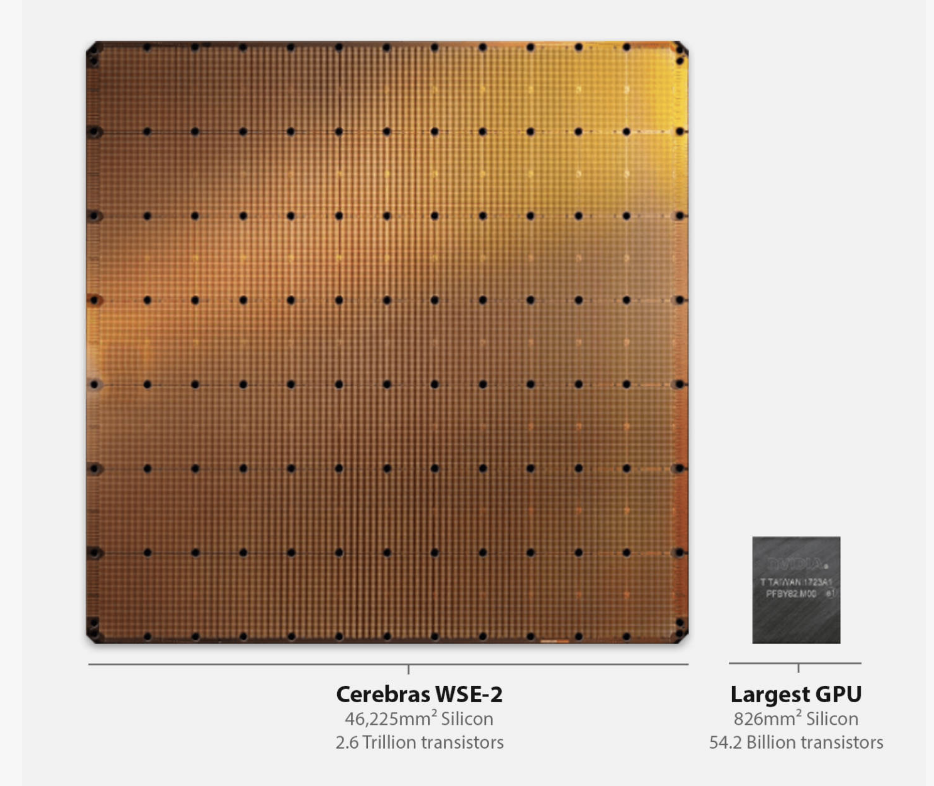

事实上,Altman 本人很早之前就对芯片进行了投资布局。除了 Rain AI,2021 年前后他还参与投资了 Cerabras,就是芯片像盘子一样大,需要两只手捧着的那家 AI 公司。

像盘子一样大的芯片 | 图片来源:Cerabras 官网

今年初“硅仙人”Jim Keller 与“硅神童”Sam Zeloof 成立的 Atomic Semi(通过简化和缩小半导体工厂和集成电路原型,快速制造价格合理的芯片),Altman 也有关注,OpenAI Startup Fund 还参与了投资。

此外,就在 Altman 被 OpenAI 解雇的前几周,还有消息称他正在试图筹集数十亿美元,创办一个新的芯片公司。

项目的详情还不得而知,只知道代号为“Tigris”,旨在与英伟达在 AI 芯片领域展开竞争。

据悉,为了“Tigris”项目,Altman 曾在中东筹集资金。地点的“巧合”,不禁让人怀疑这个项目和 Rain AI 是否有什么关联。

另外,Altman 还曾与包括芯片设计公司 Arm 在内的半导体高管进行过讨论,商讨如何尽早设计出新的芯片,为 OpenAI 这样的大语言模型公司降低成本。

而且,不止 Altman,OpenAI 也正在寻找更低成本造大模型的可能,从而摆脱对英伟达的依赖。

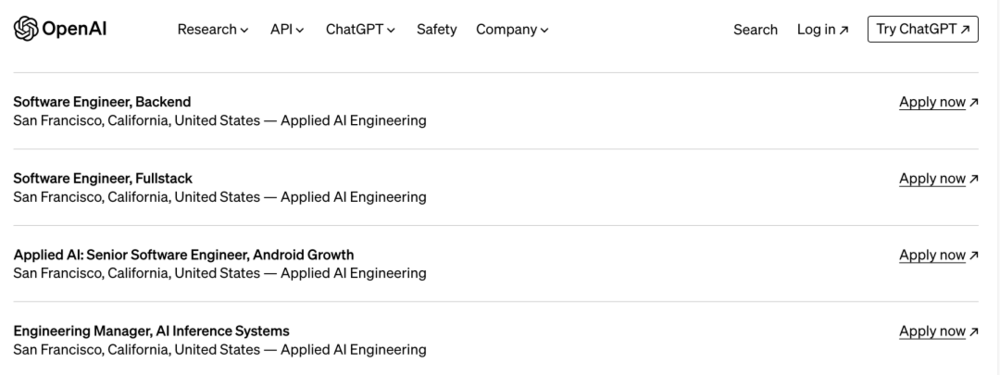

除了寻找像 Rain AI 这样的芯片供应商,对外投资之外,OpenAI 前段时间也开始尝试自研芯片,评估潜在收购目标,并招聘硬件相关岗位。

图片来源:OpenAI 官网

前不久,OpenAI 任命了前谷歌 TPU 的负责人,Richard Ho 为硬件主管,还聘请了不少编译器和内核方面的专家,并且正在招聘“数据中心设施设计专家”。

Richard Ho 将领导 OpenAI 的新部门,并且帮助优化合作伙伴的,数据中心网络、机架和建筑。

但这些前瞻性的投资布局,还是很难解决眼前的 GPU 短缺的问题,目前,OpenAI 大规模使用的还是英伟达的芯片。

据观察,OpenAI 正在动态的调整 ChatGPT 等产品的能力来节省算力。这也就不难理解,有网友最近发现 GPT-4 相比 GPT-3.5 更容易“偷懒”。

随着大模型的出现,人们开始关注大型 AI 模型数据中心的耗电情况。Rain 和其他一些芯片初创公司,旨在重新配置数据处理方式,从而减少传输需求,降低功耗。

谷歌、微软、AMD、英特尔、亚马逊,以及 Cerabras、Sambanova,Rain 等初创公司相继入局 AI 芯片未来,AI 算力供应的市场是否会有所变化?而 OpenAI 能否摆脱算力受制于人的局面?从芯片超长的周期来看,这些难题还将继续存在相当长的一段时间。

本文来自微信公众号:极客公园(ID:geekpark),作者:美漪