扫码打开虎嗅APP

本文来自微信公众号:Nature Portfolio (ID:nature-portfolio),作者:Davide Castelvecchi,原文标题:《机器学习与量子计算,全明星阵容能否讲出一个好故事?|《自然》长文》,题图来自:视觉中国

请叫它未来主义计算的“复仇者联盟”。将科技领域最火的两个词合起来——机器学习和量子计算机——“量子机器学习”便就此诞生。就和《复仇者联盟》漫画和电影一样,超级英雄的全明星阵容注定夺人眼球。但科技和虚构的故事一样,离不开好的情节。

谷歌正在研究量子计算机是否能促进机器学习技术。来源:Rocco Ceselin for Nature

如果量子计算机能大规模建造,它们就能比普通数字化电子产品更快地解决某些问题,因为它们能利用亚原子世界的独特性质。多年来,研究人员一直在思考这些问题是否也包括机器学习。机器学习这种人工智能(AI)技术使用计算机发现数据模式,学习规律,从而能在陌生场景中做出推断。

家喻户晓的AI系统ChatGPT就是利用机器学习推断文本中字词间的关系,从而生成“人类般”的对话。量子计算机的规模和算力也在迅速扩容,随着这两项技术的突飞猛进,两者结合会产生怎样的效果呢?

高歌猛进

许多科技公司,包括谷歌和IBM这种大公司以及加州Rigetti和马里兰州IonQ这类初创公司,都在为量子机器学习的潜力下注。学术界对此也热情高涨。

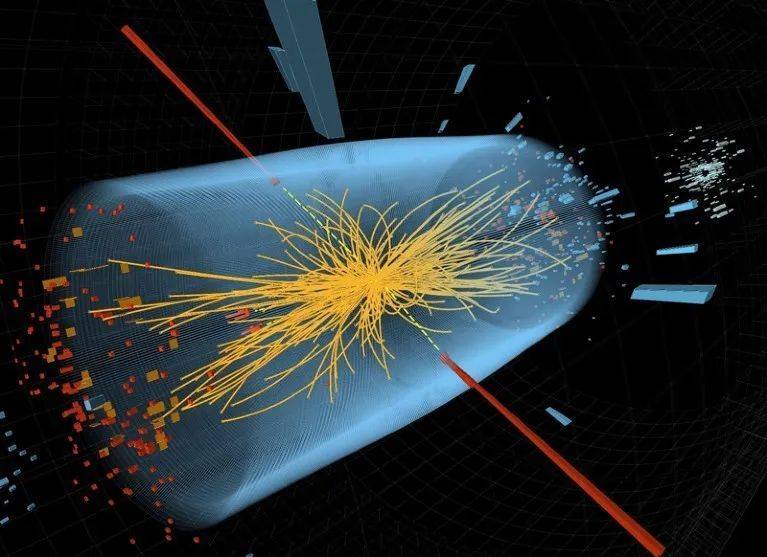

瑞士日内瓦近郊的欧洲粒子物理学实验室CERN,已经在用机器学习从大型强子对撞机产生的数据中寻找特定亚原子粒子产生的迹象。那里的科学家是正在实验量子机器学习技术的科学家之一。

CERN负责领导量子计算和机器学习研究组的物理学家Sofia Vallecorsa说:“我们想用量子计算机给经典机器学习模型提速或进行改进。”

这里的一个重要问题是,是否存在量子机器学习比经典版本更有优越性的具体场景。理论显示,对于特定的计算任务,如模拟分子或寻找大整数的质因数,量子计算机能加快运算速度,不然运算时间可能会比宇宙存在的时间更久。但研究人员仍然缺少充足证据证明机器学习也符合这种情况。其他人则认为,即使量子机器学习的速度不见得更快,但它可以发现经典计算机发现不了的模式。

研究人员对量子机器学习的态度处于两个极端,就职于加拿大量子计算公司Xanadu的南非物理学家Maria Schuld说,大家对这项技术很感兴趣,但似乎因为看不到短期前景而纷纷后撤。

一些研究人员转而关注在本质上属于量子的现象中应用量子机器学习算法。在目前提出的量子机器学习的所有可能应用中,这是量子优势最明显的领域,麻省理工物理学家Aram Harrow表示。

量子算法有用吗?

过去20年里,量子计算研究员开发了很多量子算法,这些算法理论上有望提升机器学习的效率。在2008年公布的一个重要结果中,Harrow和麻省理工的物理学家Seth Lloyd以及Avinatan Hassidim(现就职于以色列巴伊兰大学)发明了一种量子算法[1],这种算法求解很大的线性方程组的速度比经典计算机提升了指数级,这正是机器学习要解决的核心挑战之一。

但在某些方面,量子算法的承诺并未兑现。一个著名事件是:计算机科学家Ewin Tang在2018年提出的一种方法,打败了2016年设计的一个量子机器学习算法[2]。这个量子算法的最初设计目标是让Netflix这类网络购物公司和服务能基于用户既往选择做出相关推荐,并且其推荐速度较当时任何已知的经典算法有了指数级提速。

当时只有18岁的Tang还在得克萨斯大学奥斯汀分校读本科,她写了一个速度差不多的算法,但用普通计算机就能运行。量子推荐是算法在实际问题上显著提速的一个罕见特例,所以她的算法让实际的机器学习问题实现指数级量子提速的目标比以往更触不可及,Tang的导师、量子计算研究员Scott Aaronson说道。目前在加州大学伯克利分校的Tang表示,她仍然对任何声称机器学习能实现大幅量子提速的说法深表怀疑。

一个更大的问题是,经典数据和量子计算有时候并不兼容。大致而言,量子计算的经典应用主要有三步。第一步是量子计算机的初始化,也就是其单个存储单元,即量子比特(qubit)处于集体纠缠量子态。第二步是量子计算机执行一连串运算,也就是对经典比特进行逻辑运算的量子版本。第三步需要量子计算机进行读出,比如测量携带量子运算结果信息的单个量子比特的状态。这可以是计算机内的某个电子是顺时针自旋还是逆时针自旋。

吸管最细处

Harrow写的这类算法承诺在第二步实现提速,也就是量子运算。但在许多应用中,第一步和第三步有时候会非常慢,抵消这种提速[3]。初始化的步骤要求在量子计算机上加载“经典”数据,并转换成量子态,这个过程常常很慢。而且由于量子物理学本身具有概率性,所以读出往往有随机的成分,这会让量子计算机需要多次重复这三个步骤,并对结果取平均值,才能得到最终答案。

华盛顿大学量子计算研究员Nathan Wiebe说,量子化数据经过处理进入最终量子态后,得到答案可能还要很久。Wiebe在去年10月的一个量子机器学习工作组上说:“我们只能从吸管最细的部分把信息吸出来。”

“不管你问哪个研究人员量子计算机的优势在哪里,回答基本上都是‘应该不是经典数据’,”Schuld说,“现在看来,没有什么理由让我们相信经典数据真的需要量子效应。”

Vallecorsa和其他人认为,速度不应该是评价量子算法的唯一标准。有迹象表明,机器学习驱动的量子AI系统可以学会识别经典计算机容易漏掉的数据模式。这可能是因为量子纠缠能让量子比特和数据点之间建立关联,德国电子同步加速器(DESY)粒子物理学实验室的物理学家Karl Jansen说,“我们希望能发现经典算法很难在数据中发现的关联。”

量子机器学习或能帮助解释CERN的粒子对撞。CERN是位于瑞士日内瓦近郊的欧洲粒子物理学实验室。来源:CERN/CMS Collaboration; Thomas McCauley, Lucas Taylor (CC BY 4.0)

但Aaronson并不认同。量子计算机遵循众所周知的物理学法则,因此它们的工作方式和量子算法的结果都可以用经典计算机预测——只要给足时间。Aaronson说:“所以唯一的问题在于,量子计算机是否能比完美的经典模拟更快。”

根本量子变革

另一种可能性是:对已经量子化的数据使用量子机器学习算法,完全绕开转换经典数据的障碍。

回顾量子物理学的发展,对量子现象的测量被定义为用存在于宏观、经典世界中的工具读取数值。但一种新出现的观点使用名为“量子传感”(quantum sensing)的新技术,这种技术使用纯量子工具测量某个系统的量子特性。将这些量子态直接加载到一台量子计算机的量子比特上,量子机器学习或许就能在不接入经典系统的情况下发现模式。

对于机器学习来说,这么做的优势可能超过了以经典数据点的形式采集量子测量数据的系统,麻省理工物理学家、谷歌研究员Hsin-Yuan Huang说,“我们的世界本质上符合量子力学。如果你想要一台会学习的量子计算机,它能变得更强大。”

Huang和他的合作者用谷歌的一台Sycamore量子计算机运行过一个原理验证实验[4]。他们用计算机的部分量子比特模拟一种抽象物质的行为,用计算机的另一部分从这些量子比特中采集信息,并用量子机器学习进行分析。研究团队发现,这种技术较经典测量和数据分析能有指数级提速。

是超导体吗?

“完全在量子世界中收集和分析数据,或能让物理学家解决经典测量只能间接回答的问题。”Huang说。其中一个问题是特定材料是否处于能成为超导体的特定量子态——超导体能零电阻传输电力。而经典实验要求物理学家间接证明超导性,比如通过测试这种材料对磁场的反应。

Jensen说,粒子物理学家还在尝试用量子传感处理未来粒子对撞机产生的数据,比如DESY让电子和光子对撞的LUXE实验,不过这种想法距离实现至少仍有十年时间。相距遥远的天文台也可以用量子传感器采集和传输数据,这需要用到未来“量子互联网”技术,将数据传输到中央实验室的量子计算机上处理。这么做希望能捕捉到清晰度无与伦比的影像。

如果这种量子传感的应用能成功,就能用量子机器学习综合这些实验的测量数据并分析最后得到的量子数据。

归根结底,量子计算机是否能为机器学习带来优势,要由实验决定,而不是看这种优越性是否有数学证据。Harrow说:“我们不能期望用做理论计算机科学的方式来证明一切。”

Aaronson说:“我绝对相信量子机器学习是值得研究的。” 无论最后是否能提速。Schuld也认同,“我们需要在没有提速要求的限制下做研究,至少暂时不要有这个要求。”

参考文献:

1.Harrow, A. W., Hassidim, A. & Lloyd, S. Phys. Rev. Lett. 103, 150502 (2009).

2.Tang, E. in Proc. 51st Annu. ACM SIGACT Symp. Theory Comput. (eds Charikar, M. & Cohen, E.) 217–228 (ACM, 2019).

3.Biamonte, J. et al. Nature 549, 195–202 (2017).

4.Huang, H.-Y. et al. Science 376, 1182–1186 (2022).

原文以The AI–quantum computing mash-up: will it revolutionize science?标题发表在2023年1月2日《自然》的新闻特写版块上 © nature doi:10.1038/d41586-023-04007-0

本文来自微信公众号:Nature Portfolio (ID:nature-portfolio),作者:Davide Castelvecchi