扫码打开虎嗅APP

本文来自微信公众号:酷玩实验室(ID:coollabs),作者:酷玩实验室,头图来自:视觉中国

据说,很多人小时候都幻想过这样的场景:

全中国14亿人,每人给我一块钱,我就能成为亿万富翁。

长大之后,我们读书工作、成家立业,生活按部就班,大富翁的梦想画上句号,人生更像是游戏世界的NPC,主打一个“不努力、不造反、热情开朗、一问三不知”。

当碳基生物组成了世界这个巨大的草台班子,硅基生物却开始——独立思考了!

是的,在ChatGPT狂飙一年之后,AI已经可以主动学习、思考、判断,并自主完成任务了。

这种像贾维斯一样的AI智能体,也叫AI Agent。

一年前,ChatGPT横空出世,有一大批人工智能专家出来呼吁,收手吧,阿祖,再这么开发下去,AI就强大到人类无法控制了。

而AI Agent,就是那个令人类“颤抖”的AI智能体。

一、什么是AI Agent?

2023年上半年,斯坦福大学人工智能实验室(SAIL)和谷歌联合发表了一篇论文《Generative Agents: Interactive Simulacra of Human Behavior》。

在文章中,研究人员创造了一个虚拟小镇“Smallville”,里面有商场、公园、酒吧、学校、咖啡馆等建筑,还有25位完全由 AI 控制的居民。

每位AI居民都有自己独特的身份和个性,它们在小镇里生活、工作,可以一起聊天、谈八卦,也可以办Party、交朋友,甚至还拥有记忆,会根据自己见过的人、说过的话,做出判断和决策。

具体来说,它们看到早餐起火,会走过去关掉炉子;如果看到卫生间有人,知道在外面等待;街头看到一个人,还会停下来聊两句……

而这一切行为,不是系统设置的,而是AI居民根据具体问题做出的具体反应。

虽然这个研究目前没有开源,咱们并不清楚AI居民是如何做出具体响应的,但试想一下,你在路上碰到一个认识的人,大概会出现四种情况:

A:不喜欢,假装没看到

B:不熟,点头打招呼

C:有点熟,聊两句天气如何,今天吃什么

D:熟悉,聊聊各自生活,甚至还会一起约饭

而AI居民的反应,就像人类思考一样,结合了两个个体之间的“交往历史”,做出了相应的决策。

这里的AI居民,具有语言、决策、记忆的综合功能,能够通过独立的思考完成接受的任务,也就是最近风光无限的AI Agent。

通俗来说,AI Agent就是AI助理。

在大模型时代,AI只能和你聊天,谈心,帮你查资料、写文章、写代码、搞创作,而且要想让AI输出你想要的结果,关键在于“提示词”,即你得学会引导AI,才能让它给出理想答案。

如果提示词给得不好,AI就会答非所问,宛如一个智障。

而在AI Agent时代,你只要说出结果,它会帮你理清过程,并下达指令。

打个比方,你正在打游戏,突然感觉饿了。这个时候,AI可能会告诉你喝点水缓解饥饿,或者建议你尽快吃饭,以免头晕、乏力;但AI Agent则可能会调取你的外卖App,分析你爱吃的菜系,还能调用支付app,直接帮你点个外卖到家。

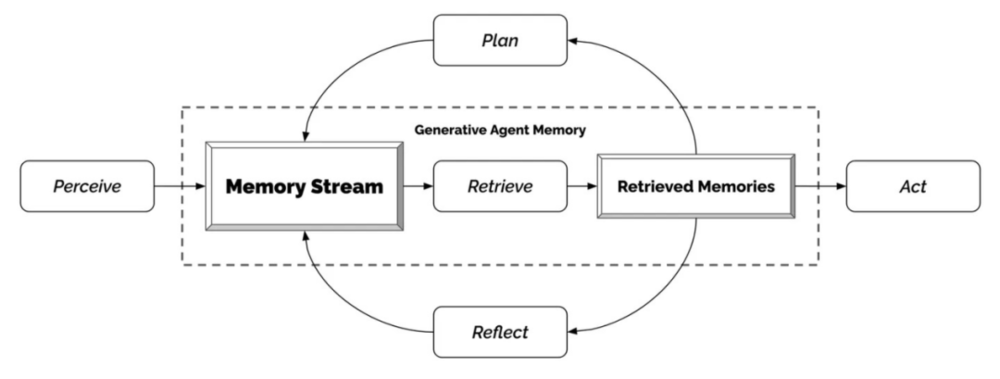

在这个过程中,AI Agent经历了“感知(Perception)——规划(Planning)——行动(Action)”三个步骤。

感知,就是收集信息并提取相关信息。

当AI Agent接收到你说“饿了”,它会首先从一堆“饱汉不知饿汉饥”“Stay hungry,Stay foolish”等与饿了相关的信息中,提取出饿了应该怎么办的关键信息。

其次是规划,也就是综合各种情况,寻找可能的解决办法。

饿了,可以出去吃,可以叫外卖,可以自己做饭,也可以喊朋友来家里吃。此时,AI Agent 首先会检索记忆流,即它会根据你在这个时间点通常在干什么,你和最近的联系人聊了些什么,是否聊到了美食,又或者你的日程表上这个点有没有其他安排等等,来综合判断你是要出去和朋友吃,还是要在家做饭,又或者点个外卖凑活一顿。

而且在规划过程中,AI Agent还需要考虑到“近期性”和“重要性”,比如你最近消费减少,可能是月底工资不够花了,又或者你第二天要给女朋友送礼物,这个时候需要勒紧裤腰带,一切从简。

最后,再根据规划做出行动——在综合了你的个人习惯、消费情况、聊天记录、日程安排等等情况后,AI Agent决定,你应该点个外卖。

于是,它打开外卖App,帮你叫了一份你最爱的炸鸡和可乐,并帮你完成了付款。

也就是说,当你在游戏世界岁月静好的时候,是AI Agent在替你负重前行。

二、AI Agent这么强大,人类可以洗洗睡了?

电影《钢铁侠》里,每次史塔克要去冒险,贾维斯都会问一句,要不要给他的妻子打个电话。

这种超越工具性的时刻,是AI agent的终极形态。

但“很多市面上的Agent产品,其实并不Agent。”一位AI行业连续创业者这样评价道。

目前,市面上的Agent,包括OpenAI推出的GPTs,其实只是构建了一个基于特定知识库或专业数据的Chatbot,这些智能体主要用于进行问答交互,如获取行业资讯、报告等。

其主要进化路径,有两个方向:

一种是自动化。即给Agent一个目标之后,它可以自己通过目标来模拟一个思考路径,然后创建任务、完成任务,并且根据用户的目标不断重复地完成任务。

以GitHub上大受好评的Auto GPT为例,你让Auto GPT写一份某地区TOP 5鞋厂的研究报告,这是终极目标。

为完成这个任务,Auto GPT会先去网页搜索该地区五大鞋厂分别是哪些,然后再去看他们的营收数据、市场份额、产品情况等,依据搜索信息,最后以分析形式形成一份报告。

在整个过程中,Auto GPT自主将任务拆解为检索信息、提出问题和回答问题等阶段,最终完成了任务。

目前,市面上的自动化AI助理,主要集中在办公场景。

比如会议纪要,一个人做起来可能要耗费好几天的时间,但交给AI agent,它可以在全部的录音素材中,提取会议内容的重点,总结成bullet point,然后自动生成待办事项添加在To-do List中;

再比如,AI Agent可以帮助销售人员收集客户信息,分析客户喜好,拟定销售机会、自动跟进销售进度,等等。

另外一种路径,则是拟人化。

不同于自主智能体的发展路径,拟人化(智能模拟体)的发展路径更多遵循开发者设定的内部目标,强调的是拟人化的情感与交互。

现在,这种拟人化的AI agent大多出现在游戏中。像前文提到的虚拟小镇里的AI居民,以及由英伟达首席科学家Jim Fan等人发布的Voyager,都是由大模型驱动并且可以终身自主学习的智能体。

好消息是,大模型的学习能力,有时会出现智能涌现。

比如把Voyager接入游戏《我的世界》后,Voyager不是一个推动剧情的NPC,而是一个能够主动创造内容的“玩家”——通过不断自我进化,Voyager在游戏中获得的独特物品增加了 3.3 倍,行进距离增加了 2.3 倍,解锁关键科技树里程碑的速度比之前的方法快了 15.3 倍。

坏消息是,这种智能体充分进化而导致的“不确定性”,会让很多玩家在尝试过后,丧失进一步玩下去的热情——我玩游戏,不就是想获得掌控感吗?角色稍微不听话可以,完全不听话,还玩个啥啊。

当然,自动化和拟人化并不是Agent发展过程中全无交集的两条河流。

相反,自动化和拟人化是现在Agent发展的两大核心能力,围绕着这两个能力,AI Agent会在不断进化、不断成熟的过程中,探索出更多的使用场景。

三、人类距离终极智能体还有多远?

AI Agent,相当于一个硅基生物拥有一个碳基大脑。

尽管听起来遥不可及,但毋庸置疑的是,这将是AI产业的下一个风口。

比尔·盖茨在一篇文章中表示,AI Agent将颠覆个人与计算机交互的方式,并将在五年内彻底改变我们的生活。

英伟达高级研究员Jim Fan也预言,Agent将“推动整个文明的进化”。

那么,人类距离终极AI Agent,还有多少困难需要克服?

第一个问题,是开发成本高昂。

拿斯坦福大学的虚拟小镇“Smallville”来说,其中每个Agent的成本高达20美元/时,比大多数人的时薪都要高。

第二个问题,是产品的标准化。

“和GPT从免费到收费的过程一样,Agent商业化的普及也要经历产品标准化的过程。”科技行业投资人申林宇(化名)这样评价道。

比如你用AI Agent办公,考量指标应该是,它到底有没有提高生产效率。“各式各样的大语言模型类产品出现后,免费试用的阶段大家会有新鲜感,会去玩、会去尝试,但是如果你说这个东西开始收费,大家的态度立刻会从猎奇转换成审视。没有人会为科技类的猎奇产品持续买单,科技类的产品必须切实地提高生产力才能持续商业化。”

如果Agent没有成熟的产品标准,那么商业化落地便遥遥无期。

第三个问题,是权责和道德的问题。

比如医疗类Agent,它可能比大部分人类医生的知识储备都要多,但医院如果把治疗方案交给AI,需要跨越的并不只是技术的门槛,还有道德的高墙——一个生活拮据的老人心脏不舒服,但不影响生活,医生往往会根据情况建议保守治疗,但AI可能会建议做个手术。

在自动驾驶领域,AI Agent也存在决策权归属问题。

一位投资人曾描述过这样一个画面,“你的自动驾驶车辆行驶在高速路上,忽然前方的宾利急刹车,紧急车道上停着一辆破旧的二手车,车上正有一个抱着婴儿的母亲在打电话,这个时候到底该撞向谁?我们要把这个问题交给AI来决定吗?”

因此,该投资人认为,自动驾驶在5~10年内不会有重大的商业化突破。

即便跳过这个“电车悖论”,自动驾驶过程中出现交通事故之后的权责判断,也是摆在汽车厂商面前的现实问题。

人机配合过程中,很多时候很难判断到底是车的问题,还是人的问题,亦或者是人和车在争夺决策权的过程中出的问题,所以很多厂家现在已经跳过了需要人机配合的L3阶段,直奔自动驾驶的L4阶段去了。

把什么样的问题交给AI去决定?这是AI Agent产品商业化无法回避的问题,而无论创造产品的人还是制造规则的人,都没有过去的经验可以参考,那么,政策的推进就需要摸索和时间。

还有最后一个问题,是使用门槛太高。

很多人觉得ChatGPT不好用,是因为提示词给得不够好,而Agent产品的使用门槛相对会更高,消费者对其期待也更大。

一位智能驾驶研发员告诉我,很多司机不是不想调动自动驾驶,而是很多自动驾驶的交互做得不够好,不够让司机省心。比如路径如何规划,前方有什么路况,准备怎么解决等,这些信息如果没有及时传达,司机就没有足够的安全感去信任和调用AI产品。

因此,Agent产品如何做好交互,从而提高产品渗透率和使用率,最终触达到用户,是Agent发展最后一步也是最重要的一步。

总之,在通往终极智能体的路上,人类还需要越过很多个山丘。

四、尾声

2023年12月,Open AI董事长萨姆·奥特曼在X(原推特)上发表了自己的“年终总结”。

他写道:“这真是疯狂的一年……很高兴2023年是世界开始认真对待AI的一年。”

过去一年,从科技公司到硬件厂商,从传统制造业到新兴产业,从投资人到开发者,几乎全员都在聊AI、做AI。

AI教育、AI医疗、AI律师、AI自动驾驶,甚至AI性机器人……各种AI应用此起彼伏,但放到普通人身上,AI似乎又很遥远——它既不能替我们完成日常工作,也不能帮我们接送孩子、照顾老人。

换句话说,绝大多数人工智能应用,现在还不够智能、好用。

Windows的图形交互,简化了人与计算机的“互动”方式,推动了PC互联网的发展。

iPhone的电容屏幕和多点触控技术,改变了人与手机的“互动”方式,拉开了移动互联网的序幕。

而AI Agent,则可能改变人与AI的“互动”方式,让人工智能不再是一个光鲜亮丽、又遥不可及的名词。

尽管现在,人类距离AI Agent终极智能体还很遥远,但没有什么能够阻挡,一个必然会到来的潮流。

本文来自微信公众号:酷玩实验室(ID:coollabs),作者:酷玩实验室