扫码打开虎嗅APP

本文来自微信公众号:硅星GenAI(ID:gh_e06235300f0d),作者:苗正,题图来自:视觉中国

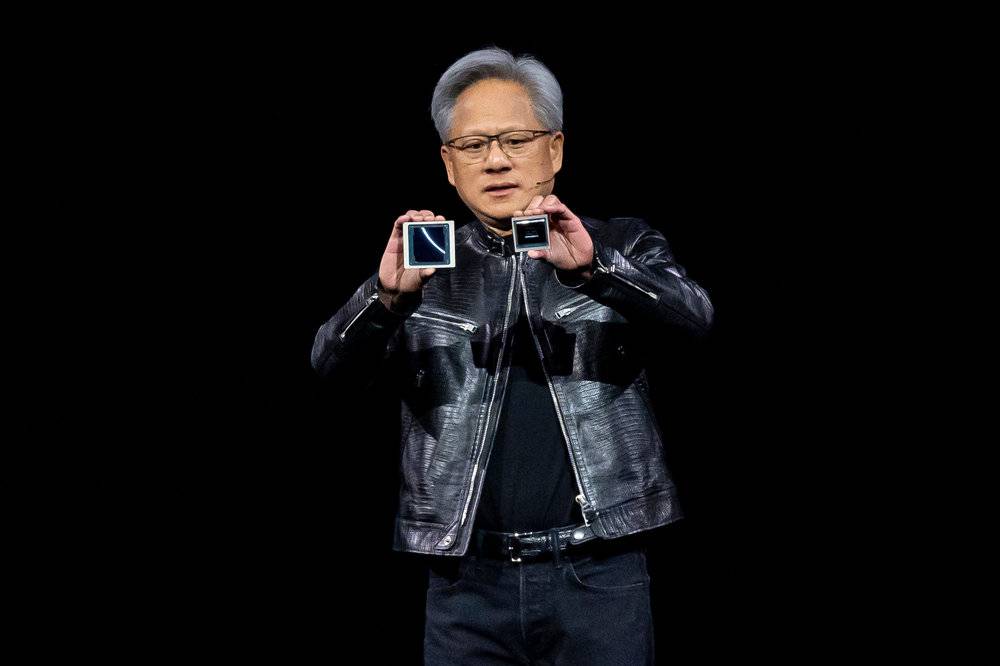

今天所有人都在讨论英伟达在GTC大会上发布的Blackwell芯片,它几乎把所有性能表现都刷新到了一个前所未有的级别。所以,它到底怎么做到的?

首先来看一下它的核心指标。

Blackwell B200 GPU核心由大约1600平方毫米的处理器构成,封装内包含两块硅片,上面集成的晶体管数量是2080亿。这两片硅片采用的是台积电(TSMC)的N4P芯片制造技术,相较于制作Hopper架构GPU(如H100)所使用的N4技术,性能提升了6%。

带宽方面,同Hopper一样,B200同样也配备了高带宽内存。

B200采用的是和H200一样的最新款HBM3e内存,总容量达到了192GB,相较于第二代Hopper芯片H200的141GB有所提升。此外,内存带宽也从H200的4.8TB/s提升至8TB/s。

根据英伟达的介绍,这个新GPU在训练性能上相较前代Hopper H100 GPU提升了四倍,推理性能提升最高可达30倍,而能源效率更是提高了25倍。

而这些只是开始,英伟达接下来开始“叠buff”,通过各种集成产品来把它的性能在实际场景里发挥到极致。

首先是和CPU合体。B200 GPU和英伟达自家的Grace CPU进行合体,组成GB200。它包含一个 Grace CPU和两个Blackwell GPU。GB200利用新型低精度数值格式,最高能实现高达11.5 exaflops的人工智能计算能力。说实话,关注硬件这么多年了,exaflops这个词我甚至是现查的翻译软件才知道具体说的是什么。11.5 exaflops代表1后面接18个0的flops,也就是每秒执行11.5百万亿次浮点运算。

真是字面意义上的“下一个量级”。

然后是英伟达口中的“超级计算机”——DGX GB200。它由3600个GB200超级芯片模块组合而成,通过Nvlink链接,以形成一个完整的系统解决方案。DGX GB200提供了超大规模的并行计算能力和极高的内存带宽,目标是服务于大规模的AI训练、推理和高性能计算任务。它有点对标谷歌TPU v5,也是一个完整系统,用来装在服务器上提供算力。

这些惊人的数据让人们关注“芯片”本身,但黄仁勋也在发布会一直强调:Blackwell不是芯片本身,它是一个全新的架构。这个如日中天的技术公司在自己技术上真正核心的迭代改变,其实藏在这些数据背后。

其中两个改进值得关注:其一是它的处理浮点数矩阵运算的单元,其二是它的封装尺寸。

B200的包含了能够处理仅4比特宽度浮点数矩阵运算的单元,这是个啥概念?我们经常听那些研究大模型的人讲一个概念叫做“并行计算”,其本质是说模型中的权重和激活值通常是以浮点数的形式存储的,而“矩阵运算”(如卷积、矩阵乘法等)是这些模型训练和推理过程中的基本运算。

GPU内置了大量的浮点运算单元,能够同时处理多个浮点数的运算,极大地加速了大规模矩阵运算的速度。这也是大模型需要GPU产品的核心原因。人工智能的计算对精度有特定要求,但并非所有操作都需要最高的精度。GPU支持多种浮点数格式(如FP32、FP16、BFLOAT16甚至INT8等),不同的浮点数格式对应不同的精度和存储需求。

越小的浮点数占用的存储空间更小,计算时所需要的读写次数相应减少,运算速度得到提升。同时对于GPU等并行计算硬件,同一时间内处理的浮点数越多,总的计算吞吐量就越高。较小的浮点数格式允许在同样的芯片面积上集成更多的计算单元,实现更密集的并行计算,从而提升大模型训练和推理的速度。Hopper可以使用小至 8 位的浮点数格式,Blackwell则是4位,而这种精细度上的变化,是Blackwell的一个“杀招”。

接下来说第二点,简单说,就是“大”。

看了发布会的人可能都会觉得,Blackwell最直观的感受就是大,下图是Blackwell(左)和上一代GPU Hopper(右)的对比,可以明显看出来Blackwell大了整整一圈。

Blackwell(左)Hopper(右),图/视觉中国

我们知道,芯片的封装尺寸越小,代表它的引线更短,需要的寄生电感、电容也就越小,那就有助于降低信号传输时的功率损耗,从而提高能效。同时由基础物理知识可以知道,当速度不变时,两地之间距离越近,到达时间也就越快,而更小的封装尺寸意味着信号传播距离更短,能够减少信号延迟,提高速度,这对高速信号传输和高性能处理器尤其重要。那为什么还要往大做呢?

首先小尺寸自己也有问题,最主要就是散热。热量从高温区域沿着温差梯度通过固体传递到低温区域,表面积越小,与周围环境接触的边界越少,热量传递通道就越少,散热效果相对较差。

任何一个拥有服务器集群的公司,他的头号敌人就是热。GPU工作时间既取决于模型训练的具体情况,也受制于基础设施条件和资源管理策略。对于高强度训练场景,GPU保持7*24小时连轴转已经是屡见不鲜了。如此的工作量就会产生大量的热量,这就是为什么越大的服务器集群,越需要高性能的制冷措施。

热对于设备的损耗有哪些呢?最重要的一点是当GPU温度持续高于推荐的工作温度范围时,高温会使内部电子元器件加速老化,甚至导致永久性损坏。例如,硅基半导体在高温下可能出现电子迁移现象,导致电路性能下降,严重时会造成GPU失效。

另外,大多数现代GPU都有温度保护机制,一旦温度过高,GPU会自动降低工作频率以减少热量产生,或者触发系统保护措施,直接停止工作以防止硬件损坏。这种情况下,计算机性能会下降,游戏帧率降低或者导致程序意外终止。

当然了,把封装尺寸做大除了散热效率增加,那里面装的东西肯定也增加了。就像开头咱说的,他里面有2080亿个晶体管,而H100才800多亿个,翻了两倍不止,最大原因就是这回物理意义上的“地方大了”。Blackwell之所以这么大个头,很可能是使用了多芯微(multi chiplet)设计。

这是一种把原本单个大型芯片分割为多个较小的、具有特定功能芯粒(Chiplets)的技术。这些芯粒各自独立制造,然后通过先进的封装技术将其堆叠或并排集成在一起,从而组成一个完整的高性能GPU。

这种设计的优点在于小尺寸芯粒的制造良率通常比大尺寸单芯片更高,通过组合多个良品芯粒可以提高最终产品的良率。同时它还允许不同芯粒采用不同的工艺节点进行制造,分别优化性能和能效。最重要的是它芯片里面的空间大了,可以集成更多的晶体管和功能模块,提高整体性能。

这并不是一个新鲜的技术,其他厂商早在尝试,根本原因是以“把芯片做得越来越小”为代表的路线正在走到尽头。比如GH100其实就已经接近当前最先进的4纳米掩模版的上限了。

黄仁勋称,这两个芯片可以像一个芯片那样,甚至两者自己都并不会区分自己是哪一块。而且,在软件层面,它们会被作为一个统一的CUDA GPU来运行。两者之间的互联速度达到了10Tbps,这比现在已知的Chiplet类的方案都要高。

这种连接能力甚至让英伟达干脆不再使用更先进的工艺,而是继续在4纳米工艺上做迭代。

黄仁勋并没有详细介绍英伟达是如何做到的。他只是在演讲里淡淡的装了一把:“当我们被告知Blackwell的野心超出了物理学的极限时,我的工程师说,那又怎样?”

本文来自微信公众号:硅星GenAI(ID:gh_e06235300f0d),作者:苗正