扫码打开虎嗅APP

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究,题图来自:视觉中国

Meta公布了自研芯片MTIA的新版本,不仅用于社交媒体中内容与广告的排行和推荐,而且能用于未来更复杂模型的训练和推理。

Meta去年5月份公布了7纳米的MTIA v1版本,已经开始用于数据中心,这次透露细节的5纳米的MTIA v2版本,其综合性能提升了3倍。

Meta称之为下一代训练及推理加速器,为解决Meta的AI负载而定制的芯片,将主要用于Meta的广告模型中的排行和推荐。Meta的场景负载,每天要处理上百亿次数据推理。MTIA v2不仅可以改善用户对产品和服务的体验,还提升了计算效率,以支持开发者构建AI模型。

MTIA v2架构

与前代相似,第二代MTIA包含64个被称为PE (Processing Elements)的计算模块,这些模块针对AI推理任务进行了优化。每个PE都有一个专用高速缓存,可用于存储数据。将内存放置在逻辑电路附近可减少数据在两者之间传输的距离,从而缩短传输时间并加快处理速度。集成在每个PE计算模块中的缓存从128KB扩展到384KB。

Meta工程师在博客文章中详细说明:“通过专注于提供超大的SRAM容量(相对于典型GPU而言),即使批量大小有限,我们也能保持高效的资源利用率,并在面对大量潜在并发任务时,仍能提供充足的计算能力。”

另一个提高新芯片性能的因素是一系列“与稀疏计算相关的改进”。AI推理芯片可以移除对于结果来说非必需的数据,从而加速计算。

Meta还开发了一套定制软件工具,核心是一个名为Triton-MTIA的系统,可以将开发人员的AI模型,转换成适合在自己芯片运行的形式。它部分基于Triton,这是一个由OpenAI开发的开源AI编译器,带有自己的编程语言。Triton-MTIA还与其他开源技术集成,包括PyTorch,这是一个由Meta创建的流行的AI开发框架。

Meta称,相比采购GPU,因为它控制了整个技术栈,效率更高。但Meta并不想用自定义芯片取代英伟达的GPU,而是强调互补关系。

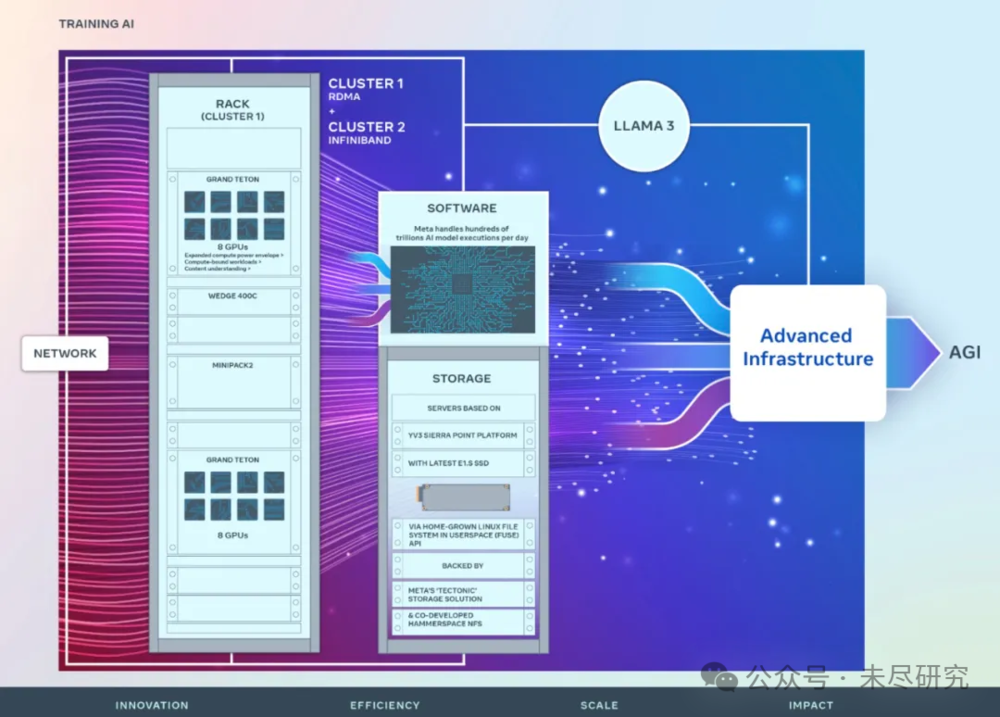

一个月前,Meta 宣布推出两个 24k GPU 集群(共 49152 个 H100)。

之前,Meta用于训练Llama和Llama2的集群,是一个 AI 研究超级集群(RSC),配备 16000 个 A100 GPU。新集群建立在 RSC 的成功和教训之上,能够支持上一代所无法胜任的更大、更复杂的模型,如Llama3。

Meta提出了一个雄心勃勃的基础设施计划:“我们正在设计自定义芯片,使其能够与现有基础设施以及未来更先进的硬件(包括下一代GPU)协同工作。实现我们的雄心,需要投资计算芯片,同时也要投资内存带宽、网络和容量,以及其他下一代硬件系统。”

Meta今年将花上数百亿美元,用来建立算力基础设施,其中很大一部分用来采购约35万张H100卡,使其总算力达到等效65万张H100卡。

显然,Meta正跻身于亚马逊、微软、谷歌之列,通过研发定制芯片,构建软件系统,从基础设施到应用,端到端地解决自己的问题。

就等Llama3了

最近的开源模型的声势,大有压倒闭源之势:

马斯克开源了Grok-1,3140亿参数,

Mistral开源了8X22B, 2620亿参数,

都是MoE(专家混合模型)。

Cohere推出了 Command R+,1040亿参数,并且成为首个在大模型竞技场上(Arena Elo)击败GPT-4的权重开放模型。其中R+的意思是“RAG优化模型”。此外,它还包括10+种语言,包括英语、中文、法语、德语等;并且能使用工具完成复杂业务流程的自动化。

如果说直到去年底开源模型的目标是追赶GPT-3.5,今年开源的目标开始“欺负”GPT-4了。

2024年仅仅过了一个季度,基础大模型领域出现了令人兴奋的变化。Claude3和Command R+分别成为最强的闭源模型与权重开放模型,分别超过和赶上了GPT-4。

而Meta的Llama3也将在几周内发布。据提前透露出来的消息,它将具备更强的推理与规划能力,也有更强的记忆力,处理更复杂的任务。Meta将推出不同规格的模型,以适用于不同的场景。

对于新推出的LLama3来说,部署到硬件上将是重要的目标之一,如Meta与雷朋定制的智能眼镜,可能也包括VR/AR设备Quest。

尤其是推理能力,成为LLama3和GPT-5都要着重解决的问题。只有更严密的推理能力,大模型才能成为智能体,有条理地完成多步骤的任务,才能真正让用户放心使用。

Meta正在彻头彻尾地成为一家AI公司,芯片(MTIA)-数据中心-软件(Pytorch等)-基础模型(Llama)-超级应用(Facebook/WhatsApp/Instagram),所有这些,正在让Meta从一家社交媒体巨头,变成了一家真正的科技巨头。

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究