扫码打开虎嗅APP

本文来自微信公众号:量子位(ID:QbitAI),作者:铜灵

半个世纪前拍摄的黑白老旧电影,现在迎来了人生的“第二春”。

在AI的帮助下,这些只有黑白灰三色的视频片段,已经变成了彩色的。

在Facebook的F8大会上,国外技术小哥Jason Antic展示了一种叫DeOldify的AI模型,这种技术为老电影上色效果堪称惊艳。

不信?直接看效果:

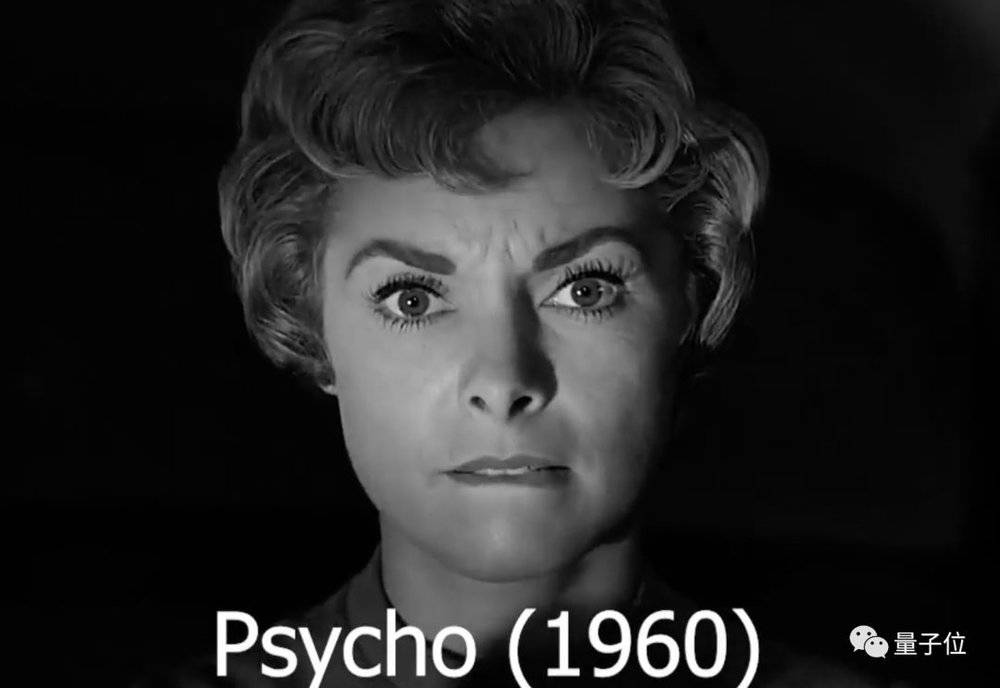

比如,1960年的美国惊悚恐怖电影《惊魂记》:

用AI上色后的毫不违和,人脸部分的妆容也不别扭:

黑白电影时代的幽默大师卓别林,第一次在镜头下有了颜色:

89年前的美国电影Reefer Madness,就这样被轻松还原了:

输入黑白灰,输出红绿蓝,这个AI模型开始大火。Jason Antic小哥的推特收获了近800赞,推特网友直呼“Amazing!!!”、“very cool”、“wow”。

不过,这还不是DeOldify模型的全部实力。

在线试玩

除了视频,DeOldify还能处理老旧的黑白照片和图像。

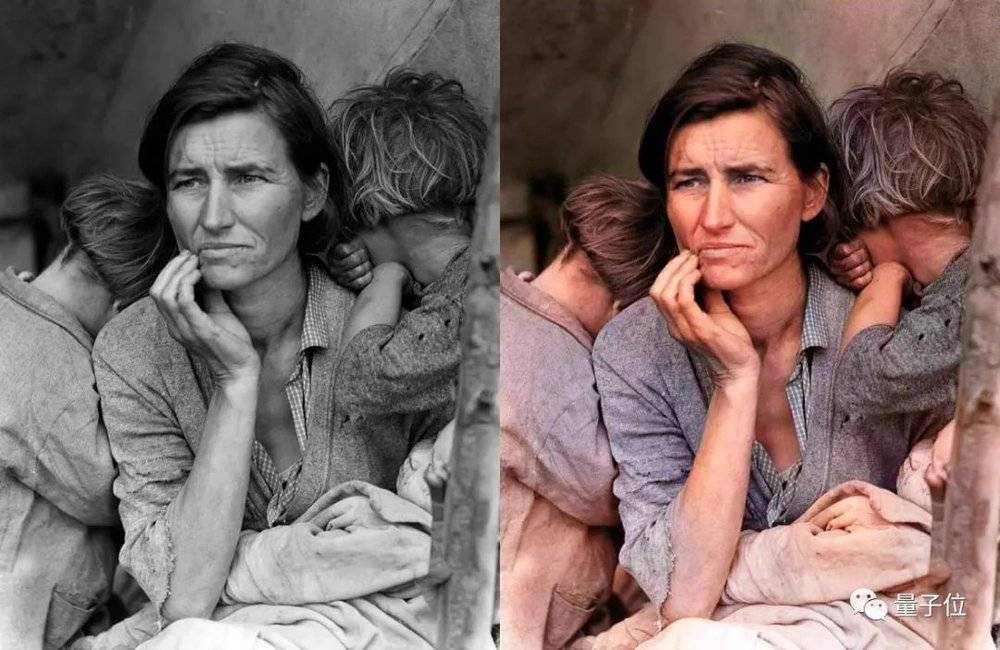

比如1936年Dorothea Lange的摄影作品《移民母亲》:

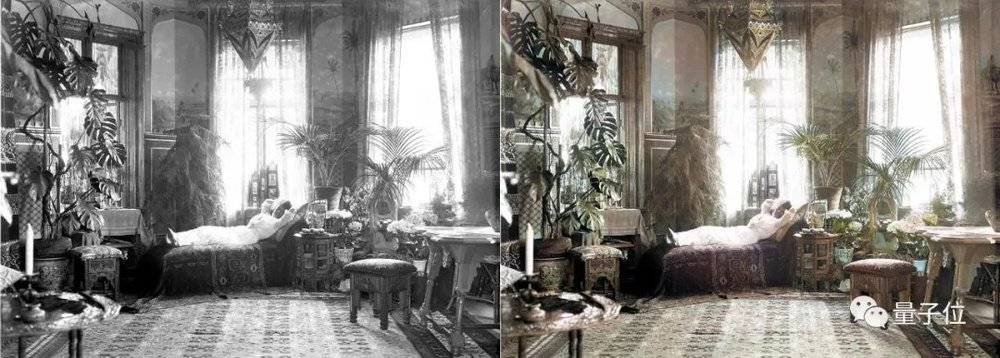

1920年在卧室放松的瑞典妇女:

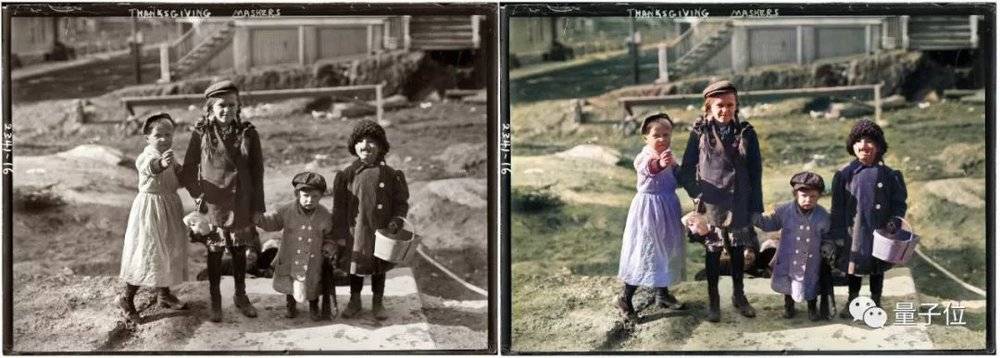

1911年的Thanksgiving Maskers:

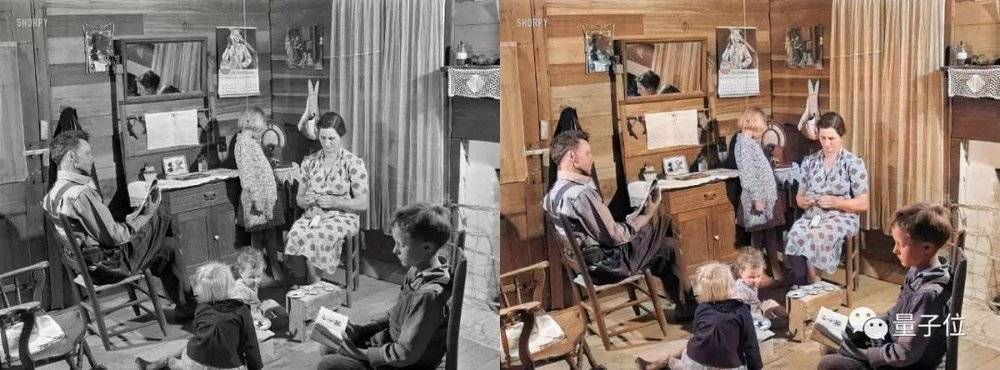

1941年在农场的Lemuel Smith先生及其夫人以及他们年幼的孩子们:

1890年代末的挪威新娘:

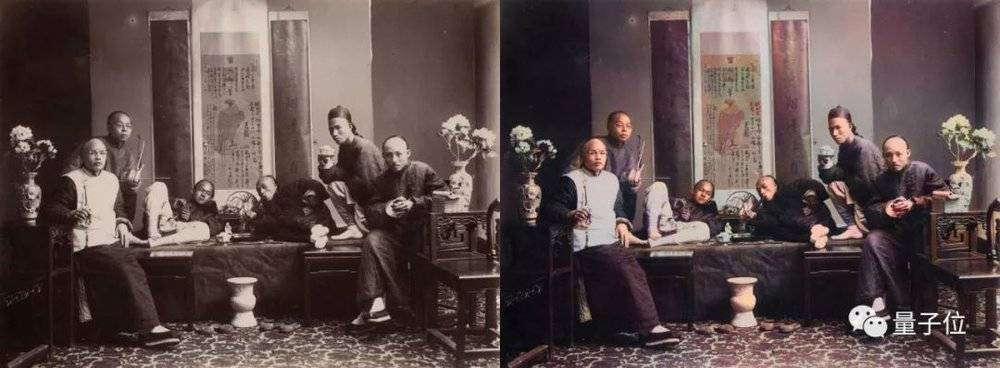

1880年吸食鸦片的中国人:

以上这些画作的上色,均由DeOldify完成。无论是人像还是场景,或是绿油油的田园景象,这只AI上色画师的处理都自然完美。

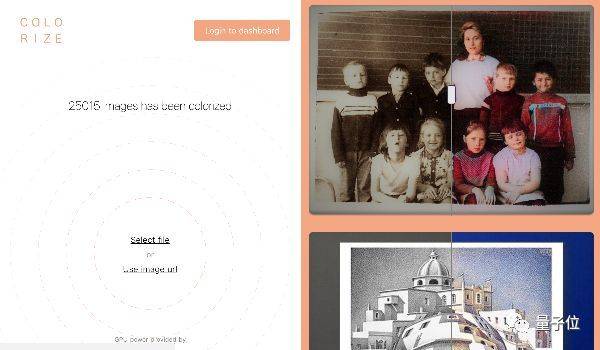

好消息是,这个为图像上色的模型现在还有了demo,你也能在线试玩了。

试玩地址:https://colorize.cc/

操作也非常简单,传入一张黑白图像,输入自己的邮箱地址,不一会儿就能收到上了色的版本。

高效的NoGAN

上色大师DeOldify是怎么做出来的?

作者小哥表示,这背后是一套名为NoGAN的架构。他自称这是一种奇怪,但是非常高效的图像到图像的训练方法。

这种深度学习模型借鉴了当前多种主流技术方法,包括:

自注意生成对抗网络(Self-Attention Generative Adversarial Network)

生成器是一个预训练的Unet,小哥进行了一个非常简单的转换过程,将其修改成了具有谱归一化和自注意力。

相关研究:https://arxiv.org/abs/1805.08318

两个时间尺度更新规则

也就是说这是一个一对一的生成/辨别迭代,并且具有更高的辨别器学习率。这种修改能够确保辨别器在生成器训练前被“捕获”。

相关研究:https://arxiv.org/abs/1706.08500

生成器的损失分为两部分

一是基于VGG16的基本感知损失(或特征损失),这让生成模型更偏向于输入生成图像。二是来自辨别器的损失,因为仅单一模仿输入并不能带来很好的生成结果,可能会出现一些棕色/绿色/蓝色的简单堆叠来欺骗检测。

所以需要意识到,生成对抗网络的本质就是学习损失函数。

NoGAN

重头戏来了,NoGAN是一种新型的GAN训练方法,能用来解决此前GAN训练过程中的关键问题。

NoGAN的相关论文虽然还没有放出,但小哥在Github中大致介绍了NoGAN的特点。

此前,训练模型的大部分时间都用在了预训练生成器和critic这一部分,但NoGAN可以花费最少的时间直接进行训练。

这种方法的训练流程为:

先用常规方法训练具有特征损失的生成器,接下来从中生成图像,并把辨别器当成一个二元分类器,区分输出图像和真实图像之间的差距。对于辨别器来说有一个拐点,在拐点附近生成图像质量最佳。为了找到这个拐点,小哥也只能通过数次尝试,没有巧方法。

NoGAN训练还有一个关键问题,可以在最初GAN训练后,用相同的方式对生成的图像重复进行预训练。

Github地址:https://github.com/jantic/DeOldify/blob/master/README.md

本文来自微信公众号:量子位(ID:QbitAI),作者:铜灵