扫码打开虎嗅APP

不久前,谷歌对于 AI 诊断乳腺癌的研究登上了 Nature 杂志。这项研究获得多方赞誉的同时遭到了 Yann LeCun 等研究者的批判。Yann LeCun 等表示说,NYU 有一项类似的研究,时间更早、效果更好。本文来自微信公众号: 机器之心(ID:almosthuman2014),作者:张倩、一鸣、杜伟,题图来自:图虫

医疗是 AI 技术涉足最深的领域之一,人们希望 AI 可以帮助医生更早、更准确地诊断病情,目前正在研究的病种包括癌症、心脑血管疾病、眼部疾病等。早在 2017 年,谷歌的 DeepMind 就宣布开始向乳腺癌发起挑战。

近日,谷歌宣布,这一项目取得了重大进展:谷歌研发的乳腺癌检测深度学习模型击败了 6 名全日制放射科医师。

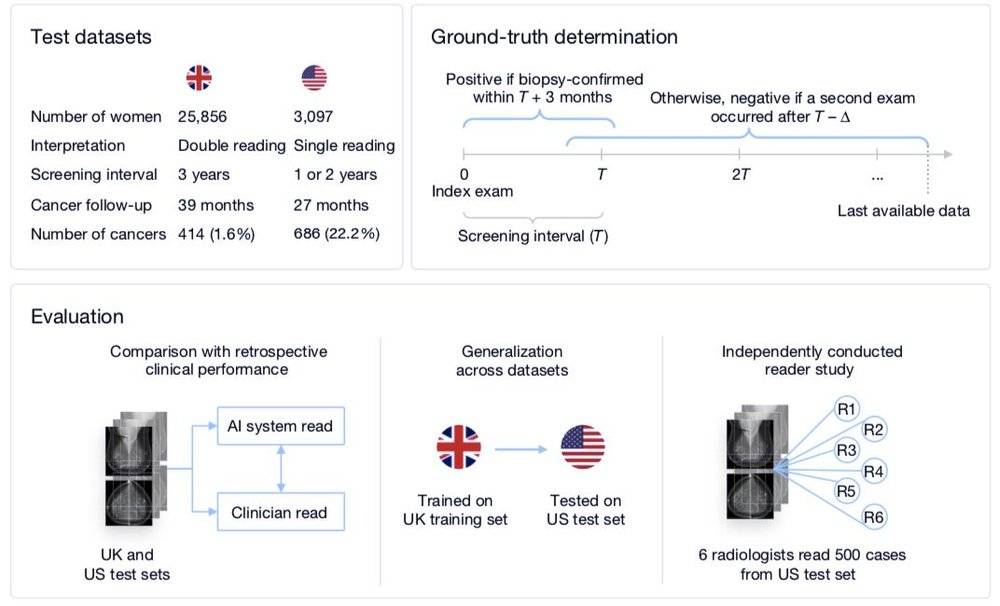

研究的整体流程一览

谷歌这次公开的研究是一种新型的深度学习钼靶影像系统(钼靶筛查是乳腺癌筛查的“金标准”)。与之前的模型相比,该模型有效减少了乳腺癌被错误识别或遗漏的情况,将乳腺癌检测的假阳性率降低了 5.7%,假阴性率也降低了 9.4%。

此外,该模型的泛化能力也非常强大。虽然训练数据多为西方人,但却可以广泛应用于中国人群,这点在医疗 AI 模型中非常难能可贵。

由于表现出色,这一结果很快就登上了《Nature》,并引发了大量关注。

但与许多高调官宣的研究一样,这项成果也未能逃脱被质疑的命运。在 Twitter 上,Yann LeCun 等几位大佬已经就此问题吵得不可开交。

DeepMind 高调官宣,LeCun 泼冷水

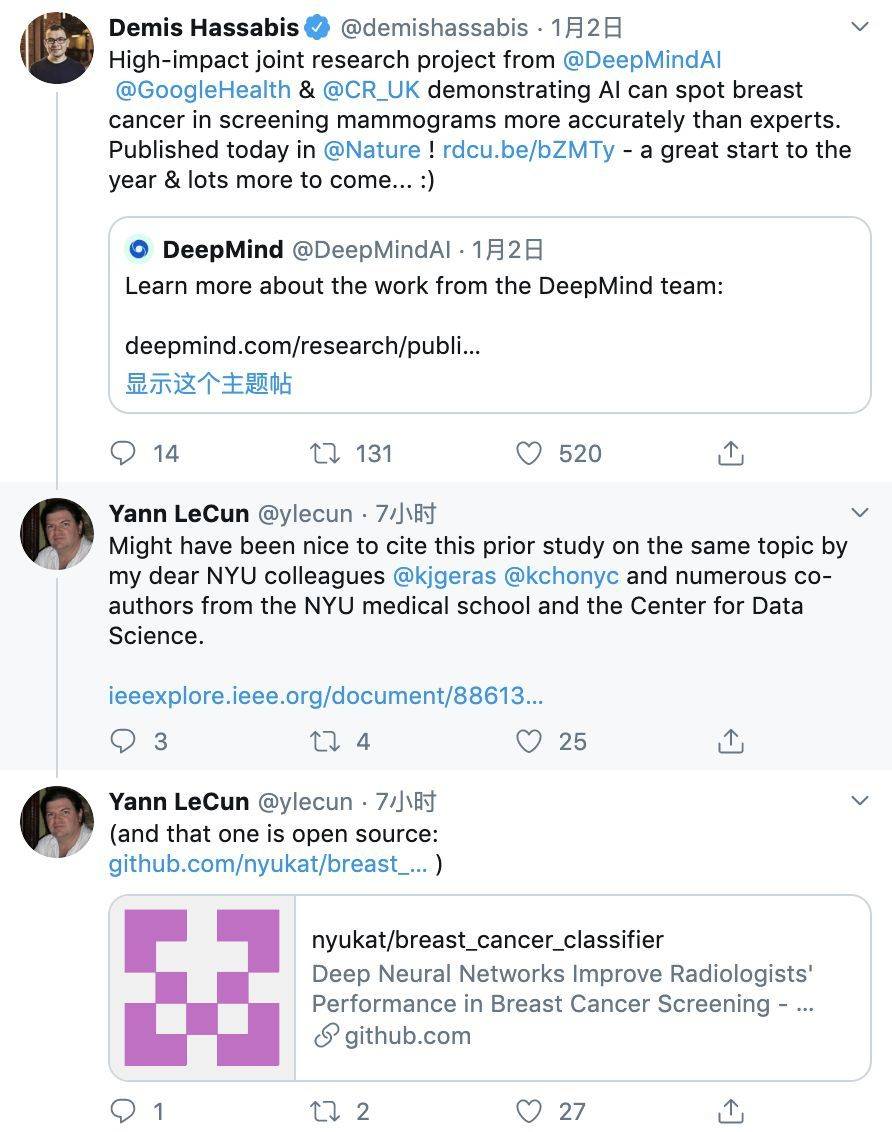

人在新年,刚发 Nature。DeempMind 创始人、这篇论文的作者之一 Hassabis 心情好到飞起。在 DeepMind 推特账号高调官宣之际,Hassabis 也发文力推,称“这是新一年一个很棒的开始!”

但没成想,一盆冷水很快就泼了过来。深度学习三巨头之一的 Yann LeCun 表示,这篇论文取得的结果 NYU 团队在之前已经做过了。

LeCun 表示,谷歌应当引用 NYU 的研究,因为这个研究效果还更好。LeCun 在评论中留下了开源地址。

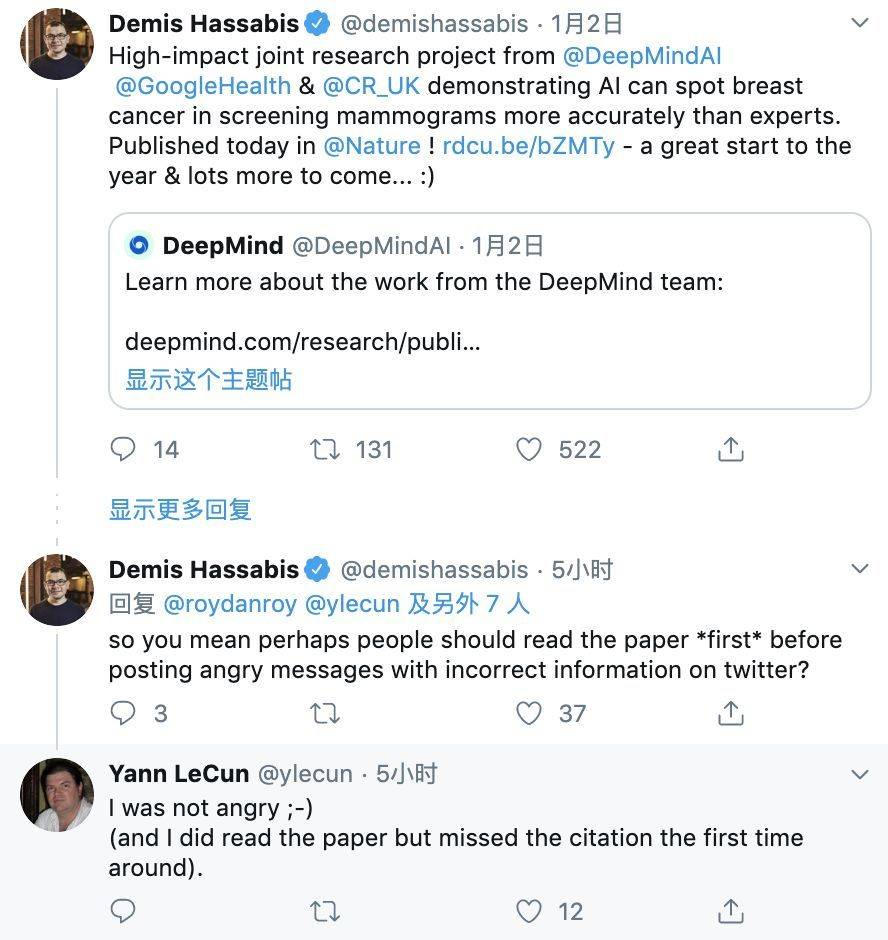

对此,Hassabis 不以为然,他表示:“我们引用了这篇论文啊。LeCun 应该先读了论文再发表愤怒的言论。”

LeCun 则表示自己第一次读论文的时候看漏了引用。

诚然,这可能只是一次小的误会。但是 LeCun 转发了另一位研究者对这篇论文的评价,这就很耐人寻味了。

在这个评论中,Hardian Health 的管理总监,具有放射科医学经验和 AI 经验的 Hugh Harvey 表示,去年的 NYU 论文具有更好的结果、更多的数据验证、和更多的人类放射科医生进行了对比,同时代码和数据都是开源的。

Hugh Harvey 提到的这篇论文发表于去年 10 月份,该论文与谷歌的论文对比如下:

谷歌的研究中涉及 6 位放射科医生,NYU 的研究用到了 14 位;

谷歌论文报告的 AUC 是 0.889(UK)和 0.8107(US),NYU 的 AUC 结果为 0.895。

因此,这位研究者断言,谷歌只是 PR 能力更强罢了。

Yann LeCun 扒出来的 NYU 论文引起了一些研究者的注意。经过对比,不少研究者表示,谷歌的研究的确存在一些问题。

纯属 PR,不能复现?

对于谷歌和 DeepMind 论文中的乳腺癌检测深度学习模型,专注于神经科学大数据分析的 Danilo Bzdok 教授发表了自己的意见。他认为训练该模型所使用的代码过多地依赖谷歌的内部工具、基础设施和硬件,因此它是不可行的。

对于 Danilo Bzdok 的这种观点,评论者也纷纷表示赞同。有人激进地表示,这篇论文就不应该发表出来。

也有人说,如果研究中使用的模型无法复现,则应该保密不予发表。谷歌公开论文是为实时收集用户的健康数据奠定基础,因为他们的软件只能在自己的基础设施上运行。除此之外,谷歌至少应该公开训练过的模型。

另外,还有人表示自己只是将此看作一个未能兑现研究成果的科研项目罢了,谷歌要么开源研究中使用到的工具,要么使用那些公开可用的工具。换言之,一项研究理应提供能够复现实验的工具,否则就不能称之为科研发现。

会读片并不代表会看病

其实早在论文发出的第一时间,reddit 和 hackernews 等社交平台上就已经出现了相关的讨论,放射科医生也参与了进来。

一位放射科医生表示,其实,乳腺癌的诊断是一个非常复杂的过程,不只是读 X 光片那么简单。相比之下,读 X 光片可能只是众多诊断步骤中的第一步。

其次,就乳腺癌检测而言,X 光检查结果其实并没有那么准确,要想获得准确的检查结果,还要进行进一步的 B 超、核磁共振等检查。

所以,综合来看,深度学习在医疗筛查、诊断方面的准确性不断提高是一件好事,也是医生喜闻乐见的,但是“AI 战胜/取代人类医生”这种论调实在是不可取。

当下的医疗 AI 创业公司也多是宣称可以辅助医生,帮助医生分担一些工作,而由于泛化性能差、稳健性差、数据存在偏见、医疗仪器规格不一等种种问题的存在,“辅助”这一角色做好都尚且困难重重,“战胜”、“取代”的说法更是无从谈起。

谷歌论文:https://www.nature.com/articles/s41586-019-1799-6

NYU 论文:https://ieeexplore.ieee.org/document/8861376

本文来自微信公众号: 机器之心(ID:almosthuman2014),作者:张倩、一鸣、杜伟