扫码打开虎嗅APP

本文来自微信公众号:把科学带回家(ID:steamforkids),撰文:比邻星,原标题:《在AI眼里东方人和西方人原来是画风这么不同的两类表情包》

魔镜魔镜告诉我,世界上谁的微笑比蒙娜丽莎更神秘?

老板的。

著名美剧《Lie to me》带火了一波微表情,甚至连你自己也忍不住通过分析男朋友咽口水的细节和向左下方看去的眼睛,试图从FBI视角分析对方有没有瞒着你的小秘密。

*The truth is written all over our face*

于是,很多科技公司试图在人脸识别的基础上更进一步,正在努力开发一种名叫“表情识别”的算法。据说,有了这些能解读表情的AI,就可以一眼看出在机场贼眉鼠眼的可疑人士,或者判断出面试者的小心思。这项技术预计2024年推出,估值为560亿美元。

所以,你的表情真的能出卖你的心吗?

表情的真相

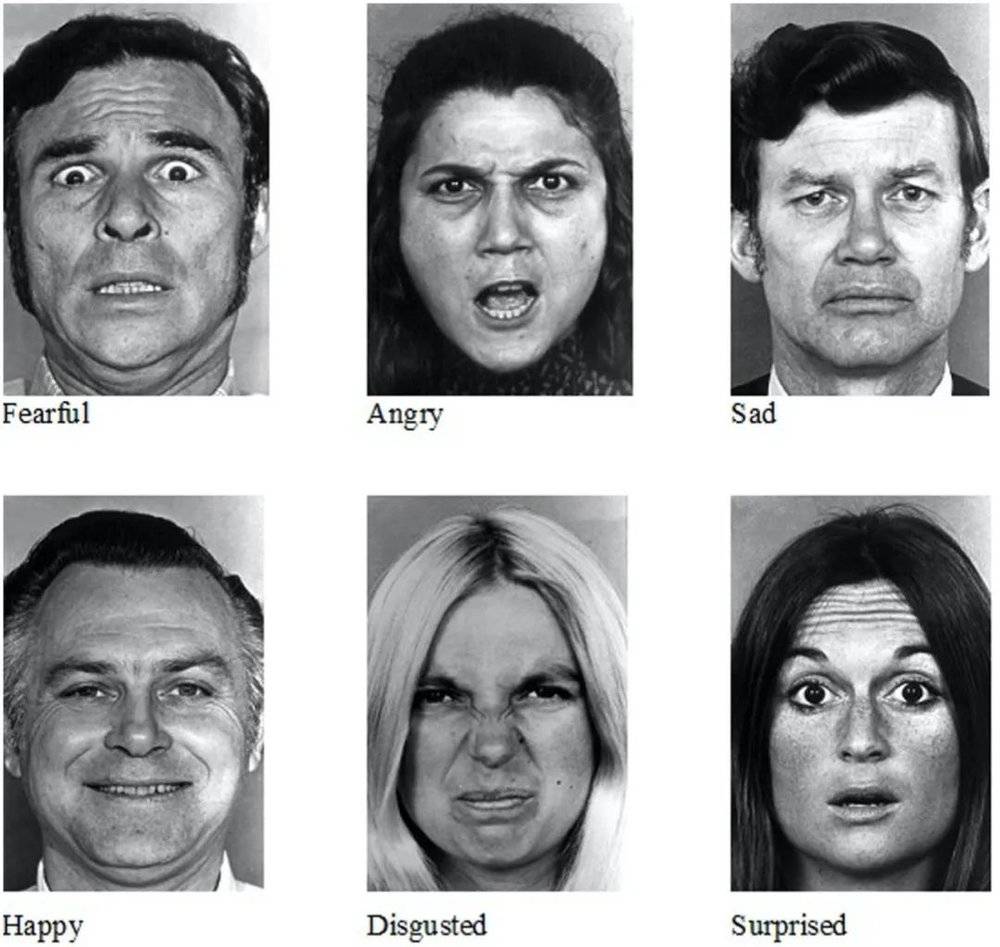

不管脸大还是脸小,每个人都藏着43块面部肌肉牵动你的皮肤。这些肌肉分布在眼眶、鼻部和口部,可以通过收缩和舒张牵动皮肤运动,这样你便有了各种表情,用以表达6种基本情绪:喜、怒、哀、惧、惊奇、厌恶。

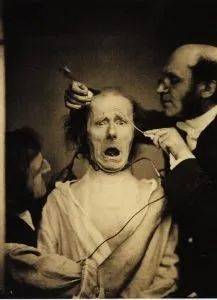

其实早在19世纪,就有人打起了面部表情研究的主意。那时,一位名叫邦雅曼·阿芒·迪谢纳的法国生理学家做了一些让人……不太舒服的实验。他邀请了不同年龄的5位受试者,试图找出面部肌肉和表情的秘密。具体方法是:

把电流探针接在受试者脸上,然后依次对面部肌肉实施低强度的电流刺激,最后拍照记录展现出的表情。想想看,那些表情可能会很诡异。

现场直击

有一个人却对这些照片很着迷,他就是大名鼎鼎的达尔文。

达尔文的第一大著作是1859年问世的《物种起源》,还有一部鲜为人知的,是发表于1872年的《人与动物的情感表达》(The Expression of the Emotions in Man and Animal)。这本书同样从进化的角度分析了灵长类动物表情的进化学意义。

那些被达尔文兄研究过的小表情

来做个实验,请默默在心中回想令你厌恶的人或事(比如试着想想,假如你被选中去参与那位法国生理学家的实验),然后照镜子看看自己是什么表情。我猜你可能会撇嘴、皱鼻然后眯起眼睛。达尔文推测,这些举动是一种防备,可以防止有害的病原体进入体内,这就是表情对灵长类动物的进化学意义。当然,这只是最原始的,表情的另一大进化作用在于有利于种群个体间的交流。

我们可以通过表情交流吗?

如果你是个表情管理不太到位的人,表情确实可以说话。(比如,小编的一位朋友,看到帅哥就会张开嘴并伴随目不转睛的注视。)但人是可以伪装表情的,并且如果段位够高,内心翻江倒海的时候也依然可以面不改色。这就给表情是否真能用于交流提出了质疑。

来用数据说话。一批科学家花了两年半的时间,收集了一千多篇分析人类表情的论文,最终得出结论:根据面部肌肉运动来推测一个人的情绪状态是不可信的。

不信?比如来看这张图:

你觉得他在哭还是在笑,或者是喜极而泣?

人类表达情绪是一个多维度的过程,除了表情,你的动作、声音都在配合着情绪表达。只看一张静止的脸,没有动态的动作,也没有联系上下文的情景,你真的判断不出来对方在想些什么。

而且,同样的情绪,在不同文化背景下的人身上可能会有不一样的诠释。简单概括就是,西方人嘴部的戏很足,东方人眼睛的戏很足。

本宫给你个眼神自己体会

事情是这样的,研究人员通过计算机模拟算法随机合成非常多种的面部表情,然后再进行6种基本情绪的分类。

结果显示,东方人的表情变化主要集中在眼睛附近,就像这样:

^ _ ^ (∩_∩) (*^o^*) ( ̄∇ ̄)

而类似的情绪变化在西方人那里,则变成了嘴部表情的变化。就像这样:

:-) :-I :-( :-P

AI 怎么猜出你的表情?

基于机器学习的算法一般都是类似的套路,先让AI学习大量的素材,然后从中寻找规律,最后学会识别。为了让AIget读懂表情的技能,开发者准备了上百万张面部表情的图像和上百个小时的录像,素材来源覆盖了87个国家的700多万张脸。据说判断准确性能达到90%。

大概就是这么玩儿的

事实上,很多研究人员都觉得,目前人们对表情的解读还没有成熟到可以发展这项技术的水平。比如,静态的照片根本无法“联系上下文”,对表情的归类也就没那么准确;不同地区的人有不同的表情表达方式;而具体到个体,每一个人的表情习惯都是不一样的,这就给AI预测一个人的表情信息增加了非常大的难度。

总的来说,AI也许能判断群体中大部分人表情含义的平均情况,但无法很精确。所以想让他帮助公共场合的安保或者助力HR的面试考核,结果很可能不靠谱,如果因为这个就抹掉受试者的工作机会,那对方也太冤枉了。

也许我们还需要更多张脸,才有可能读懂人心。

AI:“我装作听不懂的样子。”

本文来自微信公众号:把科学带回家(ID:steamforkids),撰文:比邻星