扫码打开虎嗅APP

本文来自微信公众号:SME科技故事(ID:SMELab),作者:SME,头图来源:IC photo

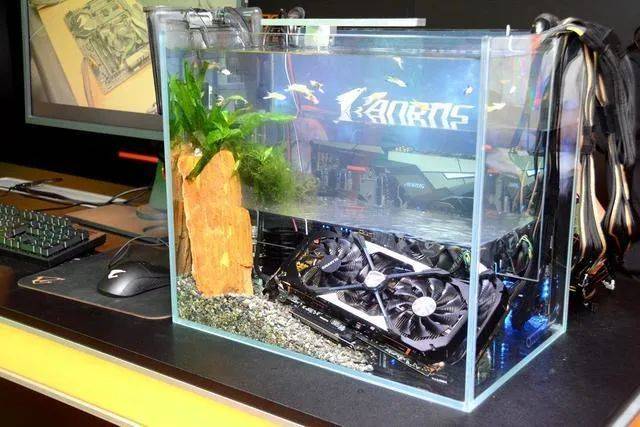

在DIY“搞机”的江湖里,永远都有关于散热的传说……

“想当年图吧老哥用萝卜散热超到5GHz,我卡吧切胆侠用水银散热把把吃鸡不是问题!”

典故解释:萝卜散热源自图拉丁吧,其原理主要是萝卜含水量较高,热容量大,可以在短时间内稳住CPU的温度。切胆侠乃显卡吧上古知名人物,突发奇想把水银灌入水冷系统,途中因吸入水银蒸汽进了医院,据说因此切除了胆囊,成为众人传颂的“切胆侠”传奇。

这当然是段子,但却足以说明民间的DIY装机玩家对散热的两个极端追求——低成本、高性能。

极限超频中会使用液氮来给CPU降温

不管半导体电子工业有多先进,都摆脱不了焦耳定律这个物理学规律,发热是免不了的。在同一代制程工艺下,往往芯片的性能越高越热。

民间之所以奇葩散热方法群魔乱舞,一方面是玩家对性能或者性价比的追求,另一方面是电脑主机DIY中,往往只有散热系统才是能够真正DIY的部分,其他不过是配件的简单排列组合而已。

随着芯片技术的高歌猛进以及大型游戏的出现,CPU或显卡厂商也都经历了大力出奇迹的阶段。散热的方式也从万年不变的风扇发展出了水冷系统(使用导热性更高的液体带走芯片堆积的热量,液体再通过别处的散热器冷却,形成循环)。

还诞生了一些冰箱散热、空调房散热、东北寒冬散热之类的,总之冷风对着吹,温度总能下降几度。

也会有一些美好的设想,比如直接把空调塞进机箱里,用压缩机和冷媒制冷。不过压缩机的体积太大,工作噪音也不小,用在家用电脑上有些杀鸡用牛刀的意思。

如果我们把规模放大,比如有成百上千台服务器的数据中心,大型空调系统就能展现它真正的实力了。

然而,问题也随之而来——交不起电费。以一间135平方米的数据中心来说,可以安装30台功率3kw的机柜,为了保证稳定运行且有一定的冗余,需要配备制冷量200kw以上的空调。

如果是同样面积的住宅,给每个房间都装两台空调满负荷运行时耗电量也只是数据中心的小零头。一个大型数据中心的耗电量与美国一个小城市的用电量相当。

前两年火遍全球的网络神曲“Despacito”的播放量超过50亿,人们播放它消耗的电量相当于4万户美国家庭的用电量。

数据中心飙升的耗电量已经成为各国担忧的能源问题。而其中用于制冷或者散热的电能占比很高,一般来说可以占到数据中心总用电量的40%甚至更高。

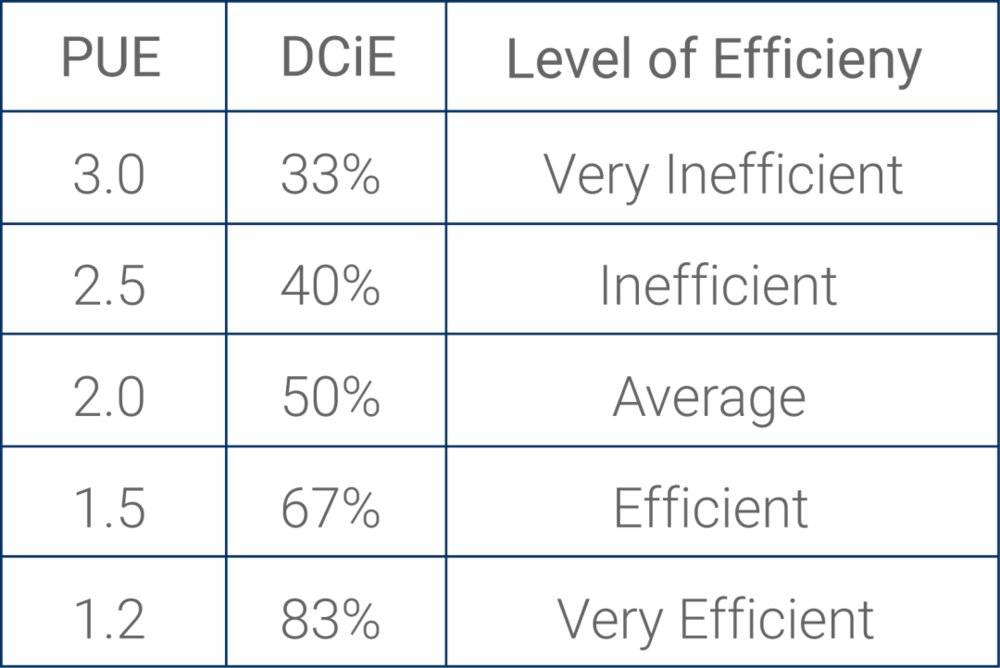

有一个相关的考核指标PUE(电源使用效率),即数据中心总能耗除以IT设备能耗,数值越大代表效率越低,一般认为PUE值达到2算是合格水平,也就是IT设备能耗占一半。

所以数据中心的散热问题是各大互联网巨头最头痛的。也因此诞生了各种脑洞大开的散热方案。

还记得前面提到的东北寒冬散热大法吗?这是最常规但很稳健的一种思路,大自然就有免费的冷气为什么不用呢?

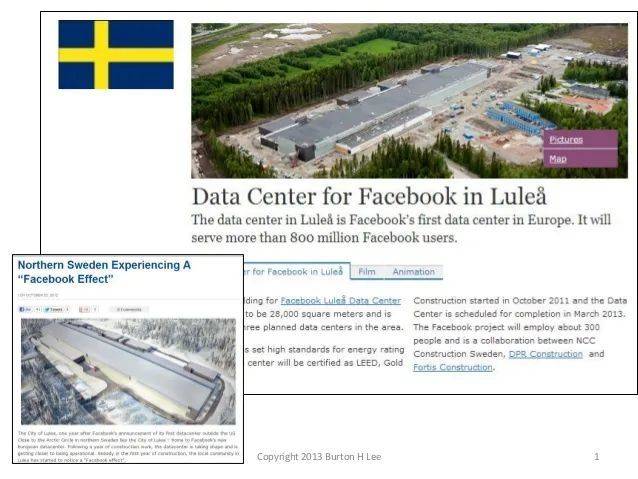

2013年Facebook在瑞典靠近北极圈的吕勒奥建立了约27000平方米的数据中心,利用高纬度相对寒冷的气候降低数据中心的散热成本。

另外,吕勒奥还有相对廉价水电,根据官方的说法,吕勒奥数据中心还首次独家使用了“OpenCompute Project”设计的服务器硬件,运行效率提高了38%,运营成本降低了24%。

虽然远在北极圈边缘,但这一个数据中心可以为全球11亿的用户提供服务,PUE达到令人惊讶的1.07,接近理论极限值。

同样走这条老派线路的还有腾讯,不过鹅厂的数据中心没有建到北极圈去,而是建到了贵州的山洞里,俗称“洞冷”。

和Facebook的策略类似,贵州的气候虽不如高纬度地区寒冷,但却有相对湿润的空气,一定条件下,封闭系统内湿度增加可有效降低发热设备的表面温度值。

施工中的腾讯兴安七星数据中心

另外,贵州还有非常多的天然山体,山体内部的温度相对较低,在挖掘出的山洞中架设服务器,加上深度预制的制冷技术和贵州低价的水电资源,大大降低了运营成本。

经过工信部实测,腾讯兴安七星数据中心的极限PUE达到1.1左右。山洞里建数据中心还有特殊的能力,不仅隐蔽安全,甚至可以防御核打击。

以上是两家玩的是因地制宜,还有另一派是玩水的,其中要数谷歌最为重口。

2007年的时候谷歌在美国佐治亚州开设大型数据中心时,就设计了一套蒸发冷却系统,简单来说就是利用液体蒸发吸热的原理来带走数据中心产生的热量。

谷歌道格拉斯数据中心的管道也是有主题色

起初他们打算直接使用市政供水,毕竟那样最方便。不过很快他们就意识到,用来蒸发冷却而已,为什么要跟城市里的居民抢水用,太浪费了。

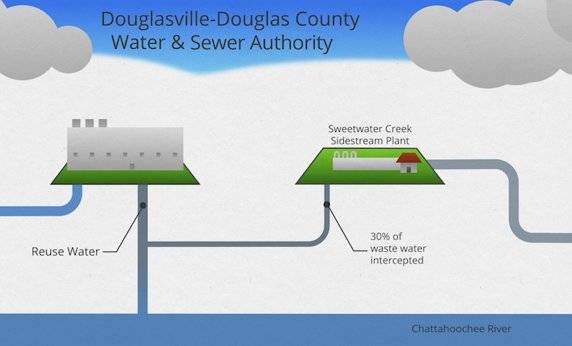

于是谷歌找到道格拉斯县的供水和污水处理局,希望利用污水处理厂的生活污水来给数据中心散热。

夸张点说,当你坐在马桶上边酝酿情绪边刷手机看视频的时候,给你手机提供网络服务的数据中心可能正在用来自你胯下的污水散热,有一种谜之轮回的既视感。

当然,生活污水并非直接排到谷歌的数据中心,还是要经过污水处理厂简单处理的,但它的品质远远达不到居民生活用水的标准。

原本这些简单处理的污水会被排放到当地的河流中,现在被谷歌的数据中心蒸发到空气中,不仅废水利用,还更加环保。

类似的,阿里巴巴也把水玩出了艺术来。阿里巴巴千岛湖数据中心是国内首个采用自然水制冷的数据中心,利用千岛湖深层低温湖水给服务器降温。

阿里巴巴千岛湖数据中心

湖水吸收了服务器产生的热量之后,并不是直接排回千岛湖,因为水温升高有可能对湖中的生态造成一定的伤害。

阿里巴巴的做法是把高温的湖水排进城市的景观人造溪流中,流经2.5公里后也就自然冷却到常温,再排回到千岛湖中,实现了对环境非常友好的循环。

千岛湖数据中心的年平均PUE达到1.3,极限值为1.17,虽然算不上顶尖,但考虑到亚热带的地理环境,这个数据已经是业界翘楚了。

阿里巴巴千岛湖数据中心内部管道

最狠的还是微软,你们要玩水是吗?别整那些污水、景观用水了,我直接把整个数据中心干到海里面。

在2014年,微软就提出了一个水下数据中心的计划,后来命名为“纳蒂克计划”。这个计划的第一阶段是把服务器塞进一个防水的大胶囊里,让它完全浸没在海中,实现真正的“水冷”。

为了实现水下5年无人维护,微软和法国海军集团合作,他们有专业的潜艇制造技术。代号“北岛”数据中心采用了一种用于冷却潜艇的热交换技术,里面容纳了864台服务器,几乎不需要额外使用电力制冷。

微软的大胶囊PUE可以达到惊人的1.07,而且还尽量使用风电、水电等可再生能源。

“北岛”数据中心的访客

除了追求极致的环保,微软也希望“纳蒂克计划”能够快速制造可移动的数据中心,灵活地在沿海城市部署。

不管你是否在乎这些与只在赛博空间与你有联系的服务器和数据中心,散热技术在最近的这几年里实实在在地发生了巨大的改变。

当DIY玩家还追求风力更强更暴力的散热风扇时,商用领域的散热显然走上了另一条路。

CPU本来就是一个性能优良的电烤炉嘛

就像在夏日摇着扇子的贫困户向往能吹着空调的习习凉风入睡,而那些每天生活在被空调包围环境中的都市人,却向往着去偏远山村露营,伴着夜晚的凉风入梦乡。

当我们对一种东西的追求达到极致,反而会回过头寻找最初最自然的状态。

参考资料

你最重要的数据都在这山洞!解密腾讯中国最大数据中心. 雷锋网, 2018.06.01.

王正宇,覃俊霖,黄庆仁,孙创.舱内气压与湿度对器件散热的实验研究[J].中国科技论文,2017,12(23):2662-2665.

郭雪梅. 详解阿里云千岛湖数据中心. CSDN,2015-09-13.

Dan Farber. Facebook turns on data centerat edge of the Arctic Circle. cNet, June 12, 2013 11:30.

CADE METZ. Google Flushes Heat From DataCenter With Toilet Water. 03.15.2012.

John Roach. Under the sea, Microsoft testsa datacenter that’s quick to deploy, could provide internet connectivity foryears. Microsoft, 5 June, 2018.

Shona Ghosh, Photos show how Microsoft tooka big step forward in its crazy plan to power the internet from the sea. Businessinsider, Jun 6, 2018.

本文来自微信公众号:SME科技故事(ID:SMELab),作者:SME