#AI有多智能

2020-08-07 12:00

扫码打开虎嗅APP

c

定睛一看主角是 GPT-3,一下就放心了。

在解释为什么放心之前,我们先聊聊 GPT-3 所代表的语言模型是什么。

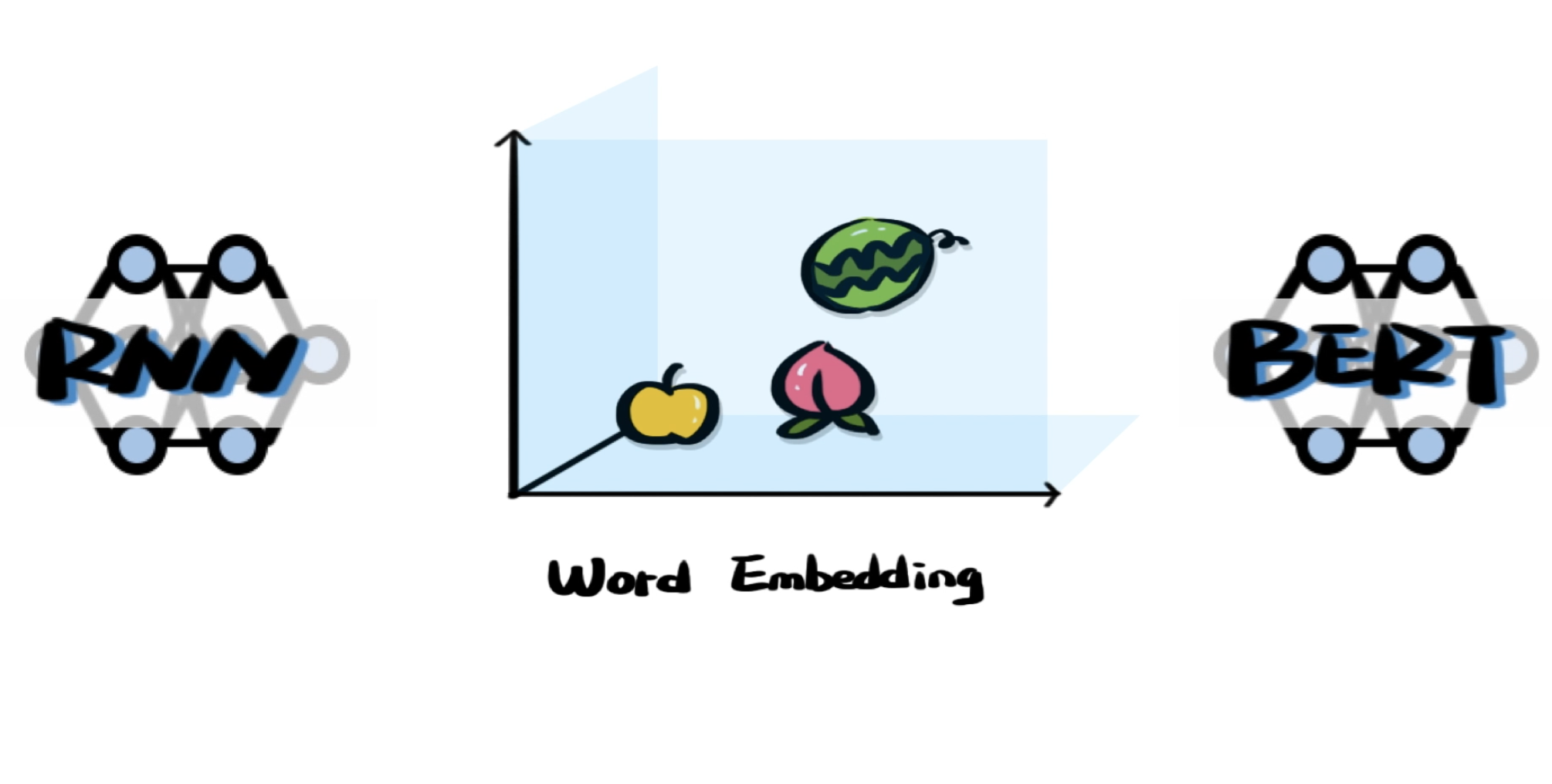

众所周知,计算机是没有办法直接理解人类语言的。最开始我们会将单词表达为向量,但这个方法并不好用。

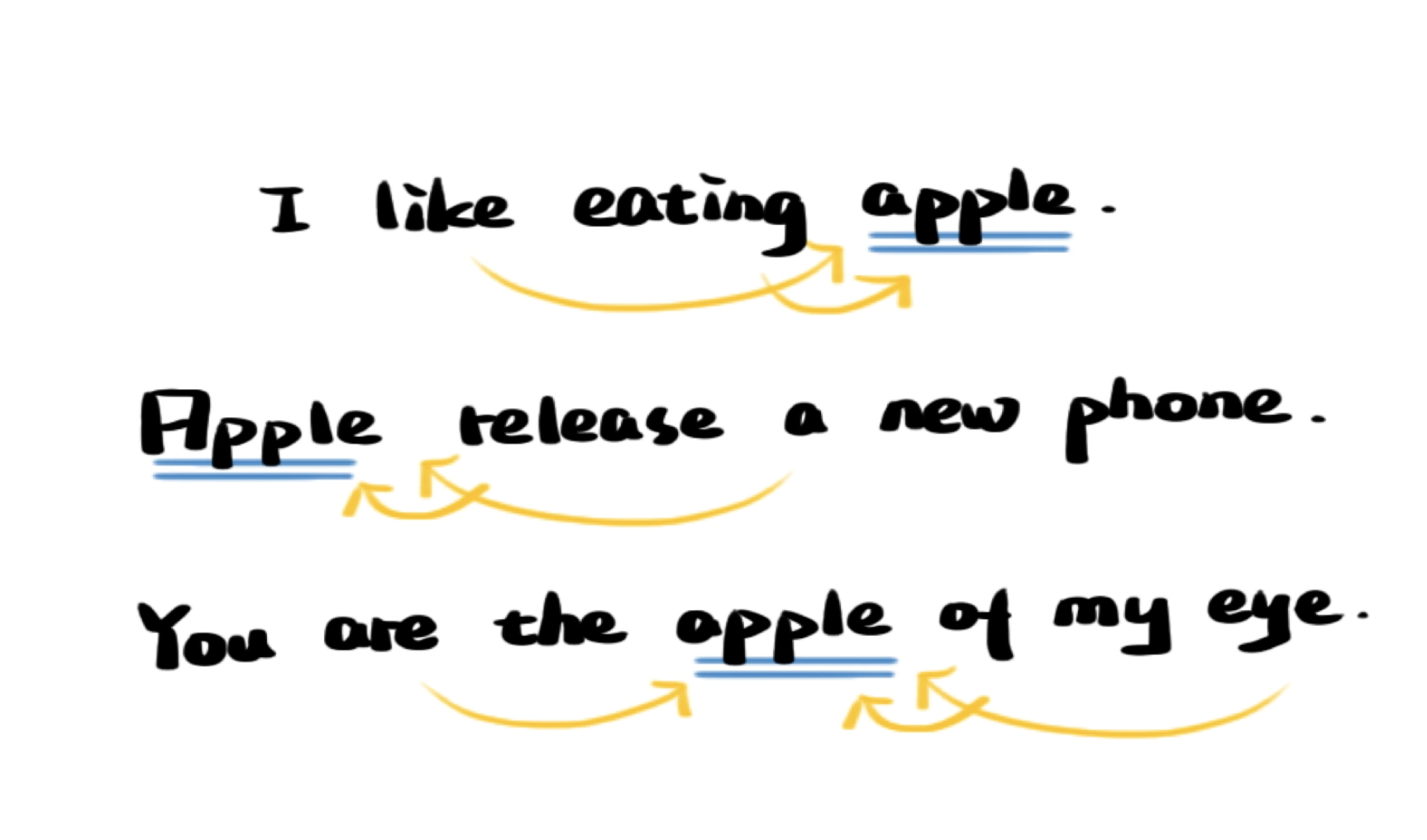

因为语言复杂到像是「活的」,每个单词的含义和语境,也就是附近的单词有很大关系,不将它们之间的关系表示出来,就无法解决实际问题。

于是人们想到将单词表达为空间中的向量,让关系近的词离得近一点,关系远的词离得远一些。

如何确定这些词应该在哪儿呢?总不能一个个去写吧,我们会构建各种各样的模型去学习已有的人类语言语料,帮忙寻找单词的合适位置。

用这种方式理解人类语言,机器就能解决一些实际问题,比如写文章,回答问题,翻译句子,因为这些任务都发生在人类语言内部。

GPT-3 就是这样一个语言模型。又不是没有别的语言模型,为什么火的是它?

因为GPT-3实在是太通用了。此前我们有了语言模型后,还要根据不同需求再训练任务模型,两者共同使用才能解决问题。

GPT-3 不需要,因为它的训练数据和网络实在是太庞大了。

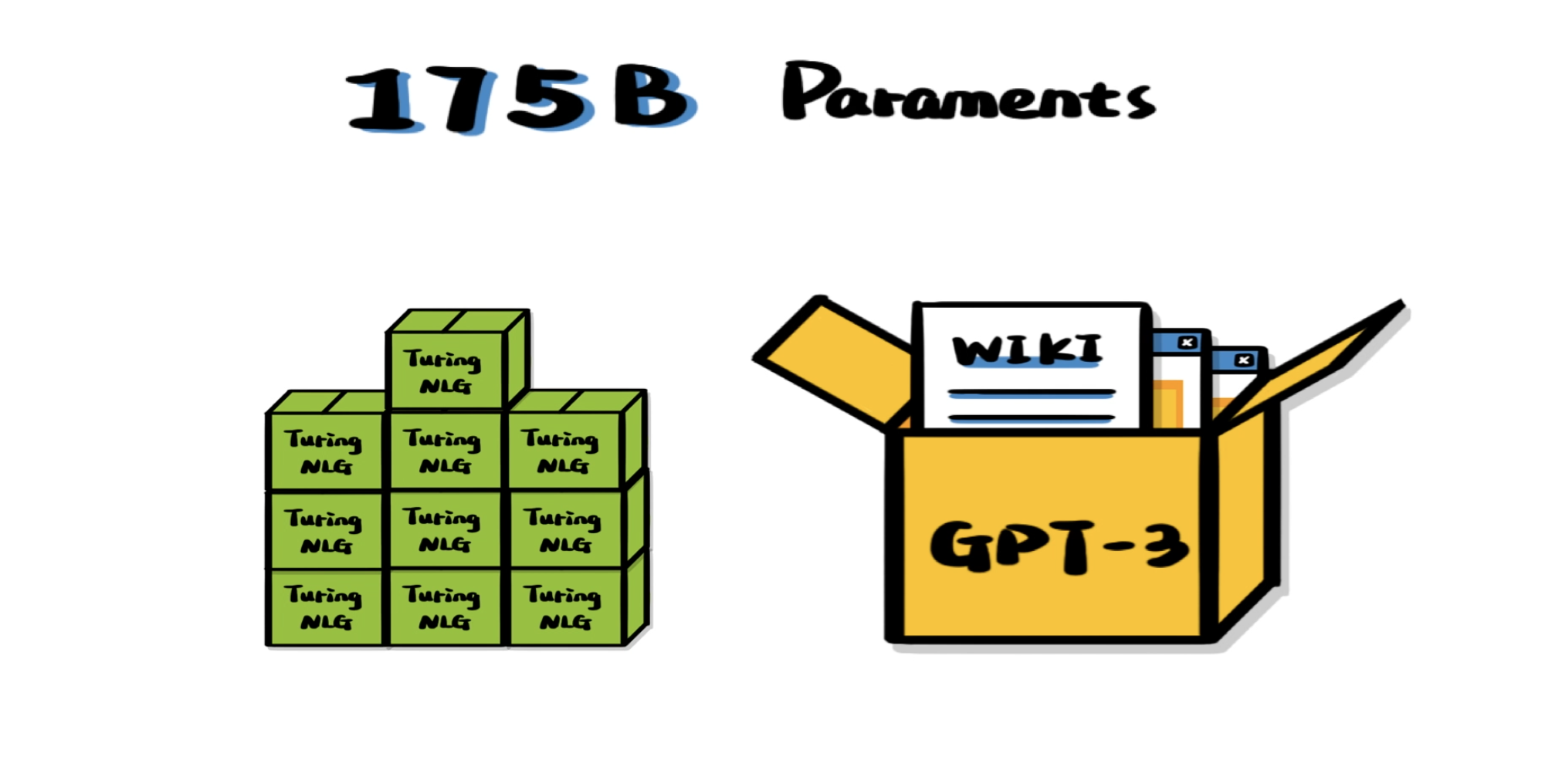

据称英文维基百科的所有内容,只占到 GPT-3 训练数据总规模的 0.6%。同时 GPT-3 有着高达 1750 亿参数,这什么概念,也就比排名第二的模型大个十倍吧。

GPT-3 是我们迈向更通用的语言模型的重要一步,但它真的有智慧吗?不见得,它证明的是也许模型和数据足够大,我们就能创造出超厉害的「工具」。