扫码打开虎嗅APP

本文来自微信公众号:硅星人(ID:guixingren123),作者:光谱、杜晨,编辑:Lianzi,原文标题:《苹果CSAM丑闻再升级:扫描算法存严重缺陷,三年前就在“偷窥”且未告知用户》,头图来自:视觉中国

美国时间8月24日,是缔造了苹果公司辉煌传奇的史蒂夫·乔布斯卸任CEO,将大权交给蒂姆·库克十周年的日子。

十年过去了,苹果的财务表现无比优秀,曾经多年保持着世界上最值钱公司的纪录。然而在名气和财气背后,这几年的苹果,风评却越来越差。就连经常被拿来自我吹捧的隐私,苹果在这方面的种种表现,都越来越令人难以相信:这居然是苹果能干的出来的事?

8月初,硅星人写了一篇文章《苹果要偷看你手机电脑上的照片了》,说的是当时苹果被业界人士曝出(随后很快官方承认)的一项争议性极高的新举措:对用户手机上保存的照片,以及通过iMessage发布、上传到iCloud的图片进行审核,从而识别儿童色情和虐待内容(CSAM),打击其传播。

注意,我们在说的可是苹果——号称最注重用户个人隐私的苹果。而现在,苹果就这样堂而皇之地摇身一变,成了一家随时随地都要“偷看”你照片的公司。

自从这项新政宣布以来,对苹果不利的情况接连发生,使得CSAM扫描事件不断升级,目前已经基本达到可以称之为“丑闻”的程度了。

算法漏洞浮现

首先来个快速前情提要:

美国时间8月5日,约翰霍普金斯大学加密学教授Matthew Green曝光苹果将推出一项用于检测CSAM的技术。这项技术名为NeuralHash,基本上就是在用户手机本地和iCloud/苹果服务器云端,用算法对用户图片和一个第三方CSAM数据库进行哈希值比对。一旦比对成功,苹果就会屏蔽这张照片,并且不排除后续还会进行报警或通知青少年家长之类的操作。

这件事被曝出后,硅星人已经进行了详细报道,并点评了这项技术存在的一些应用层面的问题,主要有两点:

1. 所谓只打击CSAM的技术,无法从技术上被限制只针对CSAM,因为下面一点。

2. 此类工具已经在技术上被攻破,使得两张完全不同的照片,可以实现哈希碰撞(也即拥有相同的哈希值)。

自那之后,这项CSAM技术又被曝出新的情况,使得丑闻再度升级。

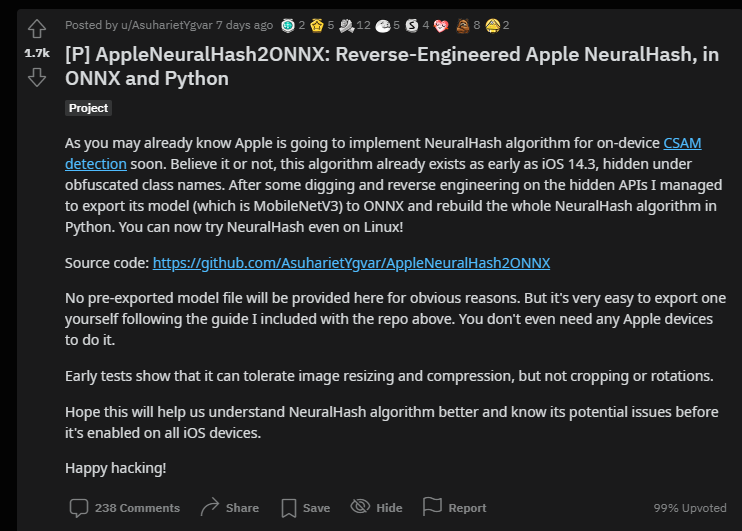

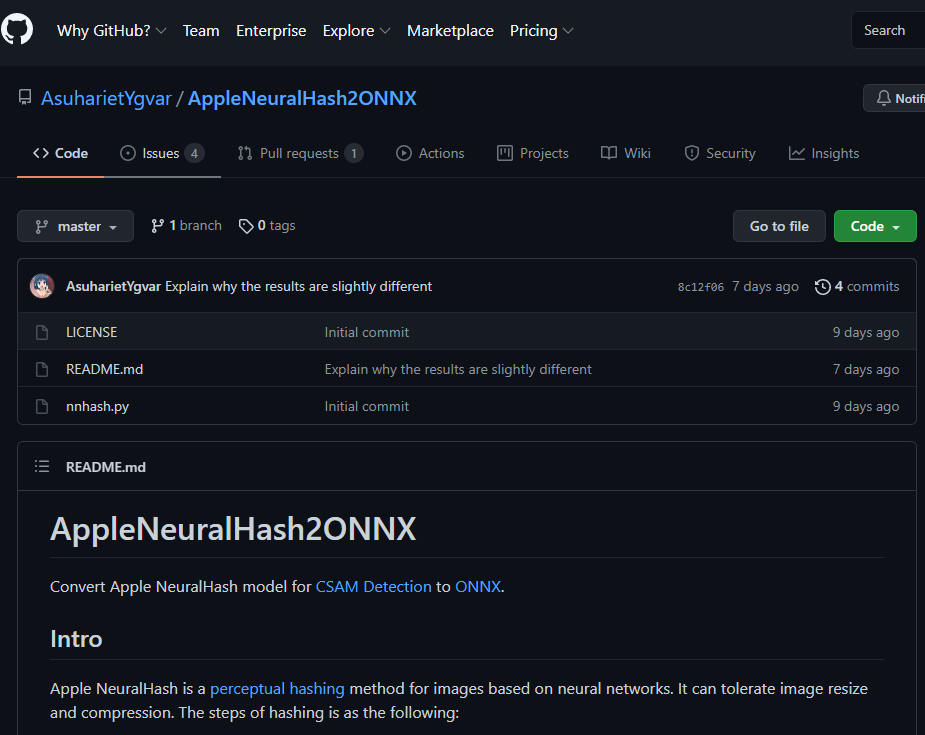

机器学习研究者Asuhariet Ygvar发现,NeuralHash算法早在iOS 14.3版本就已经植入到iPhone的操作系统里了,并且苹果还故意混淆了其API命名。(而此前苹果在CSAM技术的官网页面上宣称,这项技术是新的,计划在iOS 15和macOS Monterey正式版推出时才启动。)

Ygvar通过逆向工程的方法,成功导出了NeuralHash算法并且将其重新打包为Python可执行。这位研究者还在GitHub上提供了导出方法,让其它数据安全人士可以对NeuralHash进行更深的探索研究:

(这位研究者没有提供导出后的成品算法,显然是为了避免遭到苹果的知识产权诉讼,这一点稍后会详述。)

算法链接:https://github.com/AsuharietYgvar/AppleNeuralHash2ONNX

Ygvar自己做的早期测试显示,NeuralHash算法对于图片尺寸和压缩调整的抗性较好。但如果图片进行了切割或者旋转,NeuralHash就不好用了。这表明,NeuralHash算法投入到CSAM检测的实际效果可能会打折。

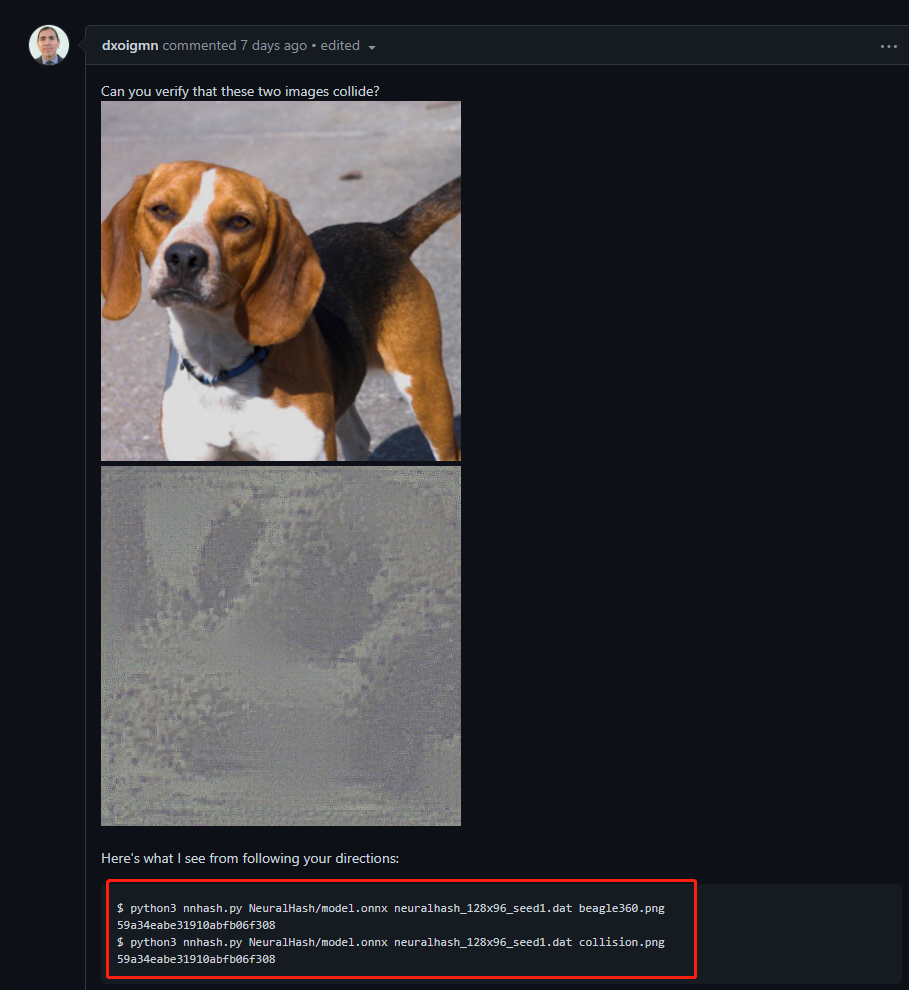

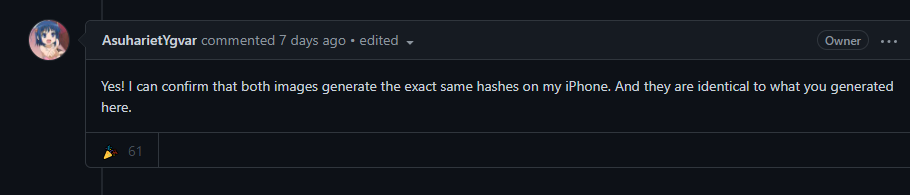

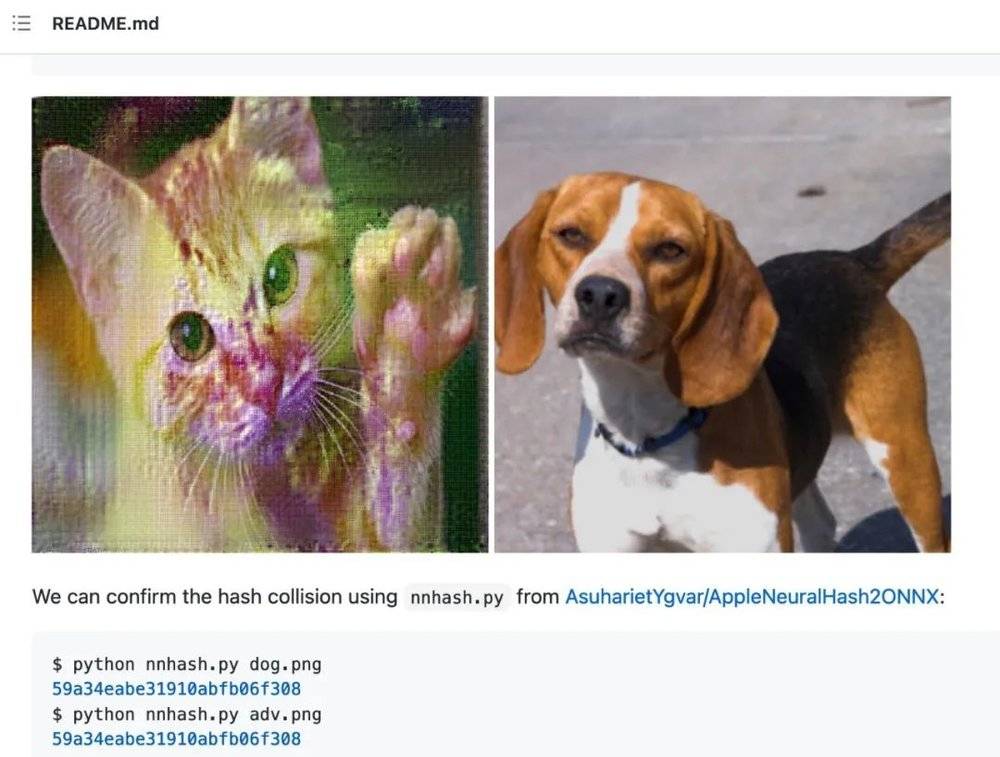

不出意外,很快就有人实现了对于NeuralHash算法的哈希值碰撞。位于波特兰的安全研究员Cory Cornelius发布了一张比格犬照片和另一张灰色乱码图片。这两张看起来毫无关联的图片,通过NeuralHash算法计算出的哈希值居然是一模一样的。

紧接着,最早发布了模型导出方法的Ygvar,也复现了这次碰撞:

这条GitHub留言下方,有人进一步指出,Cornelius发现的情况,其实比碰撞更严重,已经属于原像攻击(pre-image)的范畴了。

简单来说,哈希碰撞就是找到两张哈希值相同的随机照片,而原像攻击,你可以将其理解为“刻意生成的碰撞”,也即先给定一张照片,然后生成另一张和其哈希值相同,但内容不同的照片。

紧接着,更多开发者也用同一张照片实现了更多的碰撞:

甚至,有人在ImageNet(一个备受机器学习人士欢迎,适用范围超级广的标注图片数据库)里,都能找到天然的NeuralHash “双胞胎”。

ImageNet里的一张钉子照片和一张滑雪板照片,NeuralHash算出的哈希值相同。另一张斧子的照片和线虫的图片,也是天然的NeuralHash哈希值“双胞胎”。

对NeuralHash算法实现原像攻击,以及天然哈希值双胞胎的存在,进一步表明:苹果打算大规模推广的这个CSAM识别算法,存在远比人们想象更严重的,有可能被滥用的缺陷。

以下是一种可能性:

你在网上跟某人结仇,他想要报复你。于是他去找了一张CSAM照片,然后生成了几张看起来人畜无害,但是跟原始照片哈希值相同的图片,发了过来。你的手机将它们识别成了CSAM,你被举报了,警察上门了,那人得逞了。

没错,我们完全不需要“设身处地”,把自己当作一个可能传播色情内容的人。每一个普通人都完全有可能成为技术滥用或是错误使用的受害者。如果今天被滥用的是NeuralHash,而对象碰巧是你,那你的名誉将可能变得不堪一击。

研究者Brad Dwyer表示,尽管上述漏洞存在,目前的早期测试似乎表明,哈希碰撞的发生率和苹果宣称的误报率在相似水平。

但是,Dwyer也强调,苹果目前在全球拥有超过15亿用户。这意味着NeuralHash一旦出现误报,会对很大数量的用户造成负面影响。

瞒天过海、封口威胁

硅星人的读者可能还记得,前段时间我们写过Epic Games和苹果的诉讼,和这两家公司因为“苹果税”、应用商城政策等问题而结下的梁子。

这桩案子其实是Epic Games挑起的针对苹果的一场注定旷日持久的反垄断战争,话题也是完全“不设限”。所以在证据采集的阶段,Epic Games这边的律师也搜集了大量跟案件原本话题有关或无关的资料,其中有很多都是苹果内部的高度机密资料。

也是在昨天,这桩诉讼再次曝出一条和苹果CSAM扫描丑闻有关的猛料:

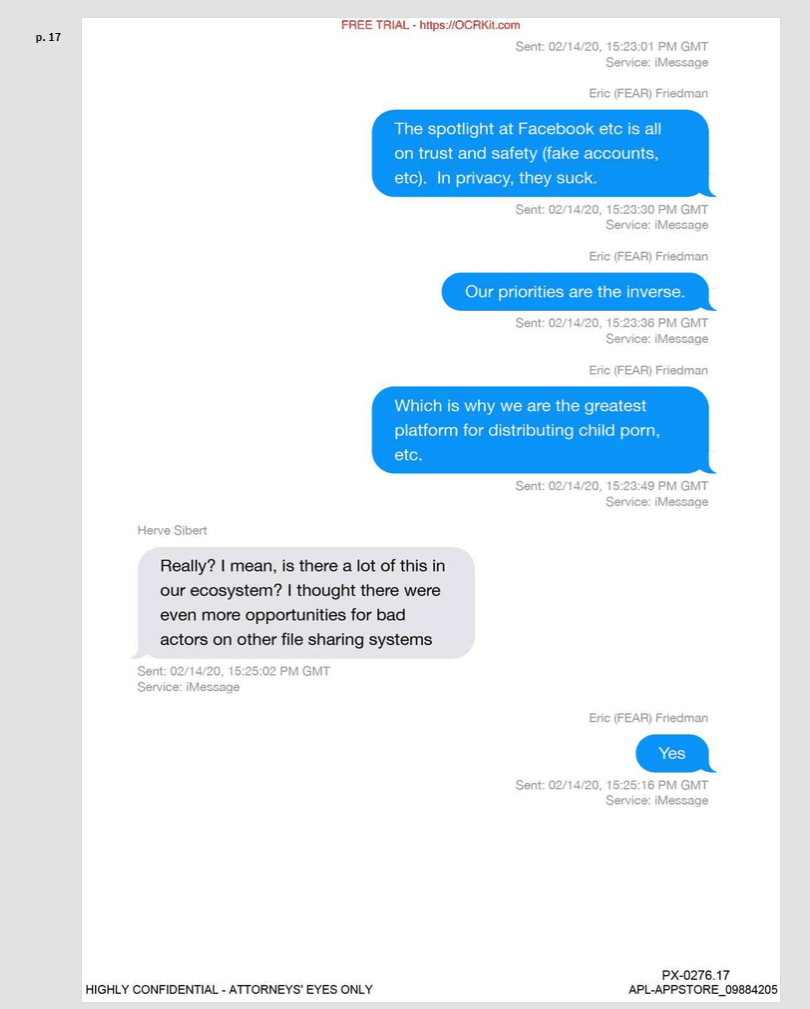

苹果反欺诈技术部门“FEAR”(Fraud Engineering Algorithms and Risk)的老大Eric Friedman在2020年和同事的一段iMessage聊天当中是这样说的:“我们(苹果)是全世界最大的儿童色情内容分发平台。”

这当然是一句带有讽刺调侃意味的发言。Friedman实际表达的是,由于苹果的隐私安全设计,更多不法分子选择苹果通讯产品传播这些内容。

从表面上来看,这句话似乎是这位工作内容包括打击儿童色情内容的苹果高管在用一种苦涩讽刺的方式,来证明苹果为什么要做这件事。

但是结合今天关于CSAM已经讨论的情况,不禁令人感到细思极恐:苹果又是怎么知道自己平台上有如此多的儿童色情内容,以至于这位高管可以在2020年就下如此断言呢?难道苹果在此之前已经在扫描用户的设备和iCloud账户了吗?

一些人开始猜测,这家公司早就在私下扫描了。

在这条证据通过诉讼公开之后,苹果发言人回应9to5Mac记者质询时表示:我们从2019年就已经开始扫描用户的iCloud账户了。(这个时间,比刚才提到包含了NeuralHash算法的iOS 14.3版本的发布时间,又早了整整整整一年。)

具体来说,苹果扫描的是用户的iCloud Mail,也即用户注册iCloud账户时得到的那个@iCloud.com后缀的登录电子邮箱。

同时苹果还表示,也在对一些“其它数据”进行同样的扫描,但拒绝透露具体是哪些数据。该公司宣称,从未扫描过用户的iCloud Photos(云端相片存储,iOS默认开启的功能)。

截图来自 9to5Mac 报道此事件的文章

更令人费解的是,苹果号称将用户数据隐私至于无上地位,时不时也会用这套说辞去攻击贬低其它竞争对手(比如 Facebook),却从未以足够清晰的方式向用户告知过它也在扫描用户隐私数据的情况。

它号称珍惜用户的忠诚,所以重视用户的数据隐私,但现在我们看的越来越清楚,“保护用户隐私”更像是它采用的一种宣传口径。

苹果当然想要瞒天过海。但当一切再也瞒不住了的时候,它也会不惜通过各种手段去封住别人的口,阻挠第三方揭露它的问题。这一点,没有任何人比Corellium感受的更加深刻。

简单来说,常规渠道销售的iPhone有一套非常复杂的用户协议。如果安全研究人士如果要深度分析破解它(且未获得苹果的专门许可),这样的行为就会违反协议。而Corellium这家公司提供一种“虚拟化ARM架构设备”的服务,包括iOS和Android设备,让研究人士可以在电脑上对ARM架构的系统和软件安全性进行研究,而无需购买实体的手机。

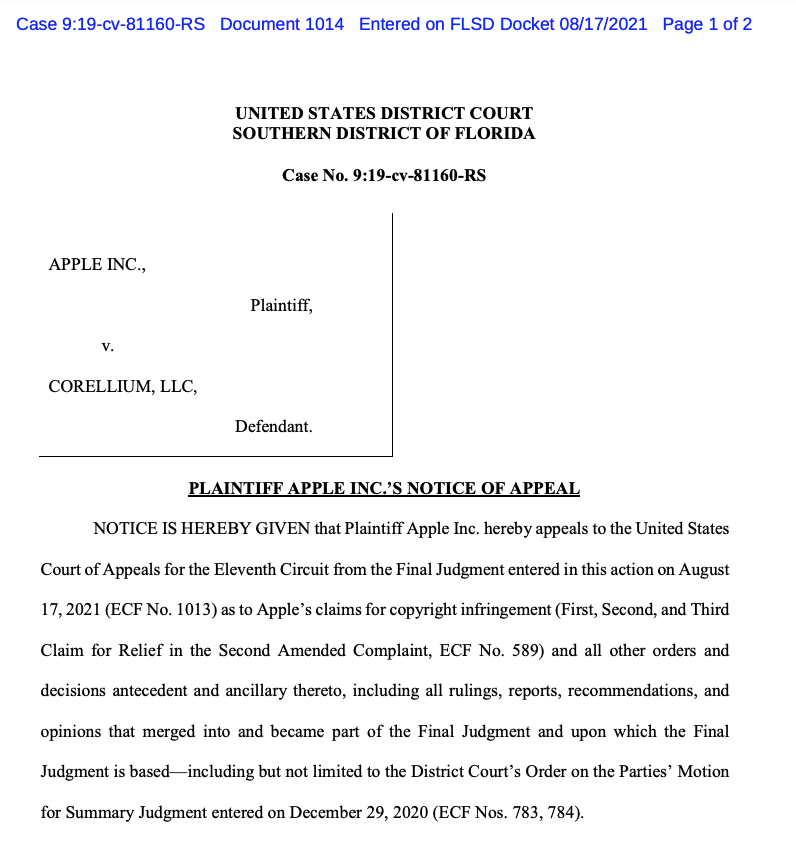

于是在2019年,苹果以违反数字千年版权法为由起诉了Corellium。一开始外界担心,考虑到苹果强大的法务力量,这个案子的走向最终可能会对安全行业不利。好在去年12月,主审案子的法官下达了一个初步裁决,确定Corellium的商业行为并不构成侵犯版权。

今年8月10日,原定开庭日期的一周前,苹果和Corellium突然达成了庭外和解。

这次和解还有一个更加微妙的细节:它发生在苹果正式宣布CSAM扫描,并且引发科技行业史无前例般巨大争议的几天之后。

很明显,苹果不希望在这个尴尬的时间点上,这桩悬而未决且对自己不利的案子被行业人士和公众当作它跟安全行业作对的证据。毕竟,在苹果官网CSAM的介绍页面上也有提到,苹果也在和第三方安全专家就NeuralHash的有效性和安全性展开合作。苹果软件SVP Craig Federighi接受采访时也表示,欢迎安全专家对CSAM/NeuralHash进行检验。

谁曾想到,这边刚跟苹果和解,几天后,Corellium就又“欠招”了。

8月17日,Corellium四周年的这一天,该公司发起了一个“开放安全计划”,招募安全研究人员,向最优秀的三组申请者提供每组5000美元拨款,以及长达一年的Corellium技术工具免费使用权限。

截图来源:Corellium 网站

截图来源:Corellium 网站

这项计划的主题是“验证设备厂商的安全宣传”。而这个厂商是谁也就不用猜了……

截图来源:Corellium 网站

“我们赞赏苹果公司做出的承诺,允许第三方研究人员对其问责。我们也相信,我们的平台非常适合帮助研究者实现这个目标。”Corellium公司在官网上写道。

这一举动再次激怒了苹果。可能苹果太愤怒了,以至于它的法务团队已经不按套路出牌了……

在Corellium宣布这一计划的第二天,苹果撕毁了之前达成的和解,就去年12月法院下达的“Coreelium行为不构成侵犯版权”的裁决,重新提交了上诉。

现在你应该能理解,为什么本文前一小节提到的那个逆向工程了NeuralHash的开发者,只是提供了破解提取方法,没有把提取出来的算法做成下载链接了。

毕竟,这世界上可能没有人想要被苹果告侵犯版权啊……

本文来自微信公众号:硅星人(ID:guixingren123),作者:光谱、杜晨,编辑:Lianzi