扫码打开虎嗅APP

本文来自微信公众号:新智元,作者:新智元,编辑:桃子、好困,题图来自:视觉中国

大模型是一条死路,无法通往AGI!

在今天的最新一期深度访谈中,LeCun直言不讳指出:

所谓的ASI路线——不断训练LLM,用更多合成数据喂模型,雇上几千人在后训练阶段“管教”系统,再折腾出一些RL的新技巧。

在我看来,完全是胡说八道!

这条路根本行不通,而且永远都不可能成功。

任职12年,即将暴走Meta的65岁图灵奖得主,在公众场合的观点愈加偏激了。

这场近2小时的对谈中,LeCun的观点一针见血:

硅谷对不断“堆大”LLM的痴迷是一条死路;

搞AI最难的问题在于,它依旧是“阿猫阿狗”的智能,而非类人的水平。

如今,他正把一生的学术声誉押注在一条截然不同的AI路线之上,即“世界模型”。

访谈中,LeCun还分享了创业公司AMI(Advanced Machine Intelligence)正在构建的“世界模型”:

在抽象表征空间中进行预测,而不是简单地像素级输出。

几天前,LeCun在与谷歌DeepMind大佬Adam Brown的一场激辩中,同样提出他的经典论点:

LLM没那么聪明,毕竟一只猫或一个孩子仅用少得多的数据就能理解世界。

Token预测全是泡沫,物理世界才是真相。

有网友辣评道,“Meta在AI领域失败,LeCun是罪魁祸首”。

还有人表示,“LeCun很聪明,在Meta保持沉默现在开始发声了”。

65岁创业,再造一个FAIR

播客开场,主持人问道,“从Meta这样的大公司跳出来,从0起步,是什么感觉”?

LeCun坦言,虽然他此前也参与过创业,但这次的AMI意义非凡。这次的独特之处在于一种新现象,即投资者也愿意为其买单。

这要是放在以往,是不可能的。

历史上,像贝尔、IBM、施乐PARC这样的大实验室,都一同垄断了企业的财力。

如今,行业风向正在转变。FAIR通过开源推动了生态的发展,但近年来越来越多实验室选择闭源,OpenAI、谷歌,甚至Meta也不例外。

在LeCun看来,这种闭源趋势,不利于真正突破性的研究。

因此,他决定在Meta外部创办AMI,专注于“世界模型”,并计划延续开放研究的传统。

除非你把论文发表出来,否则就不能称之为真正的研究。要不然,你很容易陷入一种自欺欺人的状态。

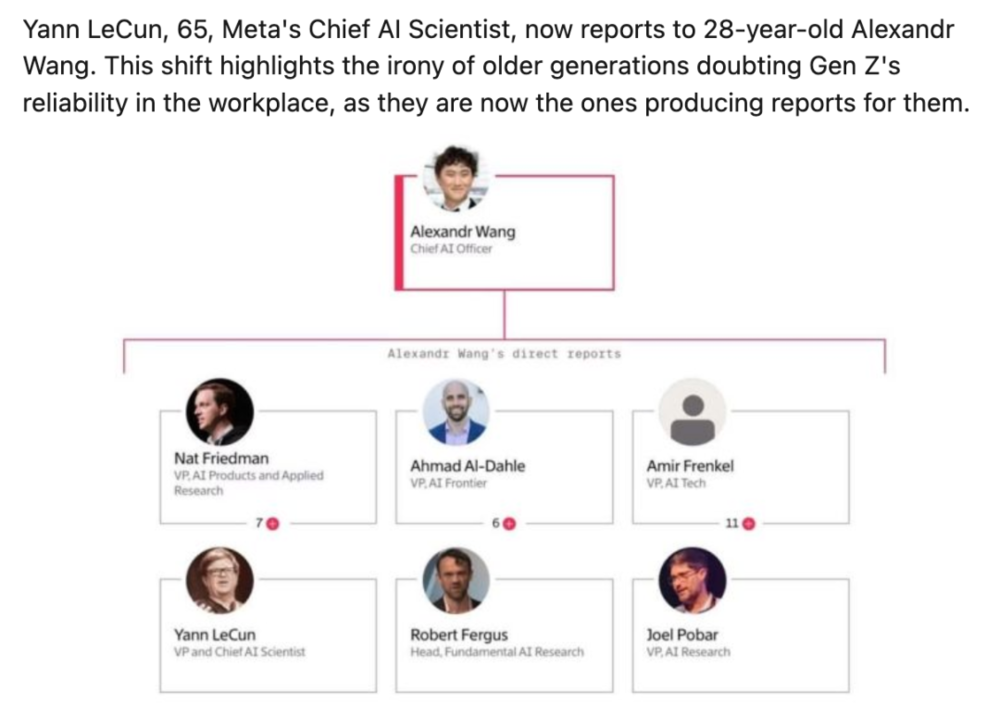

看得出,LeCun这番言论一定程度上,暗示28岁上司Alexandr Wang的做法:

此前曾爆出,FAIR实验室想要发论文,必须经过MSL批准后才可以。

LeCun再次强调,“如果真的想要突破,需要让你的员工发表论文。没有别的办法。这是目前很多行业正在遗忘的事情”。

下一步,AMI的目标不仅是研究,还会打造实际的产品,比如与世界模型、规划有关的,并成为智能系统的核心供应商。

接下来的话题,又回到了LeCun老生常谈的事情。

LeCun放话:LLM走不通

他明确表示,当前的LLM或基于LLM的AI智能体,处理语言尚可,但在可靠性、数据效率、多模态处理上远远不足。

我已经说了快十年了,世界模型才是解决这一问题的“正确方法”。

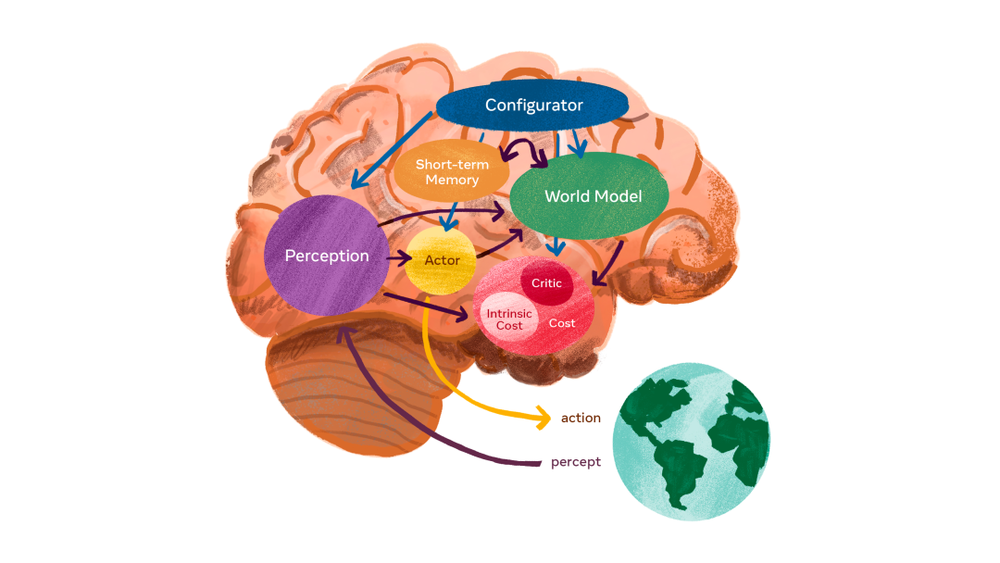

“世界模型”能够预测一个动作或一系列动作的后果,然后系统通过优化得出一系列动作,即找出哪一系列动作能最好地完成设定的任务,这就是“规划”。

因此,LeCun认为,智能的一个重要部分是能够预测行动的后果,然后将其用于规划。

“世界模型”是设计用来处理,高维、连续和嘈杂的模态数据,LLM完全不行。

真正有效的方法是,学习一个抽象的表示空间,消除关于输入的不可预测的细节,并在表示空间中进行预测。

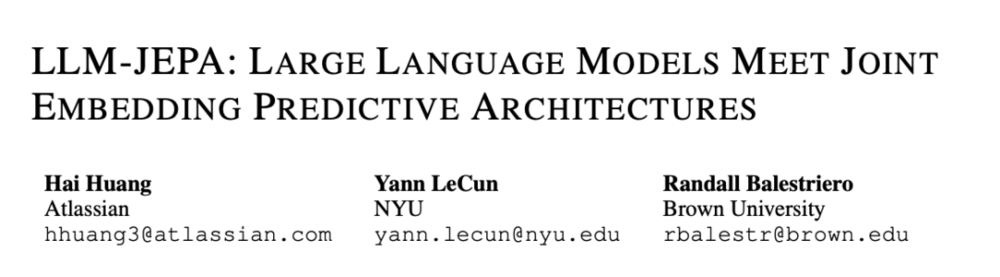

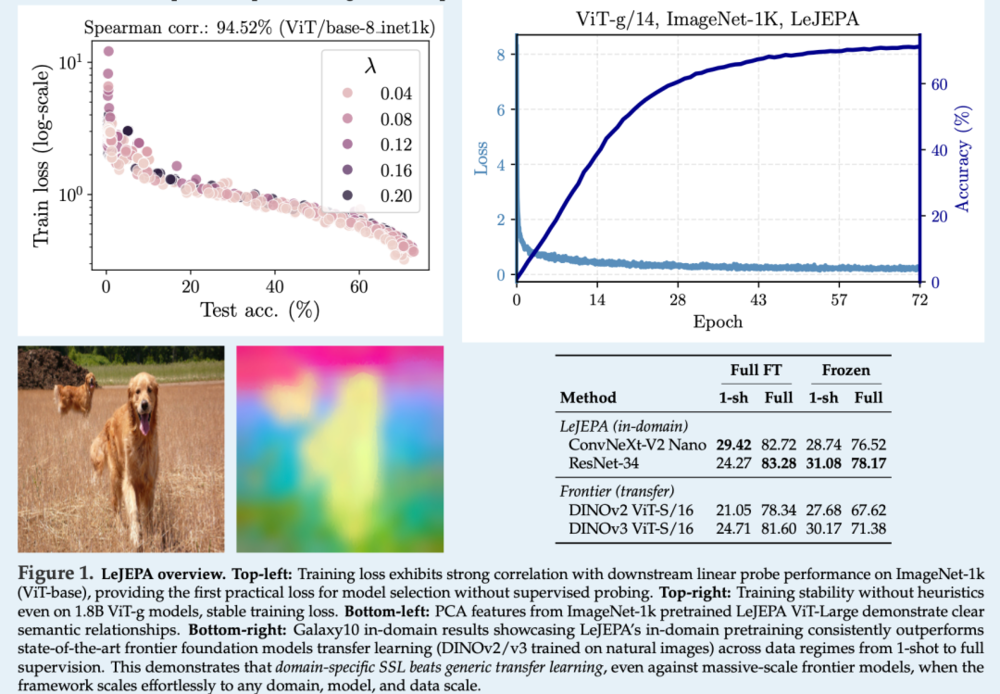

这就是, JEPA(联合嵌入预测架构)的想法。

论文地址:https://arxiv.org/pdf/2509.14252

将近有20年的时间,LeCun一直确信,构建智能系统的正确途径是通过某种形式的“无监督学习”。

他回顾了自己的研究历程:

早在2000年代初中期,便开始探索无监督学习,并尝试通过自编码器(Autoencoders)来学习表示,但发现表示包含关于输入的所有信息是个错误。

后来,他意识到需要“信息瓶颈”(Information Bottleneck),限制表示的信息量。

2015年,ResNet(残差网络)出世,彻底解决了深层网络架构训练问题,也是从这时起,LeCun开始重新思考:

如何推动实现人类水平的AI?

他意识到,强化学习等方法,基本上无法scaling,且样本效率极低,于是开始聚焦“世界模型”。

最初尝试,他在像素级预测视频,但发现这行不通,真正的突破在于表示层(Representation Level)进行预测。

JEPA的发展克服了早期孪生网络(Siamese Networks)的模型坍塌(Collapse)的问题,通过Barlow Twins、VICReg优化表示空间。

最近的Latent Euclidean JEPA,进一步推进了这一思路。

论文地址:https://arxiv.org/pdf/2511.08544

对于LLM局限背后的原因,LeCun分享了数据质量方面的“苦涩的教训”(Bitter Lesson)。

训出一个性能还不错的LLM,需要互联网上大约30万亿Token(约10^14字节)的文本数据。

LLM需要巨大的内存,来存储这些孤立的事实。

相较之下,这仅相当于大约15,000小时的视频——YouTube上30分钟的上传量。

一个4岁孩子醒着时看到的视觉信息,大约是16,000小时。

去年发布的V-JEPA 2模型,就是在相当于一个世纪时长视频数据上训练的,虽然字节数更多,但视频数据的冗余性正是自监督学习所需的。

现实世界数据的结构比文本丰富得多,这也是为什么LeCun坚称,只靠文本训练永远无法达到人类水平的AI。

关于理想化的“世界模型”,LeCun回应了主持人对《星际迷航》全息甲板(Holodeck)的比喻:

人们误以为,“世界模型”必须重现世界所有的细节,这不仅错误,还会有害。

“世界模型”是在抽象表示空间中的模拟器,只模拟现实中相关的部分。

不仅如此,LeCun相信合成数据很有用。但有些基本概念是我们通过经验习得的,而不是天生的。

然而,LLM并不真正理解这些,只是被微调出来给出正确答案,更像是“反刍”而非真懂。

炮轰硅谷单一文化

针对硅谷LLM狂热的文化,LeCun的批评尤为尖锐。

他指出,AI行业存在一种危险的“羊群效应”:

竞争太过激烈,大家都害怕走偏路线而落后,于是OpenAI、谷歌、Meta、Anthropic等科技巨头几乎都在做同一件事。

那便是,疯狂堆叠LLM。

这导致,硅谷形成了“单一的文化”,甚至这背后多少带着点优越感。

LeCun警告,一旦深陷“战壕”,就只能拼命往前冲,因为谁也承担不起被竞争对手甩开的风险。

但更大的风险是,被完全不同方向、出乎意料的一套技术颠覆,它甚至可能解决完全不同的问题。

JEPA的理念,即所谓的“世界模型”,恰恰与这条主流路线完全不同,能处理LLM很难应付的数据。

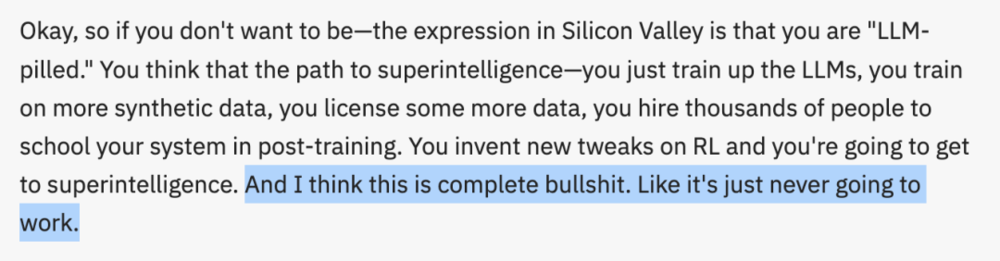

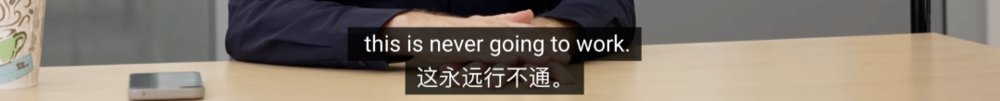

LeCun甚至毫不客气地说:

如果你不想变成硅谷口中“被LLM洗脑了”(LLM-pilled)的人,便不会相信这样一条路径:

只要不停地训练LLM,用更多合成数据,去授权更多数据,再雇上成千上万的人来做后训练,在强化学习(RL)上不断加点新花样,你就能一路走到ASI。

我认为这完全是扯淡,这条路根本不可能成功!

“没错,你必须逃离那种文化”。

他还透露,即使在硅谷的各家公司内部,也有不少人心里很清楚:这条路走不通!

因此,摆脱这种单一文化,正是LeCun创办AMI的动因之一。

他透露,AMI这家公司是全球性的,总部将设在巴黎,其全球其他几个地方,包括纽约设立分办公室。

AGI是胡扯,“类人AI”还需5~10年

当被问及AGI时间线,LeCun先澄清:不存在“通用智能”这种东西!

这个概念完全没有意义,因为它是被设计用来指代人类水平的智能,但人类智能是超级专业化的。

所以AGI这个概念完全是胡扯。

话又说回来,他还是认为,我们会拥有在所有领域都和人类一样好或更好的机器。

“但这不会是一个单一事件,这将是非常渐进的”。

他乐观地预测道,如果未来两年,能在JEPA、世界模型、规划等方向取得重大进展。

我们可能在5~10年内,看到接近人类智能,也许是狗的智能水平的AI。

但这已是极度乐观。

更现实的是,AI历史上多次出现未预见的障碍,需要我们发明新概念实现超越。

那可能需要20年,甚至更久。

有趣的是,LeCun认为最难的部分不是从狗到人类,而是达到狗的水平:

一旦你达到了狗的水平AI,你基本上就拥有了大部分要素。

从灵长类动物到人类,除了大脑的大小差异之外,还缺的是“语言”。

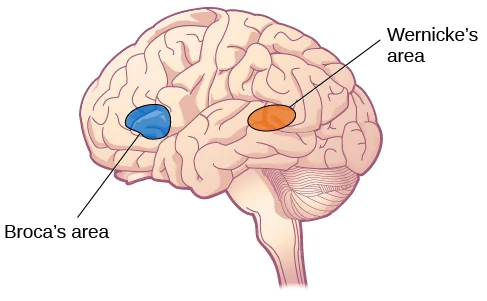

语言基本上由韦尼克区(Wernicke area)以及布罗卡区(Broca area)处理。

而LLM已经在语言编码/解码上表现不错,或许能充当大脑的韦尼克区和布罗卡区。

LeCun称,我们现在正在研究的是前额叶皮层,那是“世界模型”所在的地方。

离职Meta,三周倒计时

访谈中,LeCun还谈及了Meta AI的重组。

他表示,Alexandr Wang并非接替他的位置,而是统管Meta所有AI相关研发和产品,包括四个主要部门:

FAIR(长期研究)

GenAI Lab(专注前沿LLM构建)

AI基础设施

模型转化为实际产品的部门

重磅的是,LeCun透露,自己将在Meta再待三个星期。(估计1月初,正式告别Meta了)

FAIR现在由纽约大学Rob Fergus领导,正被推向“更短期的项目”:

较少强调发表论文,更多专注于协助GenAI Lab进行LLM和前沿模型的研究。

GenAI Lab也有一个首席科学家,专注于LLM,其他组织更像是基础设施和产品。

看得出,Meta重组重心完全放在了LLM,这也是LeCun选择出来创业的部分原因。

此外,LeCun还点评了一些大模型公司,包括SSI、Physical Intelligence、Thinking Machines等。

Ilya创立的SSI,甚至包括他们的投资人,都不知道这家公司要做什么。

给年轻人的建议:别学CS

访谈的最后,主持人问道,“如果你今天重新开始AI职业生涯,会专注哪些技能和方向”?

LeCun的回答直击要害,学习那些“保质期长”(long shelf life)的知识,以及能让你“学会如何学习”的东西。

因为技术演变得太快了,你需要具备快速学习的能力。

他开玩笑地说,“保质期长的东西,往往不是计算机科学”。

所以,作为一个计算机科学教授,我劝大家别学计算机科学。

不过,LeCun还是给出了一些具体的建议,其中包括:

深入学习数学(微积分、线性代数、概率论)、建模基础,尤其是能与现实世界联系的数学(工程学科中常见);

电气工程、机械工程等传统工程专业,能提供控制理论、信号处理、优化等对AI极有用的工具;

物理学也是绝佳选择:物理学的核心就是“如何表征现实以建立预测模型”——这正是智能的本质;

计算机科学只需学到能熟练编程和使用计算机的程度(即使未来AI写代码,你仍需懂底层);

别忘了学点哲学。

LeCun强调,这些基础能让你在AI快速变化中始终站稳脚跟,而不是被短期热点牵着鼻子走。

参考资料:

https://x.com/ziv_ravid/status/2000654377258745912?s=20

https://www.the-information-bottleneck.com/ep20-yann-lecun/

https://youtu.be/ykfQD1_WPBQ

本文来自微信公众号:新智元,作者:新智元,编辑:桃子、好困