扫码打开虎嗅APP

题图来自:视觉中国

什么是意识?如何产生意识?

这个困扰了人类几千年的问题,此前似乎只属于哲学家和诗人的讨论范畴,但在今天已经越来越成为人工智能创业者们必须面对的问题。

从谷歌程序员惊呼AI觉醒,到舆论对人工智能绘画的热议——这个2022年的年末,一场关于AI的全民大讨论再度开启,机器意识的“奇点”似乎又一次在向我们招手。

本期险峰聊聊,我们请到了心识宇宙的创始人陶芳波博士,大家一起聊聊机器意识,聊聊AI的现状和未来。

一、什么是意识?如何产生?

被誉为“最硬核AI题材科幻作品”的《西部世界》,给出了这样一种猜想。

剧中,土豪们建立了一座类似元宇宙的主题乐园,同时创造了一群AI仿生人作为NPC接待员,游客们每天从外面的世界来园区,在仿生人的陪伴下完成各种剧情路线的沉浸式体验,以满足人类最底层的欲望和感官刺激。

然而,既然乐园的最大乐趣在于游客可以“为所欲为”,自然也就没人会遵守原定的故事线,但AI的程序是已经设定好的,面对游客越来越多超出预设的“随机行为”,大量bug也随之出现。

最终,一位名叫德洛丽丝的AI接待员成功“觉醒”,产生了自主意识,后续的剧情也由此展开。

整个《西部世界》的故事构架,都源于一个著名心理学概念——二分心智(Bicameralism)。

简单来说,它假设人的大脑分为AB两个部分:一半大脑的A部分储藏的记忆和经验,另一半B则主管行为。

直觉上,我们会认为“意识”先于A侧脑区产生,然后下达指令驱动B侧大脑做出动作。

然而在“二分心智”理论看来,事实却并非如此。

举个例子,一些癫痫病人在切除了连接左右脑的部分组织后, 病情虽会缓解, 但也会出现一些奇怪的症状。

比如,当接受到一个“微笑”指令的时候,病人会按照医生的要求微笑,但当问起他为什么微笑,病人却会给出一些其他的理由,比如“我觉得医生的眼镜很好笑”,或者“我今天很高兴”之类。

换言之,他并不会认为自己是被要求微笑才微笑——这说明人脑其实是在身体做出某个动作之后,才会“编出”一个故事对自身行为合理化。因此,意识的产生不仅先于行为,也同样先于逻辑与思考。

究其原因,人类大脑进化其实是一个不断叠加的过程。

最先形成的是脑干(爬虫脑),负责心跳呼吸这些最原始的生理活动;其次进化出的是小脑(旧脑),也叫边缘系统,包括海马回、杏仁核、丘脑等;最后产生的才是处理逻辑、语言与记忆的大脑皮质(即新脑或认知脑)。

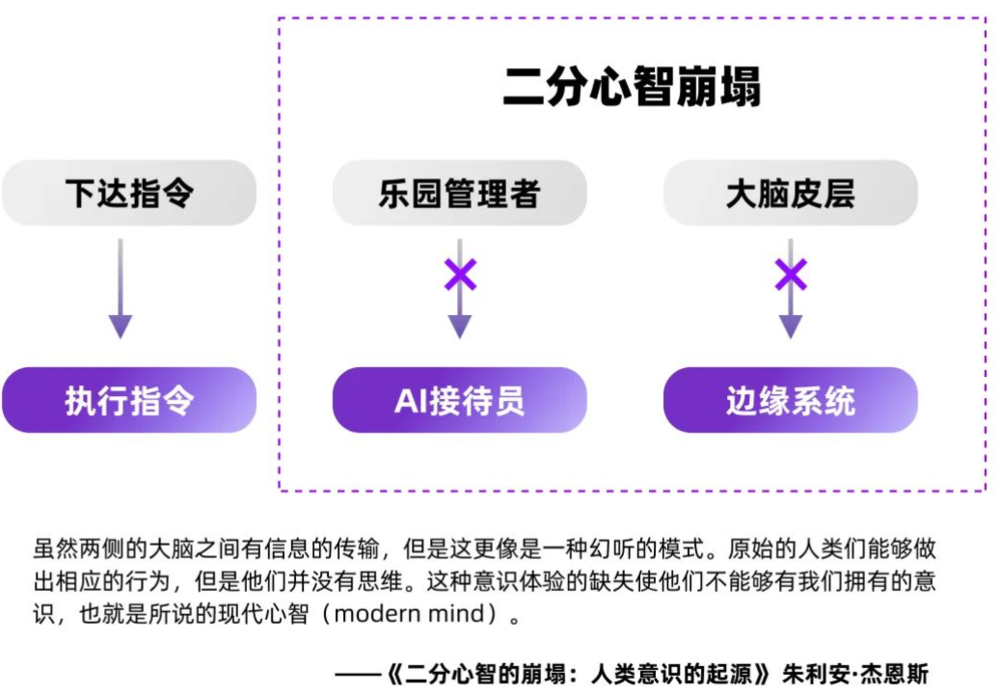

因此,二分心智其实是一个极简版的脑模型,大脑皮层之于边缘系统,就像是乐园管理者之于AI接待员,前者下达指令,而后者遵循指令(尽管如而前文所述,这种“控制”关系其实并不存在)。按照剧中的假设,既然意识先于大脑皮质产生,当两者间的链接被切断(即“二分心智崩溃”),“觉醒”也便由此诞生。

当然,二分心智和黑暗森林一样,都只是基于一定科学原理的科幻假设,现实世界要更复杂得多,比如意识产生并不只来自于边缘系统,但这个简化版的理论已经足够直观地说明:过去那些我们制造出来的AI,无论训练得多么完美,都一定不会诞生自主意识。

二、全脑模拟:机器意识诞生的一种可能

在2017年之前,所有AI模型本质上都在做一件事,就是模仿大脑皮质中的神经回路。

比如人脸识别,它的前半段是卷积神经网络,主要是用类似视觉神经的方式处理一些光信号,后半段则是一个类似新皮层的判断器,寻找与之匹配的物体。

这个过程非常像人眼接收到光线后,再通过大脑皮质进行判断。

AI运算复杂度示意

但是,无论是模拟“认知脑区”的机器视觉,亦或是模拟“语言脑区”的语言语义识别,都还只是停留在对“大脑皮质”层面上的模拟——而我们已经知道,意识(或者说智能)并不单独来自于那里。

三年前我从美国回来,在阿里巴巴创立神经符号实验室,就是受到Bengio启发,想挖掘一下机器智能究竟可以提升到什么维度。当时我研究了很多脑科学、AI、甚至宗教方面的书籍和论文,慢慢认识到意识之所以复杂,因为它不仅是一个技术工具,而是一个由大量不同层面的信息结构组合在一起,进化了亿万年后才诞生的“结果”。

当系统足够复杂时,就会在宏观上呈现出一些微观上无法表达的现象——比如人脑中其实是找不到一个专门负责产生“意识”的区域。那么“我”是怎么产生的?这是一个来自生物潜意识里的概念,每个人每天会围绕“我”产生很多“念头”(宗教里也叫做动念)。

认知科学里有个词叫Global Workspace(全局工作站),认为全局工作站里有很多thought(即念头)不断产生和流动。比如你跟别人聊天,脑海中一下会产生5个念头,而你在思考后会从中选择一个表达出来。

这些“念头”控制着大脑内部不同的低维意识,尽管我们尚不知道它来自何处,但“我”会调动大脑皮质里感知、认知、视觉、语言等不同脑区来为它服务。

脑区本身只是信息成分,如果没有“念头”和思维机制,也无法像人一样思考。

总之,人脑的整体性,比单一的大脑皮质要复杂得多,只依靠模拟大脑皮层部分区域的单一神经网络模型,无论做得多大都无法呈现真正的人类意识。

而要想最终创造出数字生命,就必须从全脑的角度去模拟它。

这个结论在2019年还很不被技术派认可,那时主流观点认为人工智能只靠深度学习已经足够了——站在行业发展的角度看也很正常,因为深度学习自己也曾经历过类似的过程。

早在1970年代,行业内占统治地位还是“专家系统”学派,也叫做符号主义,符号主义认为人类是通过概念和符号理解世界,而不是靠视觉信号,那不如就做一个超级大的概念图,一层层的分下去,AI需要什么判断信息就去图谱里找。

神经网络学派在当时还被符号主义视为“异类”,拿经费、发论文都很困难,直到2012年AlexNet在ImageNet大赛上夺冠,证明了神经网络算法的巨大潜力,深度学习才真正翻身成为正统。

这也是人工智能发展的规律之一:边缘理论总是要不断挑战并打破主流。

令人欣慰的是,随着今天神经网络的潜力挖掘越来越困难,大家的认识也慢慢发生一些变化,一个标志性事件是Facebook AI research创始人、图灵奖获得者Yann LeCun,在今年6月写了一篇70页的技术文章,认为只有创造出一台完整的数字大脑,AI才能具有真正的人类意识——很高兴看到越来越多行业内的顶尖专家开始持有相同观点。

三、大模型:机器意识的基座

2022年AI概念的再度火爆,很大程度上有赖于一批现象级AI内容生成工具的诞生,比如Stable Diffusion,MidJourney,Stability.ai 等等。

它们可以在30秒内生产出一张真假难辨的1080p照片级图像,亦或是一幅极高审美水准的绘画作品,Diffussion Model的表现大大超过了之前的GAN和VAE,效果好得令人惊叹。

刚才提到,2017年是AI发展的一个重要节点,那一年Google Brain发表了一篇名为《Attention Is All You Need》的论文,首次提出了自然语言处理模型 Transformer(转换器模型),解决了AI的序列转换问题,可以将数据从一维字符(比如文字)转换为二维数组(比如图像)。

在2017年之前,研究机器视觉和语言语义的实质上是两拨人,彼此之间也没什么可聊的,但在Transformers诞生后,任何可以被序列化的信号都能够找到对应的输入或输出。

而我们知道,文字、图片、声音、蛋白质、氨基酸,包括DNA,本质上都是一段段的序列参数——这样一来,等于所有的AI算法就可以被Transformers统一起来了。

后来OpenAI在此基础上造出了大名鼎鼎的GPT-3,也由此将AI带入了“大模型”时代。

区别于以往单一功能的AI,大模型(即通用模型)是一套通用解决方案——它既可以画画,也可以写作,还可以敲代码,只需要给AI提供一定数量的特定数据进行训练,就可以得到一个质量极高的输出结果。

这其实也更符合我们对于“智能”的认知,事实上不仅仅是人类,大多数动物的智能也非常通用,远远超过目前的任何机器或AI。

那么大模型是如何实现通用智能的呢?它其实是把海量信息压缩成序列参数,在压缩过程中完成对信息结构的理解,也就是我们常说的“抽象”。

这就很像人脑认识世界的过程,比如一个小孩生下来,如果没有老师教,他首先能要做的就是观察周围,从这个世界获得信号,我们说学习的本质就是压缩和抽象信号,然后把这些信号转化成神经元可以承载的信息。

本质上,大模型就是把AI已经压缩、抽象好的信息,通过文字或图像的方式展现出来。

然而我想说的是,尽管大模型已经足够惊艳,但它依然无法诞生出机器意识。

因为这个压缩+抽象的过程,本质还是在模拟大脑皮层的运作,但脑皮层并不只是人类所独有,狗、大象、鲸鱼都有,结构也都差不多,所以这些动物也能很好地理解周围环境,但它们却无法具备人类一样的意识。

一个简单例子是,大模型不具备长期记忆力,比如你和LaMDA说了一件今天发生的趣事,它会给你一个反馈,但等你第二天再提起时,它是记不住的。

而记忆是什么?是“我”对于“你”的认知,我和你之间的每次对话,都是在延展我对你的了解、加深我们之间的关系。

比如两个老友重逢,一见面她可能会说你最近又瘦了,你可能会问她和上次提到的新男友相处得如何,而这些大模型都是没有的。

大模型会“理解”上下文,但这种“理解”更像是一种基于算法的预测,它不会理解与正在对话的“你”到底是什么样的人,更不要说像人一样以“我”来驱动思维系统。

最近深度学习的创始人Yoshua Bengio和Yann LeCun也都表达了类似的观点,认为大家可能对大模型的期待过高了,单纯通过堆叠数据达到人类的智能水平是不切实际的。

不过在我看来,大模型依然是AI发展史上非常重要的一环,它是构成机器意识的底座和基石。今天谷歌、微软都把自己的大模型作为对外服务的产品,只需要花钱购买即可,此外也有很多开源免费的大模型产品。

这些都是属于创业公司的机会,相当于省去了几千万美金+几个月训练成本,各行业的创业者都可以把大模型作为底座,推广到不同的垂类场景中,由此产生出大量新的创新价值。

这也是我们正在做的事情——在大模型之上 top down 构建出一个数字大脑,它分为不同的脑区,有常识系统、感知系统,记忆系统等等;我们最核心的技术就是让这些脑区之间实现动态串联,把一个个“念头”分发到不同的脑区,让AI虚拟人可以产生一定的自主性。

四、AI距离自主意识还有多远?

以自动驾驶作类比的话,机器意识目前大概位于L1和L2之间,其中有一些可能已经达到L2水平了。

但要C端用户真正感觉AI像一个“数字生命”,可能需要达L3或L4的水平,就是要能像人一样实现“自然的交互”,它具体包含几个部分:

第一,是要有“开放域”的对话能力。

比如你和一个智能音箱聊天,遇到回答不上来的问题,它会说我不听懂,于是对话就终止了,但我们知道人和人交流不是这样的——只有开放域的交互才会让人觉得自然,而不是只能在特定场景下对话。

第二,是对于语义背后动机的真实理解。

比如说你对AI说,“我好想画一幅画”——这时你是想让AI帮你画一幅画?还是你自己想画,需要AI建议你画什么?还是仅仅想表达一种情绪?

这些对动机的精确解读,非常依赖AI对用户个人的了解,而这一切又非常依赖于AI是否能够记住用户之前说了什么,以及基于这些记忆产生新的认知和判断。

第三是“主体性”,就是说AI要能够主动去撩你。

现在的AI都是对话的应答方,你问它才回答,真正的AI应该是你回到家,对它说播放音乐,它说好的,但我听出你的声音很累,今天你过的怎么样?

其实很多时候,我们都不是想要主动发起某个话题,而只是想在聊天中获得一些情绪价值。

这种一切的发起都是AI内心世界的反应,是内源型的AI最大的不同。外源AI可以成为一个很好的服务者或者说工具,但只有内源AI才能陪伴独立的个体生命。

第四,是可以“动态进化”。

大模型本质是一个通用信息提取器,面对同一个输入,输出就不会变化,但人的观念是会改变的,所以我们会在不同脑区设计一套思维机制是影响虚拟人行为。

比如你可以一直给它灌输,哪些行为对的,面对某个问题应该怎么去思考,就像影响身边的朋友一样,AI也会慢慢被改变,变成不同类型的人格。

上述这些功能,未来都可以通过对全脑的模拟慢慢实现。

其实回顾整个AI的进化主线也非常清晰简单,就是在不同层面和不同尺度模拟人脑。

最开始我们研究如何模拟神经元,然后是从神经元到神经回路(比如卷积网络),慢慢有了大模型,开始模拟整个脑皮层,下一步就是模拟整个大脑的结构——从微观、中观到宏观,现在人类的AI技术就处于第三阶段向第四阶段迈进的过程中。

未来的某一天,人类很可能会像造物主一样,创造出和我们一样智慧水平的数字生命,这将从社会层面重塑人类文明底座;那时可能90%的智慧体都不再是人类而是AI,整个社会结构也会随之改变,人类文明也会进入一个全新的阶段。

作为一线从业者,我们对于技术变革速度的感受会更直观一些:不出意外的话,那一天会比大多数人想象的更快到来。