扫码打开虎嗅APP

本文来自微信公众号:刘言飞语(ID:liufeinotes),作者:刘飞Lufy,题图来自:《攻壳机动队》

近期花了一些时间继续学习 ChatGPT,体会到了认知 ChatGPT 的整个过程,就是在消除我自己偏见的过程。其中存在大量信息不对称的地方。哪怕关于 ChatGPT 的讨论这么多了,噪音里面有价值的信息也并不总是好找。

接下来就分享一些观点:

一、重点并不是“聊天机器人”

首先,对于 ChatGPT 来说,它带来的大家提到的 AI 的革命性进展,压根不是做出了好用的 chatbox,或者说聊天机器人。

换句话说,它并不意味着,我们的生活和工作里并不会有太大变化,主要的变化就是多了一个聊天机器人。如果按照这个前提条件去聊,它看起来就不是革命性的。

要真如此的话,凭什么说它是 iPhone 时刻?

真实情况是,聊天只是 OpenAI 做的一个演示,用它来做 demo,让大家很好地看到了 GPT 这个模型的威力。在这个威力之外,大家还是只觉得它是聊天机器人,这就是一个啼笑皆非的事了。

当然,我们都知道,这个聊天机器人是 OpenAI 团队用来获取真实世界对话的方法,用它来继续迭代训练模型,来强化学习的 RLHF 的一个方法。选择开放给用户的这条路线,看起来好像常见,或者说之前也见过,但实际上在科研领域这是一个非常歪门邪道、一个非常不主流的方式。

之前不管是企业还是高校,以前大家做这方面的研究,不管是大模型还是 AI 方面的研究,都是用做题家的思路,就是用各种学术界的评测,如 20 个专家标注的确定性的 QA 问答题来完成,都是命题作文。

但现在 OpenAI 说,我不参加这些考试,我不参加这做题,我也不去跟你比论文数,就是把模型扔到人民群众的汪洋大海里去。

现实就是,很会写高考作文,和很会跟人聊天,确实是两码事。所以使用 ChatGPT 的时候有很多方式就不对,比如我自己作为一个可能稍微了解 NLP 的,或者了解产品、技术实现逻辑的,我就会去想:这个是不是难为他了?这个他肯定不会吧?我就不问了。

当知道他是个机器,就容易担心给的前提条件不够。它胡说八道,给一些错误的答案,我是有奇怪的愧疚感的。所以就潜意识里特别照顾它,把问题表述得格外完整才问出来。

这样结果就是不够真实。包括我做 NLP 的一些老同学,他们也会带着很多假设和前提条件去问,他们问的都不是正常人聊天会问的。而现在用 ChatGPT 的大部分的人不是产品或者技术背景,并不知道背后的原理,所以问出来的就更真实。OpenAI 最初也是用格外真实的语料去做训练,所以能训练出来 ChatGPT 的效果。

二、很多当下的问题,都是技术性问题

认知的另一个偏差是,它就是一个终态了。于是会认为它的很多问题,代表它不智能。

比如说 ChatGPT 搜的信息不准确,以及胡说八道。很多朋友都会这么觉得,问了几个问题,发现不对,就认为 ChatGPT 没有什么大家说得那么有价值。

对于信息准确性的问题其实是好解决的,而且必然会解决。因为现在使用的模型,并不是在一句一句地学,不是像某些人想象的一样,在跟每个人沟通的时候来现学现卖(当然在聊上下文的时候,它会考虑上下文,这个可以定义为短时的学习)。背后所用的大模型,实际是一个用 2021 年的语料训练的固定的模型,这个底层的模型是没有实时进化能力的。

那为什么信息准确这个问题好解决?这个后面一起说。

另外一种常见说法是,ChatGPT 既然是一个生成式的工具,所以应该是能帮助甚至替代内容创作者的。目前看起来,这方面的水平有限。有可能帮忙写个周报,帮忙润色一下文字,帮忙写个小红书笔记等等,哪怕这种简单的工作,大家也发觉了,写出来的 AI 感非常强、并不是很擅长用人的语气表达,能明显感觉到他整个表述的方式是有一种奇奇怪怪的感觉,这种感觉就让人心怀疑虑:这个所谓的 AI,不也模仿不了人的语气吗?你看,人类还是有一些所谓“灵魂”的部分存在的,AI 写内容,就是没有灵魂。

而很残酷的是,我也认为,内容创作的风格和语气也不是大问题,依然是个技术性问题,因为 AI 最擅长的就是模仿,对于文本的模仿反而是相对来说容易的。只不过一方面,因为 ChatGPT 是基于英文语料主要训练的(中文语料只有 1% 左右),所以在中文的表达上会有比较大的问题,翻译体很明显。

另外就是 ChatGPT 本身就被刻意训练了。它目前这样的语气和表达风格,是训练出来的,不是 AI 天然就是这样的。因此说这是个技术性的问题。比如说之前 AI 绘图刚出来的时候,大家当然就习惯性基于当时的版本去考察,说 AI 能画成这样还不错,但是 AI 画的图还都有 AI 感。这个所谓的 AI 感大概意思就是光影的问题、细节的问题(比如画手),这个 AI 感在 Midjourney v5 里消除得差不多了。因为这就是个可训练的技术性问题。

(这是我用 Midjourney 画的爱因斯坦和霍金,历史上不存在这两张照片)

所以 ChatGPT 信息准确度的问题,内容表达和语气的问题,人格的问题,都是技术问题。可能就会有朋友问了,那你说都是技术问题,那 AI 发展了这么多年了,可不是每个都是技术问题吗?为什么 ChatGPT 就不一样呢?

三、重要的是“理解和推理”

ChatGPT 最特殊的地方,是揭示了一种可能性,即 AI 可以呈现理解和推理能力了。这是过去大半个世纪的学者们所一直追求,而不可得的。

这里要简单说一下 GPT 背后的逻辑。首先语言模型是很早就有的, 10 年前我读研的时候,如果学 NLP,你翻开教材的第一页可能就能看到语言模型,就跟学高等数学第一课都是先学函数一样,不是什么新鲜的、现在才发明出来的成果。

为什么作为一个语言模型,大家这么惊奇?并非由于它可以对话了、能写所谓一碗水端平的片儿汤文章了,更不是能获取什么信息和知识,而是在这个大语言模型当中体现了推理。

体现了推理是一个事实论述。说到这里,必然会有一些朋友,援引很多人包括知名学者的说法来反驳,说语言模型只是统计的模型,因此不能称之为理解和推理。

这里也不妨多说几句大语言模型的逻辑。最基础的很简单,依据上文,预测下一个词。过去能力不足,是根据一两个词预测下一个词,后来出现了更多的算法和更好的硬件,于是可以预测更多的上下文了。像现在 ChatGPT 就能依据几千个字符去做预测,这归功于有如神助的 Transformer 算法。

但是,大语言模型依然还是一个猜词游戏,是统计意义上的一个算法,它没有别的复杂思考,就是从海量的记忆(模型)里,搜寻出最有可能出现的下一个词。

所以很自然,听起来,无论谁都会觉得,这种统计逻辑的语言模型,恐怕只能解决记忆问题,不能解决逻辑问题。就像我们读了很多书籍、文献、维基百科、百度百科等等各种知识。那接下来我们能做的是什么?很明确的,可能做一个好翻译,或者能写一篇像模像样的文章,但是搞别的应该是不行的。毕竟是个复读机嘛,是个“模糊的印象”(a Blurry JPEG of the Web)嘛(这是科幻作家 Ted Chiang 对 ChatGPT 的评价,已经被更多人认为是偏见了)。

不管怎么去想象这个算法逻辑,我们都很难想象只是记忆,就能产生逻辑。这在 2022 年之前都是天方夜谭,而 2022 年底过后,ChatGPT 让这变成了一个可能性。

为什么 ChatGPT 在一个词儿一个词儿蹦的时候就呈现了逻辑?这依然是个科学上的未解之谜,以及都在争论不休的话题。毕竟我们想象中,一段有逻辑的文字,应该是先设定主题,再想框架和段落,再去落笔的。

这里要特别补充一点:表现出了推理和逻辑能力,与本质上有没有推理和逻辑能力,是两码事。前者是个事实问题,已经可以说是公认了,从原理上反驳意义不大,用过即知;后者则是个哲学问题,还在争论之中。

什么叫有逻辑能力很早就是学术界有争议的话题,从控制论出现就在讨论“看起来的智能是不是智能”的问题了。同时,人脑运作的很多原理目前尚不清楚,如何产生的逻辑推理,也不清晰。

很奇妙的是,在目前的模型中,“think step by step”是一个很好用的咒语,跟人的思考是很像的,机器只要不是直接给结果,而是多想几步,就能呈现非常好的效果。

这些都是题外话了。实际上对产学研而言最惊讶和最兴奋的,不是讨论本质上有没有推理和逻辑能力,而是表现上有没有。

四、通往通用人工智能之路

OpenAI 在这个大语言模型上做了什么,把 GPT 以及 ChatGPT 做出来的?其实没做太多算法上的、底层规则上的很复杂的事情。而是用很工程的手段,甚至堪称暴力的手段去训练,然后反复地调试。

所以一个非常古老的、已经长满了青苔的语言模型,居然可以实现有推理能力的高水准的 AI,非常叫人意外。追求 AGI 的路,从 1956 年达特茅斯会议实际已经启航了,明斯基、麦卡锡、司马贺、纽厄尔这些人工智能的创始人,本来预期是十年二十年就实现的梦想,花了大半个世纪,依然进展不大。

学者们最开始想的,跟大多数人想象的 AI 必须先学的一步是类似的,就是学习推理。他们被称为符号派,就是把世间万物的所有的逻辑和知识抽象出来,把它们变成形式语言,像数学题一样可以计算与推演,一生万物,不就是智能吗?这条路一度是人工智能的主流派系,一直到 20-30 年后,尝试了各种各样的方向,发觉全都被堵死了。

接下来就是统计学习和深度学习的时代,就是让机器去自我消化数据,它就能解决问题。这时候的学者们更落地、更实在了,不关心 AGI,而是关心垂直课题了,比如说人脸识别、自动驾驶、下围棋和玩游戏等等,这些似乎都是做得还不错的。语言模型也在其中,大家认为它能解决一些问题(谷歌翻译和百度翻译就是语言模型的逻辑),显然不能解决一切问题。

而 ChatGPT 的启示,就像说有一个田径队,短跑、长跑、接力跑、马拉松等等运动,有不同的教练去用不同的方法训练,毕竟是不同的课题。但是今天,有一个教练,用了全新的方法训练了一个队员,发现这队员跑啥都行,接力跑、长跑、短跑都能拿好的名次,甚至跑去试了试扔铅球也是前几名,扔标枪也是前几名,跳鞍马也是前几名,他不一定都能拿到第一,但这个效果大家非常惊讶。

还是前文说的,有逻辑、能从信息中发掘知识,并不是个值得争论的问题,它是个事实。很多学者花了很多年研究,怎样让机器识别词性(形容词、动词、名词等),这是个专有课题,而词性标注的效果,ChatGPT 也完成得很好。类似的课题,非常大量。用三体的话说,许多学者、博士们还在研究的 NLP 的中间课题不存在了,一点儿也不为过。哪怕不提这些研究课题,注册使用下 GPT-4,你肯定也会有体感,这种体感是不会说谎的。

那么 AI 有了逻辑和理解能力,能做什么呢?能做太多了。

前面说的技术性的问题,反而可以交给一些基于规则的产品解决。例如, ChatGPT 自己可能信息不全,但它能比很多人更好地查到所要的信息,而不只是把网页排个序;ChatGPT 自己可能不会写很厉害的文章,但经过一个熟练的写手训练之后,确实能理解你想要什么,就能变成一个有固定文风的写手;原生的 ChatGPT 可能完全不知道怎么使用 Word,但是让它看大量的人是怎么使用的,很快也就能学会了。

这才是 ChatGPT 最不一样的地方:它比之前所有的 AI 都更像一个 AI。当 AI 这个词在 1956 年出现的时候,大家想象的是一个智能的东西,而现在,它真的出现了,至少有了真正智能的可能性。这一点在学术圈和科研领域最早引起了轰动,可能比普通用户的震惊程度还要大。

之前是大家看不到通往通用人工智能的路的,所以 ChatGPT 的意义不是聊天机器人本身,而是这个新的范式,揭示了一种全新的可能性。未必是唯一的可能性,但确实是一种可能性。过去从来没有过的可能性。

五、继续推演未来

接下来可能会发生什么呢?我观察和思考到了 7 个方面,分享一下。

第一:不光 AI 的企业都得投入大模型,而且很快会进入工程上的军备竞赛。

这里跟很多朋友想的不一样,大模型不是比参数量。如果去搜参数量的模型,快手还官方自豪地发布过一个有万亿参数量的模型,当然跟 GPT-3 也没法比。

同时,也不是单纯比数据多少。数据确实是一个壁垒,但是还有一个更加核心的竞争力,即调试工程。比如对于百度,之前做的文心大模型,底层数据量真的不比 OpenAI 的少,或者很有底层的模型都不一定比 GPT-3 的质量差。只是完全没有采用 ChatGPT 的方法训练(InstructGPT),也就是怎么激发。激发也是非常玄学和魔幻,OpenAI 有一个人数不小的工程团队,专门通过语料和代码,做激发和调试,让它变得更智能。

这可以说是最后画龙点睛的一步。就像说有一个天分特好的小孩,需要调教,而如何调教是不存在一个很确定性的方法论的,调教本身也是个黑盒,有很多坑每个团队都得慢慢趟、反复试错。

从 GPT-3 这个底层模型的出现,到 ChatGPT ,其实花了很多的工夫,在这个过程中,工程比研究要重要得多。学术研究它提供的是方法,但是 ChatGPT 背后并没有新的方法,更重要的还是工程团队用了一些所谓的比较 tricky 的方法。所以 OpenAI 公开了底层的算法和逻辑,并没有公开 ChatGPT 的源代码。对于百度来说,花了一两个月重新开始调教,效果肯定跟 ChatGPT 是没法比的。百度和国内其它家面临的大多也是调教的问题,想要砸钱训练出来一个底层的 GPT-3 的模型不是难点,InstructGPT 才是。

第二,如何调教,会直接影响 AI 成为什么样的 AI。

并不是说各种不同的团队去激发大语言模型,最后激发出来的效果殊途同归、一定是一个东西。很多没有了解技术细节的朋友总觉得 ChatGPT 很蠢,因为总是一碗水端平、按格式来写命题作文,这个是刻意调教的结果。为的是获取最大公约数的用户,不要出现任何政治错误的问题、偏见的问题。

想要真的调教一个极端分子、调教一个特别温柔心理咨询师,甚至调教一个诗人,原则上都是可以的,就看怎么调。

一种说法是,目前的 OpenAI 用了 6 万多条语料就调出来了 ChatGPT。那用别的语料、用更多的语料,会发生什么?可以预见的是,未来各种各样的人格都会调出来,不同团队做的 AI 风格各异,跟人与人的区别一样。

因此,ChatGPT 并不是,有一个团队花了很多年种出来了一个品种的苹果,这个品种的苹果叫 ChatGPT,你吃了一口这个苹果说太酸了,扔了。就认为这件事没有价值。

这个叫 ChatGPT 的苹果是重要的,但更重要的是,发现了一片叫大语言模型的土地,可以种各种 AI 的水果,不光有苹果,还有梨子、菠萝、葡萄等等,有大量的可能性。这是一定会发生的。现在很多团队去追逐的,并不是要做同一个品种的、酸甜度一模一样的叫 ChatGPT 度苹果出来,而是都看到了这里面做其它水果的价值。

第三, ChatGPT 的这个范式是可靠的,那很多技术性的问题解决就只是时间问题。

这是在回应前面说的问题。只要这个范式是可靠的,很多技术性的问题无非就是加算力、加数据以及有耐心地调教。

早在 1956 年塞谬尔就做过一个跳棋程序,在当年已经能下赢很多专业选手了,那时很多科学家就意识到,未来机器能在棋类游戏中下赢人类,只是个时间问题(包括在读大学的陆奇,就有这个洞察了)。到了 1997 年,深蓝下赢了国际象棋大师, 到了 2016 年 AlphaGo 下赢了围棋世界冠军,如今的很多游戏 AI,DOTA2、星际争霸 2 的 AI 也都可以下赢很多顶级的选手。在范式不变且可靠的前提下,学会下棋就是个技术性问题,也就意味着是个时间问题。

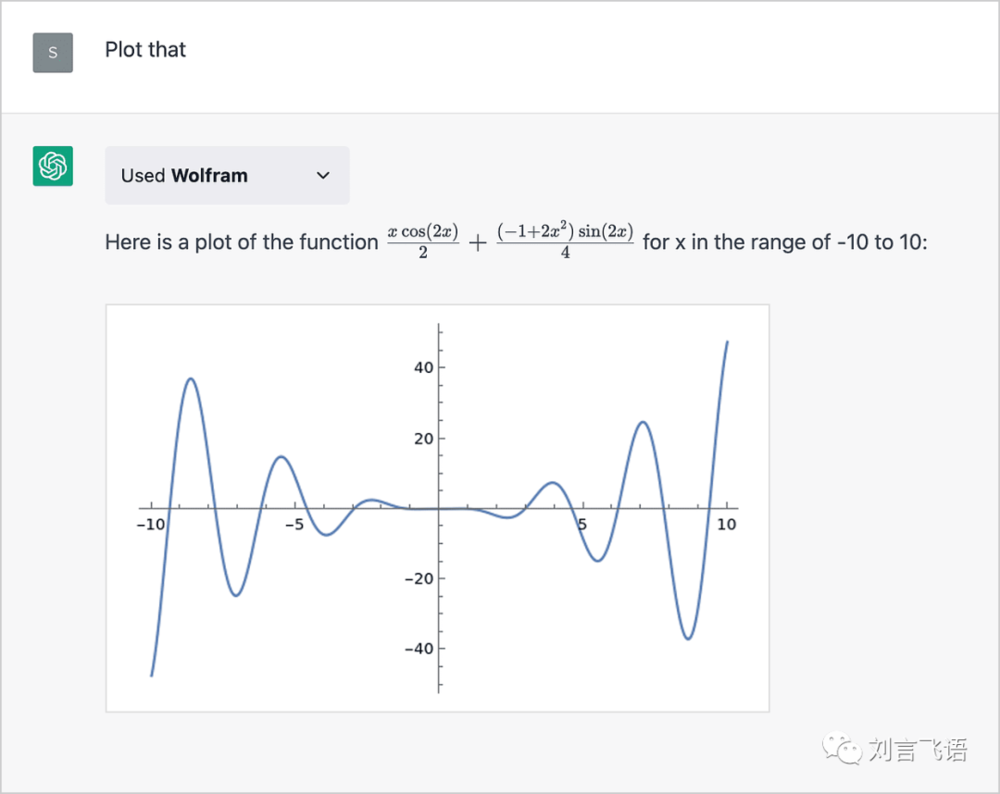

对有逻辑能力的大模型来说,前文说过的信息准确度的问题,都未必在内部解决。ChatGPT 也可以跟训练有素的有数学知识的产品合作。就像一个聪明小孩,不懂数学但是足够聪明,那可以配个小伙伴,这个小伙伴不是很聪明,但上过奥数班,俩人一搭配,问题就解决了。这不是假想。

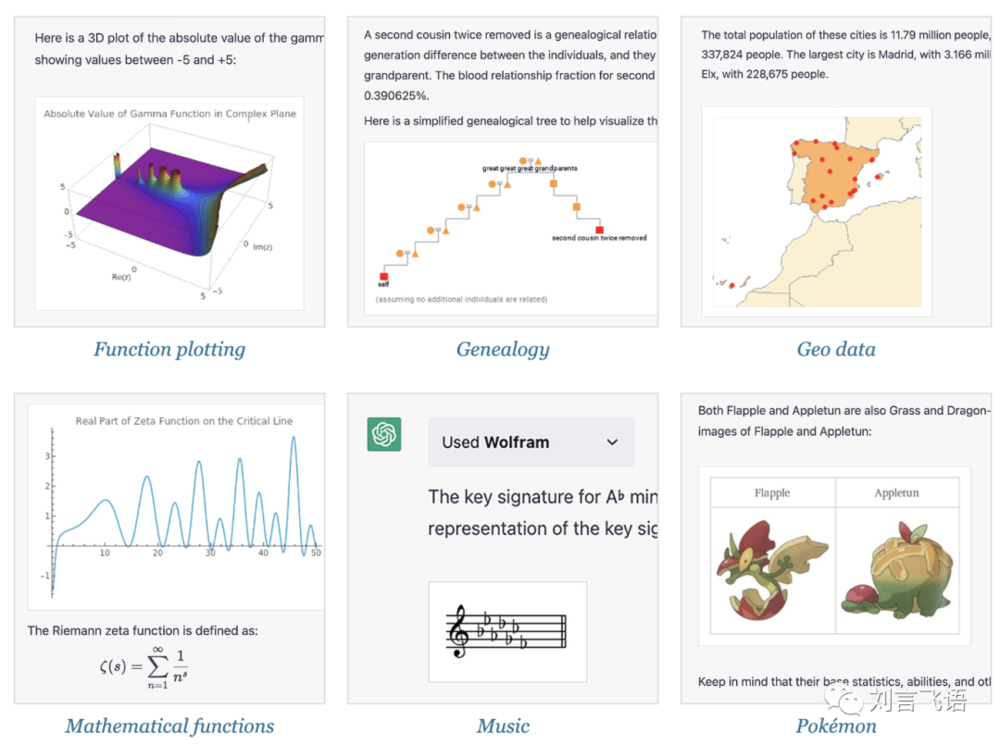

知名的计算智能引擎产品 Wolframe 就跟 ChatGPT 合作了,可以在补充了更准确的知识和规则的前提下,解决大量的问题,比如化学、数学、物理、地理、几何、历史、材料、工程等等。

(来源:ChatGPT Gets Its “Wolfram Superpowers”!)

第四,解决各种问题的速度,或者说满足各种需求的速度,可能是指数级的。

这个是很感性的判断,确实没有很有说服力的论据。现在大家也都不知道多长时间会发生什么事情。不过大概率它的发展速度不会是线性的,因为人脑的学习是缓慢的,毕竟神经元信号传递存在速度限制、神经元的数量和规模有整体的限制的。但计算机不一样,就像一个人脑不行,那可以连接 10 个人脑。10 个爱因斯坦的脑袋连起来,它是不是乘以 10 不一定,但的进化速度肯定比生物进化要快得多。

ChatGPT 的成功会让已经在过去领域里卷到疲倦的大厂,纷纷进入军备竞赛,这也会加速这个进程。另外,对于很多场景来说,让产品对接大模型,是不复杂的,ChatGPT 作为中间层很合适,主要负责解释和推理,并不用每个场景都再训练一遍(未来难说会不会各种场景都有自己的大模型)。从 Office 和 Adobe 这么快的跟进也可见一斑。

这里就有一个很残酷的现实,就是业务融合 AI 模块之后,每个打工人在用 AI 的这个过程,就是在加速淘汰自己的过程。

第五,调试工程师会变成很值钱的岗位。

这个好理解,对于大模型来说,可解释性非常差,换句话说,可控性很差。前面也说了,它是非常巨大的黑盒,只能通过调教、不能通过指挥,不能指哪打哪,说这个问题回答得不好,下次必须这么这么回答——没法这么去训练它。所以调教就显得特别重要了,调试工程师就会变得越来越值钱。

不过调试工程师到底具备什么样的能力?了解场景,还是了解代码?这个不大清楚。这是个全新的岗位,大家都在探索。

第六,失业问题。

可惜的是,值钱的岗位未来不会特别多,但不值钱的岗位会变得越来越多。

失业问题很有意思,之前 OpenAI 自己官方下场写了一篇报告,具体内容就不展开说了,只说最后的几个结论:

第一,80% 的人受影响,会有 10% 的工作内容受 LLM 影响(受影响的定义是同等质量的工作成果,降低 50% 的工作时间),19%的人“大受影响”,即会有至少 50% 的工作内容受 LLM 影响。

第二,薪资越高的人越容易受影响。受过良好教育的、有丰富工作经验的、高薪的职业,被影响的概率是偏大的。

第三,有一个影响程度排行榜,其实就是高危列表。里面高频出现的包括:数学家、口译员和笔译员、作家和写手、区块链工程师等。

第四,部分职业存在可能性被彻底替代掉。对于这个榜单,人工标注的结果里有 15 个职业;GPT-4 标注的结果里有 86 个职业。AI 下手果然还是更狠一些。(报告来源:https://arxiv.org/pdf/2303.10130.pdf)

感兴趣的朋友可以自己读一下全文。这个估计当然不会特别准确,但是他们用了尽可能量化的方式,有一定预见性。未来会不会发生?我认为大概率确实会发生的,只是时间上不好讲。有一些相对容易落地、容易快速被替换掉的,比如说个体户可能危险性更大一些。比如做插画的画师、做电商图片的这些美工、一些公众号的小编等等。大公司的组织,整个工作内容或者岗位要做调整,会有组织管理上的问题,可能会慢一些。

那这中间可能也有过渡期,比如 AI 绘图变成主流之后,画师们未必就全都失业。就像 Photoshop 出现之后大家更多是从用纸和笔去绘图,变成了用另外一个工具去做。未来 AI 绘图背后,也要有需求转化的这一步(prompt engineering) 。不过比较悲观的是,AI 绘图和 Photoshop 不一样,还是存在效率差异的。用纸和笔的画师和用 Photoshop 的画师,生产力的变化可能没那么大;但是 AI 的生产力是剧烈的大幅提升,意味着不太需要那么多从业者了。这就必然有一个结构性的大的波动。那未来会怎么样?会不会出现大的社会问题?这个就不是我能讨论的了。

第七,大多数人机交互都不存在了。

冰箱发明之前,很多人研究的是怎么存储冰块、制造冰块,有了冰箱,就不再需要这种冷藏方式了。对于产品交互也是这样,用户过去为什么要点按钮?要做各种操作?包括用 Photoshop、 Word 里很多反人类的各种各样的、根本记不住的复杂的功能。

所以我们看起来更像是处于过渡期,真的技术能力达到以后,当下的大多数人机交互也没有必要存在了,只需要剩下自然语言交互,这就跟我写过的那篇猜想对应上了(从 ChatGPT 看 AI 未来的 7 种场景可能性)。

跟写之前的文章时不一样,我这段时间试用了 GPT-4 基础上的 ChatGPT,包括跟更多专家聊了一些技术上的问题。现在的我觉得这是很有确定性的。就像前面说的,现在的发展是指数级的速度。

写在最后

如今 ChatGPT 发布后,整个产学研都已经到了快车道上了,这个快车道上是没有人有能力去踩刹车的。我们作为个体,也是不可能回避这个 AI 的历史车轮的。

大家都知道阿里有一个经常被群嘲的价值观,叫拥抱变化。这个词现在看感觉还挺应景的。

所以不如反过来想问题:汽车时代来的时候,马车夫肯定非常焦虑,驯马师也很焦虑。不过汽车是工具,对大部分人来说它是非常有帮助的。它的出现并不是说要摧毁谁,摧毁哪些岗位,或者摧毁哪个行业。它还是为人类服务的。

我们可以用汽车做很多有价值的事。没有交通工具的效率提升,全球化也不可能发生。我们可以多想一下,有了 AI 我们能干什么。

最近跟身边几个比较要好的朋友聊 AI,大家达成的一致,都是先用起来。先用它做点什么,感受下它能做什么、不能做什么。未来有无限的可能性,不妨把目光放长远一点;不纠结当下的得失,看看 AI 未来的机会。保持这样的心态也许更容易接受变化。

就说到这里,希望对你有启发。

本文来自微信公众号:刘言飞语(ID:liufeinotes),作者:刘飞Lufy