扫码打开虎嗅APP

本文来自微信公众号:神经现实(ID:neureality),原标题《大脑神经网络:不完美的“民主社会”》,作者:杨闰哲,题图来自:Matt Chinworth

就像人类社会的运转需要一套共同的决策规则,大脑的运转也依赖于神经元之间的某种契约。自上世纪40年代起,理论神经科学家就试图通过数学模型,解释神经元活动背后隐含的“民主规则”:McCulloch-Pitts模型是鼓掌通过式的民主,Linear Threshold模型是乔治·奥威尔式的民主,Hubel和Wiesel提出了神经元民主的层级结构 —— 在视觉系统里有好脾气的“简单公民”和坏脾气的“复杂公民”。

“民主”的神经元模型是简陋的,它不是生物大脑运作的真实方式,而是一种非常粗略的近似;但“民主”的神经元却又是简单高效的,它们构建了今天深度学习技术的基础。“民主”的神经网络似乎印证了丘吉尔的那句名言,“民主是最糟的政体,除了其它那些已经试过的不能用的之外。”

世界上最热闹的“社交网络”,就在你头脑里

在我们小小的颅腔里住着860亿个神经元,它们有的易燃易怒,脾气暴躁;有的郁郁寡欢,消极厌世;它们每天都在对我们经历的事物各抒己见,争吵不休。如果你不能想象大脑里每天沸沸扬扬的辩论实况,那就想一想微博或推特—— 一个不过月活3、4亿用户的社交网络 —— 每天是如何制造热点、生产和传播假新闻、或者粉圈互撕到服务器宕机的。

我们的大脑规模约等于二十多个这样的社交网络,平均每个用户有1000位粉丝。而且这些用户活跃时战斗力非凡,平均每个神经元3至4秒就发一次推,大脑短短一小时产生的信息足以淹没任何超话热搜。

即使是一个平日里看起来非常好脾气的人,他的大脑中也充满了不间断的争执。举例来说,即使像是“看到一块芝士蛋糕”这样一个简单、统一的事件单位,也是大脑中成千上百的神经元激烈辩论结果。每个参与其中的神经元——从视网膜,到视觉皮层,再到下颞叶——通过产生动作电位、释放神经递质来发表见解。

神经元们似乎总是很难达成一致,比如视网膜中的双极神经元(bipolar cells)往往乐于表达赞同,让其他神经元更加兴奋,而无长突细胞(amacrine cells)总是悲观否定,抑制其他神经元的活动。但无论如何,这些常常意见相左的神经活动终究会汇总成一个明确的、无可辩驳的概念,并让我们不禁咽了咽口水。

不仅仅是简单的“刺激-反应”过程,神经科学家们相信,我们所有的情感、记忆、思考和创造,都是这群吵吵闹闹的“乌合之众”的共同决定。它们是如何做到的?

两个原则:经验就是动作电位的模式,学习就是突触连接的改变

把大脑看作一个网络,并非一个新鲜的概念。早在社交网络的概念尚未发明的20世纪40年代,科研人员就试图用网络模型解释大脑的运作机制。

在这类模型中,大脑被看作一幅只有节点和连边的计算图,网络中的每一个节点象征一个神经元,每一条连边象征着两个神经元之间的突触连接,信息在网络中有向地从一个节点流向另一个节点,分布式地在每个节点被计算和处理。比如在小鼠的大脑中,每个神经元从树突接受来自其他神经元的电信号,在胞体上进行计算,再从轴突通过动作电位把计算结果发送给其他神经元。

小鼠视觉皮层L2/3中的三个兴奋性神经元。图中较粗有许多凸起的枝干为神经元的树突,(底部)较细较光滑的枝干为神经元的轴突。

MICrONS Explorer,https://microns-explorer.org/phase1

为了把这类计算模型和大脑的认知功能联系起来,神经科学家们提出了两个普遍接受的原则:

1. 我们所有丰富的内部体验和外部活动,不过是神经元持续的动作电位模式。

2. 我们从过去经验中学习的能力,大多归功于神经元之间突触连接的可塑性。

这两个原则,在大脑的结构和功能之间搭起一座桥梁。只要知道神经元之间的突触连接,我们就可以从某种程度上解释大脑是如何一步一步地处理信息的。不同的局部连接结构赋予了大脑不同的功能;这些结构中持续的电信号,构成了我们的行为和体验,比如速记一串电话号码;这些突触连接的动态变化,给予了认知系统迭代进步的能力,比如学习新技能。

谢灵顿反射弧(Sherrington‘s reflex arc)可能是最早把突触连接和功能联系起来的模型,可以被视作最早的“神经网络”。动物反射行为通常由从感觉神经元到运动神经元的一系列突触链执行,这种特殊的链状神经结构被叫做反射弧。一个完整的反射弧通常包括五部分:感受器负责从环境接受信息,传入神经将信息传导至神经中枢,再由传出神经将反应返回到效应器。如果用计算图表示,反射弧就是一个包含五个节点的路径,每个节点被激活的顺序反映了刺激到反应的一系列因果关系。

“现代神经科学之父”卡哈尔(Santiago Ramón y Cajal)的学生德诺(Rafael Lorente de Nó)提出了循环的突触连接可能是中枢神经系统的基本结构。和反射弧的开放结构不同,突触环(synaptic loops)是一条闭合的链,从而使神经活动的模式得以保持。

谢灵顿的学生格雷厄姆·布朗(Graham Brown)在研究脊髓的节律性时也提出,一些神经活动有可能在大脑的内部生成,而不依赖于即时的刺激-反应关系。反射弧在被外界刺激之前是不活跃的,但是因为环状突触结构和内部生成的神经活动,大脑的活动可以不依赖于外界刺激。

进一步,唐纳德·赫布(Donald Hebb)在1949年提出的“细胞集结理论”(cell assembly theory)认为不同的神经元集群构成了神经系统的基本功能单元,并讨论了突触可塑性的形式。神经元之间反复的突触通讯,可以强化它们之间的连接,从而形成德诺说的能够保持神经活动的突触环。

赫布、德诺、布朗、谢灵顿等人的想法,最终通过数学抽象为神经网络。最著名的两类基本模型,就是感知机(perceptrons)和联想记忆网络(associative memory networks)。感知机模型常常被用来解释视觉系统是如何识别物体,而联想记忆网络则试图解释大脑是如何存储和提取信息的。

- Matt Chinworth -

1957年由弗兰克·罗森布拉特(Frank Rosenblatt)提出的感知机模型,是对谢灵顿反射弧概念的数学抽象与推广。和反射弧一样,信息在网络中的流动也是单向的,即从输入到输出。但与反射弧不同的是,感知机允许许多输入汇聚到单个神经元,也允许单个神经元有多个输出。感知机也可以看作是单层的前馈神经网络(feedforwad networks)。在前馈神经网络中,突触连接不允许形成环链。

联想记忆网络往往带有回路和环链,今天被归类为循环神经网络(recurrent networks)或者回馈神经网络(feedback networks)。而感知机模型则非常适用于研究大脑对外界刺激的即时响应。在人工智能技术大行其道的今天,用于图像识别的人工神经网络,多数类似于原始的感知机模型;而用于阅读理解的网络,则往往包含了许多循环结构来维持工作记忆。

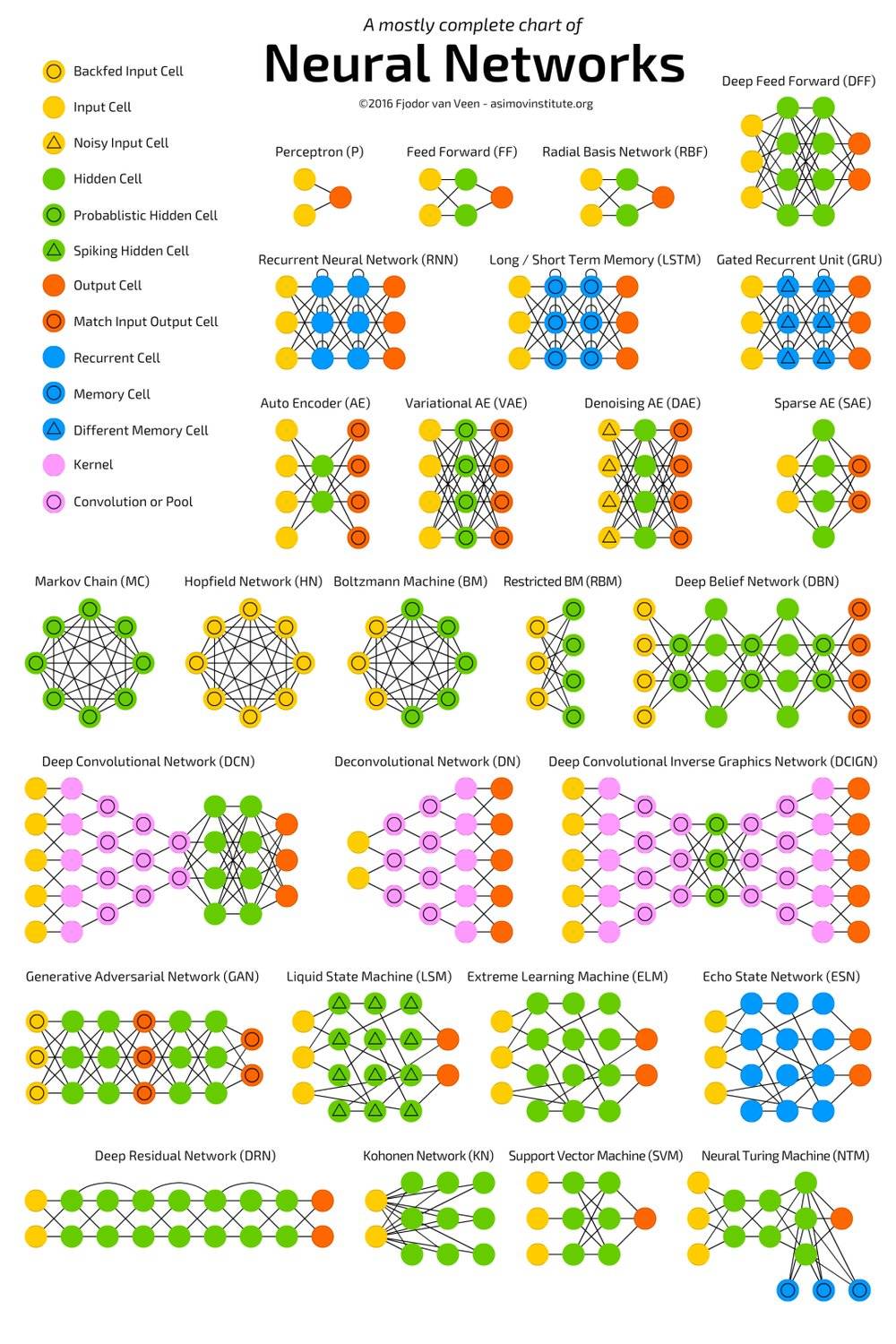

百花齐放的人工神经网络模型,大多模型都是从感知机和联想记忆网络演化而来。

Fjodor van Veen,https://towardsdatascience.com/the-mostly-complete-chart-of-neural-networks-explained-3fb6f2367464

两条原则 —— 经验就是动作电位的模式,学习就是突触连接的改变 —— 使得通过模拟神经网络来实现认知功能的联结主义人工智能变得充满希望。计算机科学家与神经科学家们相信,无论多复杂的功能,都可以从庞大的神经网络中涌现,只要找到了对的突触连接方式。

深度学习技术成功的关键,就是运用第二条原则来找到执行特定功能的神经网络。虽然今天计算机科学家们使用的更新突触连接的算法,和神经科学家普遍发现的赫布法则非常不同。

关于第二条原则的讨论我们可能需要另一篇文章来展开。而今天这篇文章会试图向你证明,单单第一条原则可能已经足够有趣。作为经验载体的动作电位是如何在神经网络中计算与传播的?网络中的一个神经元常常从与之相连的一众神经元接听信息,这些吵闹的神经元常常有着非常不同的神经活动和突触电位,神经元是如何整合这些不同意见的?

一人一票制:民主决策的基石

神经元的动作电位和突触电位是时刻变化的,它们涉及到膜电压和离子通道开闭之间的复杂相互作用。为了建模每个神经元的行为,理论神经科学家有时会忽略其中的这些复杂性。一种非常流行的简化是,当同时激活的兴奋性突触数量足够时,神经元就会激发动作电位。这一简化是合理的,因为单个兴奋性突触后电位(excitatory postsynaptic potential)通常比激发动作电位所需的电压差小很多。因此,突触后神经元的胞体需要对同时激活的那些兴奋性突触后电位求和,使得其总电压有可能超过激发阈值。

1943年,沃伦·麦卡洛克(Warren McCulloch)和沃尔特·皮茨(Walter Pitts)为这种对动作电位求和的神经元建立了数学模型。McCulloch-Pitts神经元同时接受多个输入并产生单个输出(但可能发送给多个神经元)。神经元输入和输出都用二元变量0或1表示,0为沉默,1为活跃。每个神经元都有一个阈值参数θ,表示激发神经元所需的最小兴奋性突触数量。

如果在某一时刻的输入总和大于或等于θ,则神经元的输出为1;否则输出为0。我们可以连接多个这样的McCulloch-Pitts神经元,使得一个神经元的输出就是另一个神经元的输入。这一简单的数学过程也有对应的生物解释:突触前神经元的放电可以激活另一个神经元上的突触后电位。把许许多多这样的McCulloch-Pitts神经元连接在一起,我们就构建了一个神经网络。

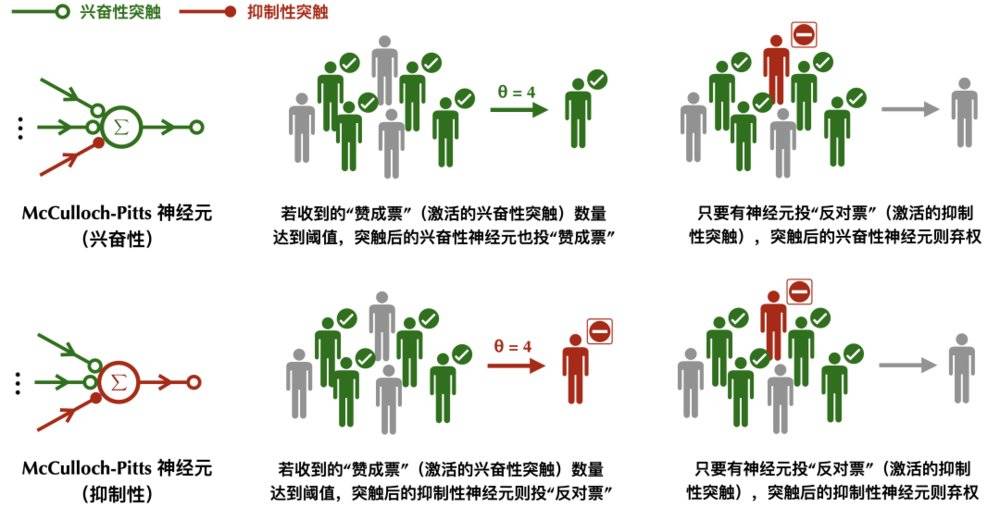

比上述的0和1稍稍复杂一些,最初的McCulloch-Pitts神经元同时考虑了兴奋性和抑制性突触的存在。类似一套民主投票规则,兴奋性突触的1记一张赞成票,抑制性突触的1记一张反对票,0为弃权票。所有突触前的神经元都可以表达它们意见,突触后神经元汇总这些意见再进行决策。

McCulloch-Pitts神经元的工作原理:兴奋性突触一人一票,抑制性突触一票否决。

如果突触后的神经元是兴奋性的,那么它属于神经网络中那一类持有乐观立场投票者,只会投赞成或者弃权票;相反如果突触后的神经元是抑制性的,那么它属于悲观的且特立独行的投票者,只会投反对票或者弃权票。这一限制遵循了神经科学中称为戴尔法则(Dale‘s principle)的规律,一个神经元只会向其他的神经元分泌相同的神经递质,从而形成要么兴奋性要么抑制性的突触。虽然今天神经学家已经发现了许多戴尔法则的反例,但是在大部分情况下,这一规律还是有普遍性的。

在McCulloch-Pitts模型中,对于兴奋性的神经元,如果它收到的来自其他神经元的“赞成票”(激活的兴奋性突触)数量达到某个阈值,比如超过半数,并且没有神经元向它投“反对票”,它就会向与之相连的其他神经元投“赞成票”(1),否则弃权(0);对于抑制性的神经元,如果它收到的来自其他神经元的“赞成票”(激活的兴奋性突触)数量达到某个阈值,并且没有神经元向它投“反对票”,它就会向与之相连的其他神经元“反对票”(1),否则弃权(0)。如果一个神经元收到了“反对票”(有抑制性突触被激活),那么无论神经元本身是兴奋性还是抑制性,都会投弃权票(0)。

McCulloch-Pitts 模型可以看作一种“鼓掌通过”式的民主,只要投赞成票的兴奋性神经元超过一定数量,就可以激发突触后神经元作出决定。同时,抑制性的神经元还具有“一票否决”权,只要它对刺激不满意,它就可以使下游的神经元不响应。

在这种体制中,每个神经元唯一需要关心的变量就是投票通过的阈值。低阈值的神经元像是人群中极易被煽动的坏脾气,只要有少量神经元冲它发火,它也会跟着发火;而高阈值的神经元则木讷许多,需要大量神经元同时对它苦口婆心地劝说,它才会审慎地透出自己宝贵的一票。

这种民主制度虽然简单粗暴,但已经可以解决许多复杂问题。我们在后面会介绍到,高阈值的兴奋性McCulloch-Pitts神经元相当于逻辑电路中的“与门”,低阈值的兴奋性McCulloch-Pitts神经元相当于逻辑电路中的“或门”,而抑制性神经元的作用和“非门”类似。一个由McCulloch-Pitts神经元构成的网络,在某种程度上等价于一个逻辑电路。我们的视觉系统也可以从类似的角度被解释。

McCulloch-Pitts是最简单的神经元模型,但它也缺失了许多重要的生物细节。其中最值得注意的一点是,在McCulloch-Pitts模型中,所有的兴奋性输入是被同等对待的。如果激活,则记为一票,每一票都同等重要。神经元的“身份”在这一民主机制中被完全革除了。而真正的生物神经元并非能做到如此绝对公平公正。神经元之间往往会形成不同强度的突触。这意味着突触后神经元会有意地更重视某些神经元的意见,而轻视另外一些。

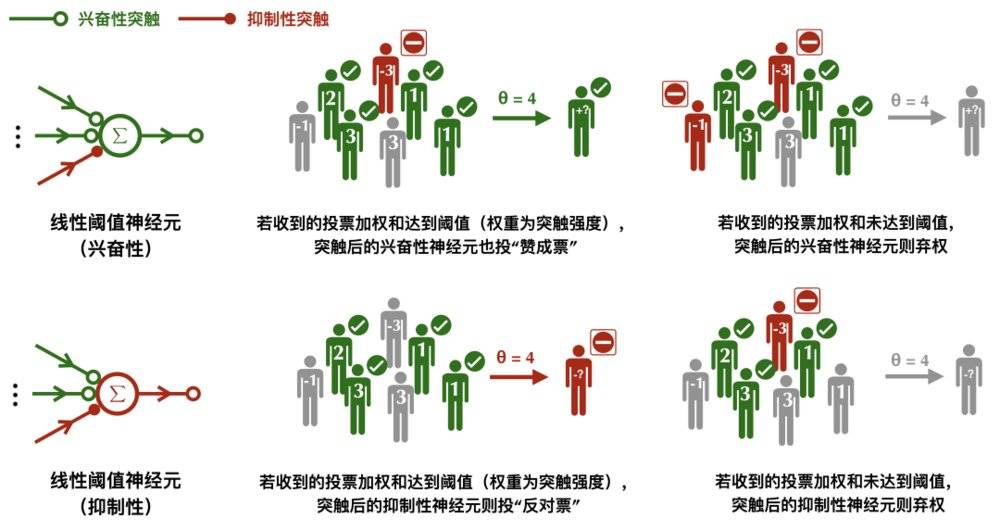

将突触强度的差异性纳入考虑的神经元模型,叫做线性阈值神经元(Linear Threshold neurons)。和McCulloch-Pitts模型一样,它也遵循了民主最基本的一人一票原则,记活跃为 1,沉默为 0,只是有的突触在最终计票时会被赋予更高的权重。这一更像是《动物庄园》式的民主,“所有神经元生来平等,但有的神经元比其他神经元更平等”。只有当来自所有突触的投票的加权和大于或等于预设的某个阈值θ,突触后的神经元则被激活。

线性阈值神经元的工作原理:兴奋性的突触拥有正权重,抑制性突触拥有负权重,投票结果由加权和决定。

此外,在线性阈值神经元模型中,抑制性神经元不再有一票否决权。相反它采取了一种更加公平的做法,兴奋性的突触拥有正权重,抑制性突触拥有负权重,只有当来自兴奋性突触的声音盖过了那些抑制性突触,并达到阈值,突触后神经元才会被激活。

McCulloch-Pitts模型可看作一种兴奋性突触权重均为1的线性阈值神经元。而要让抑制性神经元像在McCulloch-Pitts模型中那样可以“独裁”,只需把抑制性突触的权重设为兴奋性突触总数的相反数。

无论是 McCulloch-Pitts 神经元还是线性阈值神经元,都只刻画了神经元活跃(1)与不活跃(0)两种状态。而生物神经元的放电速率是连续分级的。另外,在线性阈值神经元中,神经元的输入是电流强度(假设突触强度与神经元活动相乘得到电流),输出是放电速率,这意味着胞体在进行一种将输入电流转换为放电速率的计算。

这种观点电生理学家也经常采用,他们通过频率-电流曲线来表征神经元,每个突触产生的电流与其突触强度以及突触前神经元的放电速率成正比。

今天深度学习技术中使用的神经元模型,其基本思路与线性阈值神经元非常相似。考虑到神经元放电速率是连续分级的,它们以实数作为神经元的输入输出以及突触权重。

区别于McCulloch-Pitts或线性阈值神经元用一个阈值划分激活还是沉默,它们采用一些“激活函数”来得到连续且单调递增的输出。这就像每位选民可以更加细腻地表达自己的支持程度,比如投出赞同度为65%选票,而不是绝对的0或1。而突触后神经元输出的支持率,则由它接受的支持率的加权总和决定。

视觉系统:选择性和不变性

我们已经知道单个神经元是如何运作的 —— 如果我们愿意忽视大量复杂的生物细节,那么每个神经元所做的计算,不过是一种简单的民主投票。一个由许许多多这种过分简化的神经元构成的网络,却已经可以执行非常复杂的任务 ——比如视觉识别。

我们之前提到,高阈值的兴奋性McCulloch-Pitts神经元相当于逻辑电路中的“与门”,低阈值的兴奋性McCulloch-Pitts神经元相当于逻辑电路中的“或门”。高阈值的神经元像是木讷的好脾气,不易被激活;而低阈值的神经元像是人群中极易被煽动的坏脾气,容易被激活。

高阈值的神经元对于输入刺激更加挑剔,只对特定输入响应,行为相对简单;而低阈值的神经元的响应门槛很低,对许多相似的输入都会响应,行为相对复杂。换句话说,高阈值神经元试图实现对输入的选择性(selectivity),而低阈值神经元试图捕捉输入中的不变性(invariance)。

选择性和不变性,正是视觉系统的两大特点。我们能够从视野中识别出一块“芝士蛋糕”,依赖于神经系统的选择性将蛋糕的视觉特征和其他物体加以区分;同时,类似于赫拉克利特的河流,受视角、亮度、颜色、位置、背景的影响,我们不能两次看到同样的“芝士蛋糕”,我们需要神经系统抓住“芝士蛋糕”视觉特征的一些不变性,来排除与这一识别过程无关的变量。

神经科学家对视觉皮层的研究,将McCulloch-Pitts神经元的这些计算特性与视觉过程联系起来,并启发了广泛用于计算机视觉的卷积神经网络(convolutional neural networks)。1959年,诺贝尔生理学奖得主大卫·休伯尔(David Hunter Hubel)与托斯坦·威泽尔(Torsten Nils Wiesel)发现大脑初级视觉皮层(V1)中的一类称为“简单细胞”的神经元,能对视野中具有特定空间朝向的刺激选择性地做出反应。一个“简单细胞”会响应接近特定方向的光条,而不响应具有其他方向的光条。

Hubel和Wiesel在麻醉后的猫眼前放一块屏幕,并往屏幕上投射不同朝向的光条。他们将有玻璃包裹的钨丝微电极插入猫的初级视皮层,记录神经元的电活动。他们发现当只有当光条转向特定角度时,“简单细胞”的放电最为强烈。

图片来源于参考文献[2],有修改

休伯尔和威泽尔还在实验中发现,除了“简单细胞”外,V1 还包含另一类称作“复杂细胞”的神经元。它们像“简单细胞”一样,具有方向选择性(orientation selectivity),但它们的反应对刺激光条在感受野(receptive field)内的位置不敏感。这种对位置不敏感的特点很好地建立了“复杂细胞”对于特定光条的位置不变性(location invariance)。而“简单细胞”对刺激光条在其感受野的兴奋性子区域内的具体位置相当敏感。

为了解释V1中的神经元呈现出的方向选择性和位置不变性,休伯尔和威泽尔在1962年的一篇论文中提出了一个神经网络模型。在他们的模型中,“简单细胞”是具有高阈值的McCulloch-Pitts神经元,从外侧膝状核(lateral geniculate nucleus,LGN)中一些感受野沿直线排列的神经元接收输入。如果一束光条恰好有相同的朝向和位置,所有这些LGN神经元就会被激活,从而激活与这些神经元相连的视觉初级皮层中的高阈值的“简单细胞”。

但如果光条的朝向发生变化,则只有这些LGN神经元中的部分被激活,兴奋性的输入总和未达到阈值,“简单细胞”不会被激活。这就实现了“简单细胞”对方向的选择性。

实现“复杂细胞”的位置不变性需要神经网络的层级结构。在Hubel-Wiesel模型中,“复杂细胞” 是具有低阈值的McCulloch-Pitts神经元,它们从一些具有相同方向选择性“简单细胞”接受输入。如果光条的朝向恰好是那些“简单细胞”的偏好刺激,那么至少有对应于一个位置的“简单细胞”会被激活,从而激活低阈值的“复杂细胞”。这解释了为何刺激在感受野中的位置不会影响“复杂细胞”的活动。

如果不考虑抑制性输入,高阈值的 McCulloch-Pitts 神经元相当于执行逻辑合取操作,当且仅当所有输入都为 1 时,输出为 1,否则输出为 0;低阈值的 McCulloch-Pitts 神经元相当于执行逻辑析取操作,当且仅当所有输入都为 0 时,输出为 0,否则输出为 1。不同阈值的 McCulloch-Pitts 神经元,可以用来解释视觉皮层中“简单细胞”和“复杂细胞”的行为。Hubel-Wiesel 模型通过组合高阈值的“简单细胞”和低阈值的“复杂细胞”,实现了视觉系统的方向选择性和位置不变性。

图片来源于参考文献[1],有修改

Hubel-Wiesel 的视觉模型,可以看成是一种神经元民主的层级结构。在视觉系统里有好脾气的“简单公民”和坏脾气的“复杂公民”。好脾气的“简单公民”需要从更基层的LGN神经元听取投诉意见。只有当大量向它汇报的神经元发表了意见,才会引发它的怒火并投出一票。

而“复杂公民”则从“简单公民”那儿收集信息。只要有“简单公民”投票支持,它就无法抑制自己投票的冲动。“简单公民”对意见进行筛选,“复杂公民”对意见进行整合。这种层级化的组合使得神经系统可以实现复杂的特征抽取以及更高级的认知功能。

受Hubel-Wiesel模型的启发,日本计算机科学家福岛邦彦(Kunihiko Fukushima)于1980年设计了一个可以自动识别手写数字的人工神经网络Neocognitron。手写数字可能不像自然图片(例如人类或动物)那样复杂,但是要识别这些数字仍然极具挑战。

由不同人手写的数字通常看起来会非常不同,甚至一个人重复写几次相同的数字也可能有很大的差异。Neocognitron把交替的“简单细胞”和“复杂细胞”作为网络设计的基本结构,来捕捉不同数字之间的特征差异以及相同数字共享的不变特征。

最经典卷积神经网络 — LeNet-5的结构。该神经网络可以用于手写体数字识别,输入为28x28像素的图片,输出的10个神经元分别代表数字0-9中的一类。卷积层的神经元类似于 Hubel-Wiesel 模型中的“简单细胞”,用于实现视觉过程的选择性,池化层中的神经元类似 Hubel-Wiesel 模型中的“复杂细胞”,用于实现视觉过程的不变性。简单细胞和复杂细胞交替的层级结构,帮助神经网络提取关于视觉输入的高级特征。

另一个借鉴了V1中“简单细胞”和“复杂细胞”层级结构例子,就是卷积神经网络的鼻祖LeNet。这一著名的神经网络由图灵奖得主杨立昆(Yann LeCun)于1989年在贝尔实验室设计。卷积神经网络包含交替的卷积层(convolution layer)和池化层(pooling layer)。

卷积层中神经元类似于“简单细胞”,通过对输入的卷积操作,实现视觉过程的选择性,池化层中的神经元则类似“复杂细胞”,将卷积层空间上临近的输出,通过取平均或者取极大值整合为一个神经活动,用于实现视觉过程的不变性。交替的卷积层和池化层,几乎是今天所有用于计算机视觉的深度神经网络的基础模块。

异或问题:神经元民主的逻辑困境

用于单个神经元的民主规则是简单的,McCulloch-Pitts神经元是鼓掌通过式的民主,激活与否取决于活跃的兴奋性突触的多寡;线性阈值神经元是乔治·奥威尔式的民主,有的突触比其他突触享有更大权重。虽然单个神经元的作用很简单,但是神经网络的功能可以很复杂。比如在具有层级结构的神经网络中,神经元之间分布并行的民主互动可以还原大脑视觉初级皮层的信息处理过程。

这种复杂性从简单规则中涌现的奇妙现象,和康威的生命游戏(Conway's game of life),沃夫勒姆的110号规则(Wolfram's rule 110)有着异曲同工之妙,今天已经广为人知,并成为联结主义人工智能的中心思想。但是在神经网络还是新生事物的上世纪60年代,它的普适性接受了一场严酷的考验。这场考验直接将人们对单层神经网络研究推向终结,导致了神经网络的第一次寒冬。

发起这场考验的人,正是大名鼎鼎的“人工智能之父”,图灵奖得主马文·闵斯基(Marvin Lee Minsky)。他在1969年与西摩·佩珀特(Seymour Aubrey Papert)合著的《感知机》(Perceptrons)中,证明了单层的神经网络无法计算“异或问题”(XOR problem)。异或是一种基本的逻辑操作,当且仅当两个事件中有且仅有一者为真时,它们的异或结果为真。许多认知任务都需要进行异或计算,比如判断一个迷宫的连通性。

无论是 McCulloch-Pitts 神经元的民主规则,还是线性阈值神经元的民主,都无法实现奇偶投票规则。神经元的激活特性可以由决策边界刻画。只有线性可分的问题才可被单层神经网络计算。

奇偶判断可以看作是异或问题的延伸。无论是McCulloch-Pitts神经元的民主规则,还是线性阈值神经元的民主,都无法实现奇偶投票规则。即当且仅当被激活的兴奋性神经元个数为奇数时,突触后神经元激活;被激活的兴奋性神经元个数为偶数时,突触后的神经元不活跃。

从几何的角度,神经元的激活特性可以由一条决策边界(decision boundary)刻画(在高维空间中是一个超平面),突触的强度决定了决策边界的斜率,神经元的激发阈值决定了决策边界的截距。只有当刺激落在决策边界的激活一侧时,神经元才会被激活。能被一条决策边界区分的问题叫做线性可分问题。异或问题和奇偶问题恰好是线性不可分的,无论我们如何旋转和平移决策边界,都不能让神经元得到区分奇偶的输出。

神经元民主规则的这一缺陷,直接让神经网络的研究一度陷入停滞。虽然闵斯基等人当时已经注意到,多层的神经网络是可以等价任何逻辑电路,并解决异或问题的,但是用于多层的神经网络训练的算法那时尚未发明,且训练需要大量的计算资源。这些问题在今天都已经被解决。

基于简单民主规则的神经元模型沿用至今已经近80年历史,而最近一篇发表在《科学》杂志上文章表明,或许人类大脑的神经元并不严格遵循这些模型所呈现的计算特性。

人类大脑皮层2/3层的锥体神经元的顶端树突可以进行类似异或的非线性运算,而胞体可以进行与/或等线性运算。

Albert Gidon et al., Dendritic action potentials and computation in human layer 2/3 cortical neurons. Science. 2020. https://science.sciencemag.org/content/367/6473/83/tab-figures-data

和小鼠大脑的神经元相比,科学家发现人类大脑皮层2/3层的锥体神经元,有着非常不同的钙介导树突状动作电位dCaAPs。随着刺激强度的增加,dCaAPs会先激活后减弱强度。也就是说人类锥体神经元的顶端树突可以直接进行非线性的异或运算。

神经元模型是不断发展的,一人一票的民主规则或许只是一个漫长的过渡方案。也许在不久的将来,我们会考虑更多的生物现实,引入新的数学规则,以实现更高智能的神经网络。

阿罗定理:完美民主的不可能性

我们的理智从一片喧嚣中诞生。无论头脑中的那个热闹无比的神经元网络,在外界看来是如何地嘈杂无序,它的内部始终维持着一些松散而高效的秩序。

网络局部的不同拓扑结构,为实现整体的复杂认知功能提供了丰富的组件——线性排列的神经元,形成了支持“刺激-反应”过程的反射弧;环状循环连接的神经元,可以维持神经活动的模式,被看作是工作记忆的实现方式;高低阈值神经元交替的分层连接,解释了视觉的选择性和不变性。网络中的每个神经元并不会做任何复杂的事情,它们都只需遵从一个简单的民主规则,把其他神经元输入的意见整合成自身的意见,然后再输出。

民主的神经元模型从来都不是完美的模型,它局限于线性可分的问题,并且忽略了大量的生物学现实。民主本身也不可能是完美的社会规则。诺贝尔经济学奖得主肯尼斯·阿罗(Kenneth Joseph Arrow),曾提出一个著名的不可能性定理(Arrow's impossibility theorem),证明不可能存在一种完美的社会选择机制,使个人的偏好通过多数票规则转换为社会偏好。

和二元的神经元模型投票不同,在阿罗的投票模型中,每个人都可以把选项按自己的偏好排序。民主的目的是根据每个人的意见,生成一个集体公认偏好排序。他认为“完美”的民主规则需要具备三个性质:

一致性(unanimity),如果所有人认为A比B好,那么在最终排序中也要A比B好;

无关选项独立性(independence of irrelevant alternatives, IIA),如果有人改变偏好,但是A和B的相对位置不变,那么在结果中A和B的相对位置也不应改变;

非独裁(non-dictatorship),最终生成的集体偏好不应该总和某个人的偏好一致。

根据阿罗的证明,我们总是可以构造一些情形,使得这三条必要的性质无法同时满足。如果一个民主规则是满足一致性和IIA的,那么这种规则一定是独裁的。

无法达到的完美或多或少令人有些遗憾和沮丧。但无论是人类社会的公共决策还是神经网络的数学建模,不完美的民主规则却总是能出人意料地运转良好。向不完美的妥协或许比完美本身有更加深远的意义,它揭示了自然的可能性疆界,也成就了人类的奇妙。

参考文献:

[1] Seung HS, and Yuste R. 2012. Appendix E: Neural Networks in Principles of Neural Science, Fifth Edition. McGraw-Hill Education.

[2] Connors B, Bear M, Paradiso M. 2006. Neuroscience: Exploring the Brain, Third Edition. Lippincott Williams and Wilkins.

[3] Hubel DH, Wiesel TN. 1962. Receptive fields, binocular interaction and functional architecture in the cat’s visual cortex. J Physiol 160:106–154.

[4] LeCun Y, Boser B, Denker JS, Henderson D, Howard RE, Hubbard W, Jackel LD. 1989. Backpropagation applied to handwritten zip code recognition. Neural Comput 1:541–551.

[5] Fukushima KM. 1980. Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position. Biol Cybern 36:193–202.

[6] Felleman DJ, Van Essen DC. 1991. Distributed hierarchical processing in the primate cerebral cortex. Cerebr Cortex 1:1–47.

[7] Minsky M, Papert SA. 2017. Perceptrons: An introduction to computational geometry. MIT press.

[8] Gidon A, Zolnik TA, Fidzinski P, Bolduan F, Papoutsi A, Poirazi P, ... & Larkum ME. 2020. Dendritic action potentials and computation in human layer 2/3 cortical neurons. Science, 367(6473), 83-87

本文来自微信公众号:神经现实(ID:neureality),作者:杨闰哲,封面:Matt Chinworth