扫码打开虎嗅APP

本文来自微信公众号:峰瑞资本(ID:freesvc),作者:杨永成(瑞峰资本合伙人),头图来自:

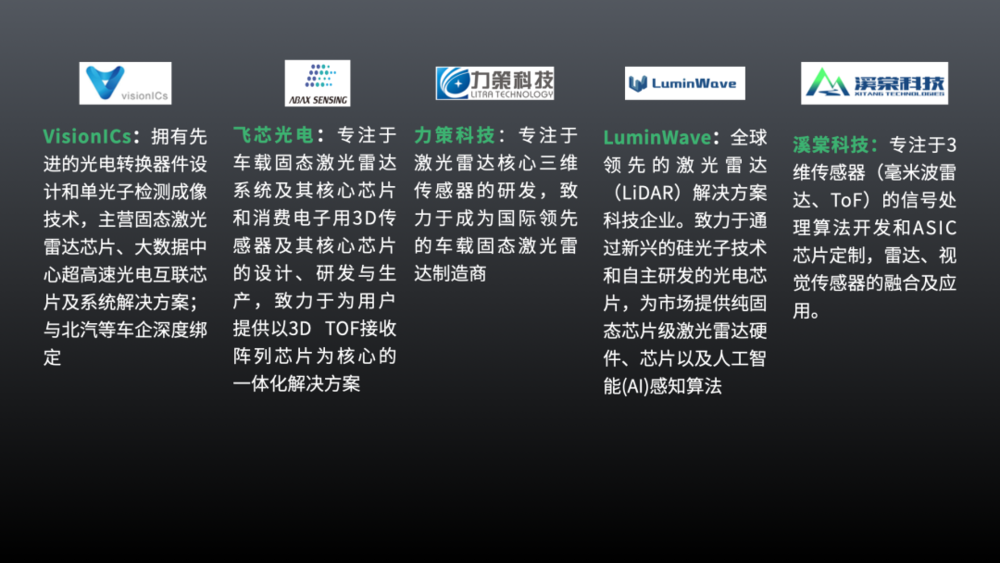

近几年,自动驾驶始终是一个热门话题。百度、华为主打L4技术,小鹏、蔚来等造车新势力比拼自主泊车与ADAS(高级辅助驾驶系统)的推送更新,苹果虽未官宣,但也在研发无人驾驶技术。就此方向,峰瑞资本进行了大量的研究和讨论,并在投资实践中布局了10余个激光雷达、毫米波雷达及上下游项目。

过去几年,我们对自动驾驶行业发展态势的基本判断,主要是以下几点:

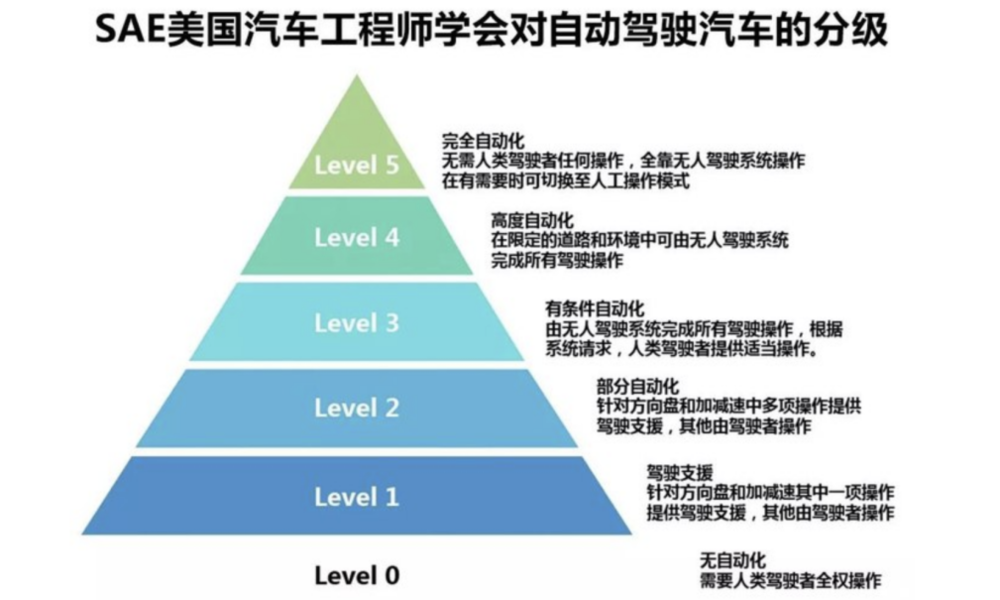

自动驾驶是汽车行业的未来,对这一点要充满信心,但技术和应用的发展是循序渐进的,需要花大量的时间验证、发展,才能到达L3、L4水准。

L3指有条件的自动化;L4指高度自动化,具体可参照SAE汽车工程师学会对自动驾驶汽车的分级。按照北美标准,可能未来要发展到Level5,才能实现理想状态中、无需方向盘的全无人驾驶。

传感器会早于自动驾驶系统完善前上车,并且会从辅助驾驶开始切入,逐渐积累数据、优化系统和技术,由简入难,由辅助、半自动,最终实现高度自主、自动驾驶的L4级别。

传感器维度,始终相信多传感器融合是自动驾驶的最合理配置,主要传感器有摄像头视觉、激光雷达、毫米波雷达。

从过去几年自动驾驶发展的情况看,大量量产汽车已经或多或少具备了辅助驾驶能力,少数品牌甚至有了L3、L4 等级的尝试,各种传感器也开始配置到量产车上,不仅有视觉摄像头,还有毫米波雷达、激光雷达。在这篇里,我们就自动驾驶所涉及的传感器做一些分析,希望能提供新的思考角度。

自动驾驶——多传感器融合背景下的OPA激光雷达

关于自动驾驶的传感器配置,业内主要分歧是:技术趋势到底是单独视觉摄像头,还是摄像头、激光雷达、毫米波雷达多传感器融合。

这个问题之所以很热,又很有争议性,首先在于,自动驾驶技术是一个庞大的软硬件高度融合的技术生态。任何一种传感器的选择,不是独立的硬件选择,它涉及配套的软件、算法还有大规模的AI相关的数据积累,是牵一发而动全身的技术生态的选择。所以,任何一个硬件传感器的引入,都需要投入大量配套的软硬件技术,以及长期的大数据积累,要慎之又慎。

另外,提起传感器配置方案的争议性,则少不了特斯拉对单独摄像头方案的坚持,还有马斯克对技术舆论的引导。依据公开报道,马斯克曾直言,特斯拉的自动驾驶系统过去和未来都不会用激光雷达。根据财经网的报道:“特斯拉CEO马斯克曾经表示,激光雷达就像人身上长了一堆阑尾,阑尾本身的存在基本是无意义的;任何依赖激光雷达的公司都可能无疾而终。”

一、路线之争:为什么多传感器融合未来比单独摄像头更合理?

要想分析清楚自动驾驶传感器的配置问题,回答为什么多传感器融合未来比单独摄像头更合理,我想至少应该先回答以下两个问题:

特斯拉为什么坚持单独摄像头方案?

首先,我们要清楚特斯拉是个汽车品牌厂,或者叫整车厂。特斯拉在汽车产业链的整体定位是整车集成,即选择汽车行业庞大供应体系(Tier 1)里适合自己整车产品定义的汽车组件,比如电机、电控、机械结构、多媒体等,最后组装、生产成汽车。

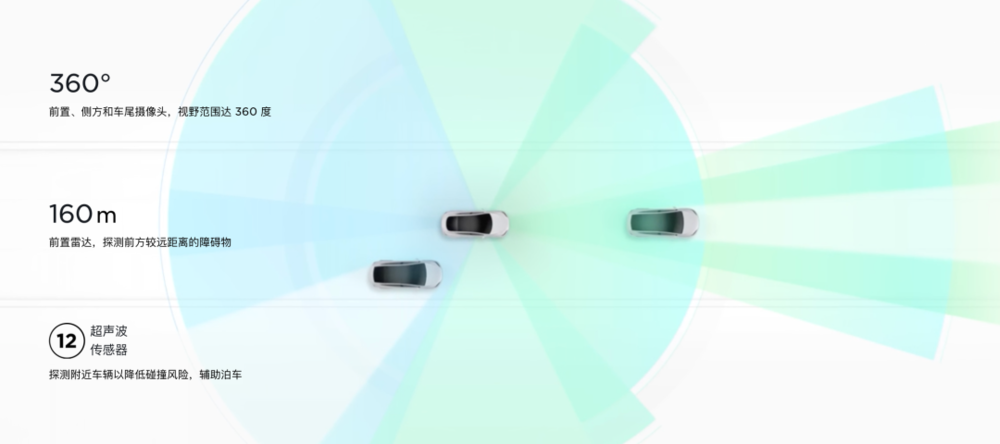

特斯拉 Model S 车型的传感器方案(图片来源:特斯拉官网)

从这个维度看,特斯拉对汽车配件和技术维度应该是“拿来主义的“和“中立的”。那为什么特斯拉会反对多传感器,特别是激光雷达呢?

问题可能出在激光雷达本身:一个是技术还不完善,特别是能生产符合车规标准的真正固体的激光雷达的企业暂不具备量产能力,另一个问题是激光雷达的价格还没有低到合理、普适的位置。一言以蔽之,还没有合适的激光雷达可以上车量产。

由此,假定我们站在特斯拉和马斯克的角度来思考:作为自动驾驶汽车品牌的领导者和自动驾驶概念的最大商业受益者,特斯拉已经有一套视觉摄像头方案量产,获得了市场的认可,同时积累了大量的数据;作为摄像头自动驾驶最成功的商业案例,特斯拉对单独摄像头方案充满信心,并输出这个信心给市场和用户,是完全必须和应该的逻辑。相反,如果这个时候站出来说多传感器融合,多少有可能被“误读”成单独摄像头方案还有些许缺陷和不足,将来需要其他传感器来补充。

对于汽车这种长生命周期的产品而言,这种信息导向,很可能打击一些潜在用户的买车欲望,而客观上市场上又确实没有性价比足够高的固态激光雷达可以供特斯拉采用,作为一个成熟、务实的著名汽车厂,这显然是特斯拉时下不希望看到的“死循环”局面。

既然人类可以只靠肉眼这样单一传感器完成汽车驾驶,为什么AI不能通过视觉摄像头完成自动驾驶?

要想回答这个问题,我们还要对人眼的视觉识别进行稍微深入一点儿的分析。

首先,人眼的视觉是个高度智能化、自动化的复杂系统,具有定焦、对焦、变焦、多区域视觉等等功能。

比如驾驶过程中,我们的视线会在远景、近景切换焦距和成像,并且在即便是近景的情况下,对远景的目标,特别是运动目标也具备检测功能,从而在远处有运动目标的时候,通过调整眼球晶状体将成像面快速切换到远距离目标。

与此同时,我们对于需要特别关注的目标,比如路面障碍物,我们可以“定睛一看”,进行特定区域的细致成像,提供局部目标视觉分辨率。

此外,我们还可以通过颈部、头部的动作,调整我们眼睛的视角和视觉范围,避免视觉死角,同时把视网膜有限的成像分辨率用在特别关注的目标区域的成像。

我们还有高度智能化、自动化的瞳孔“光圈”,控制眼睛的进光量,适用于不同的外界光照情况。

而车载自动驾驶电子摄像头,基本都是固定焦距、固定FOV、固定光圈、固定位置安装的,完全不具备人眼的自动化和灵活性。这也解释了为什么人类可以两只眼睛“包打天下”,而自动驾驶要用十几个甚至二十几个摄像头的原因。

举个例子,安装在车头位置的前向摄像头就需要配置多个,用以负责近距离、中距离,远距离的视觉成像。之所以采用多摄像头分工,而不是采用人眼这种“通用”摄像头,除了成本的考量之外,关键还是要实现人眼类似的智能化、自动化,必然使用大量电机、机械运动、控制部件,比如调整焦距的电机,在汽车这种使用环境里是非常有技术挑战的。原因是,汽车的使用环境高低温工作范围大,运动与震动强烈,而无故障运行时间要求很长。

小结一下,由于汽车使用环境的严酷性,大家最终选择了“固态”摄像头,而当前这个“固态”摄像头的智能化、自动化、灵活性水平,和人眼相对比还有很大的差距。

另外,在测量距离这个指标上,摄像头视觉甚至包括人眼,对比起激光雷达都有巨大的劣势。因为从获取距离(深度)信息的原理上,不同于激光雷达的直接测量法,视觉测距的实际精度和准确性都与被测物体,以及背景图像的特点有很大的相关性,这种测距原理,在特殊的背景和目标场景下,就有可能会出现测距算法失效的可能性。

而人眼还可以通过歪歪头等“机械”动作,调整一下视角,获取不同角度的图像,提高三角测距法的准确性。

即便如此,人眼对距离感知,对低照度也有先天的不足。好在从进化论的角度,人眼的视觉能力足以“应付”我们进化历史上漫长的“靠腿运动”的“低速” 时代。而汽车这种高速运动的机器诞生的时间,与人类的历史相比极其短暂。

那么,在人类的视觉还没有进化出(或许也不可能进化出)新的传感器功能之前,我们借用一下激光雷达、毫米波雷达这样有专长的传感器测测距离,也许是合理和聪明的选择。就像我们在没有野生动物夜视能力的情况下,可以借用手电筒、汽车大灯,来走暗夜中的漫漫长路一样。

所以,多传感器融合对自动驾驶应该是一个合理和几乎必然的趋势。至于哪种传感器在自动驾驶算法上起的的作用更大,可能不是传感器企业最关心的事情,而是做算法的人更关心的事情。

二、传感的原理:摄像头、毫米波雷达和激光雷达

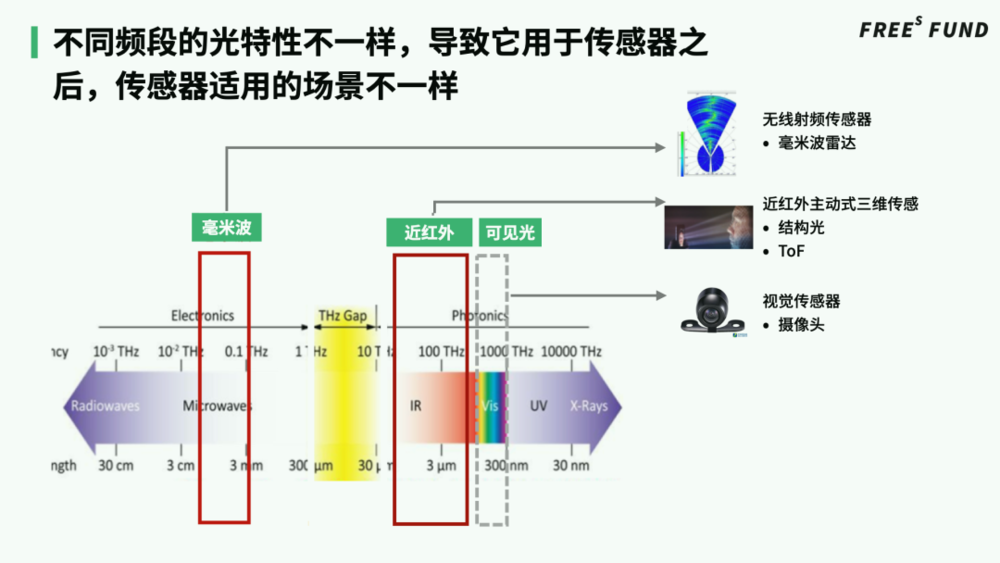

谈到自动驾驶的多传感器融合,主要的还是摄像头、毫米波雷达和激光雷达。关于这三种传感器的大致特点和优缺点,行业里有很多讨论,我们就不赘述了。

需要补充一点的是,从传感的原理上,摄像头和激光雷达本质上都是光学成像。摄像头主要是可见光成像,可借助阳光、路灯、车灯等光源,更容易获得比较高的平面分辨率;而激光雷达使用自己的专用光源,通常是不可见光的红外激光光源,优势在于获得目标距离(深度)的信息;也因为激光雷达使用自带的红外激光光源,具有窄带光谱的特性,天生比自然光成像具有更好的抗干扰性。

同时,因为自发光激光光源的相干性特点,可以采用光通讯行业长期积累的相干接收的技术成果,获得更高的信噪比,在测距的同时获得更多的测量数据,比如目标的运动速度,这也是行业里看好调频连续波(FMCW) 技术的主要原因。

而毫米波雷达使用的是不同于光频谱的无线电波,在雨、雾、霾等恶劣气候下有非常明显的优势作用。但目前毫米波雷达在平面分辨率和距离分辨率上还不如摄像头和激光雷达。毫米波雷达如果要提高以上两个分辨率,需要使用更多的通道和天线单元,加大通讯带宽,提高射频频段,这需要新的技术努力,并且在成本控制上也会有新的挑战。

激光雷达是最晚进入汽车行业、同时也是讨论热度最高的传感器。从全球领先的激光雷达公司Velodyne多线机械扫描雷达开始,众多创业团队尝试了MEMs激光雷达、Flash(TOF)面阵成像、OPA相控阵激光扫描等多种技术方案。

努力的方向是两个:一是降低成本,二是尽力减少机械运动部件,实现固态激光雷达,以满足汽车恶劣的工作环境和超长的无故障工作时间要求。

三、激光雷达:ToF、OPA之争

从技术维度看,Flash(TOF)面阵成像和OPA相控阵技术方案无疑是更接近理想固态构架的方案,因为它们都是基于半导体芯片技术。

而MEMS技术(Micro-Electro-Mechanical System,也叫做微电子机械系统、微系统、微机械等)虽然也使用半导体工艺和技术,但由于在芯片内部使用了微电机构建的振镜作为激光束控制方向的部件,本质上还是包含一个机械运动部件,同时想在微小尺寸的振镜上实现线性很好的扫描线控制和大的扫描角度也面临许多技术挑战。

Flash(快闪)激光雷达技术是最接近摄像头技术的方案,可以利用摄像头行业很多成熟的技术和工艺成果。但是,由于Flash激光雷达使用面阵的光源,由于人眼安全标准等现实限制,Flash 激光雷达更适用近距离、中距离的应用场景。

苹果在2020年推出的iPad Pro上使用了激光雷达,在扫描方式上,苹果选择的是Flash方案。激光雷达利用直接飞行时间 (dToF),测量室内或室外环境中从最远五米处反射回来的光。单光子dToF技术是未来实现激光雷达(LiDAR)小型化、低成本、可量产的一项关键技术。

OPA激光雷达是被行业最寄予厚望的技术方向。它的原理是,通过控制纳米天线阵列中每个天线的发射信号相位,使得不同天线单元的信号互相干涉,从而控制输出的激光束的方向。它是原理上最接近射频频段相控阵雷达的技术,如果能够实现芯片化,将是目前能看到的最理想的纯固态激光雷达技术路线。

除了纯固态的优点,由于OPA激光雷达是由电信号完全控制激光扫描方向,能够动态地调节扫描角度范围,对目标区域,进行全局扫描或者某一区域的局部精细化扫描,一个激光雷达就可能覆盖近距离、中距离、远距离的目标、距离探测,如果和FMCW技术相结合,还可以直接提供目标的运动速度。

换句话说,OPA激光雷达没有采用任何机械运动部件,却实现了类似人眼视觉的机动性、灵活性。

在OPA技术的发展进程中,基于液晶材料的空间光调制(spatial light modulator,SLM)技术,曾经是重要的技术探索方向之一,但是液晶SLM扫描速度非常慢(毫秒级别),远远满足不了自动驾驶快速成像的要求。

本篇总结

多传感器融合对自动驾驶应该是一个合理和几乎必然的趋势。目前“固态”摄像头的智能化、自动化、灵活性水平,和人眼相对比还有很大的差距。另外,在测量距离这个指标上,摄像头视觉甚至包括人眼,对比起激光雷达都有巨大的劣势。因此,多传感器融合,利用摄像头、毫米波雷达和激光雷达各类传感器的优势,是目前自动驾驶领域较为可行的方案。

激光雷达是最晚进入汽车行业、同时也是讨论热度最高的传感器。目前激光雷达行业主要往两个方向努力:一是降低成本,二是尽力减少机械运动部件,实现固态激光雷达,以满足汽车恶劣的工作环境和超长的无故障工作时间要求。

从技术维度看,Flash(TOF)面阵成像和OPA相控阵技术方案无疑是更接近理想固态构架的方案,它们都是基于半导体芯片技术。

本文来自微信公众号:峰瑞资本(ID:freesvc),作者:杨永成