扫码打开虎嗅APP

科幻作品中我们经常能够看到与人类一样聪明的机器人,但机器是如何在这背后存储知识的?是如何推理知识并运用知识的?最后又是如何实现与人的交互的?此次在的百度BIG大会上,百度技术副总王海峰博士总结了实现人工智能的三大关键技术,基本回答了这些问题,虽然讲的比较简单,但由于信息量过大没有一定背景的人是很难听懂的,所以我纯粹来给各位科普下。

关键一,让机器理解语言的技术

理解语言是一个从词语逐渐递进到事件的过程。

1,分词技术

让机器理解语言,也就是要让机器学会自己思考,那么就需要让机器去理解语言。而汉语的

理解与英语相比起来就显得更加困难,在英语中每个单词都是基本上可以被机器直接读取的,但是汉语在分词上则更为困难。我们来举几个列子。

“你|老张|着什么急|啊”

“你|老张着|什么嘴|啊”

上面是一个简单的列子,修改一个字,意思就相差十万八千里,而机器根据字的不同则可以勉强分出来。但是下面这个列子就折腾了。

“乒乓球拍卖完了”

机器该怎么分?这就困难了,机器既可以分出两种意思

“乒乓球|拍卖|完了”

“乒乓|球拍|卖完了”

那么困难就来了,我们如何告诉机器这句话中的词该怎么分呢?对于人来说很简单,根据前后文马上就能识别出来,但是对于机器来说则极为艰难。

2,句子的分析技术

分词问题解决之后便是分析句子的问题,请看下面两句

“谢霆锋|是谁|儿子”

“谢霆锋|儿子|是谁”

对于机器来说,这两句话获得的关键分词信息是一样的,都是“谢霆锋”、“是谁”、“儿子”,这三个关键分词信息。我们该如何告诉计算机,因为顺序先后的原因而导致的语义的天差地别呢?

这其中就需要对语言有很深入的分析,对语义理解,从而知道他们要找的答案是不一样。做到这单同样不容易。

3,上下文相关的分析技术

分析完一句话后,机器自然要推演到分析一篇文章的内容。

在《信息简史》中有一个很重要的信息原理,就是说当我们需要传递信息时,需要大量的冗余信息来保障信息的准确性,没用的废话越多则传递信息的准确性越高,同样对于让机器理解某句话也是基于同样原理。

但问题是,人可以依靠直觉抓取关键信息,而机器又凭借什么来抓取关键信息呢?又如何识别真正的信号与噪声?这也是至关重要的技术。

我们看以下三个列子

我们看到当搜索“天空为什么是蓝色的”时,百度并没有把文章前半部分的内容放上去,而是自动摘取了中间的关键答案,而当用搜狗搜索和360搜索时,并没有摘要出最优答案,只是把文章的前半部分内容放了上去。这说明搜狗和360搜索还有可以继续提升的空间。

4,分析事件的技术

分析文章的问题解决后就必须再攀登更高的高度,让机器去系统性的分析一个事件,也就是再加上时间的这个维度,将与某个事件相关关键的文章全部集合,就可以还原一个历史事件的进程。

当我们搜索“斯诺登”时,就会出现以下按照时间轴展开的标题。

左边是百度的事件整理,中间是360的事件整理,最右边是搜狗搜索的结果。

在事件归类的技术上,百度与360都已能够做到识别,而搜狗目前没有做到这点。

事件整理是最高难度的技术,也是如何做到让机器理解语言的最高一层。

关键二,知识挖掘技术

1,知识图谱的建立技术

首先假设,我们在机器中存储了上亿个实体知识,这对于机器来说不是难事,轻而易举,难就难在存储实体的关系上,一个实体对应多个属性,比如一张桌子对应了品牌、颜色、木材等等属性,这些属性就有上百亿级别,这些关系错综复杂的整合起来,要存储的数据就会指数级的增加,这注定是一张超级的海量级图谱。

如何建立起图谱?以以下这句话来举例

“奢侈品牌路易威登1854年成立法国巴黎”

那么机器该如何进行知识的存储呢?

1)奢侈品与路易威登(识别出路易威登是个品牌并且是奢侈品,存储该知识)

2)路易威登与1854年成立(识别出路易威登的成立时间,存储该知识)

3)路易威登成立于法国巴黎(识别出路易威登成立于发过,,存储该知识)

4)法国巴黎(识别出法国与巴黎有关系,存储该知识)

5)……

以上只是一种粗略的理想化的情景,王博士也没有说更细节的事情。我这里补充下,实际上这种只是图谱一直是动态的,有不断的增加删减的过程,每个语句中的知识都是按照时间线出现的大数据关键词内容,根据统计后才建立起的知识图谱,与人脑一样,这些关系知识图谱出现又消失,最后那些确凿无疑的关系被留了下来,但是这些依然是动态的,如果哪天法国的首都不再是巴黎,整个关系知识图谱数据库会将所有数据全部更新。

2,知识推理技术

当知识图谱建立后,要做的就是实际层面的应用,将这些知识图谱应用到真正的实现中,当用户搜索某个问题后,去检索数据库中的关系图谱,然后将关联性最高的精确答案呈现给用户

1)直接推理。

我们以搜索“刘德华多少岁了”来举例。

当我们搜索这个问题后,搜索结果中就会直接呈现出了刘德华的年龄,这就是运用了知识的推理能力。这个53岁是一个动态结果,机器在幕后进行了大量的运算后知道获得年龄是一个动态的算法,需要将此人的生日与当前时间相减,之后才能得出结论。

同样的,当我们搜索“谢霆锋儿子的母亲的前夫的父亲”后得出是“谢贤”的结果,这也是技术在背后的推理的作用。

2)分类推理

上面谈了比较简单直观的推理模型,但这只是在用户提问有确定唯一结果答案的时候才那么奏效,但当用户搜索某个没有唯一标准答案的问题时就不再奏效。那么这里就会用到分类推理的技术。

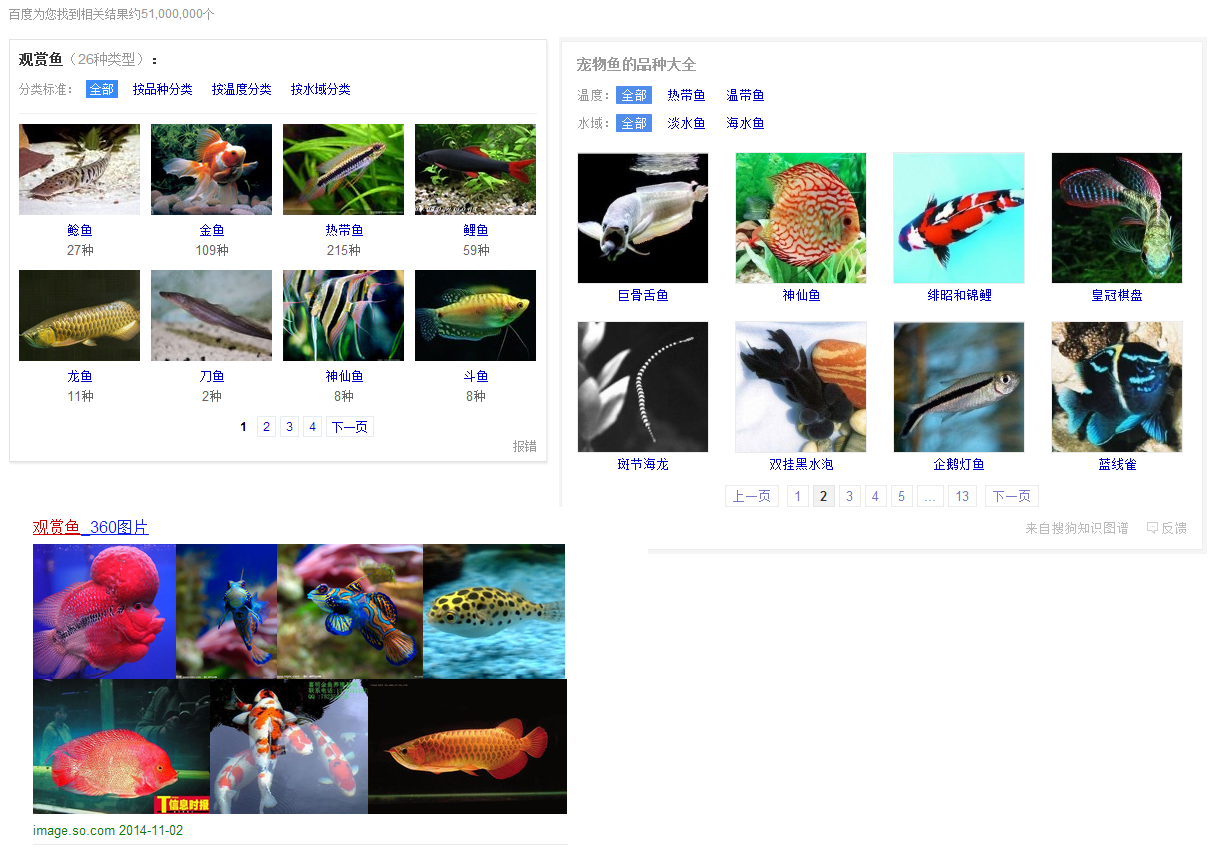

比如当用户搜索搜索“观赏鱼”。

这种搜索没有指定的唯一标准答案,所以机器从后台的知识体系库中提取了关于“观赏鱼”的相关分类内容,列出了所有相关结果,给出了各个观赏鱼的种类结果,好让用户去找到自己想要的结果。在这里又顺便将三个搜索结果做了比较,百度的搜索结果最为全面,搜狗次之,而360没有分类。

通过大数据,在后台为实体知识进行分类,这是一种在线性的直接推理之上的高层次整合式的推理。

分类推理除了能够提供直接的结果之外,还能够为用户带来额外的相关性的具有帮助的结果,当我们搜索“关羽”时,在搜索结果右侧会展示出如下结果。

左上角是百度的结果,右上角是360的搜索结果,左下角是搜狗的搜索结果。

而这些结果都不是人工输入的,全部都是通过大数据挖掘得出的结果,三家都能够挖掘出与”关羽“相关的信息,但百度挖的更深,把关羽与刘备以及貂蝉的关系都挖了出来。这种对隐性信息挖掘是大数据价值的核心,大数据的价值不在于大,而在于挖掘有价值的关联,然后拉动其他价值。举个简单的例子,通过大数据发掘,发现下面包店某款面包会卖的更好,存在这么一种隐性关联,那么店主只需要准备更多的该蛋糕就能带来更多的收益。

关键三,对人的建模技术

机器发展出智能的最终目的是为了与人交互,所以还需要让机器能够理解人的行为,只有当理解完人的行为后机器才有可能将知识运用到与用户的交互中,才有最终商业化落地的价值。

1,个体建模

所谓个体建模,就是说根据某单个用户的操作行为为其提供私人定制化的服务。“今日头条”就是用的个体建模技术,当用户查看新闻时,它会根据用户的行为轨迹,为用户推荐其感兴趣的内容。同样的,在百度搜索引擎中同样如此,当用户搜索的关键词越多,百度就越有能力向其推荐其更为感兴趣的内容。

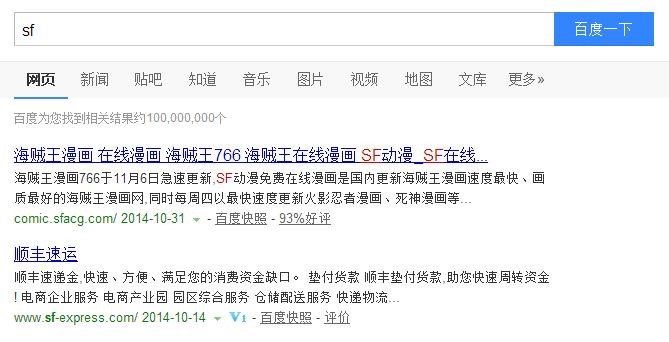

比如当用户搜索“SF”关键词后。

如果该用户经常逛百度动漫相关贴吧,搜索相关动漫人物名称,音乐等等操作,那么排序在第一位的就会是某个关于动漫的网站,但是如果该用户经常搜索与快递相关的知识,那么排在第一位的就会是顺丰网站。

这种针对个人的精准建模在未来数据更加充足的情况下,每个人都将获得数据化的留存,我们的一切行为都将数据化可视化,进而得出自己的一切相关结论。当前数据采集并建模这种技术已经趋于成熟,剩下的就等物联网大潮上阵。

2,群体建模

光对个人建模还不够,机器最重要的是对群体建模,而对群体建模也是商业化价值的核心所在。

所谓群体建模,就是判断在某一场景下最多数人的行为进行收集,然后取得各个场景下的群体交集,进而得出拥有某一部分属性的人经常会做出哪些选择。

这些人的属性包括:地域、漫画爱好者、美剧爱好者、父亲、高考学生……

这些人的行为包括:看动漫、看美剧、搜索育儿知识、搜索高考知识……

机器通过后台的判断将他们进行群体人群的属性与行为的归类,然后让相关高层找到可以进行商业化决策的支撑。

上面说的还是有点抽象,那我们再说的简单点,比如我们通过大数据挖掘预测某个地域30岁以上的人在最近一段时间有很强的购买秋裤的需求,那么商家在推广秋裤的时候只需要加大在该地区的广告投放即可获得更高的利润回报。当然这里不再是商家主动去找答案,而是机器通过挖掘后主动为其提供一系列选项,商家只需要被动接受即可。

结语:

从某种意义上来看,让机器理解语言的技术、知识挖掘技术、对人的建模技术这三大技术再经过一段时间的发展后,对破解图灵测试是有可能的。

但这种技术无论如何进步都需要驱动的“电池”,也就是人类所产生的数据,说的更确切一些是人类的欲望。

在我看来,驱动技术的唯有商业与军事这二者,而这二者分别代表着欲望与恐惧,在这个和平年代的我们是幸运的,我们被免去了战争的恐惧,进而剩下的就是无尽的欲望,在技术与人越来越紧密不可分割的纠缠中,我们将迎来一个欲望与技术超级混合的新世界。

未来会怎样?请关注微信公众号“机器之心”。