扫码打开虎嗅APP

本文来自微信公众号:新智元(ID:AI_era),编辑:梦佳、雅新,头图来自:视觉中国

作者注:人工智能的智力水平一朝一日会和人类平起平坐吗?图灵奖得主Yoshua Bengio和Yann LeCun在本届2020 ICLR大会上发表观点称,自监督学习有望使AI产生类人的推理能力。Bengio相信机器最终将习得关于这个世界的各种知识,不需要机器去亲身体验,而是通过习得语言化的知识来实现。

在2020的ICLR线上大会上,蒙特利尔学习算法研究所主任、图灵奖得主Yoshua Bengio和Facebook 的副总裁兼首席人工智能科学家Yann LeCun,坦率地谈到了未来AI的研究趋势。

根据两位大咖的说法,自我监督学习可能使AI产生类人的推理能力。

自监督学习,像人一样自觉观察世界

监督式学习需要在有标注的数据集上训练AI模型,而 LeCun 认为随着自我监督学习的广泛应用,这种训练模式的作用将逐渐减弱。自监督学习算法不再依赖标注,而是通过揭示数据各部分之间的关系,从数据中生成标签。

自监督学习是一种机器学习的「理想状态」,重点在于如何自动生成数据标签,这一步骤被认为对于实现人类水平的智能至关重要。举一个例子,例如输入一张图片,把图片随机旋转一个角度,然后把旋转后的图片作为输入,随机旋转的角度作为标签。

很多网友比较关注的一个问题是,自监督学习和无监督学习是一个意思吗?

自监督类似无监督学习,都是从没有明确标签的数据中进行学习。但无监督学习侧重于学习数据的内在关系、结构,比如clustering、grouping、density estimation, or anomaly detection等等,而自监督是根据数据集本身生成标签。

为了进一步解释自监督学习,LeCun做了类比,「不管是我们人类,还是动物,在学习大多数事物时,都是在自我监督的模式下进行的,而不是强化学习模式。这个模式本质上就是观察这个世界,然后不断与之增进互动,这种观察是自发的,而不是在测试条件下完成的。」LeCun表示, 「这种学习方式,比较难以用机器来复制。」

其中,不确定性是阻碍自监督学习成功的主要障碍。

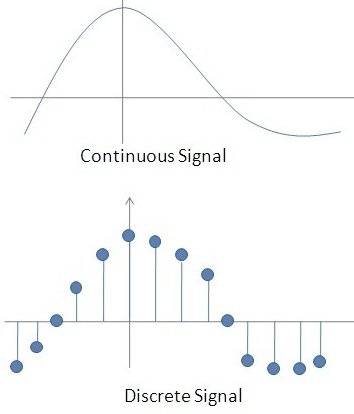

连续分布和离散分布

数据的分布是这样一个表,它将变量所有可能的值与其出现的概率联系起来。在变量是离散的情况下,它们可以很好地表示不确定性,这就是为什么像Google BERT这样的架构如此成功。但目前,研究人员尚未找到一种方法来有效地表示连续变量的分布。

在斯坦福对话问答数据集上测试时,BERT 实现了93.2% 的准确率,分别优于最先进的机器学习水平和人类水平 。斯坦福问答数据集是一个阅读理解的数据集,包含了一组维基百科文章中提出的问题。在通用语言理解评估基准测试(一个用于培训和评估NLP系统的资源集合上,BERT的准确率达到了80.4% 。

解决连续分布问题

LeCun认为,找到一种能表示连续分布的模型,就会有新突破。

Lecun 指出,连续分布问题的一个解决方案是利用基于能量的模型(EBM),它能够学习数据集中的数学元素,并生成类似的数据集。

此前,OpenAI开发了一种基于能量的模型,可以快速学会识别和生成概念,例如附近,上,中,最近和最远等,并表示为2D点集。模型仅在五次演示后学习了这些概念。

从过去的研究中看,这种形式的建模一直难以应用到实际当中,但Open AI 2019年的研究表明,这种基于能量的模型可以支持复杂的拓扑(topologies)。

Bengio 在研讨中表示,他相信人工智能研究可以从神经科学领域受益颇多,特别是意识和意识处理的探索方面。当然收益也是双向的,一些神经科学家正在使用卷积神经网络作为视觉系统的腹侧通路。

Bengio预测,新的研究将阐明高级语义变量与大脑如何处理信息(包括视觉信息)之间的关系。而这些变量是人类语言交流所用的,它们可能会衍生出新一代的深度学习模型。

「通过与基础语言学习相结合,我们可以取得很多进展,归根结底我们都在打造能够理解这个世界的模型,以及高层次的概念是如何相互关联的。这是一种联合式的分布,」Bengio 说。「我相信,人类的意识处理过程,利用的是有关世界如何变化的假设,这些假设可以理解成为一种更高层次的表达方式。简单来讲,就是我们看到世界的变化,然后想到一句话来解释这种变化。」

达到人类智力的另一难题:背景知识

想要实现人类智力,另一大难题就是背景知识。正如 LeCun 所解释的,大多数人可以在30小时内学会驾驶汽车,因为他们已经凭借直觉构建了一个关于汽车行动方式的物理模型。相比之下,现在无人驾驶汽车所采用的强化学习模型要从零开始学起---- 他们必须犯上成千上万次的错误,才能做出正确的操作。

LeCun表示,「显然,我们需要能够构建模型来学习世界,这就是进行自监督学习的原因——运行预测世界模型,能够让系统进行更快地学习。从概念上讲,这相当简单,除非是在那些我们无法完全预测的不确定环境中。」

LeCun 认为,想要实现通用人工智能(AGI),就算有自监督学习和神经科学学习的加持,也是不够的。

通用人工智能(AGI )是指机器获得人类水平的智能。一些研究人员将通用人工智能称为强AI(strong AI)或者完全AI(full AI),或称机器具有执行通用智能行为(general intelligent action)的能力。

他表示,这是因为智力,尤其是人类的智力,是非常特殊的。「AGI 是不存在的,根本没有通用人工智能这回事。我们可以谈论老鼠水平的智力、猫的智力、狗的智力,或者人类的智力,但还根本谈不上通用人工智能。」LeCun说。

但是Bengio相信机器最终将习得关于这个世界的各种知识,这个过程不需要机器去亲身体验,而是通过习得可以语言化的知识来实现。

「我认为这也是人类的一个巨大优势,相比于其他动物来说,」他说。「我认为,人类之所以聪明,是因为我们有我们自己的文化,让我们能够解决这个世界的问题。要想让人工智能在现实世界中发挥作用,我们需要它不仅仅是能够翻译的机器,而是能够真正理解自然语言的机器。」

自监督学习是AI的未来

自监督学习背后的核心想法,是开发一种深度学习系统,可以通过学习填补AI未知的领域。

LeCun曾在今年四月份AAAI会议演讲中谈到,「我认为自监督学习是AI的未来。这将使我们的AI系统,深度学习系统更上一层楼,或许AI可以通过观察获取有关世界足够多的背景知识,从而形成一些基本常识。」

自我监督学习的主要好处之一是AI能够主动输出巨大的信息量。在强化学习中,训练AI系统是在标量级别执行的,模型会收到一个数值作为对其行为的奖励或惩罚。在监督学习中,AI系统为每个输入结果预测类别或数值。

在自监督学习中,输出结果将涉及到整个图像或是一组图像,「自监督学习输出的信息量很大。要让AI学习相同量的有关世界的知识,自监督学习需要的样本量也更少。」 LeCun说。

我们必须弄清楚不确定性问题是如何运作的,当寻到解决方案时,我们将会解锁AI未来的关键。

LeCun说,「如果说人工智能是一块蛋糕,那么自监督学习就是其中最大的一块。」

参考链接:

https://venturebeat.com/2020/05/02/yann-lecun-and-yoshua-bengio-self-supervised-learning-is-the-key-to-human-level-intelligence/