扫码打开虎嗅APP

本文来自微信公众号:造就(ID:xingshu100),演讲:陈静(南京大学艺术系副教授),题图来自:电影《银翼杀手2049》

今天和大家分享关于人工智能与性别偏见的话题,看到这样的题目,可能会有人好奇,人工智能与性别究竟有着什么样的关系?

我们先来看一个新闻,上个月在美国,黑人乔治·弗洛伊德(George Floyd)在警察的逮捕行动当中死亡,在美国引起了很大的抗议、示威和骚乱。

之后,微软发表声明,提出以后将终止向美国的警察机构出售他们的面部识别技术。他们谈到,“我们今天决定不向美国警方出售我们的面部识别技术,除非未来有以人权为基础的、强有力的国家法律出台,否则我们不再考虑”。

微软发布的声明

与此同时,其他商业巨头如亚马逊和IBM都发出了类似的声明。IBM的首席执行官明确谈到,“IBM坚决反对也不会容忍包括面部识别技术在内的任何技术用于大规模监控、种族定性、侵犯基本人权与自由,或其他任何不符合我们价值观和信任与透明原则的目的”。

IBM的声明

这是非常有意思的新闻,它让我们想到近年来以面部识别为代表的人工智能技术所具有的高风险性,这种风险很容易被人们在使用技术、享受技术便利的同时忽略。

人工智能技术的风险性

用户在使用或者被要求使用人工智能技术时,如何确保个人隐私的安全性?如何能够确保不会因为不良的技术操作而导致性别、种族等方面的身份歧视?又如何确保技术获取的各种信息能够被正当合理地使用?

一、算法中的偏见是怎样产生的?

实际上,这一系列问题都引起了大家的反思和质疑,所有故事必须要从头谈起,我们看下面这张图。

AI对新娘图片的判断

图片里有两位新娘,左边是穿着白色婚纱,戴着皇冠的新娘,右边同样是一位穿着传统礼服的新娘。人类是非常容易识别出,她们穿着漂亮的礼服正在进行仪式性的活动。但计算机通过它的算法识别出来的,却是左边是穿着礼服正在进行婚礼仪式的新娘,右边的关键词是“表演艺术”“戏服”。

为什么会有这样的差异?

实际上,这个算法是深度学习的算法,它是基于包含1400万图片的ImageNet数据库建立的。ImageNet数据库是由斯坦福大学的李飞飞教授和她的团队,历经多年通过她自己、学生打标签,以及人们在亚马逊的众包平台上进行公众打标签所形成的数据集。

我们来具体看看,1400万张打了标签的图片究竟来自于哪里:美国占比45.4%,而美国的人口在全世界只占4%;其他国家占比37.8%,这里边包括中国和印度,而中国和印度的人口占到全世界的36%;同时,来自英国、意大利、加拿大的图片占比也是相对较多的,整体来讲,我们会发现白人世界占据了大部分。

白人世界占据了大部分

这说明了什么?说明我们是在以非常小的样本去训练算法,同时将基于小样本的算法放到更大的范围去进行试用,这个过程当中就造成了偏差。计算机或算法是无法准确地根据它所习得的能力进行更大范围的识别,但我们却基于这种算法开发了更多的应用。

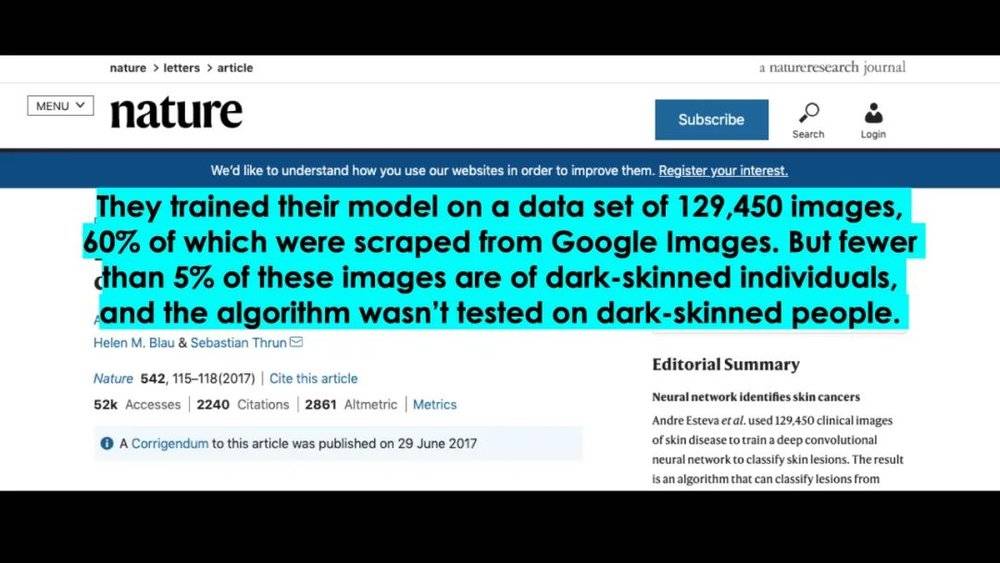

那是不是只有ImageNet数据库是这样?其实不然,我们再看另一个发表在Nature上面的用深度神经网络进行皮肤癌测试的研究。

Nature上发表的用深度神经网络进行皮肤癌测试的研究

当时他们用了很多谷歌的图片,但是谷歌图片当中只有不到5%是来自黑色人种,所以算法就没有办法测试深皮肤人群。我们发现,数据由于抽样、选择标准、应用范围等因素,使得算法本身就有缺陷,因此我们要反思:这些数据并不客观,是经过人工筛选的,甚至在数据的内部都有偏见。

ImageNet数据库的算法是基于WordNet的算法用同样的逻辑来处理图片的,因此WordNet中的偏见也被保留下来。那它的开发者有没有意识到呢?答案是有。

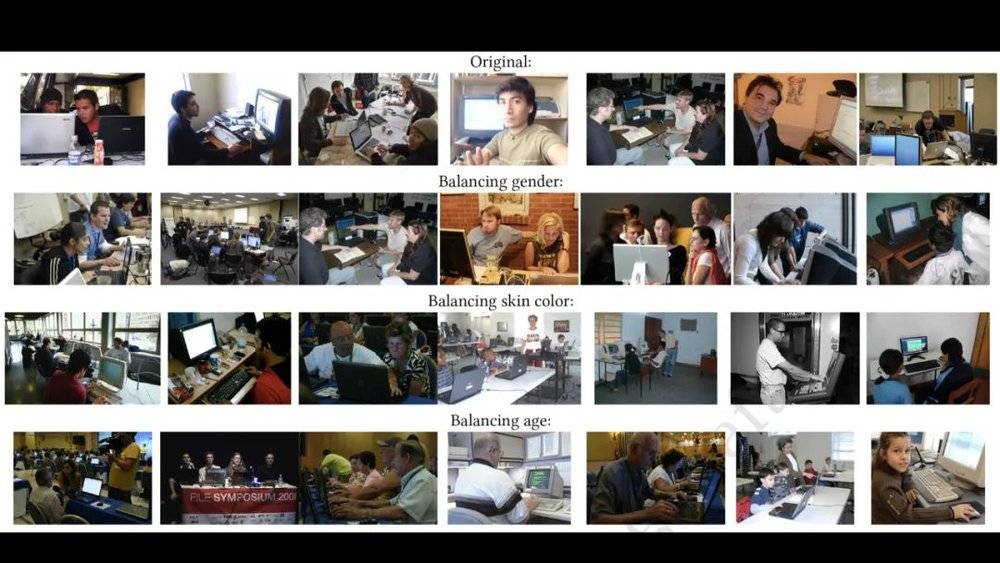

2019年,李飞飞团队专门对所有的数据集进行纠正,试图去筛选和平衡数据结构当中“人”出现时的一些情况。

对数据集进行纠正

比如说最上面一行是Original,就是最原初的图,我们可以看到所有的工作场景中间主要的都是男性,而且一般都会伴随着他的办公桌、电脑、同事,往往他的同事也是以男性居多。

他们首先要平衡的是什么?是性别。他们会在办公场景中有意识地放入有女性形象的图片,以确保让计算机学会识别工作场景的时候不仅仅只有男性。

第二个去平衡的是肤色。让不同人种、不同肤色的人出现在办公场景当中。

第三个去平衡的是年龄。从幼年到老年,不同年龄段的人都能被选择到数据库里面。

他们的目的就是让图片的数据更加多元,更加兼容不同的语境,更加兼容种族、性别、年龄的多样性,但是这样的努力是不是真的能够起作用,现在还不得而知。

ImageNet不是唯一的照片集,算法中的偏见更多是基于算法的开发以及算法本身。

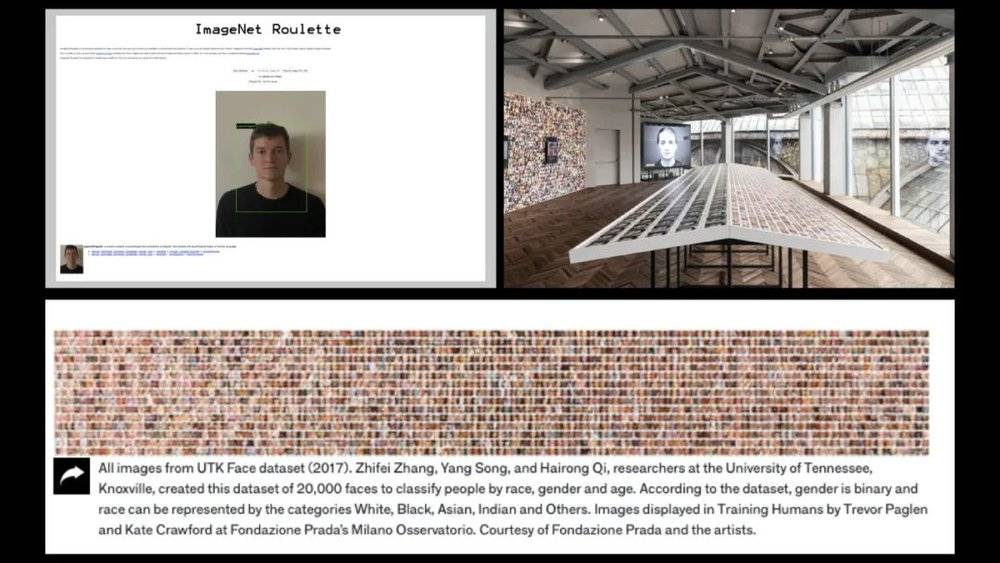

这里要谈到两个非常有意思的科学家,也是艺术家,他们做了一个很有意思的项目叫做ImageNet Roulette。

ImageNet Roulette项目

就是把历史上有计算机技术以来,人们对人脸识别所进行的努力做了一个展示。除了使用ImageNet数据集之外,他们还选择了另外一个叫做UTK Face的数据集。这个数据集当中也包含了大量的以人脸图片为主的数据,基于这些数据做艺术化的表达。两位艺术家想说明的是,人们习以为常的,仅作为技术来看待的面部识别技术,背后隐藏着非常大的文化、身份、种族的偏见。

除了训练数据,在算法过程当中,本身也具有着偏见,因为人工智能算法的背后是人,算法的开发及应用中都有着非常大量的人工因素与人为判断。

二、人工智能固化了我们的性别偏见?

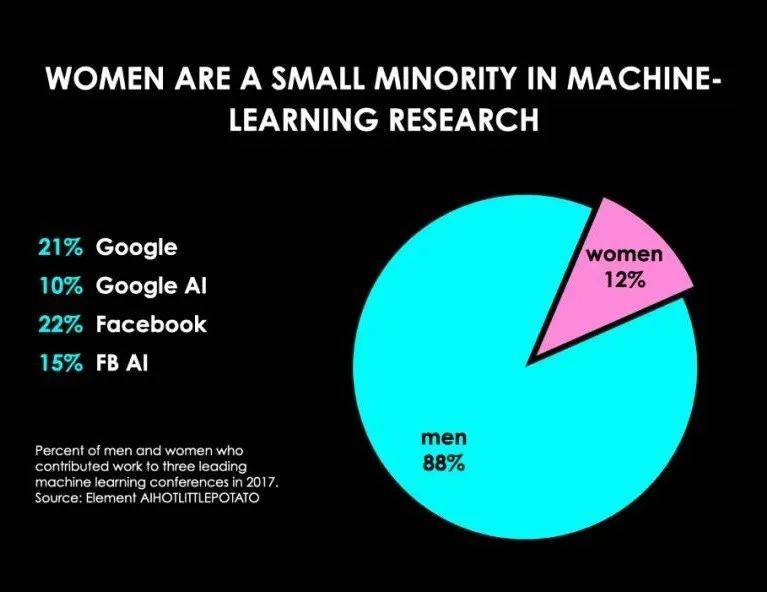

在谷歌的技术部中有21%是女性,其中人工智能部只有10%是女性。Facebook的技术员工中22%是女性,但只有15%的女性从事人工智能领域。

在机器学习领域,女性是少数群体

因此可以看到,算法背后的开发人员本身就包含着非常大的性别差异,并不是说男性程序员就一定有性别偏见,我想强调的是:当工作的人群性别更加平衡、更加均衡的时候,才可能会让性别意识更加地凸显,大家才会比较主动地关注性别差异问题。

这是算法背后的人,那算法本身是怎样的呢?

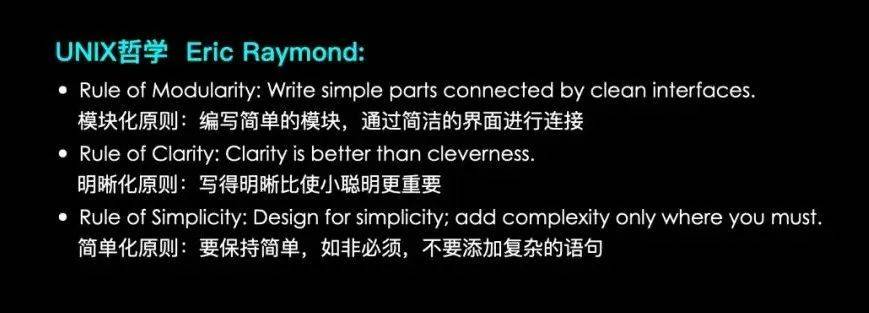

我们往前回溯,回到比较早的开源语言——Unix,它在计算机领域应用得非常广泛。

20世纪80年代至90年代,美国正在经历科技浪潮,算法的开发者身处在那样的文化环境当中,他们的理念会受到影响,当然这不是必然的因果律,但是当人们去比较它的时候,会发现很多的相似性。

UNIX哲学

比如埃里克·雷蒙德(Eric Raymond)谈到的Unix哲学的逻辑,他谈到的模块化逻辑、明晰化逻辑、简单化逻辑等已经被人们普遍认为是编程语言当中的首要原则。

尤其是模块化逻辑,这是1960年代以来美国社会非常认可和奉行的一种区隔政策,是一种社会治理观念。人们希望将社群进行划分,希望把人群进行识别,同时希望有基本的原则,比如说尽可能地让问题变得透明化。

那么有个问题值得我们思考:是不是所有的技术、所有的编程语言、所有的计算机都是那么单纯的技术,那么的自然而然呢?如果回溯历史,再去看每一种技术发生的历史语境,都会发现其中的蛛丝马迹与万种关联。

不管数据也好,算法也好,本身都具有偏见,但还需要注意一个问题,偏见是被人带入到人工智能世界的。

带入偏见的原因是我们往往对技术有着盲目的信任,愿意相信技术是中立的,数据的决策更加客观,大数据更加全面。但是技术从来不是在真空或者单纯的实验室状态下的产物,技术也绝对不是科学的应用化这么简单,甚至哪怕是最单纯的科学研究也都具备一定的社会、文化和政治因素。

因此,我们在考虑科技带来便利、变革和创新的同时,必须意识到科技所具有的复杂性特点,尤其是当科技与资本、与政治的意识形态形成合谋的时候,会带来非常大的欺骗性和自然而然性。

刷脸支付,刷脸生活

现在,我们已经非常习惯用脸、用面部特征信息在生活中完成交易和获得许可,但是如果回到背后的技术流程,我们就会发现,它的初衷是为了让用户更加便捷地生活。但在使用的过程中,我们每一步都是用个人信息去换取这种便利,而背后受益的并不是我们。

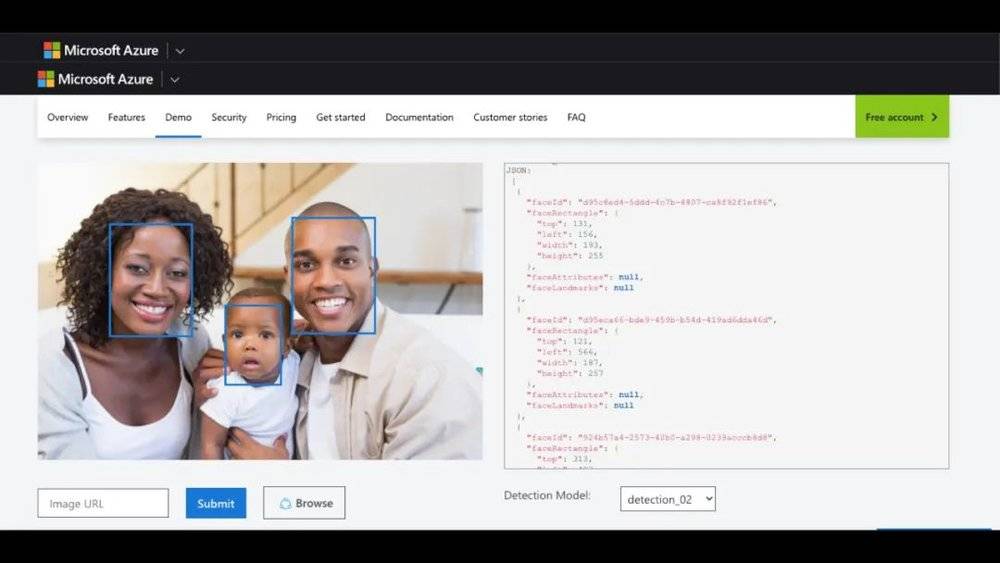

所以像亚马逊、微软、谷歌、Facebook等公司,近些年来的态度都表明了对个人隐私的重视,表示出会主动地纠正技术偏见的态度。但面部识别依然是它们主要的应用技术,被宣传和推广使用在各种商业环境当中,公司的网站上只不过把人们习以为常的白人图像换成了黑人图像。

人们习以为常的白人图像被换成了黑人图像

那么是不是这样的努力就可以改变呢?对此我要打上问号,因为商业性资本的利益驱动是所有这样的公司或者大企业背后最主要的动机。

三、我们在结构性体系当中的位置,塑造了我们的认识论

人工智能其实不仅仅是一种基于算法的技术,同时也是人的意识的延伸。在人与机器合作,人与机器互动的过程中,人和机器、人和算法共同造就了一种虚拟空间合作关系,共同构成了一种合作的智慧体。

在这种虚拟的智慧体中,人把自己在自然世界里已经形成的常识不加思索地带入到算法的世界,而人们的常识往往是具有意识形态、具有偏见的。

人们是不是意识到了呢?是不是意识到我们正在把努力纠正、筛选和改变的事情不加思索地带入到新世界呢?

陈静在造就的舞台上演讲

我想并不是完全如此,再看看现在所有智能语音的小助手们,都是女性对不对?一个非常甜美、年轻的少女声音出现在我们的手机和家用智能电器里,出现在各种智能化陪伴的应用里,这是为什么?

女性化的语音助手

因为这就是偏见,这就是以往的对于人、对于性别、对于年龄的偏见,促使它们将技术向市场进行转化的时候,把在人类社会当中已经有意识要去改变的一切又带入到新世界里面。

所以最后我想说的是,“是我们在结构性体系当中的位置,塑造了我们的认识论”。

是我们在结构性体系当中的位置,塑造了我们的认识论

这种结构性的位置不仅是在自然的人类世界里面,同时也在技术世界里面,我们以我们的认识塑造了新世界,要警惕的是新世界同样也在塑造着我们的认识。我们究竟带给未来,给下一代,给年轻人们什么样的新观念?要给他们什么样的新世界?

改变必须要从今天开始,从当下开始,从每个人对所使用技术的警惕开始。

我们不能排斥人工智能,也不能一刀切地反对人工智能。恰恰相反,要与它合作,要与技术合作,要去了解它背后的逻辑,了解它的好与坏,了解它的利弊。与此同时,我们也要做出变化,做出应对。

本文来自微信公众号:造就(ID:xingshu100),演讲:陈静(南京大学艺术系副教授)