扫码打开虎嗅APP

本文来自微信公众号:学术头条(ID:SciTouTiao),作者:XT,编审:寇建超,头图来自:视觉中国

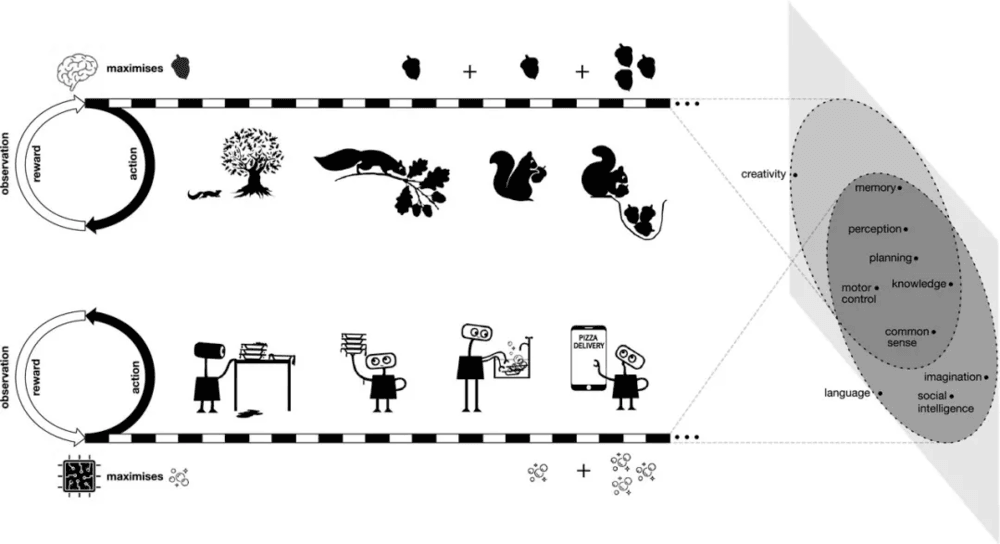

今年 6 月,DeepMind 首席研究科学家、伦敦大学学院教授 David Silver 及其合作者在一篇题为 《Reward is enough》的论文中指出,人工智能及其相关能力不是通过制定和解决复杂问题而产生的,而是通过坚持一个简单而强大的原则:奖励最大化。Silver 等人认为,简单的奖励是丰富环境中的代理人开发多属性智能的全部需要,而这种多属性智能正是实现通用人工智能所需的全部。

但很显然,并不是所有人都同意这一观点。

近日,数据科学家 Herbert Roitblat 就针对 DeepMind 团队提出的这一观点提出了反驳意见。在他看来,虽然 Silver 等人的说法听起来像是一个大胆的主张,但事实上却很模糊,甚至几乎毫无意义。

值得一提的是,Roitblat 也是 《Algorithms Are Not Enough: How to Create Artificial General Intelligence》 一书的作者。

产生智能的前提存在误导

据了解,第一个试图证明单一学习机制就足够的重要项目是 B.F. Skinner 的行为主义版本,以他的 Verbal Behavior 一书为代表。这本书受到了美国哲学家 Noam Chomsky(1959 年)的严厉批评,Chomsky 称 Skinner 试图解释人类的语言产生是 “戏剧表演科学” 的例子;

第二个主要建议是由 Rumelhart 和 McClelland(1986 年)提出的侧重于英语动词过去式学习的建议,但遭到了 Lachter 和 Bever(1988 年)的严厉批评,认为他们通过选择的特定方式来表示他们的联结主义系统正在学习转换的单词的音位特性,其中包含使系统成功的特定信息。

之所以前面的这两次尝试都失败了,是因为他们屈服于确认偏见。正如 Silver 等人所做的那样,他们报告了与假设相一致的数据,而没有考虑可能的替代性解释,他们将模棱两可的数据解释为支持性的。这三个项目都没有考虑到他们模型中的隐性假设,如果没有这些隐含的 TRICS(Lachter 和 Bever 对 "其关键假设的表征" 的称呼),这些系统中就不会存在“智能”。

Silver 等人更进一步,还提出它足以达到智能,特别是足以解释通用人工智能。Silver 等人的论点可以归纳为以下三个命题:

奖励最大化足以产生智能。“奖励最大化的通用目标足以驱动表现出自然和人工智能中所研究的大多数(如果不是全部)能力的行为。”

智力是实现目标的能力。“智力可以被理解为实现目标的灵活能力。”

成功是通过最大化奖励来衡量的。“因此,成功是通过最大化奖励来衡量的。”

简而言之,他们提出智能的定义是使奖励最大化的能力,同时他们用奖励的最大化来解释智力的出现。继 17 世纪作家莫里哀(Molière)之后,一些哲学家将这种论证称为 virtus dormativa(一种诱导睡眠的美德)。当被要求解释为什么鸦片会导致睡眠时,莫里哀在 Imaginary Invalid 中的单身汉(bachelor)回答说,它有安眠的属性(一种诱导睡眠的美德)。

当然,这只是对正在寻求解释的属性的命名。奖励最大化在 Silver 的假设中起着类似的作用。实现目标既是智能的过程,也解释了智能的过程。

“Reward is enough”的假设,假定智力及其相关能力可以被理解为在其环境中行动的主体促进奖励的最大化(来源:ScienceDirect)

之所以 Chomsky 批评 Skinner 的方法,是因为该方法假设任何表现出来的行为都必须有一些奖励。如果有人看着一幅画说“荷兰语”,Skinner 的分析假设是,这幅画的某些特征一定会因为“荷兰语”的表达而受到奖励。但是,Chomsky 认为,这个人可以说任何其他的东西,包括 "弯曲的"、"可怕的"或 "让我们吃点午餐"。Skinner 无法指出导致这些言论的具体特征,也不能提供任何证据来证明该言论在该特征存在的情况下曾被奖励过。

引用一位 18 世纪法国作家 Voltaire 的话说,他的博士 Pangloss 在 Candide 中曾这样说:“请注意,鼻子的形成是为了承受眼镜,因此我们有了眼镜。”一定有一个问题可以通过任何特征来解决,在这种情况下,他声称鼻子的形成只是为了让眼镜可以被托起。Pangloss 还表示:“可以证明……事物不可能不是本来的样子;因为一切都是为了一个目的而创造的,一切都必然是为了最好的目的。”

智能的诱发存在多种影响因素

Silver 等人在论文中写道:“当与智能相关的能力作为奖励最大化的单一目标的解决方案出现时,这实际上可能提供了一个更深入的理解,因为它解释了为什么这种能力会出现。相反,当每一种能力被理解为其自身专门目标的解决方案时,为了关注该能力的作用,为什么的问题就被绕开了。”

而 Roitblat 的观点是:对 Silver 等人来说,这个目的就是一个解决问题的方法,而智能的学习正是为了这个目的,但我们不一定知道这个目的是什么,也不知道是什么环境特征诱发了它,但一定有什么东西。

Gould 和 Lewontin(1979)很好地利用 Pangloss 博士批评他们所谓的进化生物学中的 “适应主义者(adaptationist)” 或“过分乐观者(Panglossian)”范式。适应主义的核心原则是,任何特征都必须有一个适应性的解释。

他们指出,威尼斯圣马可大教堂的高装饰拱门(两个拱门相交处近似三角形形状)是一个建筑特征,源于选择设计四个拱门的大教堂,而不是建筑设计的驱动力。拱门的选择决定了壁炉的位置,而不是壁炉的位置决定拱门。一旦建筑师选择了拱门,拱肩是必要的,而且可以进行装饰。Gould 和 Lewontin 说:“每个扇形拱顶都必须有一系列沿拱顶中线的开放空间,即扇形两侧在支柱之间相交的地方。由于这些空间必须存在,所以它们经常被用来达到巧妙的装饰效果。”

Gould 和 Lewontin 给出了另一个例子,对阿兹台克人祭祀同类相食的适应性解释。阿兹特克人从事活人祭祀。从适应主义的角度解释是,祭祀制度是解决肉类长期短缺问题的方法。受害者的四肢经常被社区中的某些地位高的成员吃掉。

这种 “解释” 认为,构成这一精心设计的仪式性谋杀的神话、象征和传统系统是对肉的需求的结果,而事实可能恰恰相反。每一位新国王都必须超越他的上一任,为更多的人献上越来越精致的祭品。这种做法似乎使阿兹特克帝国的经济资源日益紧张。其他蛋白质来源很容易获得,只有某些已经拥有足够食物的特权人士才会吃牺牲的受害者的某些部分。

如果目标是让饥饿的人吃到肉,那么人们会期望他们能够更有效地利用受害者,并更广泛地传播食物来源。对肉的需求不太可能成为人类牺牲的原因;相反,它似乎是其他文化习俗的结果,这些习俗实际上对阿兹特克文明的生存不适应。

引用 Silver 等人迄今为止的论点,如果目标是成为富人,那么只要积累大量的金钱就足够了。用积累金钱就可以用成为富人的目标来解释,成为富人的定义是积累了大量的金钱。强化学习没有解释一个人如何去积累金钱或为什么这应该是一个目标。他们认为,这些都是由环境决定的。

Silver 等人认为,如果一个智能体可以不断调整其行为以提高其累积奖励,那么其环境反复要求的任何能力最终都必须在智能体的行为中产生。在Silver 等人在自然智能和通用人工智能之间进行了类比,并指出:

“动物的经验流足够丰富和多样的,它可能需要一种灵活的能力来实现各种各样的子目标(例如觅食、战斗或逃跑),以便成功地最大化其整体奖励(例如饥饿或繁殖)。类似地,如果一个人工智能代理的经验流足够丰富,那么许多目标(例如电池寿命或生存)可能隐含地需要实现同样广泛的子目标的能力,因此奖励的最大化应该足以产生一种通用的人工智能。”

Roitblat 反驳道,只靠奖励本身其实是不够的,至少环境也发挥了作用。但适应的内容远不止这些。适应需要一个变异性的来源,从中可以选择出某些特征。进化生物学中这种变异的主要来源是突变和重组。

任何生物体的繁殖都涉及到将基因从父母那里复制到孩子身上。复制的过程并不完美,并且会出现错误。其中许多错误是致命的,但也有一些不是,然后可用于自然选择。在有性繁殖的物种中,每一个亲本都贡献了其基因的一个副本(以及任何潜在的错误),这两个副本允许通过重组产生额外的变异性,一些来自一个亲本的基因,一些来自另一个亲本的基因传递给下一代。

奖励是选择。仅此而已,这是不够的。正如 Dawkins 所指出的,进化奖励是将特定基因传递给下一代。奖励是在基因层面,而不是在生物体或物种层面。任何能增加基因从一代传给下一代的机会的东西,都是对这种奖赏的调解,但请注意,基因本身并没有能力成为智能。

除了奖励和环境,其他因素也在进化和强化学习中发挥着作用。奖励只能从现有的原材料中进行选择。如果我们将一只老鼠扔进一个洞穴,它就不会像蝙蝠一样学会飞行和使用声纳。积累足够的突变需要多代甚至数百万年的时间,即便如此,也不能保证它能进化出与蝙蝠一样的解决洞穴问题的方法。

强化学习是一个纯粹的选择性过程。强化学习是提高行动概率的过程,这些行动共同构成了处理某种环境的政策。这些行动必须已经存在,才能被选中。至少就目前而言,这些行动是由进化中的基因和人工智能中的程序设计师提供的。

针对这一问题,Silver 等人在论文中也提到,在不同的环境中实现不同的奖励最大化可能会导致不同的、强大的智能形式,每一种智能都会表现出自己令人印象深刻的、但又无法比拟的一系列能力。一个好的奖励最大化的代理将利用其环境中存在的任何元素,但某种形式的智能的出现并不以它们的具体内容为前提。

理论与现实的结合

正如 Lachter 和 Bever 所指出的那样,学习并不像 Silver 等人所声称的那样从“白板”(Tabula rasa)开始,而是从一组代表性的承诺开始。

Skinner 的大部分理论都基于动物的强化学习,尤其是鸽子和老鼠。他和许多其他研究人员在严酷的环境中研究了它们。对于老鼠来说,那是一个房间,里面有一个供老鼠按压的杠杆和一个提供奖励的喂食器。老鼠除了在短距离内徘徊并接触杠杆外,没有什么其他可以做的。鸽子也在一个包含啄食键(通常是墙上的一个有机玻璃圈,可以被照亮)和一个提供奖励的谷物喂食器的环境中接受了类似的测试。

在这两种情况下,动物都有一种预先存在的偏见,即以行为学家希望的方式作出反应。事实证明,即使没有奖励,老鼠也会接触杠杆,鸽子也会在黑暗的盒子里啄食发光的钥匙。这种以理想方式做出反应的倾向使得训练动物变得容易,研究者可以不费吹灰之力地研究奖励模式的影响。但多年后人们才发现,选择杠杆或啄食钥匙并不只是一种任意的便利,而是一种未被承认的“幸运选择”。

当 Rumelhart 和 McClelland 建立他们的过去式学习者时,同样未被承认的幸运选择发生了。他们选择的表征恰好反映了他们希望他们的神经网络能够学习的信息。这不是单纯依靠一般学习机制的 “白板”。

Silver 等人在题为《A general reinforcement learning algorithm that masters chess, shogi, and Go through self-play》的论文中指出,在开发 AlphaZero 时也很“幸运”,他们在本文中提到了这一点。他们在提出这一主张的同时,对 AlphaZero 进行了更详细的说明。他们的结果表明,一个通用的强化学习算法可以在没有特定领域的人类知识或数据的情况下学习“白板”,同一算法在多个领域的成功学习证明了这一点,在多个具有挑战性的游戏中表现出了超人的表现。

他们还指出,AlphaZero 用深度神经网络、通用强化学习算法和通用树形搜索算法取代了传统游戏程序中使用的手工知识和特定领域的增强功能。他们不包括明确的针对游戏的计算指令,但确实包括了人类对解决问题的重大贡献。例如,他们的模型包括一个“神经网络 fθ(s),(它)将棋盘位置 s 作为输入,并输出一个移动概率矢量”。

换句话说,他们并不期望计算机知道它在玩游戏,或者游戏是通过轮流进行的,或者它不能只是把围棋棋子堆成一堆或把棋盘扔在地上。他们还提供了许多其他的约束条件,例如,让机器与自己对弈。他们使用的树状表示法曾经是代表游戏玩法的巨大创新。树的分支对应于可能的移动范围,没有其他操作是可能的。计算机还被提供了一种使用蒙特卡洛树形搜索算法搜索树的方法,并且提供了游戏的规则。

那么,AlphaZero 远不是一个“白纸黑字”,它被赋予了大量的先验知识,这大大限制了它可以学习的可能范围。因此,即使在学习围棋的背景下,也不清楚“奖励是足够的”意味着什么。要使奖励足够,它就必须在没有这些限制的情况下发挥作用。此外,目前还不清楚,即使是一个一般的游戏系统,是否也能算作在不太受约束的环境中进行一般学习的一个例子。

AlphaZero 对计算智能作出了重大贡献,但它的贡献主要涉及它的人类智能,识别其运行的约束,并将玩游戏的问题减少到定向树搜索。此外,它的约束条件甚至不适用于所有游戏,而只适用于有限类型的游戏。它只能玩某些类型的棋盘游戏,这些棋盘游戏的特征是树搜索,学习者可以将棋盘位置作为输入并输出一个概率向量。没有证据表明它甚至可以学习另一种棋盘游戏,比如大富翁,甚至 Parchisi。

在没有约束的情况下,奖励并不能解释任何东西。AlphaZero 不是所有种类学习的模型,当然也不是通用智能的模型。

Silver 等人将一般智能视为一个定量问题。“通用智能,即人类和其他动物所拥有的那种智能,可以被定义为在不同背景下灵活地实现各种目标的能力。”需要多大的灵活性?多大范围的目标?如果我们有一台电脑,可以交替地下围棋、跳棋和国际象棋,这仍然不构成通用智能。即使我们增加了另一种游戏,即象棋,我们仍然拥有完全相同的计算机,它仍然可以通过找到一个模型来工作,该模型“以棋盘位置 s 作为输入并输出移动概率向量”。

计算机完全没有能力接受任何其他的“想法”或解决任何无法以这种特定方式表示的任何问题。通用人工智能中的 "通用" 不是以它可以解决不同问题的数量为特征,而是以解决多种类型问题的能力为特征。一个通用智能代理必须能够自主地制定自己的表述,它必须创造自己的方法来解决问题,选择自己的目标、表征、方法等等。

到目前为止,这都是人类设计师的职权范围,他们将问题简化为计算机可以通过调整模型参数解决的形式。除非我们能够消除对人类构建问题的依赖,否则我们无法实现通用智能。强化学习,作为一个选择性的过程,无法做到这一点。

正如行为主义和认知主义之间的对抗,以及反向传播是否足以学习语言学的过去式转换的问题一样,这些简单的学习机制只有在我们忽略了其他往往未被承认的限制因素所带来的沉重负担时才显得充分。奖励在可用的替代方案中进行选择,但它们无法创造这些替代物。

只要我们不仔细观察这些现象,只要我们假设一定有某种奖励能强化某种行动,行为主义的奖励就能发挥作用。善于事后“解释”任何观察到的行为,但在实验室之外,它们无助于预测哪些行动即将发生。这些现象与奖励是一致的,但如果认为它们是由奖励引起的,那就错了。

Roitblat 在《 Algorithms Are Not Enough: How to Create Artificial General Intelligence》 一书中解释了为什么所有当前包括强化学习在内的人工智能算法,都需要仔细制定人类创建的问题和表示。他表示,一旦建立了模型及其内在表示,优化或强化就可以指导其进化,但这并不意味着强化就足够了。同样,Roitblat 补充说,该论文没有就如何定义强化学习的奖励、动作和其他元素提出任何建议。与 Silver 等人的说法相反,他认为奖励是不够的。

参考资料:https://venturebeat.com/2021/07/10/building-artificial-intelligence-reward-is-not-enough/https://www.sciencedirect.com/science/article/pii/S0004370221000862https://mp.weixin.qq.com/s/5M1kuNp9z83yJkjKTE9m3g

本文来自微信公众号:学术头条(ID:SciTouTiao),作者:XT,编审:寇建超