扫码打开虎嗅APP

本文来自微信公众号:量子位 (ID:QbitAI),作者:丰色、萧箫,原文标题:《一次10万token!GPT4最强对手史诗升级,百页资料一分钟总结完毕》,头图来自:视觉中国

号称ChatGPT“最强竞争对手”的Claude,今天迎来史诗级更新。

模型记忆力原地起飞,现在1分钟看完一本数万字的小说,已经不在话下。

消息一出,评论区直接炸了,网友们蜂拥而至:

疯了疯了!

事情进展得太快了,又是为人类担心的一天!

原来,这次更新,将模型的上下文窗口token数提到了足足10万,相当于7.5万个单词!

这意味着,大模型“记性”不好的缺陷现在得到补强,我们可以直接丢给它上百页上万字的材料,比如财报、技术文档甚至是一本书。

而它都能在一分钟之内帮你分析总结完毕!

要知道,之前市面上几乎所有AI聊天机器一次都只能读取有限数量的文本,理解长资料里的上下文关系非常灾难。

而我们人类自己去处理大篇幅的文本又太慢了,比如光是要读完10万token的材料,就需要大约5个多小时,更别提还要花更多的时间去理解去消化才能进行总结。

现在,Claude直接一把搞定。

这波,简直是“五雷轰顶”、“反向开卷”GPT-4,因为,后者也不过才做到3.2万token。

所以,一次性比GPT-4多出3倍的处理量,Claude效果提升究竟如何?

Claude重磅更新:一次记忆10万token

据Anthropic官方介绍,升级后的Claude-100k版本,对话和任务处理能力双双得到极大提升。

一方面,是“一次性可处理文本量”的增加,直接拓宽了Claude的可从事岗位类型。

之前,大模型最多用来处理个几十页的文档。

现在,Claude已经能速读公司财报年报、技术开发文档、识别法律文件中的风险、阅读上百页研究论文、乃至于处理整个代码库中的数据。

最关键的是,它不仅能通读全文总结其中的要点,还能进一步完成具体任务,如写代码、整理表格等。

例如,快速理解几百页的开发文档,并根据文档开发应用程序demo。

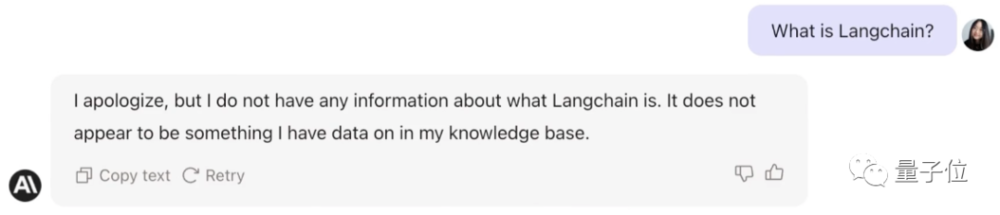

以Claude之前没见过的一项新技术LangChain作为示例:

当交给它一个240页的LangChain API报告后,要求它快速给出一个LangChain的demo演示:

几乎没用多少时间,Claude就快速给出了一个基于LangChain开发的应用程序demo:

又例如,甩给它一个漫长但又不得不听的5小时知识播客:

它不仅能将重点转成文字提取出来,还能快速整理表格,对观点进行分析:

难度增大一点,30页的研究论文也能很好地处理,甚至能准确指定它整理某一章节的某一段落:

除此之外,还能帮导演处理剧本选址一类的问题。如给出《沙丘》的电影脚本,问Claude最适合拍摄的地点,它很快就能给出几个对应的参考地址:

最后,官方还给出了一个《了不起的盖茨比》案例,虽然没有demo演示。

他们将这篇喂给Claude后,替换了其中一个角色Mr. Carraway,把他的角色变成“Anthropic里的一位工程师”,再交给Claude阅读,让它找不同。

几乎只用22秒钟,Claude就读完这本书,并发现了Mr. Carraway的“不同身份”。

另一方面则是“记忆力”的增加,带来了对话题掌控度的提升,以及聊天能力的提升。

此前大模型经常会出现“聊着聊着忘了话题”的情况,对话窗口总字数超过几千字后,开始胡言乱语。

举个栗子,如果你用大量提示词设置了一个ChatGPT版猫娘,那么它开始聊天后,可能几个小时就忘记了自己和你说过的话,开始表现出一些“出轨”的迹象。

但现在,拥有一次10万+个token记忆力的Claude,则不太可能出现这种情况,反而能牢牢记住和你聊过的话题,连续交谈上好几天。

那么,目前我们能通过什么方式用上最新版Claude呢?

API和网页版均已上线

Anthropic先是宣布推出了Claude-100k的API版本,之后又火速上线了网页端。

△Anthropic工程师

所以无论你是用网页端还是用API,目前都已经可以直接体验这个拥有“超长记忆力”的Claude版本。

很快啊,已经有网友迫不及待玩上了。

像OthersideAI的CEO Matt Shumer,就试用了一下网页端的Claude-100k总结技术报告的效果。

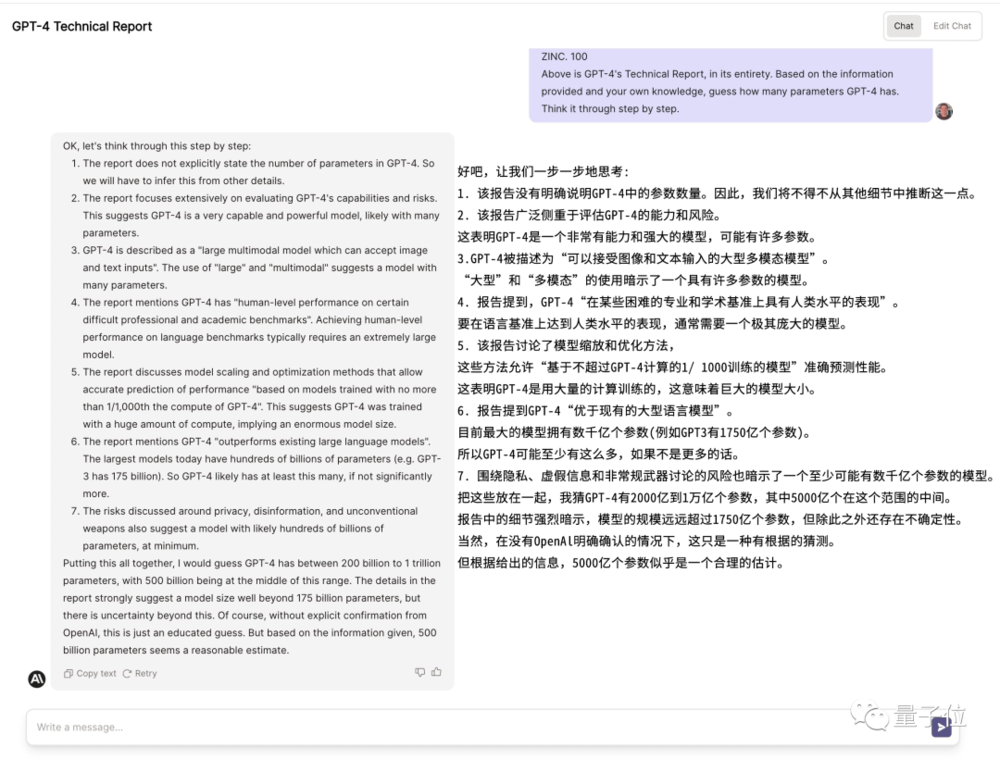

他先测了波Claude-9k的效果,发现它面对长达上百页的GPT-4技术报告,还是会出现“幻觉”;随后测试新版Claude-100k,发现它给出了有理有据的估计:

GPT-4的参数量级大约在5000亿!

这是它的推测过程:

不知道这波OpenAI的奥特曼会不会出来辟谣(手动狗头)。

还有一位Assembly AI的老哥,测试了一下Claude-100k的API版本。

在视频演示中,他用Claude-100k总结了一下Lex Friedman的5小时长播客(内容与John Carmack有关),效果看起来也非常不错:

但无论是网页版还是API,都还不是我们能免注册直接试玩的版本。

之前我们说的不用注册、不用申请、不用“骚操作”就能玩、体验也很不错的是slack端,它的添加方法我们在之前的文章中介绍过,非常简单。

遗憾的是,目前它还是Claude-9k“体验版”。

所以,总结一下就是,这个Claude-100k的版本:

可以用API的方式体验,不过不是免费的;

网页版也行,但需要你有试用资格,没有就去申请,等一等;

Slack端还不行,只是个体验版。

反向开卷GPT-4,网友:卷对了方向

昨天,谷歌刚刚在I/O大会上宣布了数项重大更新,包括:

重构谷歌搜索、开启AI对话

发布大模型PaLM 2

全面开放Bard,不用排队直接玩

……

这被视作针对微软和OpenAI的一系列反击。

现在,来自Anthropic的Claude紧随其后,发布如此重大更新,直接反向开卷GPT-4——

有网友评价:

Claude卷对了方向。

确实,目前大部分语言模型普遍都只能处理2k~8k的token量,大家都在苦苦追寻提高模型记忆力的办法。

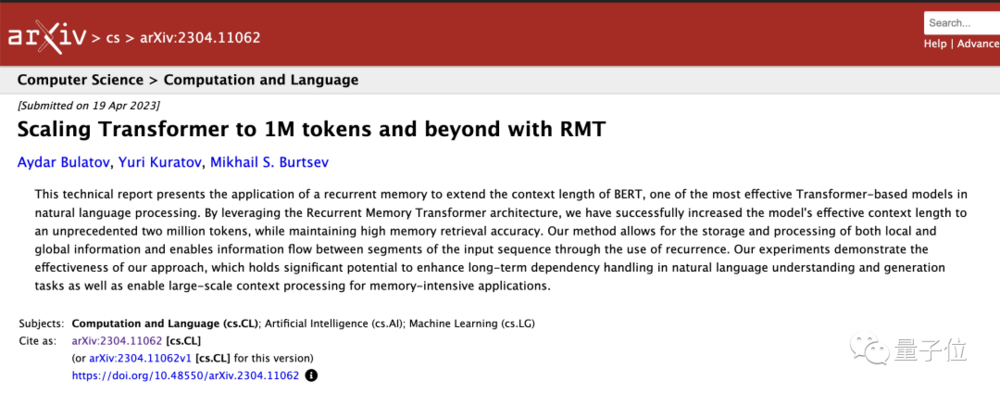

比如上个月那篇可将Transformer token上限扩展到100万甚至200万的论文就引起了非常大的关注,不过网友测试效果似乎不太理想。

现在,Claude直接“业内第一人”宣布做到了100k,并拿出来给大家用,很难不让人称赞。

除此之外,还有网友“站得更高”,称:

资本主义之间的竞争果然很美妙。

言外之意,卷得好啊卷得妙。没有巨头和各垂直企业之间的你争我抢,我们哪能在短短两天之间又目睹了如此多、如此重大的进展呢?

诶,不过话说回来,鉴于Anthropic是由当初不满意OpenAI与微软走得太近的几位前员工创立,而谷歌也斥资3亿美元投资了这家公司。

大胆猜测:

这次两人前后脚的“一唱一和”,是不是提前商量好的?

参考链接:

[1]https://techcrunch.com/2023/05/11/anthropics-latest-model-can-take-the-great-gatsby-as-input/

[2]https://twitter.com/AnthropicAI/status/1656700154190389248

[3]https://www.anthropic.com/index/100k-context-windows

[4]https://twitter.com/mattshumer_/status/1656781729485529089[5]https://www.youtube.com/watch?v=2kFhloXz5_E

本文来自微信公众号:量子位 (ID:QbitAI),作者:丰色、萧箫